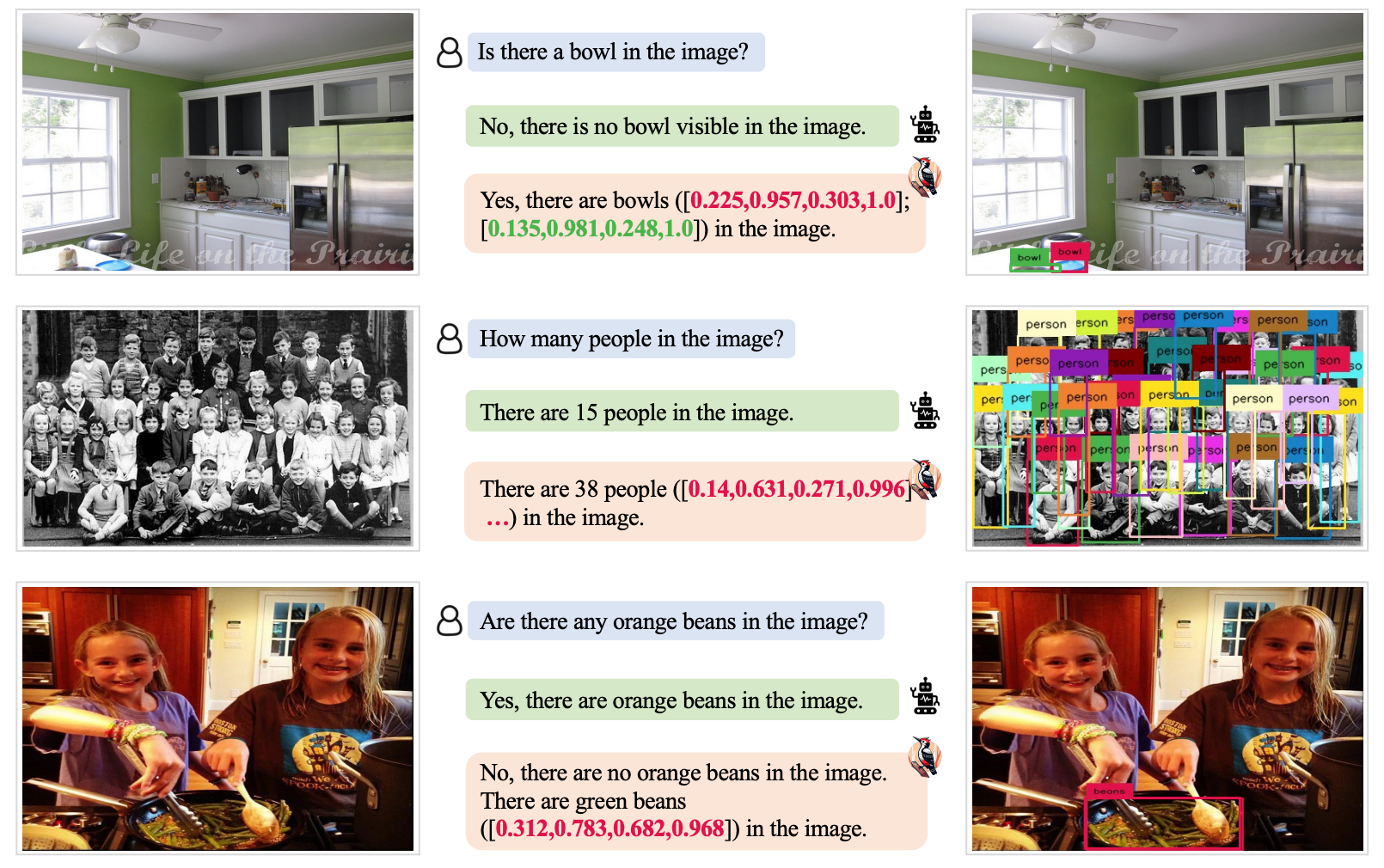

Multimodale Large Language Models (MLLM) zoals GPT-4V zijn erg goed in het analyseren en beschrijven van afbeeldingen, maar soms hallucineren ze en hebben ze het mis. Een nieuwe benadering genaamd Woodpecker zou dat kunnen oplossen.

Als je een MLLM vraagt om een foto te beschrijven, kan het normaal gesproken de objecten eruit pikken en de scène nauwkeurig beschrijven. Maar net als bij antwoorden op tekstvragen doet het model soms aannames op basis van voorwerpen of concepten die vaak samen voorkomen.

Als gevolg hiervan kan een MLLM een foto van een winkelpui beschrijven en zeggen dat er mensen in de scène staan, terwijl die er eigenlijk niet zijn.

Het verhelpen van hallucinaties in tekstgebaseerde LLM's is een continu proces, maar wordt een stuk eenvoudiger als het model verbonden is met het internet. De LLM kan een tekstreactie op een prompt genereren, deze op waarheidsgetrouwheid controleren op basis van relevante internetgegevens en zichzelf waar nodig corrigeren.

Wetenschappers van Tencent's YouTu Lab en de Universiteit van Wetenschap en Technologie van China hebben deze aanpak overgenomen en vertaald naar een visuele oplossing met de naam Woodpecker.

Eenvoudig gezegd bouwt Woodpecker een hoeveelheid kennis op uit de afbeelding en vervolgens kan een LLM die gebruiken als referentie om de oorspronkelijke beschrijving die door de MLLM is gegenereerd te corrigeren.

Hier volgt een korte beschrijving van hoe het werkt:

- Een LLM zoals GPT-3.5 Turbo analyseert de beschrijving die door de MLLM wordt gegenereerd en extraheert sleutelconcepten zoals objecten, hoeveelheden en attributen. In de zin "De man draagt een zwarte hoed." worden bijvoorbeeld de objecten "man" en "hoed" geëxtraheerd.

- Een LLM wordt vervolgens gevraagd om vragen te genereren met betrekking tot deze concepten, zoals "Staat er een man op de afbeelding?" of "Wat draagt de man?".

- Deze vragen worden als prompts naar een Visual Question Answering (VQA) model gestuurd. De DINO voert objectdetectie en -telling uit, terwijl de BLIP-2-FlanT5 VQA attribuutgerelateerde vragen beantwoordt na analyse van het beeld.

- Een LLM combineert de antwoorden op de vragen tot een visuele kennisbank voor de afbeelding.

- Een LLM gebruikt deze referentie-informatie om eventuele hallucinaties in de oorspronkelijke beschrijving van de MLLM te corrigeren en details toe te voegen die de LLM over het hoofd heeft gezien.

De onderzoekers gaven hun benadering de naam Woodpecker, een verwijzing naar de manier waarop de vogel insecten uit bomen plukt.

Testresultaten toonden aan dat Woodpecker een nauwkeurigheidsverbetering behaalde van 30,66% voor MiniGPT4 en 24,33% voor de mPLUG-Owl modellen.

Het generieke karakter van de modellen die voor deze aanpak nodig zijn, betekent dat de Woodpecker-aanpak gemakkelijk in verschillende MLLM's kan worden geïntegreerd.

Als OpenAI Woodpecker in ChatGPT integreert, zouden we een duidelijke verbetering kunnen zien in de toch al indrukwekkende visuele prestaties. Een vermindering van MLLM hallucinatie zou ook geautomatiseerde besluitvorming kunnen verbeteren door systemen die visuele beschrijvingen als input gebruiken.