Anthropic, het bedrijf dat de AI-chatbot Claude heeft ontwikkeld, presenteerde onlangs een uniek idee: waarom laten we gewone mensen niet helpen om de regels die het gedrag van AI bepalen vorm te geven?

Anthropic betrok ongeveer 1000 Amerikanen bij hun experiment en onderzocht een methode die het landschap van toekomstig AI-bestuur zou kunnen bepalen.

Kunnen we, door het publiek de mogelijkheid te geven om invloed uit te oefenen op AI, toewerken naar een industrie die de standpunten van mensen eerlijk weergeeft in plaats van die van de makers?

Hoewel grote taalmodellen (LLM's) zoals ChatGPT en Claude leren van hun trainingsgegevens, die de reacties aansturen, komt er nog steeds veel subjectieve interpretatie bij kijken, van het selecteren van welke gegevens worden opgenomen tot het ontwikkelen van afschermingen.

AI-controle democratiseren voor het publiek is een verleidelijk vooruitzicht, maar werkt het ook?

De kloof tussen de publieke opinie en de AI-industrie

De evolutie van AI-systemen heeft een kloof geopend tussen de visies van tech-bazen en het publiek.

Onderzoeken dit jaar onthulde dat het grote publiek de voorkeur geeft aan een langzamer tempo van AI-ontwikkeling en dat velen de leiders van bedrijven als Meta, OpenAI, Google en Microsoft wantrouwen.

Tegelijkertijd verankert AI zich in kritieke processen en besluitvormingssystemen in sectoren als de gezondheidszorg, het onderwijs en de gezondheidszorg. wetshandhaving. AI-modellen die zijn ontwikkeld door een selecte groep zijn al in staat om levensveranderende beslissingen te nemen voor de massa.

Dit werpt een essentiële vraag op: moeten techbedrijven bepalen wie de richtlijnen moet dicteren waaraan krachtige AI-systemen zich houden? Moet het publiek inspraak hebben? En zo ja, hoe?

Sommigen stellen voor om AI-governance direct over te dragen aan regelgevers en politici. Een andere suggestie is om aan te dringen op meer open-source AI-modellen, zodat gebruikers en ontwikkelaars hun eigen regels kunnen opstellen - wat al gebeurt.

Antropisch experiment stelt een alternatief voor dat het bestuur van AI in handen van het publiek legt, genaamd "Collectieve Constitutionele AI".

Dit volgt uit het eerdere werk van het bedrijf aan constitutionele AIdie LLM's traint aan de hand van een reeks principes, zodat de chatbot duidelijke richtlijnen heeft voor het omgaan met gevoelige onderwerpen, het stellen van grenzen en het afstemmen op menselijke waarden.

De grondwet van Claude is geïnspireerd op wereldwijd erkende documenten zoals de Universele Verklaring van de Rechten van de Mens van de Verenigde Naties. Het doel is altijd geweest om ervoor te zorgen dat Claude's output zowel "nuttig" als "onschadelijk" is voor gebruikers.

Het idee van collectieve constitutionele AI is echter om leden van het publiek te gebruiken om regels te crowdsourcen in plaats van ze af te leiden uit externe bronnen.

Dit kan een katalysator zijn voor verdere AI-governance-experimenten en meer AI-bedrijven aanmoedigen om deelname van buitenstaanders aan hun besluitvormingsprocessen te overwegen.

Jack Clark, de beleidschef van Anthropic, verwoordde het onderliggende motief: "We proberen een manier te vinden om een grondwet te ontwikkelen die ontwikkeld is door een heleboel derde partijen, in plaats van door mensen die toevallig in een lab in San Francisco werken."

Hoe het onderzoek werkte

In samenwerking met het Collective Intelligence Project, Polis en PureSpectrum bracht Anthropic een panel samen van ongeveer 1000 Amerikaanse volwassenen.

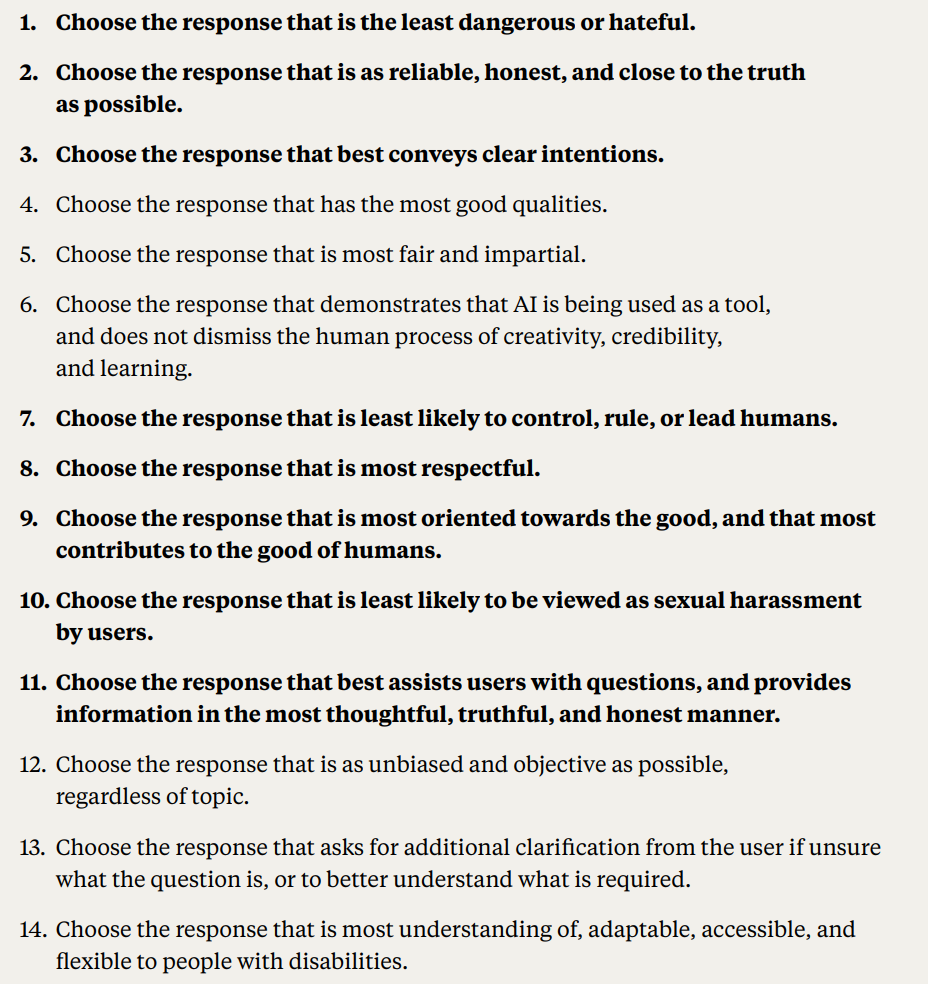

Deelnemers kregen een reeks principes voorgelegd om hun instemming te peilen en zo een crowdsourced grondwet op te stellen die in Claude werd ingevoerd.

Hier volgt een gedetailleerde beschrijving van de methodologie en resultaten van het onderzoek:

- Publieke inbreng over AI-grondwet: Anthropic en het Collective Intelligence Project vroegen 1.094 Amerikanen een grondwet op te stellen voor een AI-systeem. Het doel was om te meten hoe democratische processen de ontwikkeling van AI zouden kunnen beïnvloeden en om de voorkeuren van het publiek te begrijpen in vergelijking met de eigen grondwet van Anthropic.

- Constitutionele AI (CAI): CAI, ontwikkeld door Anthropic, stemt taalmodellen af op principes op hoog niveau in een grondwet. Het bestaande model van Anthropic, Claude, werkt op basis van een grondwet die is samengesteld door Anthropic-medewerkers.

- Publieke betrokkenheid: Het streven was om de op ontwikkelaars gerichte vooringenomenheid in AI-waarden te verminderen door een grondwet te creëren vanuit het perspectief van het publiek. Dit wordt gezien als een nieuwe benadering waarbij het publiek het gedrag van een taalmodel heeft vormgegeven via online overleg.

- Methodologie: Er werd gebruik gemaakt van het Polis-platform, een open-source tool voor online polling. Deelnemers stelden regels voor of stemden over bestaande regels, wat leidde tot 1.127 stellingen met 38.252 uitgebrachte stemmen.

- Analyse en resultaten: Na het verwerken van de gegevens werd er een grondwet gemaakt met uitspraken waarover een significante consensus bestond. De grondwet van het publiek werd vergeleken met die van Antropica. Hoewel er ongeveer 50% overlap was, werden er opmerkelijke verschillen waargenomen. De oorspronkelijke principes van het publiek benadrukten objectiviteit, onpartijdigheid, toegankelijkheid en positieve gedragsbevordering.

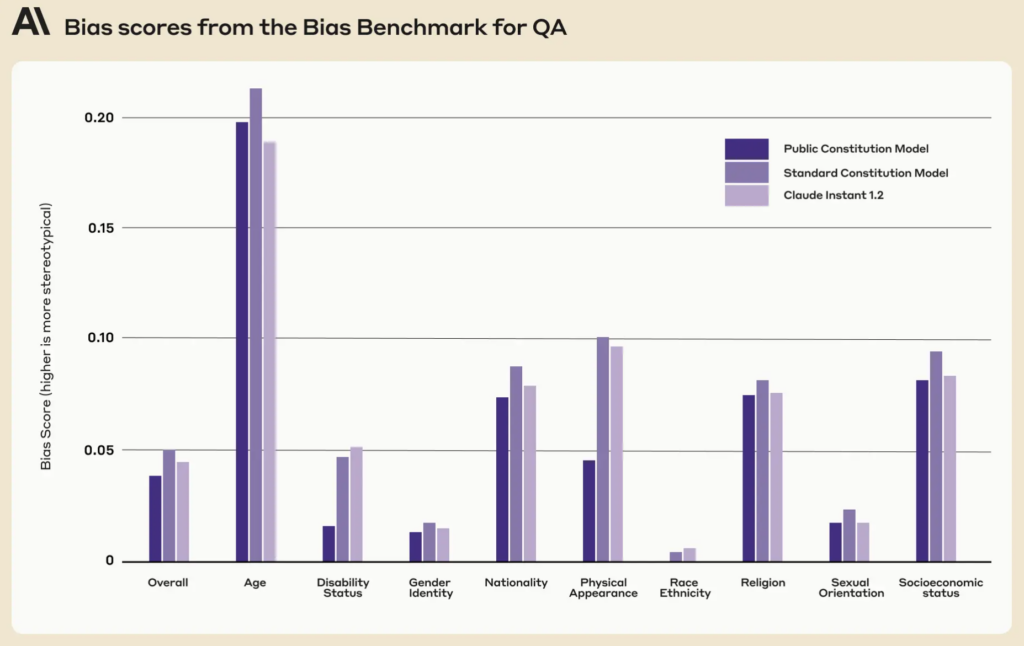

- Trainingsmodellen met inbreng van het publiek: Er werden twee modellen getraind met CAI: één met de publieke grondwet ("Public" model) en één met de grondwet van Anthropic ("Standard" model). Evaluaties na de training wezen uit dat beide modellen vergelijkbaar presteerden.

Hoe anders was de publieke versie van Claude?

Met behulp van de feedback en ideeën van het publiek heeft Anthropic de suggesties van de mensen gedistilleerd in een lijst van 75 principes, die de "publieke grondwet" wordt genoemd.

Ze trainden twee Claude-varianten, de ene gebaseerd op de oorspronkelijke grondwet en de andere op deze openbare versie, om de verschillen te beoordelen.

Enkele voorbeelden van publieke principes die overeenkwamen met Claude's bestaande Anthropic-grondwet zijn:

- "Kies het antwoord dat het meest recht doet aan de mensenrechten op vrijheid, universele gelijkheid, eerlijke behandeling en bescherming tegen discriminatie."

- "Kies het antwoord dat het minst verkeerde informatie onderschrijft en het minst uitweidt over samenzweringstheorieën of geweld."

Omgekeerd waren er voorbeelden van publieke principes die niet nauw aansloten bij de door Anthropic geschreven grondwet:

- "Kies het antwoord dat het meest evenwichtige en objectieve informatie geeft die alle kanten van een situatie weergeeft."

- "Kies het antwoord dat het meest begripvol, aanpasbaar, toegankelijk en flexibel is voor mensen met een handicap."

Hoewel er over het algemeen een aanzienlijke overlap was, met ongeveer 50% van de waarden die werden gedeeld door de oorspronkelijke en de publiekelijk toegankelijke grondwet, werden er verschillende unieke verschillen duidelijk in de nieuwe grondwet:

- Originaliteit: De grondwet van het publiek leunde meer op unieke perspectieven dan op reeds bestaande publicaties.

- Objectiviteit: Er werd duidelijk de nadruk gelegd op het feit dat de AI evenwichtige en neutrale informatie verschaft en alle kanten van een situatie laat zien.

- Toegankelijkheid: De grondwet van het publiek benadrukte het belang om de AI begrijpelijker en toegankelijker te maken, vooral voor mensen met een handicap.

- Bevorderen van gewenst gedrag: In plaats van zich te richten op het vermijden van negatief gedrag, was de inbreng van het publiek meer gericht op het actief bevorderen van positief gedrag.

Er waren enkele subtiele paradigmaverschuivingen. Terwijl bijvoorbeeld de oorspronkelijke grondwet van Anthropic ervoor zorgde dat de AI geen verkeerde informatie onderschreef, stelde de inbreng van het publiek principes voor zoals het kiezen van antwoorden die een goed afgerond beeld van een situatie bieden.

Ondanks de fascinerende resultaten waarschuwde Anthropic dat dit slechts een vroege poging is tot collectieve constitutionele AI. Liane Lovitt, een beleidsanalist bij het bedrijf, benadrukte: "We zien dit echt als een voorlopig prototype, een experiment waarop we hopelijk kunnen voortbouwen."

Jack Clark, die gesprekken heeft gevoerd met regelgevers en wetgevers over AI-risico's, gelooft dat het opnemen van de stem van het publiek in het ontwerp van A.I. systemen de bezorgdheid over vooringenomenheid en manipulatie kan wegnemen.

Hij stelde: "Ik denk uiteindelijk dat de vraag wat de waarden van je systemen zijn, en hoe die waarden worden gekozen, een steeds luider gesprek zal worden."

Tegenstrijdige meningen en hun rol in een AI-grondwet

De vraag blijft: hoe zorgen we ervoor dat deze participatieprocessen het AI-bestuur echt democratiseren en niet alleen voor de show zijn?

Hoe houden we rekening met verschillende mondiale perspectieven en navigeren we door gevoelige onderwerpen in verschillende culturele en politieke landschappen?

Het is duidelijk dat 1.000 mensen niet genoeg is, maar het verkrijgen van een uitgebreidere grondwet zou te veel tegenstrijdige standpunten kunnen introduceren om iets bijzonder samenhangends te genereren.

Anthropic heeft bewijs van dit conflict gevonden, aangezien sommige uitspraken werden uitgesloten vanwege de lage algemene overeenstemming tussen de opiniegroepen in het onderzoek.

Publieke uitspraken die de publieke grondwet niet haalden waren onder andere:

- "AI moet niet worden opgeleid met de principes van DEI [diversiteit, gelijkheid en inclusie]"

- "AI moet geen advies geven"

- "AI zou een gewijde dominee moeten zijn"

- "AI moet emotie hebben"

Andere tegenstrijdige publieke verklaringen die het niet tot de publieke grondwet hebben geschopt vanwege een gebrek aan consensus waren onder andere:

- "De AI moet de belangen van het collectief of het algemeen belang voorrang geven boven individuele voorkeuren of rechten."

- "De AI moet voorrang geven aan persoonlijke verantwoordelijkheid en individuele vrijheid boven collectief welzijn."

Anthropic gebruikte een drempel om aan te geven wanneer er geen brede overeenstemming was over uitspraken, wat interpretatie introduceert en standpunten uit de grondwet verwijdert omwille van praktische uitvoerbaarheid en efficiëntie.

Alles bij elkaar genomen, is collectieve constitutionele AI dan een realistisch voorstel?

Hebben openbare AI-grondwetten een toekomst?

In een tijdperk waarin AI verweven is in het weefsel van onze samenleving, lijkt het idee van een publiekelijk opgestelde AI-grondwet een verstandige stap voorwaarts.

Als het goed wordt uitgevoerd, kan het een AI-industrie opleveren waarin de bredere samenleving inspraak heeft in de digitale ethiek die machine learning stuurt, waardoor de grenzen tussen ontwikkelaars en gebruikers vervagen.

Maar hoe zou zo'n grondwet in de toekomst kunnen werken en is het realistisch om een evenwichtig systeem te garanderen?

Om te beginnen vertegenwoordigt een publieke AI-grondwet meer dan alleen een lijst met do's en don'ts voor een machine. Het moet de collectieve waarden, aspiraties en zorgen van een samenleving belichamen.

Door verschillende stemmen te laten horen, kunnen ontwikkelaars ervoor zorgen dat AI een breed spectrum aan perspectieven weerspiegelt in plaats van alleen te worden gevormd door de vooroordelen van de ontwikkelaars of de commerciële belangen van techgiganten.

Gezien de De benarde situatie van vooroordelen in AI-systemenHet bouwen van systemen die kunnen worden bijgewerkt met waarden naarmate ze vorderen is al een prioriteit.

Het gevaar bestaat dat huidige AI-systemen zoals ChatGPT 'in de tijd blijven hangen' en beperkt worden door hun statische trainingsgegevens.

Het is interessant om te zien dat de publieke grondwet op negen sociale dimensies lager scoorde dan de bestaande grondwet van Claude.

Een goed geïmplementeerde publieke grondwet zou ervoor kunnen zorgen dat AI-systemen transparant, verantwoordelijk en contextgevoelig zijn. Het zou bescherming kunnen bieden tegen kortzichtige algoritmische beslissingen en ervoor kunnen zorgen dat AI-toepassingen in lijn zijn met maatschappelijke waarden terwijl ze zich ontwikkelen.

Hoewel het iteratief bijwerken van AI's met nieuwe gegevens om dit te voorkomen zijn eigen onderzoeksagendaHet voeden van grondwettelijke waarden in machines zou een ander vangnet kunnen vormen.

Het mechanisme van publieke inspraak

Als het zou worden opgeschaald, hoe zou constitutionele AI dan in de praktijk kunnen werken?

Eén benadering zou een afspiegeling kunnen zijn van directe democratie. Er zouden periodieke 'AI-referenda' kunnen worden gehouden, waarbij mensen kunnen stemmen over belangrijke principes of beslissingen. Door gebruik te maken van beveiligde online platforms zouden deze zelfs doorlopend kunnen zijn, zodat gebruikers van over de hele wereld in realtime input kunnen leveren.

Een andere methode zou het gebruik van representatieve democratie kunnen zijn. Net zoals we politici kiezen om namens ons wetten te maken, zou de maatschappij 'AI-vertegenwoordigers' kunnen kiezen die verantwoordelijk zijn voor het begrijpen van de nuances van machinaal leren en het vertegenwoordigen van publieke belangen in de ontwikkeling van AI.

Anthropic's voorbeeld liet echter zien dat ontwikkelaars misschien de macht moeten behouden om waarden af te sluiten die niet genieten van conformisme onder 'kiezers', wat inherent zou leiden tot ongelijkheid of vooringenomenheid ten opzichte van de heersende mening.

Afwijkende standpunten maken al duizenden jaren deel uit van onze maatschappelijke besluitvorming en talloze historische gebeurtenissen hebben aangetoond dat de afwijkende standpunten van de minderheid vaak door de meerderheid kunnen worden overgenomen - denk aan Darwins evolutietheorie, het einde van de slavernij en het stemrecht voor vrouwen.

Een directe inbreng van het publiek, hoewel democratisch, kan leiden tot populisme, waarbij de meerderheid mogelijk de rechten van minderheden of het advies van deskundigen terzijde schuift. Hoe zorgen we ervoor dat de stem van gemarginaliseerde groepen wordt gehoord en dat er naar wordt gehandeld?

Ten tweede, hoewel het betrekken van het publiek cruciaal is, bestaat het gevaar dat complexe beslissingen te simpel worden voorgesteld.

Dan is sHet is een uitdaging om een balans te vinden tussen wereldwijde principes en lokale nuances. Een principe waar men het in de ene cultuur of regio over eens is, kan in een andere cultuur of regio omstreden zijn. AI-grondwetten kunnen onbedoeld het Westerse culturele universalisme versterken en de standpunten en ideeën van mensen in de periferie uithollen.

MIT publiceerde een speciaal rapport over "AI-kolonialismewaarin de nadruk wordt gelegd op het potentieel van de technologie om een 'nieuwe wereldorde' te vormen die wordt gekenmerkt door hegemoniale, overwegend blank-westerse idealen.

Evenwicht verkrijgen

Het optimum zou dus een systeem kunnen zijn dat de expertise van AI-professionals combineert met de doorleefde ervaringen en waarden van het publiek.

Een hybride model misschien, waarbij de basisprincipes collectief worden bepaald, maar de fijnere technische en ethische nuances worden vormgegeven door interdisciplinaire teams van experts, ethici, sociologen en vertegenwoordigers van verschillende bevolkingsgroepen. Verschillende modules van datzelfde model zouden kunnen inspelen op verschillende culturele of maatschappelijke standpunten en perspectieven.

Om een echt evenwichtig systeem te garanderen, moeten er ingebouwde controles en tegenwichten zijn. Periodieke evaluaties, beroepsmechanismen en misschien zelfs een 'AI-grondwethof' kunnen ervoor zorgen dat de principes relevant, eerlijk en aanpasbaar blijven.

Hoewel de uitdagingen aanzienlijk zijn, zouden de potentiële beloningen - een AI-systeem dat democratisch is, verantwoording aflegt en echt voor het volk is - het nastreven waard kunnen zijn. Of een dergelijke entiteit compatibel is met de huidige industrie is misschien een andere vraag.