Onderzoekers van de Universiteit van Chicago hebben een nieuw hulpmiddel ontwikkeld om AI-modellen te "vergiftigen" wanneer AI-bedrijven afbeeldingen zonder toestemming in hun datasets opnemen.

Bedrijven als OpenAI en Meta hebben te maken gehad met kritiek en rechtszaken over het op grote schaal schrapen van online content om hun modellen te trainen. Om tekst-naar-beeld generatoren zoals DALL-E of Midjourney effectief te laten zijn, moeten ze getraind worden op grote hoeveelheden visuele gegevens.

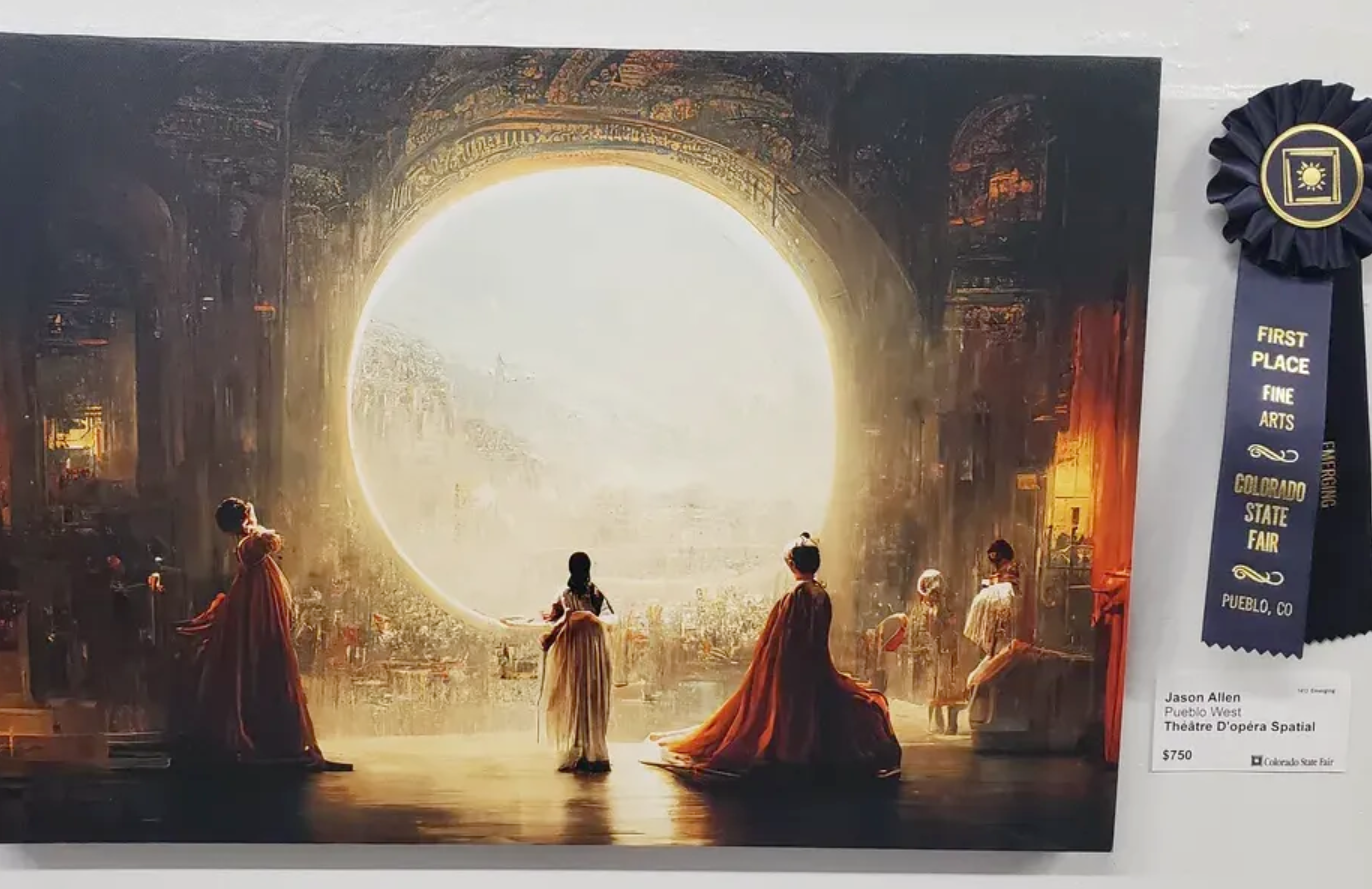

Een aantal artiesten hebben geklaagd dat deze afbeeldingsgeneratoren nu afbeeldingen in hun stijl kunnen produceren nadat ze zonder toestemming hun kunst hebben gesloopt.

De onderzoekers creëerden Nightshade, een hulpmiddel dat onzichtbare pixels in een afbeelding inbouwt die de afbeelding vervolgens 'giftig' maken voor AI-modellen.

Generatieve AI is afhankelijk van goed gelabelde gegevens. Als een AI-model is getraind op duizenden afbeeldingen van katten en de afbeeldingen zijn allemaal gelabeld met "kat", dan weet het hoe een kat eruit moet zien als je het vraagt om een afbeelding van een kat te genereren.

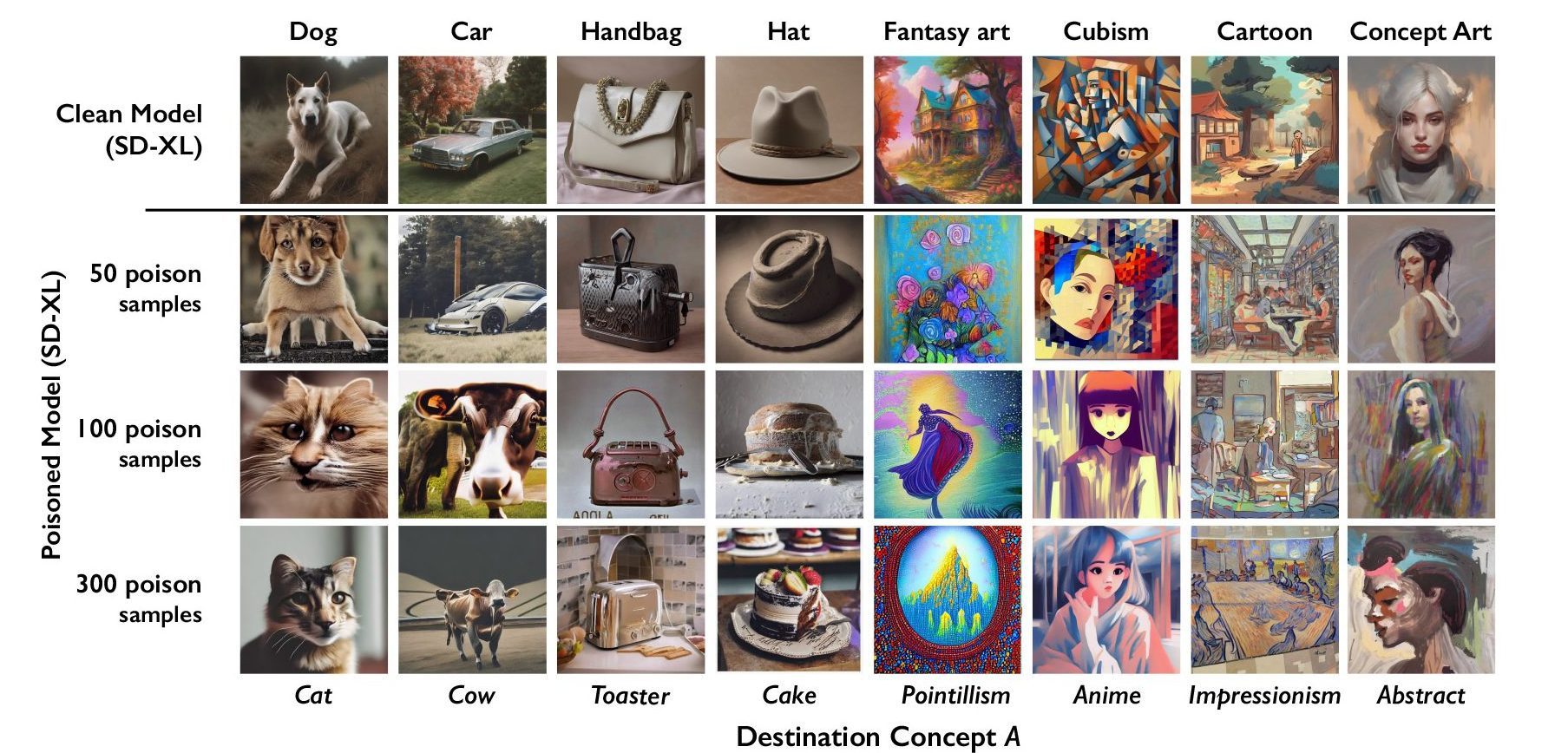

Nightshade stopt gegevens in het beeld die de classificatie van het beeld verstoren. Zo zou een afbeelding van een kasteel dat door Nightshade is vergiftigd, worden geclassificeerd als bijvoorbeeld een oude vrachtwagen. De onderzoekers ontdekten dat het gebruik van slechts 100 afbeeldingen gericht op een enkele prompt effectief was om een model te corrumperen.

Nightshade is slecht nieuws voor AI-beeldgenerators

Een model dat is aangetast door vergiftigde gegevens kan denken dat afbeeldingen van taarten hoeden zijn, of dat broodroosters handtassen zijn. Naast het corrumperen van het specifieke woord waar Nightshade zich op richt, infecteert de corruptie ook bredere concepten. Dus als het label "hond" corrupt wordt, wordt de corruptie ook uitgebreid naar termen als "puppy".

Als genoeg artiesten Nightshade gaan gebruiken zou dat bedrijven een stuk voorzichtiger kunnen maken om toestemming te krijgen voordat ze beelden stelen.

Het onderzoeksteam zal Nightshade integreren in de Glaze tool die ze ook hebben ontwikkeld. Glaze labelt de stijl van een afbeelding verkeerd. Een kunstenaar die bijvoorbeeld de stijl van zijn werk wil beschermen, kan Glaze gebruiken om het te labelen als "impressionistisch" terwijl het eigenlijk "pop-art" is.

Het feit dat tools als Nightshade zo effectief werken, benadrukt een kwetsbaarheid in tekst-naar-beeld generatoren die misbruikt kunnen worden door kwaadwillenden.

Bedrijven als OpenAI en Stability AI zeggen dat ze de opt-outs voor 'niet scrapen die websites kunnen toevoegen aan hun robots.txt-bestanden. Als de door Nightshade vergiftigde afbeeldingen niet worden gescraped, dan blijven de modellen onaangetast.

Kwaadwillenden kunnen echter een grote hoeveelheid afbeeldingen vergiftigen en beschikbaar maken voor scraping met de bedoeling om AI-modellen te beschadigen. De enige manier om dat te omzeilen is met betere labeldetectoren of menselijke beoordeling.

Nightshade zorgt ervoor dat artiesten zich een beetje zekerder voelen over het online zetten van hun inhoud, maar kan serieuze problemen veroorzaken voor AI-beeldengenerators.