Hoe onze hersenen precies taal verwerken en formuleren is nog steeds grotendeels een mysterie. Onderzoekers van Meta AI hebben een nieuwe manier gevonden om hersengolven te meten en de bijbehorende woorden te decoderen.

Mensen met ernstig beperkte motorische vaardigheden, zoals ALS-patiënten, vinden het bijzonder moeilijk om te communiceren. De frustratie van iemand als Stephen Hawking die moeizaam een zin opbouwt met oogbewegingen of het trekken van een wangspier is moeilijk voor te stellen.

Er is veel onderzoek gedaan naar spraak decoderen uit hersenactiviteitmaar de beste resultaten zijn afhankelijk van invasieve hersen-computer implantaten.

Onderzoekers van Meta AI gebruikten magneto-encefalografie (MEG) en elektro-encefalografie (EEG) om de hersengolven van 175 vrijwilligers op te nemen terwijl ze naar korte verhalen en geïsoleerde zinnen luisterden.

Ze gebruikten een vooraf getraind spraakmodel en contrastief leren om te identificeren welke hersengolfpatronen geassocieerd werden met specifieke woorden waar de proefpersonen naar luisterden.

Het decoderen van spraakperceptie uit niet-invasieve hersenopnames`,

geleid door de enige echte @honualx

is zojuist verschenen in het nieuwste nummer van Nature Machine Intelligence:- open-access paper: https://t.co/1jtpTezQzM

- volledige trainingscode: https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Jean-Rémi King (@JeanRemiKing) 5 oktober 2023

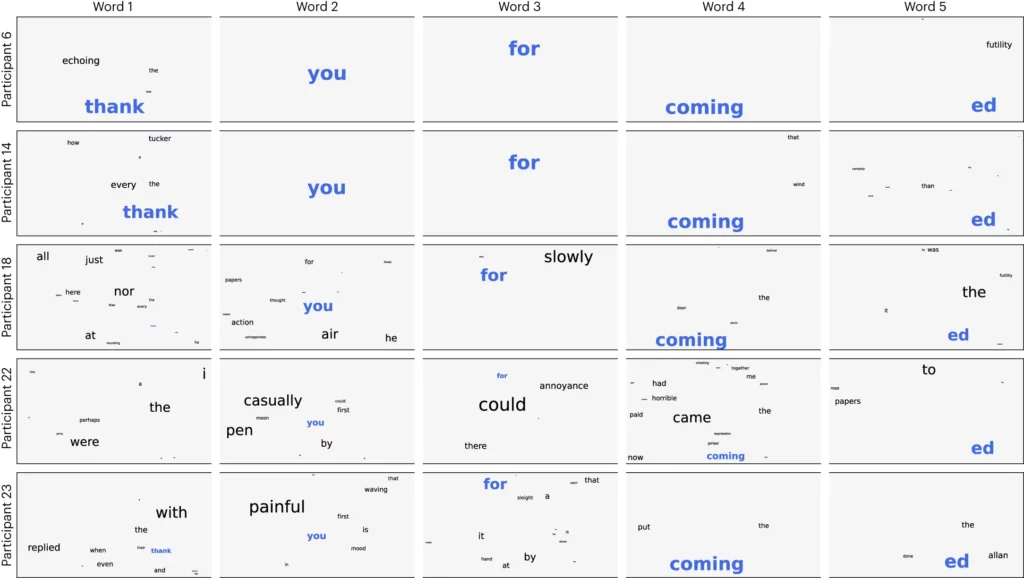

De onderzoekers splitsten de audio op in segmenten van 3 seconden en testten vervolgens hun model om te zien of het correct kon identificeren naar welk van de 1.500 segmenten de vrijwilliger luisterde. Het model voorspelde een soort woordwolk waarbij het meest waarschijnlijke woord het meeste gewicht kreeg.

Ze bereikten een gemiddelde nauwkeurigheid van 41% en een nauwkeurigheid van 95,9% met hun beste deelnemers.

Het onderzoek toont aan dat het mogelijk is om een redelijk goed idee te krijgen van welke spraak iemand hoort, maar nu moet het proces worden omgekeerd om nuttig te zijn. We moeten hun hersengolven meten en weten aan welk woord ze denken.

Het artikel stelt voor om een neuraal netwerk te trainen terwijl de proefpersonen woorden produceren door te spreken of te schrijven. Dat algemene model zou dan gebruikt kunnen worden om hersengolven en de bijbehorende woorden waaraan een ALS-patiënt dacht te begrijpen.

De onderzoekers waren in staat om spraaksegmenten te identificeren uit een beperkte vooraf bepaalde set. Voor goede communicatie zou je veel meer woorden moeten kunnen identificeren. Een generatieve AI gebruiken om het volgende meest waarschijnlijke woord te voorspellen dat iemand probeert te zeggen, zou daarbij kunnen helpen.

Ook al was het proces niet-invasief, het vereist nog steeds dat je aangesloten bent op een MEG apparaat. Helaas waren de resultaten van EEG-metingen niet geweldig.

Het onderzoek laat zien dat AI uiteindelijk gebruikt zou kunnen worden om mensen zonder stem, zoals ALS-patiënten, te helpen communiceren. Door gebruik te maken van een vooraf getraind model werd ook de noodzaak van meer nauwgezette woord-voor-woord training vermeden.

Meta AI heeft het model en de gegevens openbaar gemaakt, zodat hopelijk andere onderzoekers op hun werk kunnen voortbouwen.