Tesla gaat maandag zijn nieuwe $300M supercomputer aanzetten om zijn FSD-programma (Full Self Driving) een boost te geven.

De benadering die Tesla kiest voor zijn zelfrijdende technologie zal veel rekenkracht vergen.

Elon Musk gaf een paar dagen geleden een live demo van Tesla's FSD V12, en hoewel het erg goed presteerde, waren er een paar haperingen. Het systeem is nog in bèta en is een ambitieuze benadering van zelfrijdende auto's omdat het puur op camera's vertrouwt zonder hulp van radar- of lidarsensoren.

In een tweet zei Musk: "Wat ook verbazingwekkend is, is dat de rekenkracht die nodig is voor 8 camera's die op 36FPS draaien, slechts ongeveer 100W is op de AI-computer die door Tesla is ontworpen. Deze nietige hoeveelheid stroom is genoeg om bovenmenselijk rijgedrag te bereiken!"

Dat is misschien waar voor de rekenkracht die nodig is in het voertuig, maar het is alleen mogelijk als de AI goed getraind is.

Musk verklaarde de noodzaak van Tesla's investering in computers door te zeggen dat "het bereiken van bovenmenselijk rijden met AI miljarden dollars per jaar aan computer- en gegevensopslag vereist, evenals een enorm aantal gereden kilometers."

En daar komt de nieuwe supercomputer van Tesla om de hoek kijken. De computer bestaat uit 10.000 Nvidia H100 compute GPU's. Daarmee is het een van de krachtigste supercomputers ter wereld.

Tesla heeft momenteel 4 miljoen auto's op de weg die kunnen worden toegevoegd aan de trainingsdataset en verwacht wordt dat het er over een paar jaar 10 miljoen zullen zijn. Dat zijn heel wat video's om door te nemen.

Tim Zaman, een van Tesla's AI Engineering managers: "Dankzij real-world videotraining hebben we misschien wel de grootste trainingsdatasets ter wereld, met een hot tier cache-capaciteit van meer dan 200PB - ordes van grootte meer dan LLM's."

De nieuwe computer van Tesla levert 340 FP64 PFLOPS voor technisch rekenwerk en 39,58 INT8 ExaFLOPS voor AI-toepassingen.

Als deze cijfers je niet veel zeggen, dan zijn ze beter dan Leonardo, dat vierde staat op de lijst van 's werelds beste supercomputers.

Nvidia kan het niet bijbenen

De H100 GPU's van Nvidia doen AI-trainingen tot 9 keer sneller dan de A100-processors die Tesla tot nu toe heeft gebruikt. En het is nog steeds niet voldoende voor Tesla's behoeften.

Waarom kopen ze dan niet gewoon meer GPU's? Omdat Nvidia niet de capaciteit heeft om ze snel genoeg te leveren.

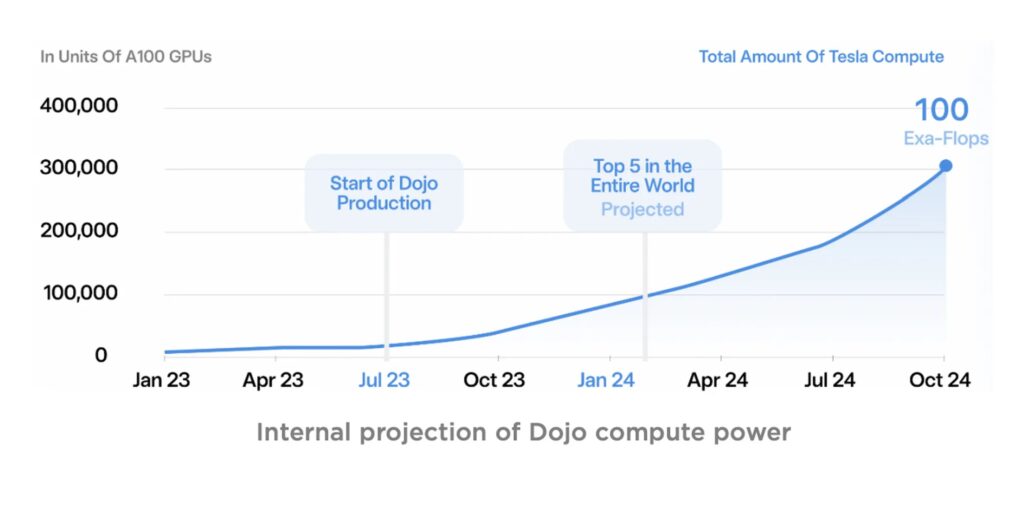

Maar Tesla wacht niet tot Nvidia zijn productie verhoogt. Het bouwt al een paar jaar zijn eigen supercomputer, Dojo, op basis van chips die Tesla zelf heeft ontworpen.

Dojo komt naar verwachting eind 2024 online en zal nog krachtiger zijn dan het Nvidia-cluster van Tesla.

Bron: Tesla

Productiemanager zijn bij Nvidia moet op dit moment een zware baan zijn met de onverzadigbare vraag naar Nvidia's GPU's.

Interessant genoeg werd Musk geciteerd toen hij zei: "Eerlijk gezegd... als zij (NVIDIA) ons genoeg GPU's zouden kunnen leveren, zouden we Dojo misschien niet nodig hebben."

We denken vaak aan Tesla als een bedrijf dat elektrische auto's bouwt, maar het lijkt er steeds meer op dat het eigenlijk een supercomputing AI-bedrijf is.

Het zal interessant zijn om te zien hoe de exponentiële toename in rekenkracht Musks ambities met zowel Tesla als zijn xAI-project voedt.