Nvidia heeft een bijgewerkte versie onthuld van zijn Grace Hopper Superchip (GH200) die het 2 maanden geleden aankondigde. De GH200 is ontworpen om datacenters voor grootschalige AI-verwerking van energie te voorzien.

De GH200 is nog niet in serieproductie gegaan, maar heeft al wel een grote upgrade in het geheugen. De geheime saus in deze nieuwe chips is het verbeterde geheugen met hoge bandbreedte, HBM3e genaamd, dat in staat is om gegevens met 5 TB/s te benaderen.

Dit is een verbetering van 50% ten opzichte van het HBM3-geheugen in de chip die eind mei werd aangekondigd.

Nvidia verbond dit snelle geheugen met krachtige CPU's en GPU's op hetzelfde apparaat. De resulterende toename in verwerkingssnelheid zal de AI-verwerkingscapaciteit van de huidige datacenters drastisch verbeteren.

Naast de bijgewerkte chip heeft Nvidia ook het GH200 Grace Hopper-platform aangekondigd, waarmee 2 van de GH200-chips op één bord kunnen worden aangesloten.

Het platform levert acht petaflops aan AI-verwerking en 282 GB HBM3e-geheugen met een bandbreedte van 10TB/s.

Hoe zal de chip van Nvidia datacenters veranderen?

De cijfers zijn soms moeilijk te bevatten. Dus hoe belangrijk is deze nieuwe chip en dit platform?

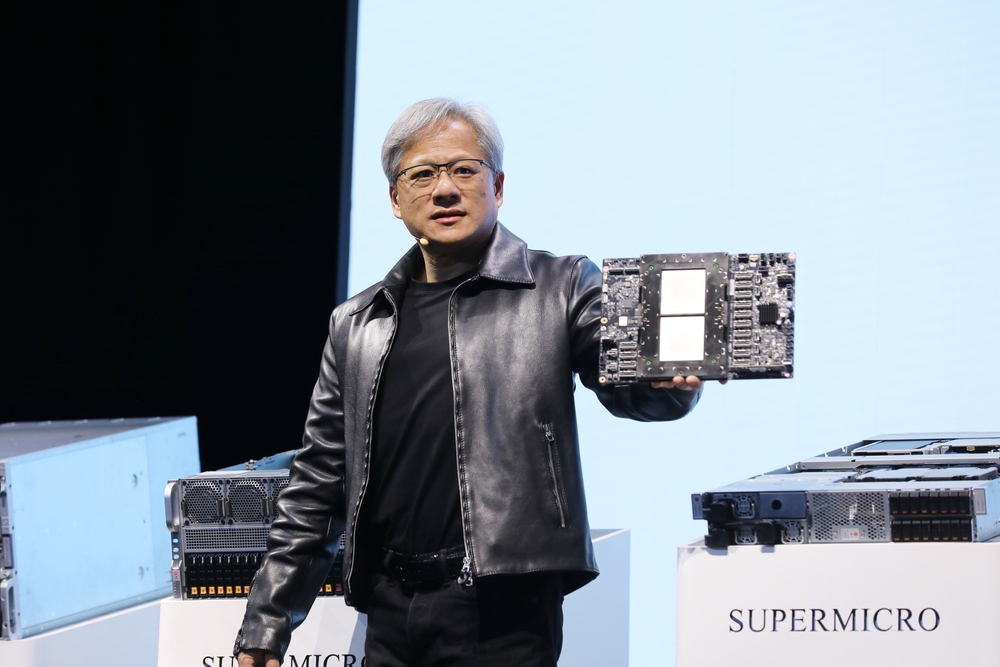

In zijn presentatie gebruikte Nvidia CEO Jensen Huang het voorbeeld van een typisch datacenter met 8800 x86-processors die verschillende rekenfuncties uitvoeren (ISO-budget).

Zo'n datacenter met Llama 2 voor inferentie, waarbij een vectordatabase wordt opgevraagd en SDXL de uitvoer genereert, zou ongeveer $100m kosten en 5MW aan stroom verbruiken.

Een datacenter van $100m met 2500 GH200-platforms zou dezelfde modellen 12 keer sneller kunnen draaien en slechts 3MW stroom verbruiken.

Als een datacenter zich zou richten op een zeer specifieke set taken (ISO-workload), dan wordt de vergelijking nog onthutsender.

U hoeft slechts $8m uit te geven voor 210 GH200-apparaten die 20 keer minder energie verbruiken om de prestaties van een datacenter van $100m te evenaren.

Het hoeft geen betoog dat AI-datacenters voor cloud computing die voor deze release in de planningsfase zaten, terug moeten naar de tekentafel.

De GH200-chips zullen in het tweede kwartaal van 2024 op de markt komen en zullen naar verwachting een groot deel van de x86-processoractiviteit opslokken. AMD's nieuwe MI300-chip is Nvidia's naaste rivaal, maar zijn grotere geheugenvoordeel lijkt te worden uitgehold door de upgrade in de nieuwe GH200.

De vooruitgang in processortechnologie die we zien is groter dan ooit. Wet van Moore en het lijkt er niet op dat het langzamer zal gaan. Generatieve AI-toepassingen leveren al indrukwekkende prestaties, maar het ziet ernaar uit dat ze nog veel sneller zullen worden.