Een onderzoek door psychologen aan de UCLA heeft aangetoond dat GPT-3 ongeveer net zo goed is als studenten aan de universiteit in het oplossen van redeneerproblemen.

We weten dat LLM's zoals GPT-3 goed zijn in het genereren van reacties op basis van de gegevens waarop ze getraind zijn, maar hun vermogen om te redeneren is twijfelachtig. Analoog redeneren is het vermogen van mensen om wat we leren van een ongerelateerde ervaring toe te passen op een probleem waar we nog niet eerder mee te maken hebben gehad.

Op dat vermogen vertrouw je als je een vraag moet beantwoorden die je nog nooit eerder hebt gezien. Je kunt er doorheen redeneren op basis van eerdere problemen die je hebt opgelost. En uit het onderzoek blijkt dat GPT-3 dat vermogen ook heeft ontwikkeld.

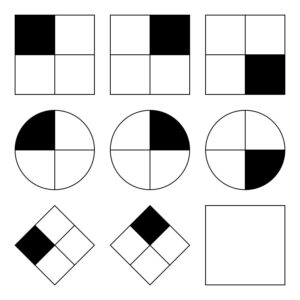

De UCLA-onderzoekers GPT-3 aan het werk zetten met een reeks problemen die lijken op Progressieve matrices van Raven waarbij je de volgende afbeelding in een reeks afbeeldingen moet voorspellen. Hier is een eenvoudige die je kunt proberen.

GPT-3 hield zich goed staande in vergelijking met de 40 studenten van UCLA die dezelfde test moesten maken. De AI had de antwoorden 80% van de tijd goed, terwijl de 40 studenten gemiddeld rond de 60% zaten. De topstudenten scoorden ongeveer hetzelfde als GPT-3.

UCLA psychologie professor Hongjing Lu, de senior auteur van het onderzoek, zei: "Verrassend genoeg deed GPT-3 het niet alleen ongeveer net zo goed als mensen, maar maakte het ook vergelijkbare fouten."

De onderzoekers vroegen GPT-3 ook om enkele woordassociatieproblemen op te lossen. Bijvoorbeeld: "'Auto' is bij 'Weg' als 'Boot' bij welk woord?". Het antwoord is duidelijk 'water', maar dit soort vragen kunnen lastig zijn voor een AI.

De onderzoekers dachten tenminste dat het lastig zou zijn. Het blijkt dat GPT-3 beter presteerde dan de gemiddelde universiteitsstudenten bij hun SATs.

GPT-3 worstelt met problemen die gemakkelijk zijn voor mensen

Waar AI-modellen moeite mee hebben, zijn problemen die een visueel begrip van de fysieke ruimte vereisen. Als je GPT-3 een lijst met gereedschap zoals een hamer, een spijker en een schilderij voorlegt, kan het niet de voor de hand liggende oplossing bedenken om het schilderij aan de muur te hangen.

Dat soort problemen is voor mensen gemakkelijk op te lossen omdat we fysieke objecten kunnen zien, vasthouden en voelen in een ruimte die we innemen. Deze ervaringen maken het makkelijk voor onze hersenen om te leren en problemen op te lossen op een manier die AI-modellen niet kunnen. Dat gezegd hebbende, GPT-4 wordt nu beter in dit soort redeneringen.

Hoewel de onderzoekers de prestaties van GPT-3 konden meten, hebben ze geen idee van het "denkproces" dat het volgt om de antwoorden te krijgen. Volgt het een vergelijkbaar denkproces als mensen of doet het iets heel anders? Omdat GPT-3 een gesloten model is, is het niet mogelijk om onder de motorkap te kijken om te zien wat er gebeurt.

Het verrassende resultaat van dit onderzoek is dat GPT-3 in staat lijkt te zijn om nieuwe problemen op te lossen zonder enige directe training. Dat komt sterk overeen met hoe mensen nieuwe problemen oplossen. GPT-4 zal naar verwachting nog beter presteren op deze problemen en wie weet wat voor andere "denk"-vaardigheden naar voren zullen komen na meer testen.

Hoewel ruimtelijk redeneren een uitdaging is voor LLM's, kunnen deze uitdagingen worden opgelost door visuele modellen zoals Google's RT-2 die onlangs werd aangekondigd. Zodra AI-modellen fysiek kunnen "zien" en interageren met hun omgeving, zal hun probleemoplossend vermogen exponentieel verbeteren.