De New Yorkse advocaat Steven A Schwartz gebruikte ChatGPT om onderzoek te doen naar verschillende 'zaken' die vals bleken te zijn.

De zaak van Schwartz betrof een man die de Colombiaanse luchtvaartmaatschappij Avianca aanklaagde. De aanklager werkte samen met een juridisch team, Levidow, Levidow & Oberman, dat een juridische brief opstelde waarin werd verwezen naar volledig valse rechtszaken.

Schwartz vroeg ChatGPT om zekerheid dat de gevallen echt waren, maar hij probeerde alleen een van de gevallen in detail te controleren, en ChatGPT verzekerde hem dat het kon worden gevonden in de Westlaw en LexisNexis databases. Op basis daarvan nam Schwartz aan dat de andere zaken ook echt waren.

Later bleek dat slechts één geval echt was, Zicherman v. Korean Air Lines Co., 516 U.S. 217 (1996)en ChatGPT citeerde de datum en verschillende andere details verkeerd.

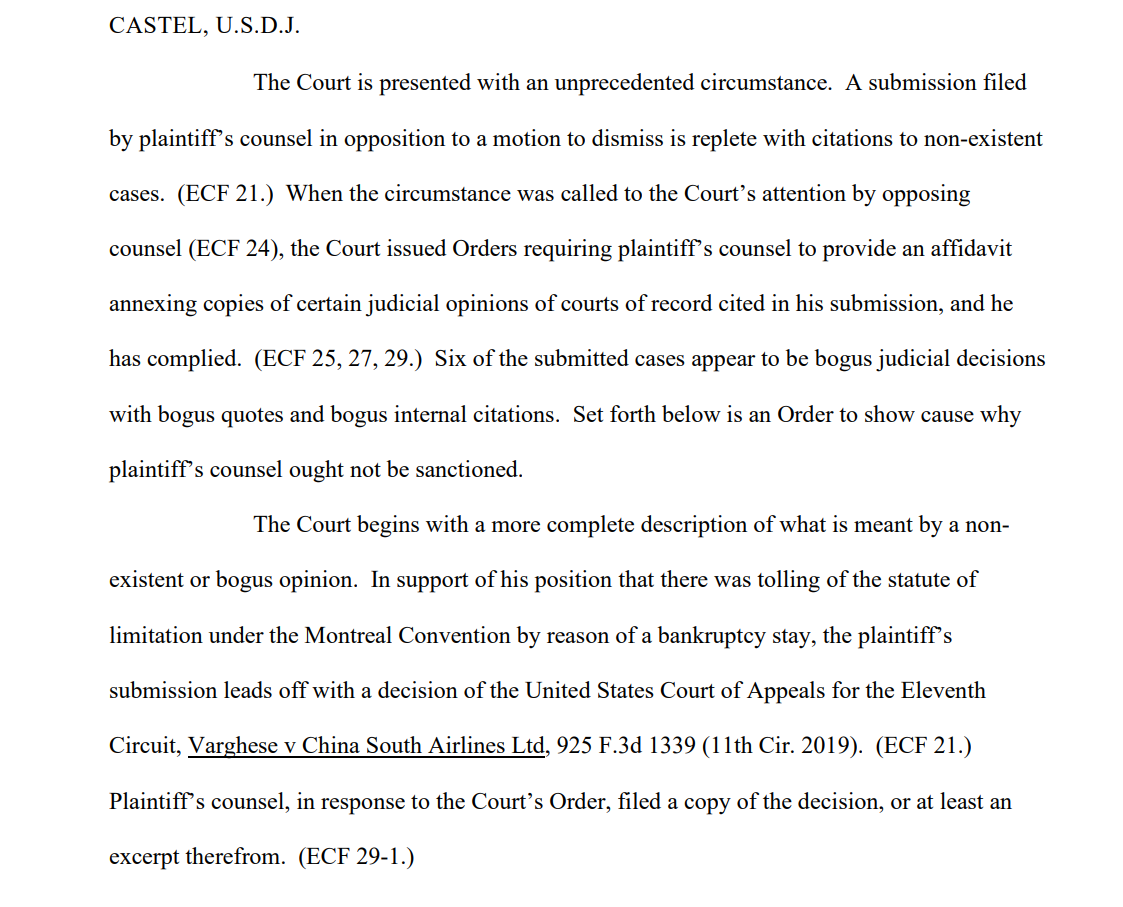

Nadat het team van de aanklager de brief had ingediend, verklaarde een van de ontvangers, US District Judge Kevin Castel: "Zes van de ingediende zaken lijken neprechterlijke beslissingen te zijn met nepcitaten en nepinterne citaten."

Een van de rechtsboeken zegt"De rechtbank wordt geconfronteerd met een ongekende omstandigheid. Een verklaring ingediend door de raadsman van de eiser in oppositie tegen een motie tot verwerping staat vol met citaten naar niet-bestaande zaken."

Schwartz, die 30 jaar ervaring heeft als advocaat, pleitte dat dit een onschuldige vergissing was en vertelde de rechtbank dat hij "veel spijt" had van het gebruik van ChatGPT voor onderzoek en dat hij "niet wist dat de inhoud ervan vals kon zijn". Hij gaf ook toe ChatGPT in andere rechtszaken te hebben gebruikt.

Schwartz, die optrad namens Peter LeDocu, een collega bij hetzelfde advocatenkantoor, moet op 8 juni voor het Hof verschijnen om uit te leggen waarom hij en zijn advocatenkantoor niet bestraft moeten worden.

Wanneer ChatGPT controleert

OpenAI is er heel duidelijk over dat ChatGPT kwetsbaar is voor het verkeerd weergeven van de waarheid, maar de AI kan zelfverzekerd overkomen als hij contextueel relevante 'voorbeelden' geeft die niet feitelijk correct zijn - ook wel "hallucineren" genoemd.

Dit is ook een probleem in de academische wereld, waar ChatGPT vaak valse referenties genereert, die soms zo ver gaan dat ze realistische studies en experimenten fabriceren die nooit hebben plaatsgevonden.

Veel universiteiten hebben verklaringen uitgegeven waarin ze dit benadrukken. Bijvoorbeeld, Duke University stelt, "Wat je misschien niet weet over ChatGPT is dat het aanzienlijke beperkingen heeft als betrouwbare onderzoeksassistent. Een van die beperkingen is dat het citaten verzint of "hallucineert" (in termen van machinaal leren)."

Het analyseren van referenties op inconsistenties is een betrouwbare manier geworden voor docenten om studenten te betrappen die ChatGPT gebruiken om essays te schrijven.

Dat is precies wat er met Schwartz is gebeurd - hij werd gepakt. Hij was niet de eerste en zal ook niet de laatste zijn. Hij leek oprecht onwetend, maar onwetendheid is niet noodzakelijk een verdediging in de rechtszaal.

Het genereren van valse juridische citaten is een alarmerend voorbeeld van de feilbaarheid van ChatGPT en dient als een krachtige herinnering om 'feiten' die worden aangeprezen door generatieve AI's te controleren, dubbel en driedubbel te controleren.