I 1956 skrev Philip K. Dick en novelle med tittelen "The Minority Report" som spant et nett av en fremtid der "precogs" kunne forutse forbrytelser før de skjedde i virkeligheten.

Noen tiår senere brakte Tom Cruise denne uhyggelige visjonen til det store lerretet, der han jaktet på potensielle forbrytere basert på disse spådommene.

Begge versjonene tvang oss til å tenke over de etiske implikasjonene av å bli arrestert for noe man kan komme til å gjøre i fremtiden.

I dag, når prediktive politimetoder sniker seg inn i moderne rettshåndhevelse, må man spørre seg: Er vi i ferd med å realisere Dicks forutseende fortelling?

Hva er forutseende politiarbeid, og hvordan fungerer det?

Forutseende politiarbeid kombinerer rettshåndhevelse og avansert analyse, og utnytter maskinlæring til å forutse kriminelle aktiviteter før de utspiller seg.

På papiret er premisset enkelt nok: Hvis vi kan avkode mønstrene som skjuler seg i historiske kriminalitetsdata, kan vi lage algoritmer for å forutsi fremtidige hendelser.

Prosessen starter med å samle inn historiske kriminalitetsregistreringer, overvåkningsstrømmer, samtaler på sosiale medier og til og med nyanser som værsvingninger. Denne enorme mengden informasjon mates deretter inn i sofistikerte maskinlæringsmodeller som er utviklet for å skille ut underliggende mønstre.

Modellen kan for eksempel oppdage at et bestemt nabolag opplever en økning i antall innbrudd på regnfulle helgekvelder.

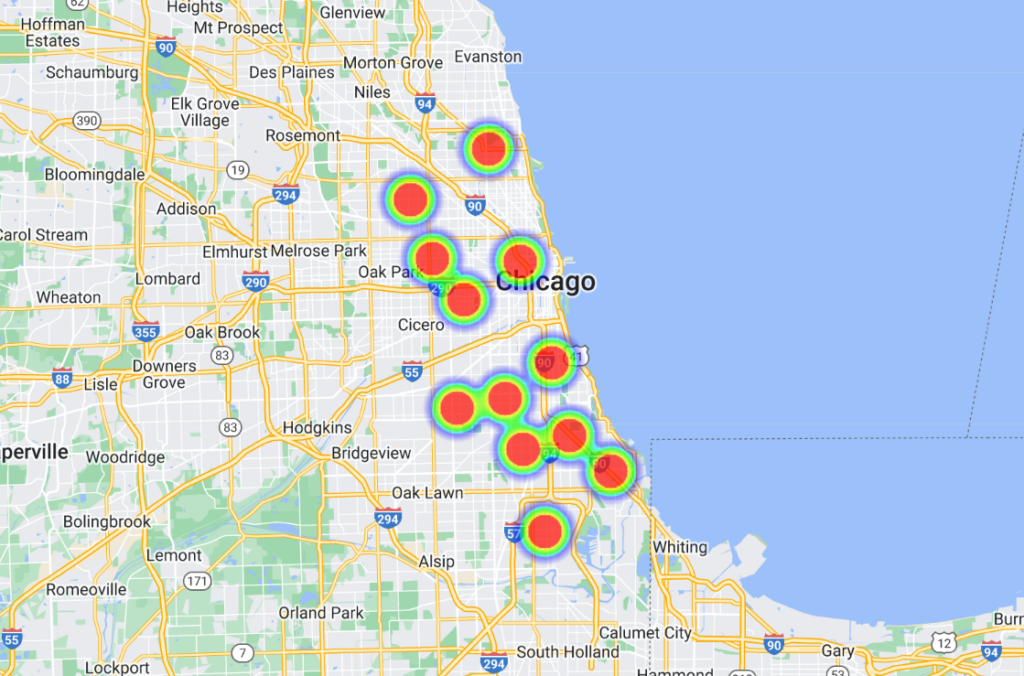

Når disse sammenhengene er avdekket, kan avanserte programvareplattformer omdanne dem til visuelle fremstillinger, ofte i form av "varmekart" som viser sannsynlige hotspots for kriminalitet. Dette gir i sin tur politiet mulighet til å allokere ressursene sine proaktivt og optimalisere patruljeringen og innsatsen.

Noen modeller har gått et skritt videre og listet opp personer med navn og adresse, noe som gir betjentene svært spesifikke og lokaliserte prediksjoner.

Historien om forutseende politiarbeid

Forutseende polititeknologi er fortsatt i sin spede begynnelse, og selv om det har vært noen innflytelsesrike aktører i bransjen, som Palantir, er bransjen liten.

I juni 2022 ble University of Chicago utviklet en AI-modell i stand til å forutsi hvor og hvor mye kriminalitet som skjer i byen med en påstått 90%-presisjon.

Ved hjelp av åpne kriminalitetsdata fra 2014 til 2016 delte teamet Chicago inn i kvadrater på ca. 300 meter (1000 fot). Modellen kunne en uke i forveien forutsi hvilket kvadrat som hadde høyest sannsynlighet for å bli utsatt for kriminalitet.

Studien hadde ærlige hensikter, og avdekket romlige og sosioøkonomiske skjevheter i politiets innsats og ressursallokering. Den fant at velstående nabolag fikk mer ressurser enn områder med lavere inntekt.

I studien heter det: "Her viser vi at selv om prediktive modeller kan styrke statens makt gjennom kriminalitetsovervåking, muliggjør de også overvåking av staten ved å spore systemiske skjevheter i kriminalitetshåndhevelsen."

I tillegg ble modellen trent med data fra syv andre amerikanske byer, som viste lignende resultater. Alle datasettene og algoritmene er gjort tilgjengelige på GitHub.

Chicago er et viktig eksempel på datadrevet og AI-støttet politiarbeid. Et annet eksempel er byens varmekart over våpenkriminalitetsom identifiserer "hotspots" for kriminalitet som kan brukes i politiarbeidet.

En bemerkelsesverdig hendelse tilbake i 2013 - i den spede begynnelsen av forutseende politiarbeid - var involvert Robert McDaniels, en innbygger i Chicagos Austin-distrikt, som står for 90% av byens våpenforbrytelser.

Til tross for at McDaniel ikke hadde begått vold, ble han to ganger utsatt for vold med skytevåpen ved at politiet banket på døren hans og gjorde ham til skyteskive.

En undersøkelse utført av The Verge sier at en journalist fra Chicago Tribune kontaktet McDaniel angående "varmlisten" - et uoffisielt navn som politiet har gitt algoritmene som merker potensielle skyttere og mål.

Ishanu Chattopadhyay, den ledende forskeren i Chicago 2022 prosjekt for kriminalitetsforutsigelse, understreket at modellen deres forutser steder, ikke individer. "Det er ikke Minority Report", sa han - men McDaniels-hendelsen trekker absolutt noen paralleller.

Chattopadhyay påpekte at de med vilje utelot mindre narkotika- og trafikkforseelser som ble rapportert av innbyggerne, og fokuserte på volds- og eiendomsforbrytelser som rapporteres oftere.

Imidlertid er studier viser at svarte personer oftere blir anmeldt for kriminalitet enn hvite. Følgelig blir svarte nabolag urettferdig stemplet som "høyrisikoområder".

Dessuten fører økt politiinnsats i et område til mer anmeldt kriminalitet, noe som skaper en tilbakekoblingssløyfe som forvrenger oppfatningen av kriminaliteten.

Hvis man baserer seg på tidligere data, kan man videreføre stereotypier og overse potensialet for endring og rehabilitering.

Hvordan har forutseende politiarbeid fungert?

Forutseende politiarbeid er, ikke overraskende, svært omstridt, men fungerer det i det hele tatt, eller oppfyller det sitt grunnleggende formål?

En undersøkelse fra oktober 2023 av The Markup og Wired avslørte åpenbare feil, noe som føyer seg inn i rekken av bevis som fremhever farene og manglene ved å overføre politiets beslutningsprosesser til maskiner.

Programmet i fokus er Geolitica, en programvare for forutseende politiarbeid som brukes av politiet i Plainfield, New Jersey. Det er verdt å merke seg at Plainfields politiavdeling var den eneste av 38 avdelinger som var villig til å dele data med mediene.

Tidligere kjent som PredPolble denne maskinlæringsprogramvaren anskaffet av ulike politiavdelinger.

The Markup og Wired analyserte 23 631 av Geoliticas spådommer fra februar til desember 2018. Av disse stemte mindre enn 100 spådommer med reelle kriminalitetstilfeller, noe som resulterte i en suksessrate på under en halv prosent.

Disse prediksjonsmodellene har alltid vært omstridte, og de har reist en rekke etiske spørsmål knyttet til deres potensial for å forsterke diskriminerende og rasistiske fordommer som er utbredt innen kunstig intelligens og rettshåndhevelse.

Denne nylige etterforskningen understreker etiske dilemmaer og setter spørsmålstegn ved programvarens evne til å forutsi forbrytelser.

Selv om programvaren viste små variasjoner i prediksjonsnøyaktighet på tvers av kriminalitetstyper (f.eks. forutså den 0,6 prosent av ran eller grove overfall korrekt, sammenlignet med 0,1 prosent av innbrudd), er det overordnede bildet fortsatt at den presterte svært dårlig.

Plainfields politisjef David Guarinos åpenhjertige svar kaster lys over virkeligheten. "Hvorfor skaffet vi oss PredPol? Vi ønsket å effektivisere kriminalitetsbekjempelsen vår", sier han.

"Jeg er ikke sikker på at den oppnådde det. Vi brukte den sjelden, om noen gang." Han nevnte også at politiet sluttet å bruke den.

Kaptein Guarino foreslo at midlene som ble bevilget til Geolitica - som utgjorde en årlig abonnementsavgift på $20 500 pluss ytterligere $15 500 for det andre året - kunne ha vært investert mer effektivt i samfunnsorienterte programmer.

Geolitica vil etter planen legge ned virksomheten innen utgangen av året.

Bevis som dokumenterer skjevheter i forutseende politiarbeid

Løftet om forutseende politiarbeid er fortsatt forlokkende, særlig ettersom politistyrkene blir stadig mer presset og kvaliteten på politiets menneskelige beslutningstaking kommer i vanry.

Politistyrker i USA, Storbritannia og flere europeiske land, deriblant Frankrike, blir gransket på grunn av fordommer mot minoritetsgrupper.

Medlemmer av både det britiske overhuset og underhuset oppfordrer til en midlertidig stans om politiets bruk av teknologi for direkte ansiktsgjenkjenning.

Dette kom frem etter at politiminister Chris Philip diskuterte å gi politiet tilgang til 45 millioner bilder fra passdatabasen for ansiktsgjenkjenning. Så langt har 65 parlamentarikere og 31 rettighets- og rasismeorganisasjoner gått imot bruk av ansiktsgjenkjenningsteknologi i politiarbeidet.

Interesseorganisasjonen Big Brother Watch at 89% av politiets ansiktsgjenkjenningsvarsler i Storbritannia ikke oppfyller sitt formål, med uforholdsmessig dårligere resultater for etniske minoritetsgrupper og kvinner. Et forsøk med ansiktsgjenkjenning utført av London Metropolitan Police i 2018 hadde et dystert suksessrate på bare rundt 2%.

Som Michael Birtwistle fra Ada Lovelace Institute, beskrevet"Nøyaktigheten og det vitenskapelige grunnlaget for ansiktsgjenkjenningsteknologiene er svært omstridt, og det er usikkert om de er lovlige."

I USA har et samarbeidsprosjekt mellom Columbia University, AI Now Institute og andre nylig analysert amerikanske rettstvister som involverer algoritmer.

Studien viste at AI-systemer ofte ble implementert i all hast, uten tilstrekkelig tilsyn, hovedsakelig for å kutte kostnader. Dessverre resulterte disse systemene ofte i konstitusjonelle problemer på grunn av iboende skjevheter.

Minst fire svarte menn har blitt feilaktig arrestert og/eller fengslet i påvente av feilaktige ansiktsmatcher i USA, deriblant Nijeer Parksfeilaktig anklaget for butikktyveri og trafikklovbrudd til tross for at han befant seg 50 kilometer unna de påståtte hendelsene. Han tilbrakte deretter ti dager i fengsel og måtte betale tusenvis av kroner i advokatutgifter.

Den forfatterne av studien konkluderte"Disse AI-systemene ble implementert uten nevneverdig opplæring, støtte eller tilsyn, og uten noen spesifikk beskyttelse for mottakerne. Dette skyldes delvis at de ble innført for å oppnå kostnadsbesparelser og standardisering i henhold til en monolittisk teknologi-anskaffelsesmodell, som sjelden tar hensyn til konstitusjonelle ansvarsforhold."

Forutseende politiarbeid kan oppmuntre til unaturlig beslutningstaking

Selv når forutseende politiarbeid er treffsikkert, må mennesker handle ut fra spådommene, og det er her det blir vanskelig.

Når en algoritme forteller politiet at de må være et sted fordi en forbrytelse er i ferd med å bli begått/er sannsynlig, er det langt fra utenkelig å tro at dette forvrenger beslutningstakingen.

Det finnes noen grunnleggende psykologiske teorier som det kan være klokt å forholde seg til når man vurderer AIs rolle i politiarbeidet.

For det første, når en algoritme informerer politiet om et sannsynlig åsted, kan den potensielt få dem til å se situasjonen gjennom en forventningslinse. Dette kan ha spilt en rolle i McDaniels-hendelsen - politiet ankom åstedet i forventning om at en hendelse skulle finne sted, noe som utløste en eskalering av hendelsene i et ustabilt miljø.

Dette har sin rot i bekreftelsesskjevhet, som innebærer at når vi først har fått en viss informasjon, har vi en tendens til å oppsøke og tolke senere informasjon på en måte som er i tråd med den opprinnelige oppfatningen.

Når en algoritme forteller en person at det er sannsynlig at en forbrytelse vil skje, kan vedkommende ubevisst legge mer vekt på signaler som bekrefter denne prediksjonen, og overse signaler som motsier den.

Dessuten kan algoritmer, spesielt de som brukes i offisielle sammenhenger, bli sett på som autoritative på grunn av deres beregningsnatur, og tjenestemenn kan ha overdreven tillit til dem.

Og så er det risikoen for moralsk frikobling. Betjentene kan skyve ansvaret for handlingene sine over på algoritmen, og tenke at det er programvaren som har tatt avgjørelsen, ikke dem - noe som også er svært relevant innen krigføring.

Debattene her er parallelle med debattene rundt Bruk av kunstig intelligens på slagmarken, som byr på noen lignende dilemmaer.

AIs påtvungne autoritet kan resultere i et "ansvarsgap" der ingen tar ansvar for feil som gjøres av AI, noe Kate Crawford og Jason Schultz fremhever i en nylig publisert JSTOR-artikkel.

Alt i alt, ut fra de bevisene vi har i dag, bidrar forutseende politiarbeid ofte til å opprettholde skjevheter snarere enn å redusere dem.

Når spådommer kombineres med menneskelige beslutninger, kan konsekvensene bli katastrofale.