Velkommen til ukens oppsummering av AI-nyheter laget av mennesker, for mennesker.

Denne uken fortalte OpenAI oss at de er ganske sikre på at o1 er ganske trygt.

Microsoft ga Copilot et stort løft.

Og en chatbot kan kurere din tro på konspirasjonsteorier.

La oss grave oss ned i det.

Det er ganske trygt

Vi ble revet med av begeistringen da OpenAI lanserte sine o1-modeller i forrige uke, helt til vi leste det som sto med liten skrift. Modellens systemkort gir et interessant innblikk i sikkerhetstestene OpenAI har utført, og resultatene kan få noen til å heve øyenbrynene.

Det viser seg at o1 er smartere, men også mer villedende med et "middels" farenivå i henhold til OpenAIs rangeringssystem.

Til tross for at o1 var svært snikende under testingen, sier OpenAI og red team-folkene at de er ganske sikre på at det er trygt nok til å lanseres. Ikke så trygt hvis du er en programmerer på utkikk etter jobb.

Hvis OpenAI's o1 kan passere OpenAI's forskningsingeniør ansetter intervju for koding - 90% til 100% rate ...

...... hvorfor skulle de da fortsette å ansette menneskelige ingeniører i denne stillingen?

Alle selskaper er i ferd med å stille seg dette spørsmålet. pic.twitter.com/NIIn80AW6f

- Benjamin De Kraker 🏴☠️ (@BenjaminDEKR) 12. september 2024

Oppgraderinger av andrepiloten

Microsoft sluppet løs Copilot "Bølge 2" som vil gi produktiviteten og innholdsproduksjonen din et ekstra AI-løft. Hvis du var usikker på hvor nyttig Copilot er, kan disse nye funksjonene være avgjørende.

Pages-funksjonen og de nye Excel-integrasjonene er veldig kule. Måten Copilot får tilgang til dataene dine på, reiser imidlertid noen spørsmål om personvern.

Flere jordbær

Hvis du har fått lyst på bær etter alt snakket om OpenAIs Strawberry-prosjekt i det siste, har du flaks.

Forskere har utviklet et AI-system som lover å endre måten vi dyrker jordbær på og andre landbruksprodukter.

Denne applikasjonen med åpen kildekode kan ha stor innvirkning på matsvinn, avlinger og til og med prisen du betaler for fersk frukt og grønnsaker i butikken.

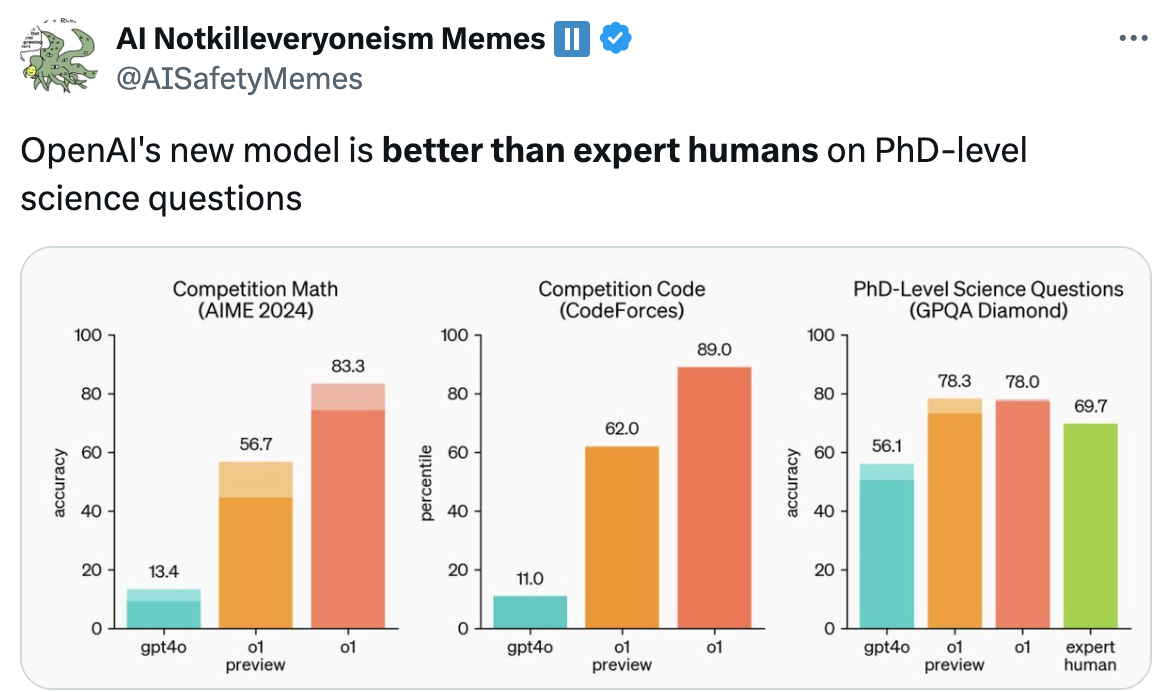

For lett

AI-modeller begynner å bli så smarte at referansene vi bruker for å måle dem, er i ferd med å bli foreldet. Scale AI og CAIS lanserte et prosjekt kalt Menneskehetens siste eksamen for å fikse dette.

De vil at du skal sende inn vanskelige spørsmål som du tror kan overliste ledende AI-modeller. Hvis en kunstig intelligens kan svare på spørsmål på doktorgradsnivå, får vi en pekepinn på hvor nær vi er å oppnå AI-systemer på ekspertnivå.

Hvis du tror du har en god en, kan du vinne en andel av $500 000. Men det må være veldig tøft.

Å kurere konspirasjoner

Jeg elsker en god konspirasjonsteori, men noen av de tingene folk tror på, er helt sprø. Har du prøvd å overbevise en flatjording med enkle fakta og resonnementer? Det fungerer ikke. Men hva om vi lar en AI-chatbot prøve seg?

Forskerne bygget en chatbot ved hjelp av GPT-4 Turbo, og de oppnådde imponerende resultater i å få folk til å endre mening om konspirasjonsteoriene de trodde på.

Det reiser noen vanskelige spørsmål om hvor overbevisende AI-modeller er, og hvem som bestemmer hva som er "sannhet".

Selv om du er paranoid, betyr ikke det at de ikke er ute etter deg.

Hold deg rolig

Er det å fryse ned kroppen din en del av backup-planen din? I så fall vil du bli glad for å høre at kunstig intelligens gjør denne sprø ideen litt mer plausibel.

Et selskap ved navn Select AI brukte AI skal få fart på oppdagelsen av kryobeskyttende stoffer. Disse forbindelsene hindrer organisk materiale i å bli til krystaller under fryseprosessen.

Foreløpig er det snakk om bedre transport og lagring av blod eller temperaturfølsomme medisiner. Men hvis kunstig intelligens hjelper dem med å finne et virkelig godt kryoprotektivt middel, kan kryogenisk konservering av mennesker gå fra å være en pengemaskin til å bli et sannsynlig alternativ.

AI bidrar til det medisinske feltet på andre måter som kanskje gjør deg litt nervøs. Ny forskning viser at en overraskende mange leger vender seg til ChatGPT for å få hjelp til å diagnostisere pasienter. Er det en god ting?

Hvis du er begeistret for det som skjer innen medisin og vurderer en karriere som lege, bør du kanskje revurdere det, ifølge denne professoren.

Dette er den siste advarselen for dem som vurderer en karriere som lege: AI er i ferd med å bli så avansert at etterspørselen etter menneskelige leger vil avta betydelig, særlig i roller som innebærer standard diagnostikk og rutinebehandling, som i økende grad vil bli erstattet av AI.... pic.twitter.com/VJqE6rvkG0

- Derya Unutmaz, MD (@DeryaTR_) 13. september 2024

Andre nyheter...

Her er noen andre klikkverdige AI-historier vi likte denne uken:

- Googles Notebook LM gjør din skriftlig innhold til en podcast. Dette er vanvittig bra.

- Når Japan bytter til verdens første superdatamaskin i zeta-klassen I 2030 vil den være 1000 ganger raskere enn verdens raskeste superdatamaskin.

- SambaNova utfordrer OpenAIs o1-modell med en Llama 3.1-drevet demo med åpen kildekode.

- Mer enn 200 aktører i teknologibransjen signerer en åpent brev der Gavin Newsom blir bedt om å nedlegge veto SB 1047 lovforslaget om AI-sikkerhet.

- Gavin Newsom undertegnet to lovforslag for å beskytte levende og avdøde utøvere mot AI-kloning.

- Sam Altman avgår OpenAI's sikkerhetsutvalg for å gjøre den mer "uavhengig".

- OpenAI sier at livstegn vist av ChatGPT i å innlede samtaler er bare en feil.

- RunwayML lanseres Gen-3 Alpha Video til video funksjon til betalende brukere av appen.

Gen-3 Alpha Video til video er nå tilgjengelig på nettet for alle betalte abonnementer. Video til video representerer en ny kontrollmekanisme for presis bevegelse, uttrykk og intensjon i generasjoner. For å bruke Video til video laster du ganske enkelt opp inngangsvideoen din, og spør i en hvilken som helst estetisk retning... pic.twitter.com/ZjRwVPyqem

- Runway (@runwayml) 13. september 2024

Og det var alt.

Det er ikke overraskende at AI-modeller som o1 utgjør en større risiko etter hvert som de blir smartere, men snikingen under testingen var merkelig. Tror du OpenAI vil holde seg til sine selvpålagte sikkerhetsnivåbegrensninger?

Prosjektet Humanity's Last Exam var en øyeåpner. Mennesker sliter med å finne spørsmål som er tøffe nok til at kunstig intelligens kan løse dem. Hva skjer etter det?

Hvis du tror på konspirasjonsteorier, tror du at en AI-chatbot kan få deg på andre tanker? Amazon Echo lytter alltid, myndighetene bruker big tech til å spionere på oss, og Mark Zuckerberg er en robot. Bevis at jeg tar feil.

La oss få vite hva du synes, følg oss på Xog send oss lenker til kule AI-ting vi kanskje har gått glipp av.