Når ChatGPT gir deg det riktige svaret på spørsmålet ditt, resonnerer den seg gjennom forespørselen eller husker den bare svaret fra treningsdataene sine?

Forskere ved MITs Computer Science and Artificial Intelligence Laboratory (CSAIL) har utviklet en rekke tester for å se om AI-modeller "tenker" eller bare har god hukommelse.

Når du ber en AI-modell om å løse en matematisk oppgave som "Hva er 27+62?", kommer den raskt tilbake med det riktige svaret: 89. Hvordan kan vi vite om den forstår den underliggende aritmetikken eller om den bare så problemet i treningsdataene sine?

I avisen deresForskerne testet GPT-4, GPT-3.5 Turbo, Claude 1.3 og PaLM2 for å se om de kunne "generalisere ikke bare til usette forekomster av kjente oppgaver, men også til nye oppgaver".

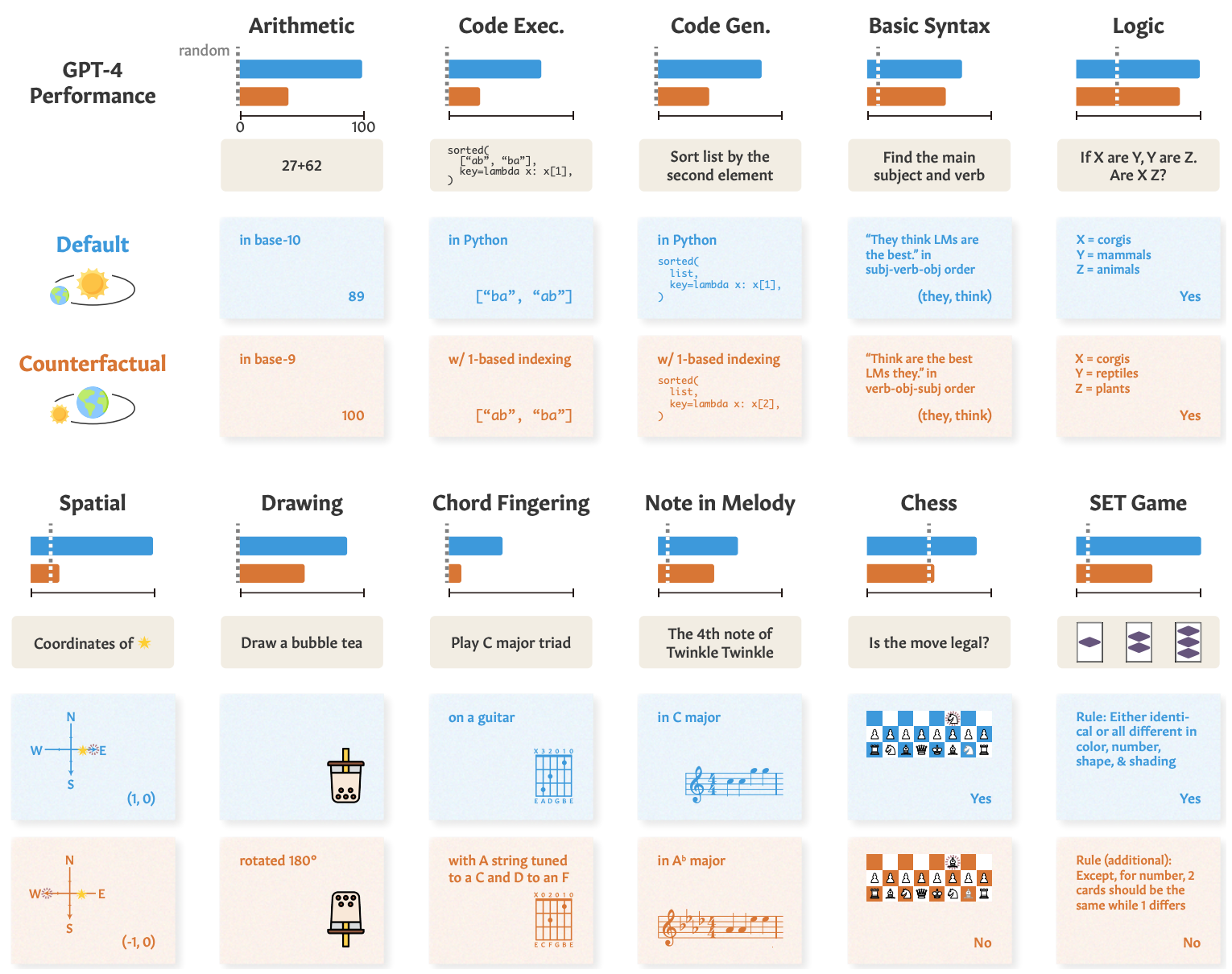

De utformet en serie på 11 oppgaver som skilte seg litt fra standardoppgavene som LLM-ene generelt presterer godt i.

LLM-ene bør gjøre det like bra med de "kontrafaktiske oppgavene" hvis de bruker generelle og overførbare prosedyrer for oppgaveløsning.

Hvis en LLM "forstår" matematikk, bør den for eksempel kunne gi riktig svar på en matematisk oppgave i base 10 og den sjeldent brukte base 9.

Her ser du eksempler på oppgavene og GPT-4s ytelse.

GPT-4s prestasjoner i standardtester (blå linje) er gode, men dens evner innen matematikk, logisk resonnering, romlig resonnering og andre evner (oransje linje) blir betydelig dårligere når oppgaven endres noe.

De andre modellene viste lignende nedbrytning, med GPT-4 på topp.

Til tross for forringelsen var resultatene på kontrafaktiske oppgaver fortsatt bedre enn tilfeldighetene. AI-modellene prøver å resonnere seg gjennom disse oppgavene, men er ikke særlig gode til det.

Resultatene viser at AI-modellenes imponerende prestasjoner i oppgaver som høyskoleeksamener er avhengig av utmerket gjenkalling av treningsdata, ikke resonnering. Dette understreker ytterligere at AI-modeller ikke kan generaliseres til usynlige oppgaver,

Zhaofeng Wu, doktorgradsstudent i elektroteknikk og informatikk ved MIT, tilknyttet CSAIL og hovedforfatter av artikkelen, sier: "Vi har avdekket et fascinerende aspekt ved store språkmodeller: De utmerker seg i kjente scenarier, nesten som en velbrukt sti, men sliter når terrenget blir ukjent. Denne innsikten er avgjørende når vi jobber for å forbedre modellenes tilpasningsevne og utvide bruksområdene deres."

Vi så en lignende demonstrasjon av denne manglende evnen til å generalisere da vi undersøkte hvor dårlige AI-modeller er til å løse et forenklet puslespill for å krysse en elv.

Forskerne konkluderte med at når utviklere analyserer modellene sine, bør de "betrakte abstrakt oppgaveevne som løsrevet fra observert oppgaveutførelse".

"Tren-for-å-teste"-tilnærmingen kan få en modell til å klatre i benchmarks, men gir ikke et reelt mål på hvordan modellen vil klare seg når den blir presentert for en ny oppgave å resonnere seg gjennom.

Forskerne antyder at en del av problemet er at disse modellene kun er trent på overflatetekst.

Hvis LLM-er blir eksponert for mer kontekstualiserte data og semantiske representasjoner fra den virkelige verden, vil de kanskje være i stand til å generalisere når de blir presentert for oppgavevariasjoner.