Google-forskere har utviklet en teknikk kalt Infini-attention, som gjør det mulig for LLM-er å håndtere uendelig lange tekster uten å øke kravene til databehandling og minne.

Transformatorarkitekturen i en LLM gjør at den kan ta hensyn til alle symbolene i en ledetekst. De komplekse prikkprodukt- og matrisemultiplikasjonene den utfører, er kvadratiske i kompleksitet.

Det betyr at en dobling av antall tokens i ledeteksten krever fire ganger så mye minne og prosessorkraft. Dette er grunnen til at det er så utfordrende å lage LLM-er med store kontekstvinduer uten at minne- og datakravene skyter i været.

I en "standard" LLM går informasjonen i begynnelsen av ledeteksten tapt når ledeteksten blir større enn kontekstvinduet. Googles forskningsoppgave forklarer hvordan Infini-attention kan lagre data utenfor kontekstvinduet.

Google presenterer Leave No Context Behind: Effektive uendelige konteksttransformatorer med uendelig oppmerksomhet

1B-modellen som ble finjustert på opptil 5K sekvenslengder, løser problemet med 1M lengdehttps://t.co/zyHMt3inhi pic.twitter.com/ySYEMET9Ef

- Aran Komatsuzaki (@arankomatsuzaki) 11. april 2024

Hvordan fungerer Infini-attention?

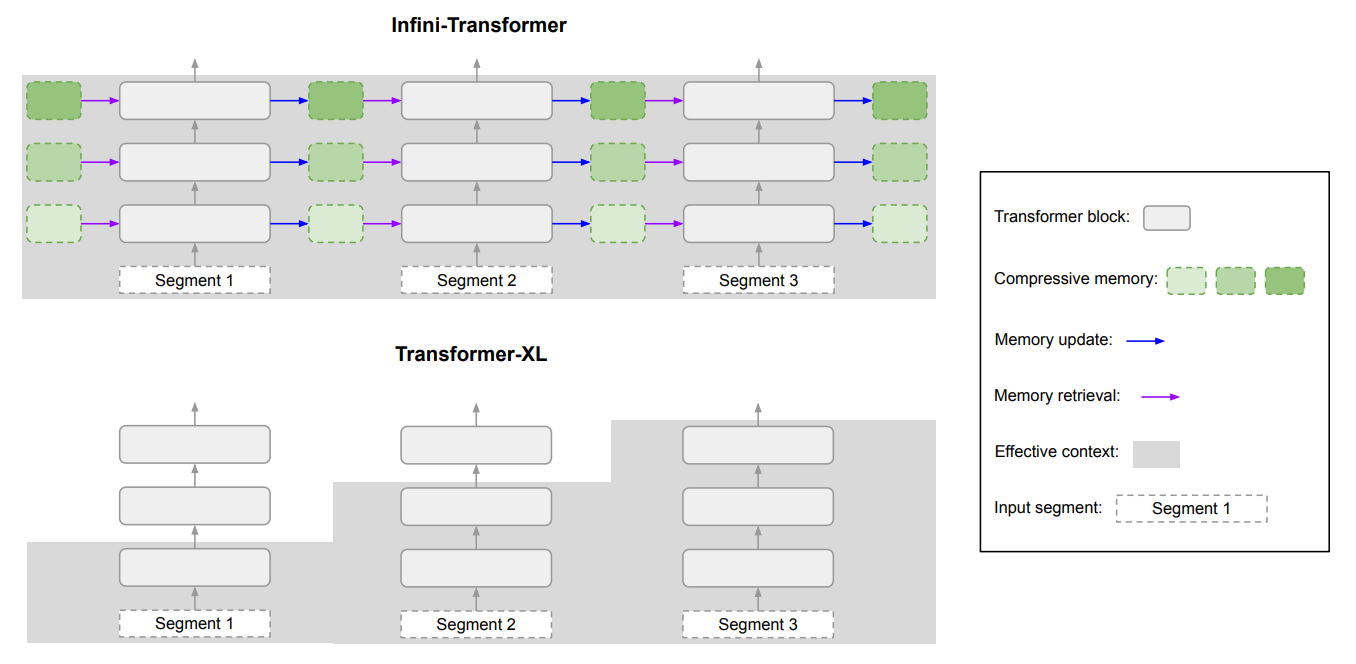

Infini-attention kombinerer komprimerende hukommelsesteknikker med modifiserte oppmerksomhetsmekanismer, slik at relevant, eldre informasjon ikke går tapt.

Når inndataprompten vokser utover modellens kontekstlengde, lagrer det komprimerende minnet informasjonen i et komprimert format i stedet for å forkaste den.

Dette gjør det mulig å lagre eldre, mindre umiddelbart relevant informasjon uten at minne- og databehandlingsbehovet vokser i det uendelige i takt med at inndataene vokser.

I stedet for å forsøke å ta vare på all den eldre inndata-informasjonen, veier Infini-attentions komprimerende minne og sammenfatter informasjon som anses som relevant og verdt å ta vare på.

Infini-attention tar utgangspunkt i en "vanilje"-oppmerksomhetsmekanisme, men gjenbruker nøkkelverdiene (KV) fra hvert påfølgende segment i modellen i stedet for å forkaste dem.

Her er et diagram som viser forskjellen mellom Infini-attention og en annen modell med utvidet kontekst, Transformer XL.

Resultatet er en LLM som gir lokal oppmerksomhet til nylige inndata, men som også har kontinuerlig destillerte, komprimerte historiske data som den kan bruke langsiktig oppmerksomhet på.

I artikkelen heter det: "Denne subtile, men kritiske modifikasjonen av oppmerksomhetslaget gjør det mulig for LLM-er å behandle uendelig lange kontekster med begrensede minne- og beregningsressurser."

Hvor god er den?

Google kjørte benchmarking-tester med mindre 1B- og 8B-parameter Infini-attention-modeller. Disse ble sammenlignet med andre utvidede kontekstmodeller som Transformer-XL og Memorizing Transformers.

Infini-Transformer oppnådde betydelig lavere perplexity-score enn de andre modellene ved behandling av innhold med lang kontekst. En lavere forvirringspoengsum betyr at modellen er sikrere på sine prediksjoner.

I "passkey retrieval"-testene fant Infini-attention-modellene konsekvent det tilfeldige tallet som var skjult i tekst med opptil 1 million tokens.

Andre modeller klarer ofte å finne passordet mot slutten av inndataene, men sliter med å finne det midt i eller i begynnelsen av et langt innhold. Infini-attention hadde ingen problemer med denne testen.

Benchmarking-testene er svært tekniske, men den korte historien er at Infini-attention utkonkurrerte basismodellene når det gjaldt å oppsummere og håndtere lange sekvenser, samtidig som konteksten ble opprettholdt over lengre perioder.

Det er bemerkelsesverdig at den beholdt denne overlegne lagringsevnen samtidig som den krevde 114 ganger mindre minne.

Benchmark-resultatene overbeviser forskerne om at Infini-attention kan skaleres til å håndtere ekstremt lange inndatasekvenser, samtidig som minne- og databehandlingsressursene er begrenset.

Infini-attentions plug-and-play-egenskaper betyr at den kan brukes til kontinuerlig forhåndstrening og finjustering av eksisterende Transformer-modeller. Dette kan effektivt utvide kontekstvinduene uten å kreve fullstendig omskolering av modellen.

Kontekstvinduene vil fortsette å vokse, men denne tilnærmingen viser at et effektivt minne kan være en bedre løsning enn et stort bibliotek.