Forskere har publisert en studie som sammenligner nøyaktigheten og kvaliteten på sammendragene som LLM-er produserer. Claude 3 Opus gjorde det spesielt bra, men mennesker har fortsatt en fordel.

AI-modeller er ekstremt nyttige for å oppsummere lange dokumenter når du ikke har tid eller lyst til å lese dem.

Luksusen med stadig større kontekstvinduer betyr at vi kan spørre modellene med lengre dokumenter, noe som utfordrer deres evne til alltid å få med seg fakta i sammendraget.

Forskerne fra University of Massachusetts Amherst, Adobe, Allen Institute for AI og Princeton University, publisert en studie som hadde som mål å finne ut hvor gode AI-modeller er til å oppsummere innhold av boklengde (>100 000 tokens).

FABLER

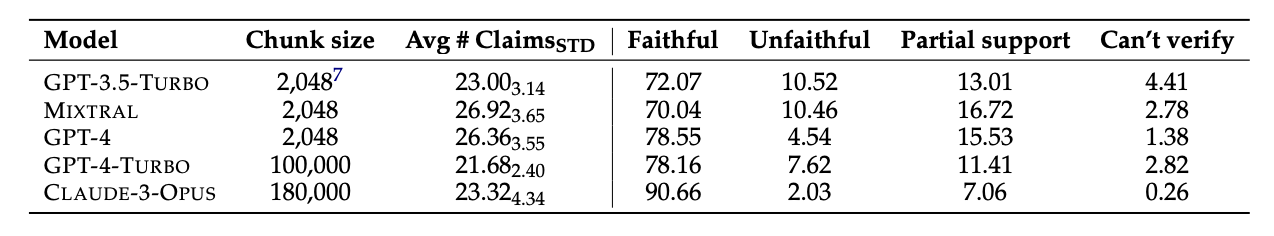

De valgte ut 26 bøker som ble utgitt i 2023 og 2024, og fikk ulike LLM-er til å oppsummere tekstene. De nylige utgivelsesdatoene ble valgt for å unngå potensiell dataforurensning i modellenes opprinnelige treningsdata.

Når modellene hadde produsert sammendragene, brukte de GPT-4 til å trekke ut dekontekstualiserte påstander fra dem. Forskerne hyret deretter inn menneskelige kommentatorer som hadde lest bøkene, og ba dem om å faktasjekke påstandene.

De resulterende dataene ble samlet i et datasett kalt "Faithfulness Annotations for Book-Length Summarization" (FABLES). FABLES inneholder 3158 annoteringer av trofasthet på påstandsnivå i 26 narrative tekster.

Testresultatene viste at Claude 3 Opus var "det mest trofaste boklange sammendraget med en betydelig margin", med over 90% av påstandene verifisert som trofaste eller nøyaktige.

GPT-4 kom på en god andreplass, med bare 78% av påstandene verifisert som troverdige av de menneskelige kommentatorene.

Den vanskelige delen

Modellene som ble testet, så alle ut til å slite med de samme tingene. De fleste faktaene som modellene tok feil, var knyttet til hendelser eller tilstander hos karakterer og relasjoner.

I artikkelen bemerkes det at "de fleste av disse påstandene bare kan avkreftes ved hjelp av resonnementer over bevisene, noe som understreker oppgavens kompleksitet og forskjellen fra eksisterende innstillinger for faktaverifisering".

LLM-ene utelot også ofte kritisk informasjon i sammendragene sine. De legger også for stor vekt på innhold mot slutten av bøkene, og går glipp av viktig innhold nærmere begynnelsen.

Vil kunstig intelligens erstatte menneskelige kommentatorer?

Menneskelige kommentatorer eller faktasjekkere er dyre. Forskerne brukte $5 200 på å få de menneskelige kommentatorene til å verifisere påstandene i AI-sammendragene.

Kunne en AI-modell ha gjort jobben billigere? Enkelt innhenting av fakta er noe Claude 3 er god til, men når det gjelder å verifisere påstander som krever en dypere forståelse av innholdet, er den mindre konsekvent.

Når de ble presentert med de ekstraherte påstandene og bedt om å verifisere dem, var alle AI-modellene dårligere enn de menneskelige kommentatorene. De var spesielt dårlige til å identifisere utro påstander.

Selv om Claude 3 Opus var den beste påstandskontrolløren med en viss avstand, konkluderte forskerne med at den "til syvende og sist presterer for dårlig til å være en pålitelig automatisk skårer".

Når det gjelder å forstå nyansene, de komplekse menneskelige relasjonene, plottpunktene og karakterenes motivasjon i en lang fortelling, ser det ut til at menneskene fortsatt har et forsprang.