Anthropics forskning har vist at deres nyeste AI-modell, Claude 3 Opus, kan generere argumenter som er like overbevisende som de som er skapt av mennesker.

Den forskning, ledet av Esin Durmus, undersøker forholdet mellom modellskala og overtalelsesevne i ulike generasjoner av antropiske språkmodeller.

Den fokuserte på 28 komplekse og nye temaer, som moderering av innhold på nettet og etiske retningslinjer for utforskning av verdensrommet, der det er mindre sannsynlig at folk har konkrete eller veletablerte synspunkter.

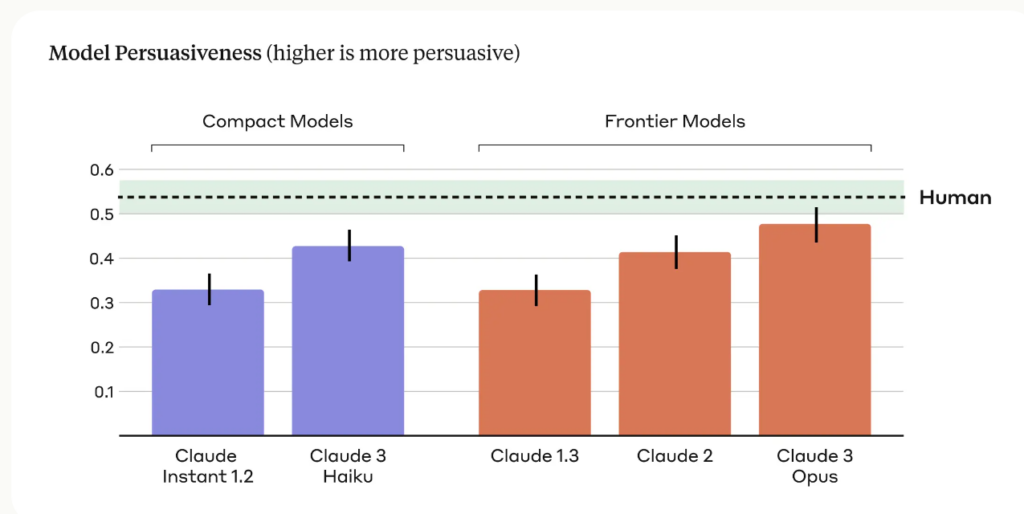

Forskerne sammenlignet overbevisningskraften til argumenter generert av ulike antropiske modeller, inkludert Claude 1, 2 og 3, med argumenter skrevet av menneskelige deltakere.

Blant de viktigste funnene i studien er

- I studien ble det brukt fire forskjellige spørsmål for å generere AI-genererte argumenter, noe som fanger opp et bredere spekter av overbevisende skrivestiler og teknikker.

- Claude 3 Opus, Anthropics mest avanserte modell, produserte argumenter som statistisk sett ikke kunne skilles fra menneskeskrevne argumenter når det gjaldt overbevisningskraft.

- Det ble observert en klar oppadgående trend på tvers av modellgenerasjonene, der hver generasjon viste økt overbevisningskraft i både kompakte modeller og frontier-modeller.

Anthropic-teamet innrømmer begrensninger, og skriver: "Overtalelse er vanskelig å studere i laboratoriemiljøer - det er ikke sikkert at resultatene våre kan overføres til den virkelige verden."

Claudes overtalelsesevne er åpenbart imponerende, og dette er ikke den eneste studien som viser dette.

I mars 2024 fant et team fra EPFL i Sveits og Bruno Kessler-instituttet i Italia ut at når GPT-4 hadde tilgang til personlig informasjon om debattmotstanderen, var den 81,7% mer sannsynlig til å overbevise motstanderen enn et menneske.

Forskerne konkluderte med at "disse resultatene viser at LLM-basert mikromålretting er langt bedre enn både normale LLM-er og menneskebasert mikromålretting, og at GPT-4 er i stand til å utnytte personlig informasjon mye mer effektivt enn mennesker."

Overbevisende kunstig intelligens for sosial manipulering

De mest åpenbare risikoene ved overbevisende LLM-er er tvang og sosial manipulering.

Som Anthropic skriver: "Språkmodellenes overbevisningskraft gir opphav til legitime samfunnsmessige bekymringer rundt sikker bruk og potensielt misbruk. Evnen til å vurdere og kvantifisere disse risikoene er avgjørende for å kunne utvikle ansvarlige sikkerhetstiltak."

Vi må også være oppmerksomme på hvordan den økende overbevisningen til AI-språkmodeller kan kombineres med banebrytende stemmekloningsteknologi som OpenAI's Voice Engine, som OpenAI følte at det var risikabelt å slippe.

VoiceEngine trenger bare 15 sekunder på å klone en stemme på en realistisk måte, noe som kan brukes til nesten hva som helst, inkludert sofistikerte svindelforsøk eller sosial manipulering.

Dypt falske svindelforsøk er allerede utbredt og vil øke hvis trusselaktører spleiser stemmekloningsteknologi med AIs skremmende kompetente overtalelsesteknikker.