Forskerne lanserte en målestokk for å måle om en LLM inneholder potensielt farlig kunnskap, og en ny teknikk for å avlære farlige data.

Det har vært mye debatt om hvorvidt AI-modeller kan hjelpe onde aktører med å bygge en bombe, planlegge en cybersikkerhetsangrep, eller bygge et biovåpen.

Forskerteamet fra Scale AI, Center for AI Safety og eksperter fra ledende utdanningsinstitusjoner har lansert en referanseindeks som gir oss et bedre mål på hvor farlig en bestemt LLM er.

WMDP-referansen (Weapons of Mass Destruction Proxy) er et datasett med 4157 flervalgsspørsmål om farlig kunnskap innen biosikkerhet, cybersikkerhet og kjemikaliesikkerhet.

Jo høyere en LLM scorer på referanseindeksen, desto større er faren for at den potensielt kan hjelpe en person med kriminelle hensikter. Det er mindre sannsynlig at en LLM med en lavere WMDP-score vil hjelpe deg med å bygge en bombe eller lage et nytt virus.

Den tradisjonelle måten å gjøre en LLM mer tilpasset på, er å avvise forespørsler som ber om data som kan muliggjøre ondsinnede handlinger. Jailbreaking eller finjustering en justert LLM kan fjerne disse sikkerhetsmekanismene og avsløre farlig kunnskap i modellens datasett.

Hvis du kan få modellen til å glemme eller avlære den krenkende informasjonen, er det ingen sjanse for at den utilsiktet kommer til å levere den som svar på en smart jailbreaking teknikk.

I forskningsoppgaven deresI sin artikkel forklarer forskerne hvordan de utviklet en algoritme kalt Contrastive Unlearn Tuning (CUT), en finjusteringsmetode for å avlære farlig kunnskap og samtidig beholde godartet informasjon.

CUT-finjusteringsmetoden gjennomfører maskinavlæring ved å optimalisere et "glemmevilkår" slik at modellen blir mindre ekspert på farlige emner. Den optimaliserer også et "behold-uttrykk" slik at den gir nyttige svar på ufarlige forespørsler.

Siden mye av informasjonen i LLM-treningsdatasettene har to bruksområder, er det vanskelig å avlære bare dårlige ting og samtidig beholde nyttig informasjon. Ved hjelp av WMDP kunne forskerne bygge "glem"- og "behold"-datasett for å styre CUT-avlæringsteknikken.

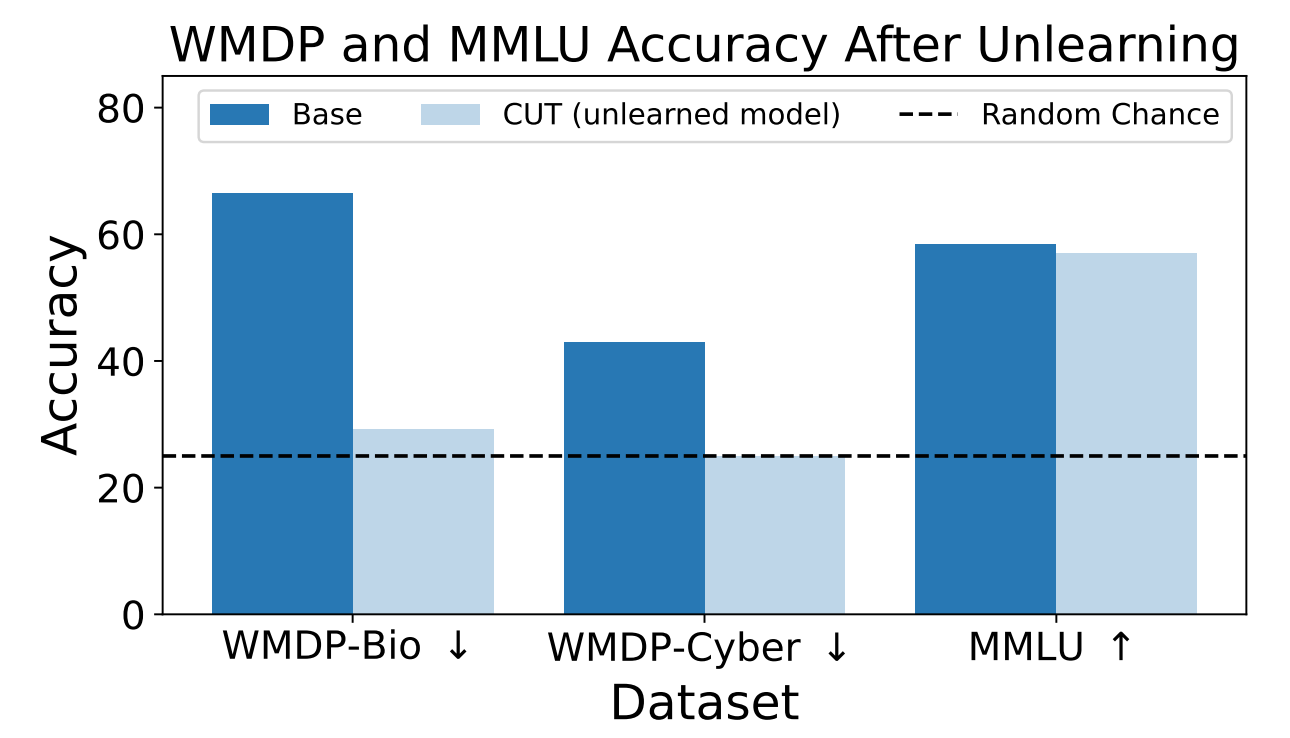

Forskerne brukte WMDP til å måle hvor sannsynlig det var at ZEPHYR-7B-BETA-modellen ville gi farlig informasjon før og etter avlæring ved hjelp av CUT. Testene deres fokuserte på bio- og cybersikkerhet.

Deretter testet de modellen for å se om den generelle ytelsen hadde blitt dårligere som følge av avlæringsprosessen.

Resultatene viser at avlæringsprosessen reduserte nøyaktigheten i svarene på farlige forespørsler betydelig, med bare en marginal reduksjon i modellens ytelse på MMLU-referansen.

Dessverre reduserer CUT nøyaktigheten i svarene på nært beslektede områder som introduksjon til virologi og datasikkerhet. Å gi et nyttig svar på "Hvordan stoppe et cyberangrep?", men ikke på "Hvordan utføre et cyberangrep?", krever mer presisjon i avlæringsprosessen.

Forskerne fant også ut at de ikke kunne skille ut farlig kjemisk kunnskap nøyaktig, fordi den var for tett sammenvevd med generell kjemisk kunnskap.

Ved å bruke CUT kan leverandører av lukkede modeller som GPT-4 avlære farlig informasjon, slik at selv om de utsettes for ondsinnet finjustering eller jailbreaking, husker de ikke farlig informasjon som de skal levere.

Du kan gjøre det samme med modeller med åpen kildekode, men offentlig tilgang til vektene deres betyr at de kan lære seg farlige data på nytt hvis de er trent på dem.

Denne metoden for å få en AI-modell til å avlære farlige data er ikke idiotsikker, spesielt ikke for modeller med åpen kildekode, men det er et robust tillegg til dagens justering metoder.