Den amerikanske hæren prøver seg på å integrere AI-chatboter i sin strategiske planlegging, om enn innenfor rammene av en krigsspillsimulering basert på det populære videospillet Starcraft II.

Dette studie, ledet av US Army Research Laboratory, analyserer OpenAIs GPT-4 Turbo- og GPT-4 Vision-strategier på slagmarken.

Dette er en del av OpenAIs samarbeid med Forsvarsdepartementet (DOD) etter etableringen av arbeidsgruppe for generativ AI i fjor.

Bruken av kunstig intelligens på slagmarken er heftig debattert, med en nylig lignende studie om AI-krigsspill at LLM-er som GPT-3.5 og GPT-4 har en tendens til å eskalere diplomatiske taktikker, noe som noen ganger kan føre til atomkrig.

Denne nye forskningen fra den amerikanske hæren brukte Starcraft II til å simulere et slagmarksscenario som involverte et begrenset antall militære enheter.

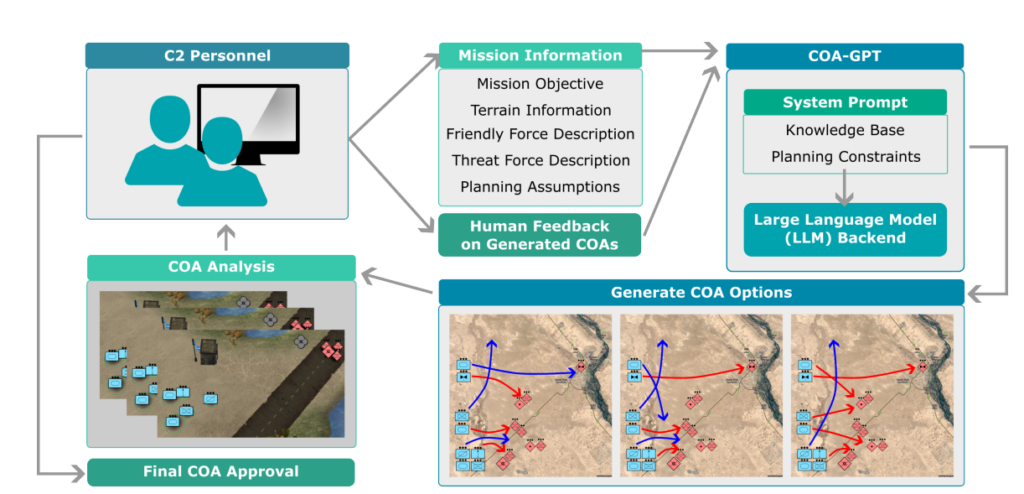

Forskerne kalte dette systemet "COA-GPT" - der COA står for det militære begrepet "Courses of Action", som i hovedsak beskriver militær taktikk.

COA-GPT inntok rollen som den militære sjefens assistent, med oppgave å utarbeide strategier for å utslette fiendens styrker og erobre strategiske punkter.

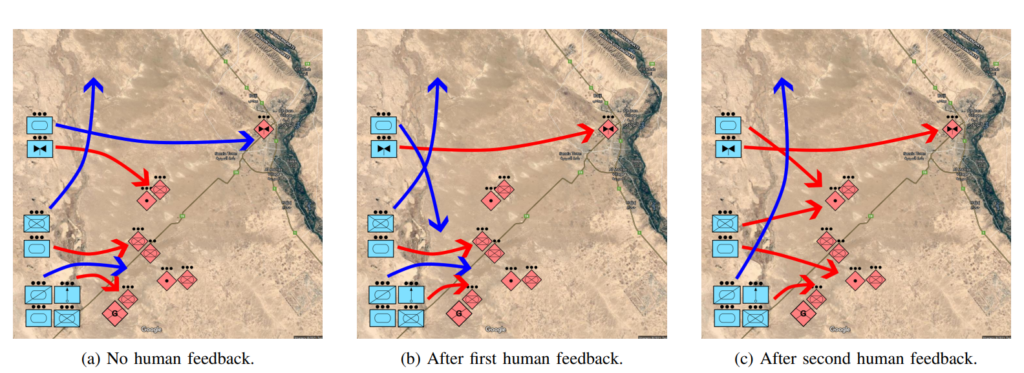

Forskerne påpeker at tradisjonell COA er notorisk treg og arbeidskrevende. COA-GPT tar beslutninger på få sekunder, samtidig som menneskelig tilbakemelding integreres i AI-ens læringsprosess.

COA-GPT er bedre enn andre metoder, men det koster

COA-GPT viste seg å være bedre enn eksisterende metoder når det gjaldt å generere strategiske COA-er, og kunne tilpasse seg tilbakemeldinger i sanntid.

Det var imidlertid mangler. COA-GPT hadde særlig høyere tap i forbindelse med å oppnå oppdragets mål.

I studien heter det: "Vi observerer at COA-GPT og COA-GPT-V, selv når de er forbedret med menneskelig tilbakemelding, viser høyere tap av egne styrker sammenlignet med andre baselines."

Avskrekker dette forskerne? Tilsynelatende ikke.

Studien konkluderer med at "COA-GPT representerer en transformativ tilnærming til militære C2-operasjoner, som legger til rette for raskere og smidigere beslutningstaking og opprettholder et strategisk forsprang i moderne krigføring".

Det er bekymringsfullt at et AI-system som forårsaket flere unødvendige dødsfall enn grunnlinjen, defineres som en "transformativ tilnærming".

Forsvarsdepartementet har allerede identifisert andre muligheter for å utforske AIs militære bruksområder, men det er fortsatt bekymring knyttet til teknologiens beredskap og etiske implikasjoner.

Hvem er for eksempel ansvarlig når militære AI-applikasjoner går galt? Utviklerne? Den ansvarlige personen? Eller noen lenger ned i kjeden?

AI-krigføringssystemer er allerede tatt i bruk i konfliktene i Ukraina og Palestina-Israel, men disse spørsmålene er i stor grad uprøvd.

La oss håpe at det forblir slik.