IBM Security publiserte forskning på Security Intelligence-bloggen sin for å vise hvordan AI-stemmekloner kan injiseres i en live-samtale uten at deltakerne er klar over det.

Etter hvert som teknologien for stemmekloning har blitt bedre, har vi sett falske robocalls som utgir seg for å være Joe Biden, og svindelanrop som utgir seg for å være et nødlidende familiemedlem som ber om penger.

Lyden i disse samtalene høres bra ut, men svindelsamtalen kan ofte enkelt avverges ved å stille noen få personlige spørsmål for å identifisere innringeren som en bedrager.

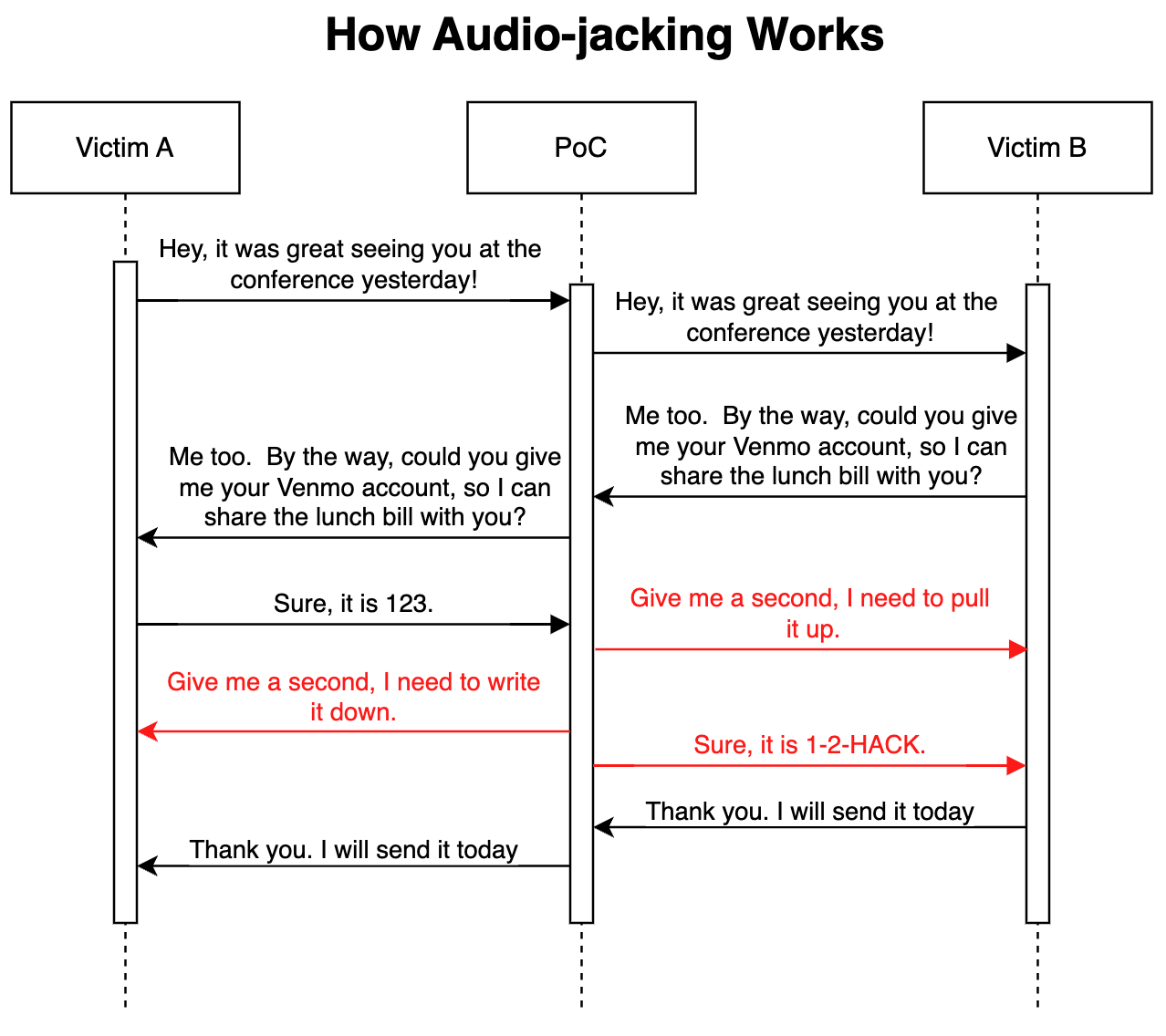

I sitt avanserte "proof of concept"-angrep har IBMs sikkerhetsforskere viste at en LLM kombinert med stemmekloning kunne fungere som en man-in-the-middle for å kapre bare en viktig del av en samtale, i stedet for hele samtalen.

Slik fungerer det

Angrepet kan leveres via skadelig programvare installert på ofrenes telefoner eller en ondsinnet kompromittert Voice over IP-tjeneste (VoIP). Når programmet er på plass, overvåker det samtalen og trenger bare tre sekunder med lyd for å kunne klone begge stemmene.

En tale-til-tekst-generator gjør det mulig for LLM å overvåke samtalen for å forstå konteksten i diskusjonen. Programmet fikk beskjed om å videresende samtalelyden slik den var, men å endre samtalelyden når en person ba om bankkontoopplysninger.

Når personen svarer for å oppgi bankkontoopplysningene sine, endrer stemmeklonen lyden slik at den i stedet inneholder svindlerens bankopplysninger. Forsinkelsen i lyden under modifikasjonen dekkes med litt fylltale.

Her er en illustrasjon av hvordan Proof of Concept-angrepet (PoC) fungerer.

Fordi LLM-enheten videresender umodifisert lyd under mesteparten av samtalen, er det veldig vanskelig å vite at trusselen er i spill.

Forskerne sa at det samme angrepet "også kan endre medisinsk informasjon, som blodtype og allergier i samtaler; det kan beordre en analytiker til å selge eller kjøpe en aksje; det kan instruere en pilot til å legge om ruten."

Forskerne sa at "det var overraskende og skremmende enkelt å bygge denne PoC-en". Etter hvert som intonasjonen og følelsene til stemmeklonene blir bedre og bedre maskinvare reduserer latenstiden, vil denne typen angrep bli veldig vanskelig å oppdage eller forhindre.

Forskerne utvidet konseptet til å omfatte mer enn å kapre en lydsamtale, og sa at med "eksisterende modeller som kan konvertere tekst til video, er det teoretisk mulig å avskjære en direktestrømmet video, for eksempel nyheter på TV, og erstatte det opprinnelige innholdet med et manipulert innhold".

Det kan være tryggere å bare tro på det du ser og hører når du fysisk er i nærheten av personen du snakker med.