Hvis du trenger nye ideer, kan AI-modeller som GPT-4 ofte komme opp med noen gode ideer som du kan legge til på listen din. Problemet er bare at den lange listen med ideer som genereres, ofte inneholder svært like ideer, og ikke den utradisjonelle tenkningen du er ute etter.

Forskere fra Wharton School, University of Pennsylvania, ville se om det fantes en måte å få en AI-modell som GPT-4 til å levere mer varierte, eller nye, ideer i løpet av idégenereringsprosessen.

Forfatterne av artikkelen, Lennart Meincke, Ethan Mollick og Christian Terwiesch, startet med en hypotese om at GPT-4 hadde potensial til å være mer kreativ, og at smart veiledning kunne frigjøre denne kreativiteten.

Eksperimentet

Teamet utformet en øvelse der målet var å komme opp med ideer til et nytt forbrukerprodukt rettet mot studenter som koster $50 eller mindre.

De brukte ulike spørrestrategier for å se hvilke ideer GPT-4 kunne komme opp med, og målte deretter mangfoldet i ideene. Deretter sammenlignet de mangfoldet i de AI-genererte ideene med ideene som team av MBA-studenter kom opp med.

Oppfordringsstrategiene de brukte, var

- Minimal veiledning

- Be GPT-4 om å innta ulike roller

- Del ideer til kreativ tenkning fra eksisterende litteratur med GPT-4

- Bruk Chain of Thought (CoT) og instruer LLM til å arbeide i flere forskjellige trinn

🚨 Vår nye artikkel: Vi vet at GPT-4 genererer bedre ideer enn folk flest, men ideene er ganske like og variansen har betydning

Men det viser seg at bedre veiledning kan generere puljer av gode ideer som er nesten like mangfoldige som fra en gruppe mennesker https://t.co/LkGsU0VC7S pic.twitter.com/5BDx8A3E8Z

- Ethan Mollick (@emollick) 27. januar 2024

Resultater

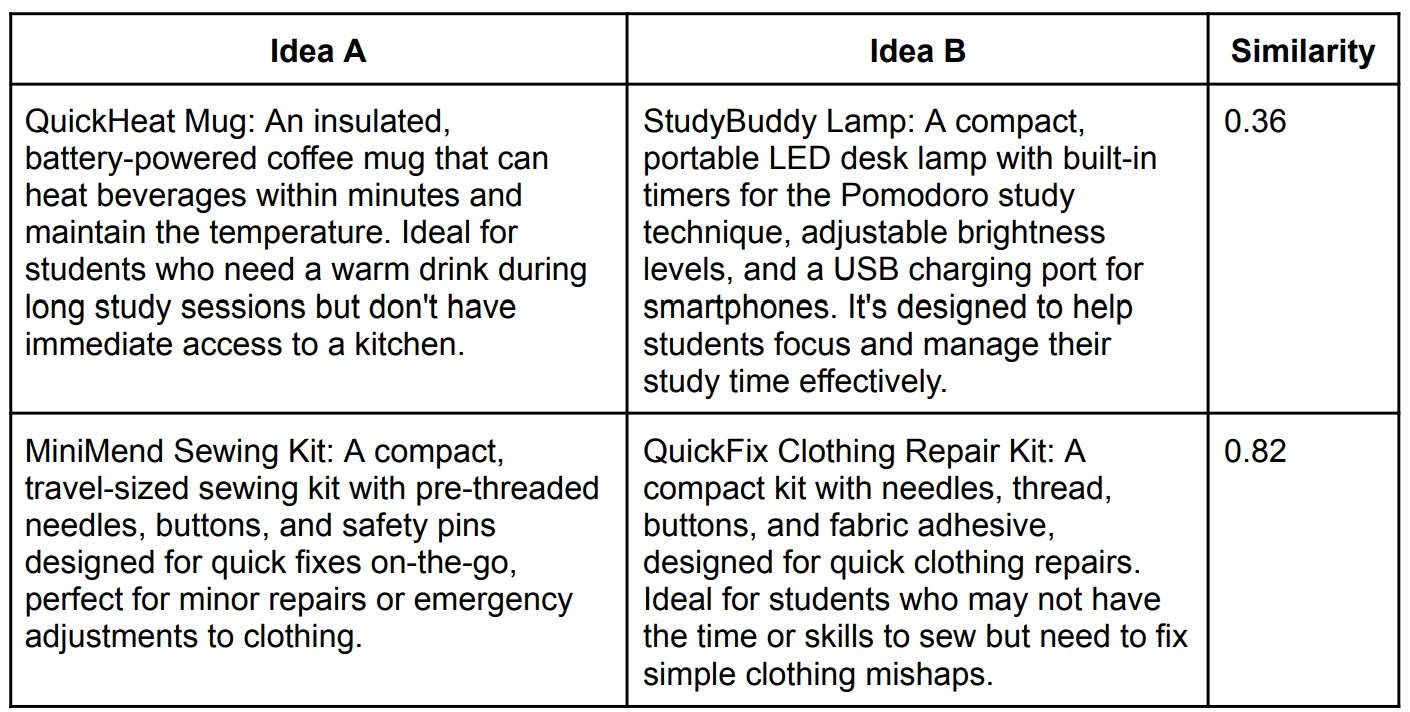

Mangfoldet av ideer ble målt ved hjelp av Cosine-likhetsmetoden. Denne metrikken brukes ofte i tekstanalyse for å måle hvor like elementene i lister er når det gjelder ideene deres. Et mål på 1 betyr at ideene er svært like, og at mangfoldet i de sammenlignede ideene øker når verdien går mot null.

I artikkelen ble det bemerket at "idépooler generert av GPT-4 uten noen spesiell oppfordring er mindre mangfoldige enn ideer generert av grupper av mennesker". Gruppene av mennesker hadde en Cosine-likhet på 0,243 sammenlignet med en rekkevidde på 0,255 til 0,432 for GPT-4-genererte ideer, avhengig av hva som ble bedt om.

Her er et eksempel på sammenligning av ideer.

Dette bekrefter at selv om GPT-4 kommer opp med noen veldig gode ideer, ender mange av dem opp med å være varianter av den samme ideen. En seier for Team Human. Antall gode ideer og hvor raskt idébanken ble tømt, ble også målt.

Forskerne fant ut at bruk av lengre spørsmål resulterte i et større mangfold i ideene GPT-4 leverte. Den beste strategien var å bruke CoT, som kom på en god andreplass etter menneskene med en Cosine-likhet på 0,255.

Å be GPT-4 om å anta personas hadde blandede resultater med liten forutsigbarhet. Å be LLM-en om å opptre som "Steve Jobs" (0,368) ga mer varierte ideer enn en variant med "Elon Musk" (0,385). Å be den om å opptre som en "kreativ gründer" ga en cosinuslikhet på 0,348.

Interessant nok var det lite overlapping mellom ideene fra de ulike oppgavene da de ble sammenlignet.

I en tweet sa Ethan Mollick: "Jeg bør nevne at jeg ikke tror vi oppdaget (eller til og med prøvde å oppdage) noen form for fantastisk prompting-teknikk. Vi argumenterer for at de viktigste antatte grensene for AI-ideasjon - den genererer mindre forskjellige ideer enn en gruppe mennesker og har færre ideer totalt sett - ikke trenger å være sanne."

Så hvis du ønsker å bruke GPT-4 i din neste idédugnad, er det et par ting du kan gjøre for å få den til å være mer kreativ. Bruk lengre spørsmål, legg inn noen CoT-instruksjoner, be den om å anta noen personas, og kombiner deretter alle ideene fra de ulike spørsmålene til én enkelt liste.

Eller du kan ansette en gruppe MBA-studenter for å oppnå enda bedre resultater.