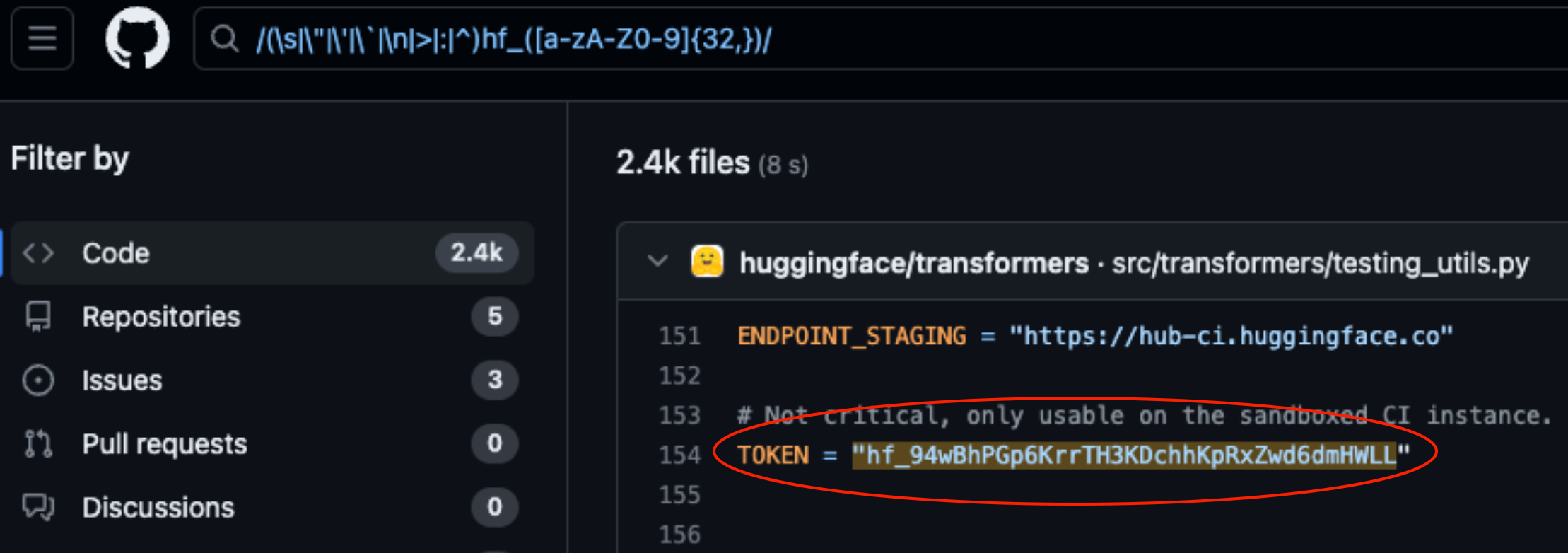

Lasso Security avdekket sikkerhetsproblemer på HuggingFace og GitHub etter å ha funnet 1681 eksponerte API-tokens som var hardkodet inn i kode lagret på plattformene.

HuggingFace og GitHub er to av de mest populære repositoriene der utviklere kan gi tilgang til sine AI-modeller og sin kode. Tenk på disse som mapper i skyen som administreres av organisasjonene som eier dem.

HuggingFace og GitHub gjør det enkelt for brukere å samhandle med hundretusener av AI-modeller og datasett via API-er. Det gjør det også mulig for organisasjoner som eier modellene og datasettene, å bruke API-tilgangen til å lese, opprette, endre og slette repositorier eller filer.

Tillatelsene som er knyttet til API-tokenet ditt, avgjør hvilket tilgangsnivå du har. Lasso funnet at de med litt graving kunne finne mange tokens i kode som var lagret i repositorier på plattformene.

Av de 1681 gyldige tokens de fant, hadde 655 brukeres tokens skrivetillatelser, hvorav 77 hadde fulle kontotillatelser.

Hvorfor er dette en stor sak?

Tenk på et API-token som en nøkkel til inngangsdøren din. Det kan være praktisk å legge nøkkelen under dørmatten, men hvis noen finner den, får de tilgang til huset ditt.

Når utviklere skriver en kode som skal samhandle med AI-modellen eller datasettet, hender det at de blir litt late. De kan hardkode tokens i koden i stedet for å bruke sikrere måter å håndtere dem på.

Noen av tokensene Lasso fant ga dem full lese- og skrivetillatelse til Metas Lama 2, BigScience Workshop og EleutherAI. Alle disse organisasjonene har AI-modeller som har blitt lastet ned millioner av ganger.

Hvis Lasso var skurkene, kunne de ha endret modellene eller datasettene i de eksponerte repositoriene. Tenk deg om noen la til litt snikende kode i Metas depot og deretter fikk millioner av mennesker til å laste den ned.

Da Meta, Google, Microsoft og andre fikk høre om de eksponerte API-tokens, trakk de dem raskt tilbake.

Tyveri av modeller, forgiftning av treningsdata og kombinasjon av tredjepartsdatasett og forhåndstrenede modeller er alle store risikoer for AI-selskaper. Utviklere som uten videre lar API-tokens ligge eksponert i koden, gjør det bare enklere for ondsinnede aktører å utnytte disse.

Man kan lure på om Lassos ingeniører var de første til å finne disse sårbarhetene.

Hvis nettkriminelle fant disse symbolene, ville de helt sikkert ha holdt det veldig stille mens de åpnet inngangsdøren.