Nvidia skalerte og optimaliserte Eos AI-superdatamaskinen for å sette nye rekorder for MLPerf AI-trening.

Da Nvidia slo på AI-superdatamaskinen Eos i mai, ble 10 752 NVIDIA H100 Tensor Core GPU-er vekket til live, og de har nettopp blitt testet i den virkelige verden.

Denne enestående prosessorkraften sammen med nye programvareoptimaliseringer har gjort det mulig for Eos å presse MLPerf målestokk inn i rekordterritorium.

MLPerf-referansen med åpen kildekode er et sett med trenings- og inferenstester som er utviklet for å måle ytelsen til maskinlæringsarbeidsbelastninger på virkelige datasett.

Et av de fremste resultatene var at Eos klarte å trene opp en GPT-3-modell med 175 milliarder parametere på én milliard tokens på bare 3,9 minutter.

Da Nvidia satte rekorden på denne målestokken for mindre enn 6 måneder siden, tok det nesten tre ganger så lang tid med en tid på 10,9 minutter.

Nvidia klarte også å oppnå en effektivitet på 93% under testene, noe som betyr at de brukte nesten all datakraften som teoretisk sett var tilgjengelig i Eos.

Microsoft Azure, som bruker omtrent det samme H100-oppsettet som Eos i sin virtuelle ND H100 v5-maskin, kom innenfor 2% av Nvidias testresultater i sine MLPerf-tester.

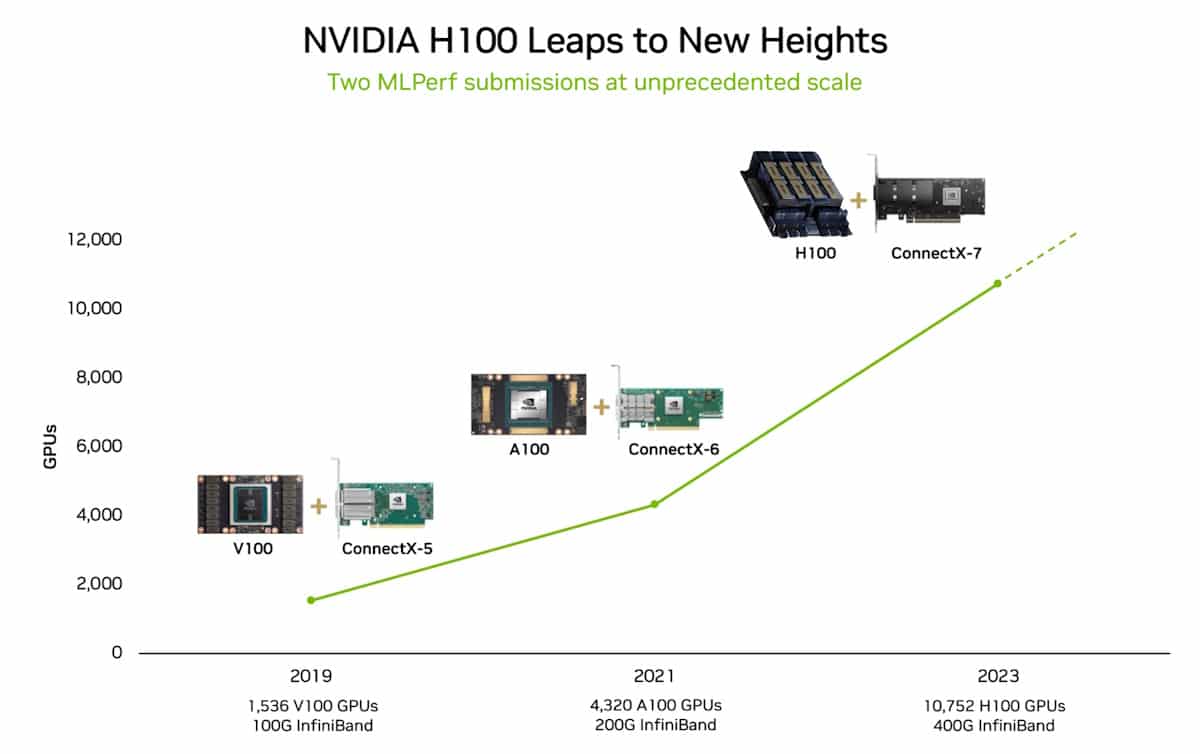

I 2018 sa Jensen Huang, administrerende direktør i Nvidia, at ytelsen til GPU-er vil mer enn dobles hvert annet år. Denne påstanden ble kalt Haungs lov, og den har vist seg å være sann, ettersom den etterlater Moores lov er i ferd med å forsvinne i databehandlingens bakspeil.

Hva så?

MLPerf-referansetreningstesten som Nvidia klarte, bruker bare en del av hele datasettet som GPT-3 ble trent på. Hvis du tar tiden Eos satte i MLPerf-testen og ekstrapolerer for hele GPT-3-datasettet, kan den trene hele modellen på bare 8 dager.

Hvis du hadde forsøkt å gjøre det samme med det tidligere toppmoderne systemet, som besto av 512 A100 GPU-er, ville det tatt rundt 170 dager.

Hvis du skulle lære opp en ny AI-modell, kan du tenke deg forskjellen i tid til markedet og kostnader som 8 dager versus 170 dager utgjør?

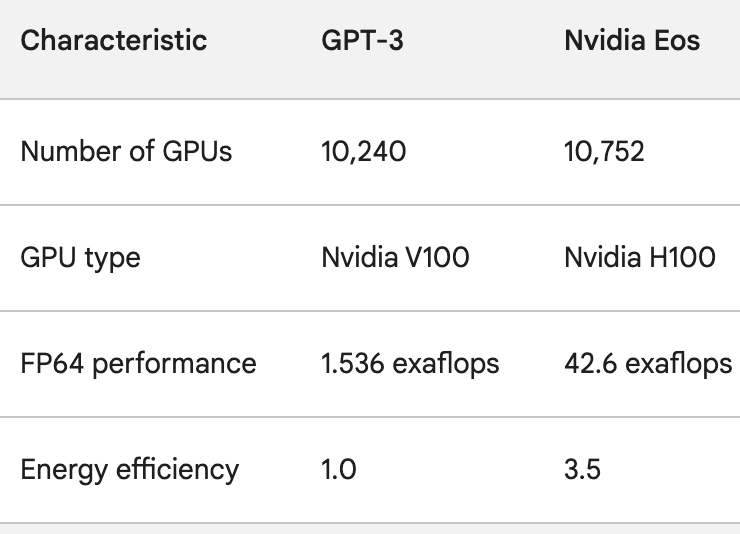

H100-GPU-ene er ikke bare mye kraftigere enn A100-GPU-ene, de er også opptil 3,5 ganger mer energieffektive. Energiforbruk og AIs karbonfotavtrykk er reelle problemer som må løses.

For å få et inntrykk av hvor raskt AI-prosesseringen blir bedre, kan du tenke på ChatGPT, som ble satt i drift for litt under ett år siden. Den underliggende modellen, GPT-3, ble trent opp på 10 240 Nvidia V100 GPU-er.

Mindre enn ett år senere har Eos 28 ganger så stor prosessorkraft som det oppsettet, med en 3,5 ganger så stor effektivitetsforbedring.

Da OpenAIs Sam Altman avsluttet den siste DevDay, sa han at prosjektene OpenAI jobbet med, ville få de siste utgivelsene til å se gammeldagse ut.

Med tanke på spranget i prosessorkraft som selskaper som Nvidia oppnår, oppsummerer Altmans påstand sannsynligvis fremtiden for AI-industrien som helhet.