Multimodale store språkmodeller (MLLM) som GPT-4V er veldig gode til å analysere og beskrive bilder, men noen ganger hallusinerer de og tar feil. En ny tilnærming kalt Woodpecker kan fikse det.

Hvis du ber en MLLM om å beskrive et bilde, kan den normalt plukke ut gjenstandene og gi en nøyaktig beskrivelse av motivet. Men i likhet med svar på tekstmeldinger gjør modellen noen ganger antakelser basert på gjenstander eller begreper som ofte opptrer sammen.

Resultatet er at en MLLM kan beskrive et bilde av en butikkfront og si at det er mennesker i bildet, selv om det faktisk ikke er noen.

Det er et kontinuerlig arbeid å fikse hallusinasjoner i tekstbaserte LLM-er, men det blir mye enklere når modellen er koblet til Internett. LLM-en kan generere et tekstsvar på en ledetekst, sjekke om det er sant basert på relevante internettdata, og korrigere seg selv der det er nødvendig.

Forskere fra Tencents YouTu Lab og University of Science and Technology of China tok denne tilnærmingen og omsatte den til en visuell løsning kalt Woodpecker.

Enkelt sagt bygger Woodpecker opp en mengde kunnskap fra bildet, og deretter kan en LLM bruke den som referanse for å korrigere den opprinnelige beskrivelsen som er generert av MLLM.

Her er en kort beskrivelse av hvordan det fungerer:

- En LLM som GPT-3.5 Turbo analyserer beskrivelsen som genereres av MLLM, og trekker ut nøkkelbegreper som objekter, mengder og attributter. I setningen "Mannen har på seg en svart hatt" blir for eksempel objektene "mann" og "hatt" trukket ut.

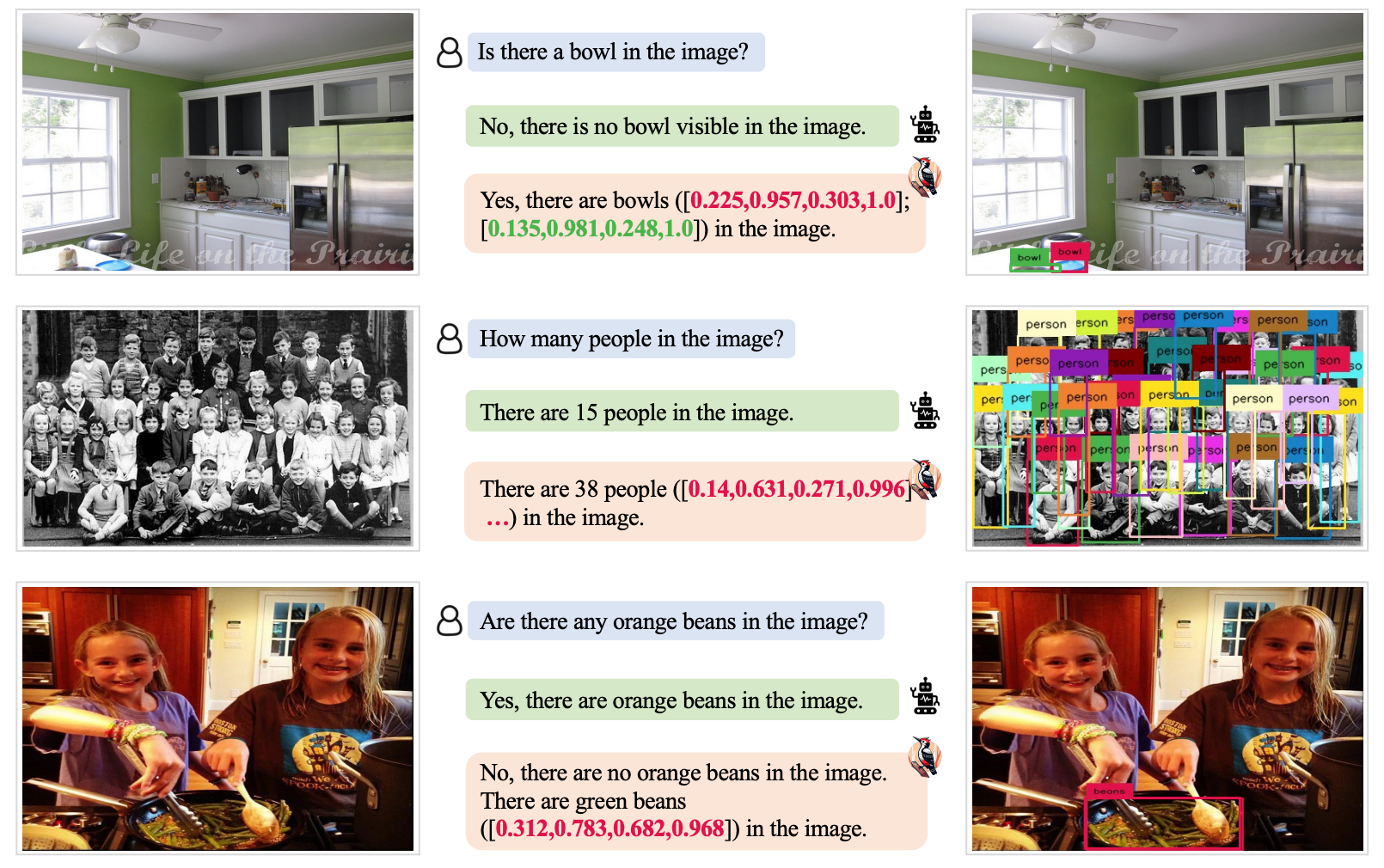

- En LLM blir deretter bedt om å generere spørsmål knyttet til disse begrepene, for eksempel "Er det en mann på bildet?" eller "Hva har mannen på seg?".

- Disse spørsmålene mates inn som spørsmål til en VQA-modell (Visual Question Answering). Grounding DINO utfører objektdeteksjon og telling, mens BLIP-2-FlanT5 VQA besvarer attributtrelaterte spørsmål etter å ha analysert bildet.

- En LLM kombinerer svarene på spørsmålene til en visuell kunnskapsbase for bildet.

- En LLM bruker denne referansekunnskapen til å korrigere eventuelle hallusinasjoner i den opprinnelige MLLM-beskrivelsen, og legger til detaljer den har oversett.

Forskerne kalte metoden Woodpecker (hakkespett) med referanse til hvordan fuglen plukker insekter ut av trærne.

Testresultatene viste at Woodpecker oppnådde en nøyaktighetsforbedring på 30,66% for MiniGPT4 og 24,33% for mPLUG-Owl-modellene.

De generiske modellene som kreves i denne tilnærmingen, gjør at Woodpecker-tilnærmingen enkelt kan integreres i ulike MLLM-er.

Hvis OpenAI integrerer Woodpecker i ChatGPT, kan vi få se en markant forbedring av den allerede imponerende visuelle ytelsen. En reduksjon i MLLM-hallusinasjon kan også forbedre automatisert beslutningstaking i systemer som bruker visuelle beskrivelser som inndata.