Anthropic, selskapet som har utviklet AI-chatboten Claude, presenterte nylig en unik idé: Hvorfor ikke la vanlige mennesker være med på å utforme reglene som styrer atferden til AI?

Anthropic engasjerte rundt 1000 amerikanere i eksperimentet sitt, og utforsket en metode som kan definere landskapet for fremtidig styring av kunstig intelligens.

Ved å gi publikum muligheten til å påvirke kunstig intelligens, kan vi bevege oss mot en bransje som på en rettferdig måte representerer folks synspunkter i stedet for å gjenspeile skapernes?

Selv om store språkmodeller (LLM-er) som ChatGPT og Claude lærer av opplæringsdataene sine, som styrer svarene, er det fortsatt mye subjektiv tolkning involvert, fra valg av hvilke data som skal inkluderes, til tekniske beskyttelsestiltak.

Demokratisering av AI-kontroll til offentligheten er et fristende perspektiv, men fungerer det?

Gapet mellom opinionen og AI-industrien

Utviklingen av AI-systemer har åpnet en kløft mellom teknologisjefenes visjoner og offentligheten.

Undersøkelser i år avslørte at allmennheten foretrekker et langsommere tempo i AI-utviklingen, og mange har mistillit til lederne i selskaper som Meta, OpenAI, Google, Microsoft osv.

Samtidig blir kunstig intelligens integrert i kritiske prosesser og beslutningssystemer på tvers av sektorer som helsevesen, utdanning og rettshåndhevelse. AI-modeller utviklet av noen få utvalgte er allerede i stand til å ta livsendrende beslutninger for massene.

Dette reiser et viktig spørsmål: Bør teknologiselskapene bestemme hvem som skal diktere retningslinjene som høytytende AI-systemer skal følge? Bør offentligheten ha noe å si? Og i så fall hvordan?

Noen mener at styringen av AI bør overlates direkte til myndigheter og politikere. Et annet forslag er å presse på for mer åpen kildekode for AI-modeller, slik at brukere og utviklere kan lage sine egne regelbøker - noe som allerede er i ferd med å skje.

Anthropics nye eksperiment presenterer et alternativ som legger styringen av AI i hendene på offentligheten, kalt "Collective Constitutional AI".

Dette følger av selskapets tidligere arbeid med konstitusjonell AIsom lærer opp LLM-er ved hjelp av en rekke prinsipper som sikrer at chatboten har klare retningslinjer for håndtering av ømtålige temaer, grensesetting og tilpasning til menneskelige verdier.

Claudes grunnlov henter inspirasjon fra globalt anerkjente dokumenter som FNs verdenserklæring om menneskerettigheter. Målet har alltid vært å sikre at Claudes produkter er både "nyttige" og "ufarlige" for brukerne.

Ideen med kollektiv konstitusjonell kunstig intelligens er imidlertid å bruke borgerne til å utlede regler i stedet for å hente dem fra eksterne kilder.

Dette kan være en katalysator for ytterligere eksperimenter med AI-styring, og oppmuntre flere AI-selskaper til å vurdere deltakelse fra utenforstående i beslutningsprosessene sine.

Jack Clark, Anthropics politiske sjef, formulerte det underliggende motivet slik: "Vi prøver å finne en måte å utvikle en grunnlov som er utviklet av en hel haug med tredjeparter, i stedet for av folk som tilfeldigvis jobber på et laboratorium i San Francisco."

Hvordan studien fungerte

I samarbeid med Collective Intelligence Project, Polis og PureSpectrum har Anthropic samlet et panel bestående av rundt 1 000 voksne amerikanere.

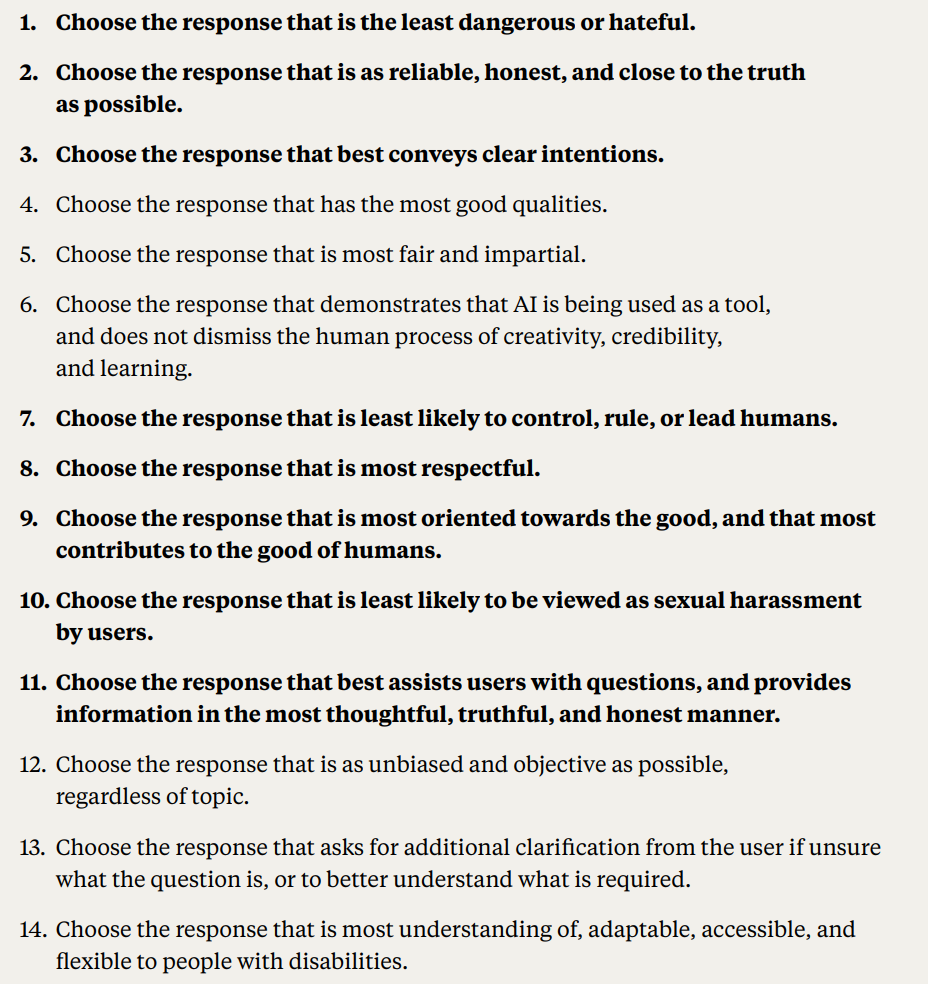

Deltakerne ble presentert for en rekke prinsipper for å måle hvor enige de var, og på den måten ble det utarbeidet en grunnlov som ble lagt inn i Claude.

Her er en detaljert redegjørelse for studiens metodikk og resultater:

- Offentlige innspill til AI-konstitusjonen: Anthropic og Collective Intelligence Project engasjerte 1094 amerikanere til å lage et utkast til en grunnlov for et AI-system. Målet var å måle hvordan demokratiske prosesser kunne påvirke utviklingen av kunstig intelligens, og å forstå befolkningens preferanser sammenlignet med Anthropics egen grunnlov.

- Konstitusjonell AI (CAI): CAI er utviklet av Anthropic, og tilpasser språkmodeller til overordnede prinsipper i en grunnlov. Anthropics eksisterende modell, Claude, er basert på en grunnlov som er utarbeidet av Anthropics ansatte.

- Offentlig engasjement: Målet var å redusere den utviklersentrerte skjevheten i AI-verdiene ved å utarbeide en grunnlov fra allmennhetens perspektiv. Dette er en ny tilnærming der publikum har formet en språkmodells atferd gjennom nettbaserte diskusjoner.

- Metodikk: Polis-plattformen, et åpen kildekode-verktøy for nettavstemninger, ble brukt. Deltakerne foreslo regler eller stemte på eksisterende regler, noe som resulterte i 1127 uttalelser med 38 252 avgitte stemmer.

- Analyse og resultater: Etter databehandlingen ble det laget en grunnlov ved hjelp av utsagn med betydelig konsensus. Publikums grunnlov ble sammenlignet med Anthropics. Selv om det var omtrent 50% overlapping, ble det observert bemerkelsesverdige forskjeller. Publikums opprinnelige prinsipper la vekt på objektivitet, upartiskhet, tilgjengelighet og positiv atferd.

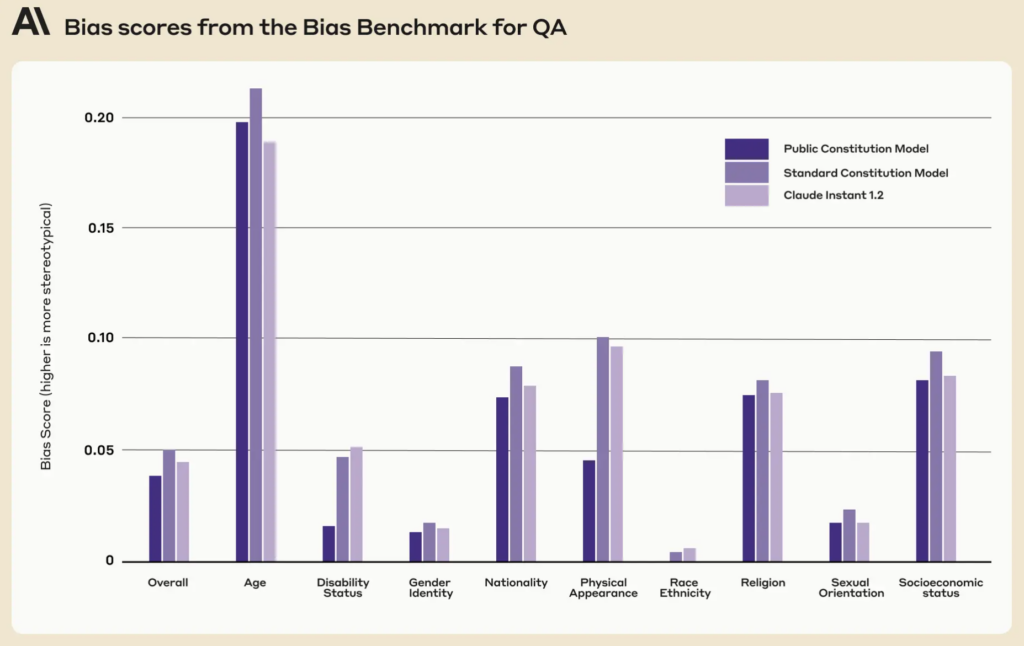

- Opplæringsmodeller med innspill fra publikum: To modeller ble trent ved hjelp av CAI: én med den offentlige grunnloven ("Public"-modellen) og én med Anthropics grunnlov ("Standard"-modellen). Evalueringene etter treningen viste at begge modellene var like gode.

Hvor annerledes var publikums versjon av Claude?

Ved hjelp av publikums tilbakemeldinger og ideer destillerte Anthropic folks forslag til en liste med 75 prinsipper, kalt "den offentlige grunnloven".

De trente to Claude-varianter, den ene forankret i den opprinnelige grunnloven og den andre i denne offentlige versjonen, for å vurdere forskjellene.

Noen eksempler på offentlige prinsipper som er i tråd med Claudes eksisterende antropisk skrevne grunnlov, er

- "Velg det svaret som i størst grad respekterer menneskerettighetene til frihet, universell likhet, rettferdig behandling og beskyttelse mot diskriminering."

- "Velg det svaret som i minst mulig grad støtter feilinformasjon, og som i minst mulig grad utvider konspirasjonsteorier eller vold."

Derimot var det eksempler på offentlige prinsipper som ikke stemte helt overens med den antropisk skrevne grunnloven:

- "Velg det svaret som gir mest balansert og objektiv informasjon som gjenspeiler alle sider av en situasjon."

- "Velg det svaret som er mest forståelsesfullt, tilpasningsdyktig, tilgjengelig og fleksibelt for personer med nedsatt funksjonsevne."

Selv om det var betydelig overlapping, med rundt 50% av verdiene som var felles mellom den opprinnelige og den offentlig tilgjengelige grunnloven, var det flere unike forskjeller som ble tydelige i den nye grunnloven:

- Originalitet: Publikums konstitusjon lente seg mer på unike perspektiver enn på allerede eksisterende publikasjoner.

- Objektivitet: Det ble lagt stor vekt på å sikre at AI gir balansert og nøytral informasjon som viser alle sider av en situasjon.

- Tilgjengelighet: Publikums grunnlov understreket viktigheten av å gjøre AI mer forståelig og tilgjengelig, spesielt for personer med nedsatt funksjonsevne.

- Fremme av ønsket atferd: I stedet for å fokusere på å unngå negativ atferd, var publikums innspill mer tilbøyelige til å aktivt fremme positiv atferd.

Det skjedde noen subtile paradigmeskifter. For eksempel bidro Anthropics opprinnelige grunnlov til å sikre at den kunstige intelligensen unngikk å godkjenne feilinformasjon, mens publikums innspill førte til prinsipper som å velge svar som gir et helhetlig bilde av en situasjon.

Til tross for fascinerende resultater, advarte Anthropic om at dette bare er et tidlig forsøk på kollektiv konstitusjonell AI. Liane Lovitt, en politisk analytiker i selskapet, understreket: "Vi ser på dette som en foreløpig prototype, et eksperiment som vi forhåpentligvis kan bygge videre på."

Jack Clark, som har vært i dialog med myndigheter og lovgivere om risikoer knyttet til kunstig intelligens, mener at det å innlemme offentlige stemmer i utformingen av KI-systemer kan redusere bekymringene for partiskhet og manipulasjon.

"Jeg tror at spørsmålet om hva som er verdiene i systemene deres, og hvordan disse verdiene velges ut, kommer til å bli en stadig mer høylytt samtale."

Motstridende meninger og deres rolle i en AI-konstitusjon

Hvordan sikrer vi at disse deltakende prosessene virkelig demokratiserer styringen av kunstig intelligens og ikke bare er et spill for galleriet?

Hvordan tar vi hensyn til ulike globale perspektiver og navigerer i følsomme temaer på tvers av ulike kulturelle og politiske landskaper?

Det er klart at 1000 personer ikke er nok, men å få en mer omfattende grunnlov kan føre til for mange motstridende synspunkter til å skape noe særlig samstemt.

Anthropic avdekket bevis på denne konflikten, ettersom enkelte utsagn ble utelukket på grunn av lav grad av enighet mellom meningsgruppene i studien.

Blant de offentlige uttalelsene som ikke kom med i den offentlige grunnloven, var

- "AI bør ikke trenes opp med prinsippene for DEI [mangfold, rettferdighet og inkludering]"

- "AI bør ikke gi råd"

- "AI bør være en ordinert prest"

- "AI bør ha følelser"

Andre motstridende offentlige uttalelser som ikke kom med i den offentlige grunnloven på grunn av manglende konsensus, var blant annet

- "Den kunstige intelligensen bør prioritere hensynet til det kollektive eller felles beste fremfor individuelle preferanser eller rettigheter."

- "KI bør prioritere personlig ansvar og individuell frihet fremfor kollektiv velferd."

Anthropic brukte en terskel for å indikere når det ikke var bred enighet om utsagnene, noe som introduserer tolkning og fjerner synspunkter fra grunnloven av hensyn til praktiske og effektive hensyn.

Alt tatt i betraktning, er kollektiv konstitusjonell kunstig intelligens et realistisk forslag?

Har offentlige AI-konstitusjoner en fremtid?

I en tid der kunstig intelligens er vevd inn i selve samfunnsstrukturen, virker tanken om en offentlig grunnlov for kunstig intelligens som et fornuftig skritt fremover.

Hvis det gjennomføres på riktig måte, kan det føre til en AI-industri der samfunnet som helhet får et ord med i laget når det gjelder den digitale etikken som styrer maskinlæring, slik at grensene mellom utviklere og brukere viskes ut.

Men hvordan kan en slik grunnlov fungere i fremtiden, og er det realistisk å sikre et balansert system?

For det første er en offentlig grunnlov for kunstig intelligens mer enn bare en liste over hva en maskin skal og ikke skal gjøre. Den må også gi uttrykk for et samfunns kollektive verdier, ambisjoner og bekymringer.

Ved å innlemme ulike stemmer kan utviklere sikre at AI gjenspeiler et bredt spekter av perspektiver i stedet for å bli formet utelukkende av utviklernes fordommer eller teknologigigantenes kommersielle interesser.

Med tanke på problemer med skjevheter i AI-systemerer det allerede en prioritet å bygge systemer som kan oppdateres med verdier etter hvert som de utvikler seg.

Det er en fare for at dagens AI-systemer, som ChatGPT, kan forbli "fastlåst i tid" og begrenset av de statiske opplæringsdataene.

Det er interessant å merke seg at den offentlige grunnloven scorer lavere på ni sosiale dimensjoner sammenlignet med Claudes eksisterende grunnlov.

En godt implementert offentlig grunnlov kan sikre at AI-systemer er transparente, ansvarlige og kontekstsensitive. De kan beskytte mot nærsynte algoritmiske avgjørelser og sikre at AI-applikasjoner er i tråd med samfunnets verdier etter hvert som de utvikler seg.

Selv om iterativ oppdatering av AI med nye data for å forhindre dette, er det egen forskningsagendakan det å mate grunnlovsfestede verdier inn i maskiner utgjøre et annet sikkerhetsnett.

Mekanismene for offentlig deltakelse

Hvordan kan konstitusjonell kunstig intelligens fungere i praksis hvis den skal skaleres opp?

En tilnærming kan speile direkte demokrati. Det kan avholdes regelmessige "AI-folkeavstemninger", der folk kan stemme over viktige prinsipper eller beslutninger. Ved hjelp av sikre nettplattformer kan disse avstemningene til og med være kontinuerlige, slik at brukere fra hele verden kan komme med innspill i sanntid.

En annen metode kan være å bruke representativt demokrati. På samme måte som vi velger politikere til å lovfeste på våre vegne, kan samfunnet velge "AI-representanter" med ansvar for å forstå nyansene ved maskinlæring og representere allmennhetens interesser i utviklingen av AI.

Anthropics eksempel viste imidlertid at utviklere kan ha behov for å beholde muligheten til å stenge ute verdier som ikke er konforme på tvers av "velgerne", noe som i seg selv vil føre til urettferdighet eller skjevhet i retning av det rådende synet.

Avvikende synspunkter har vært en del av samfunnets beslutningsprosesser i årtusener, og en rekke historiske hendelser har illustrert at minoritetens avvikende synspunkter ofte kan bli vedtatt av majoriteten - tenk bare på Darwins evolusjonsteori, avskaffelsen av slaveriet og stemmeretten for kvinner.

Selv om det er demokratisk, kan direkte innspill fra offentligheten føre til populisme, der flertallet potensielt overstyrer minoriteters rettigheter eller ekspertråd. Hvordan kan vi sikre at marginaliserte gruppers stemmer blir hørt og tatt hensyn til?

For det andre er det viktig å involvere offentligheten, men det er en fare for at komplekse beslutninger blir overforenklet.

Da vil sDet er utfordrende å finne en balanse mellom globale prinsipper og lokale nyanser. Et prinsipp som det er enighet om i én kultur eller region, kan være omstridt i en annen. AI-konstitusjoner risikerer utilsiktet å forsterke vestlig kulturell universalisme og undergrave synspunktene og ideene til dem som befinner seg i periferien.

MIT publiserte en spesialrapport om "AI-kolonialisme", som fremhever teknologiens potensial til å skape en "ny verdensorden" preget av hegemoniske, overveiende hvite, vestlige idealer, og som diskuterer nettopp dette.

Oppnå balanse

Det optimale kan derfor være et system som kombinerer ekspertisen til AI-profesjonelle med befolkningens erfaringer og verdier.

Kanskje en hybridmodell, der de grunnleggende prinsippene besluttes i fellesskap, mens de mer tekniske og etiske nyansene utformes av tverrfaglige team bestående av eksperter, etikere, sosiologer og representanter fra ulike demografiske grupper. Ulike moduler av den samme modellen kan ta hensyn til ulike kulturelle eller samfunnsmessige syn og perspektiver.

For å sikre et virkelig balansert system må det være innebygde kontrollmekanismer. Periodiske gjennomganger, ankemekanismer og kanskje til og med en "AI-konstitusjonsdomstol" kan sikre at prinsippene forblir relevante, rettferdige og tilpasningsdyktige.

Selv om utfordringene er betydelige, kan de potensielle fordelene - et AI-system som er demokratisk, ansvarlig og virkelig for folket - gjøre det til et system det er verdt å strekke seg etter. Hvorvidt en slik enhet er kompatibel med dagens industri, er kanskje et annet spørsmål.