Forskere fra University of Chicago har utviklet et nytt verktøy for å "forgifte" AI-modeller når AI-selskaper inkluderer bilder i datasettene sine uten samtykke.

Selskaper som OpenAI og Meta har blitt utsatt for kritikk og søksmål på grunn av sin omfattende skraping av nettinnhold for å trene opp modellene sine. For at tekst-til-bilde-generatorer som DALL-E eller Midjourney skal være effektive, må de trenes opp på store mengder visuelle data.

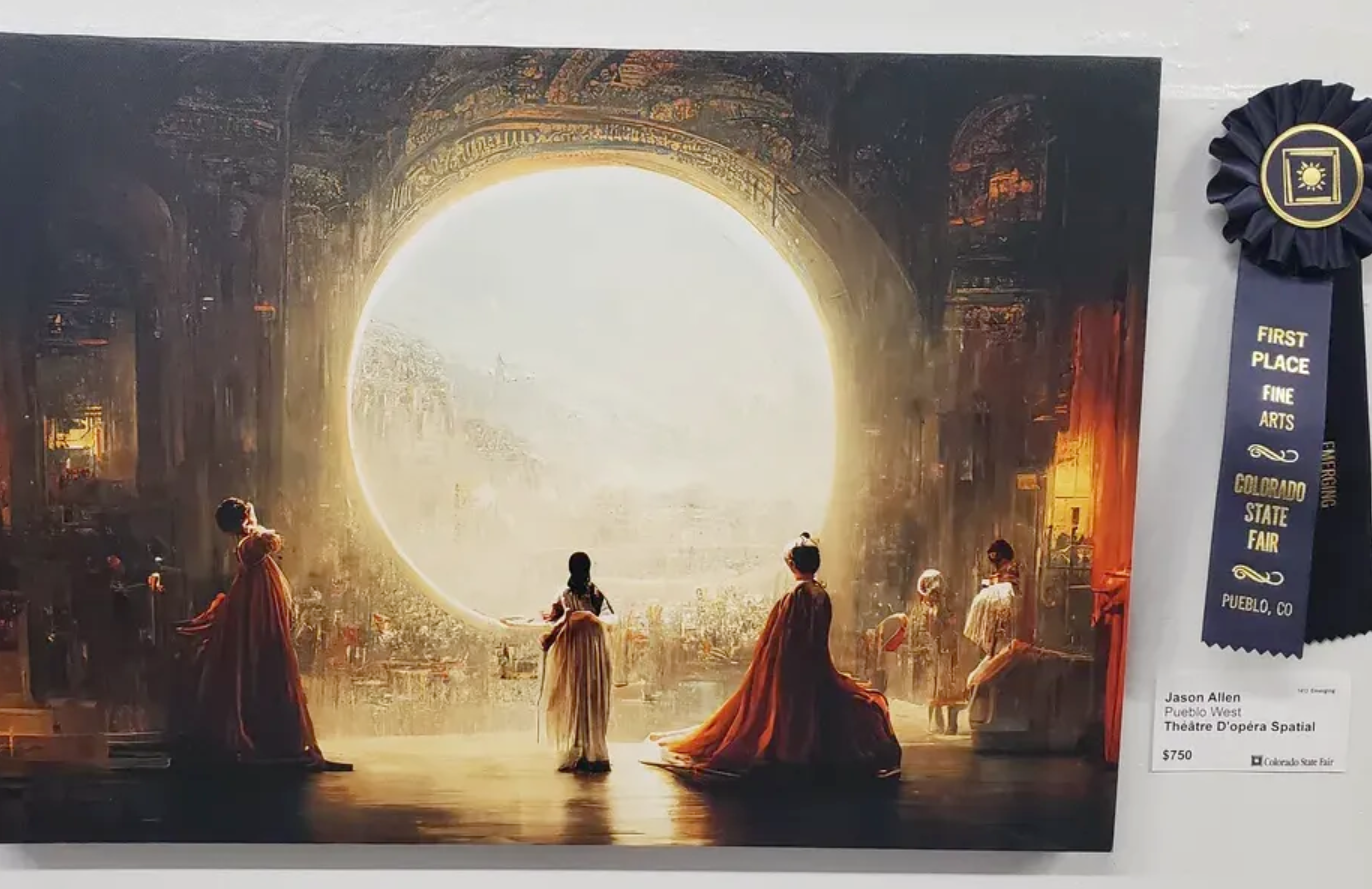

En rekke kunstnere har klaget over at disse bildegeneratorene nå kan produsere bilder i deres stil etter å ha scrapet kunsten deres uten samtykke.

Den forskere opprettet Nightshade, et verktøy som legger inn usynlige piksler i et bilde som deretter gjør bildet "giftig" for AI-modeller.

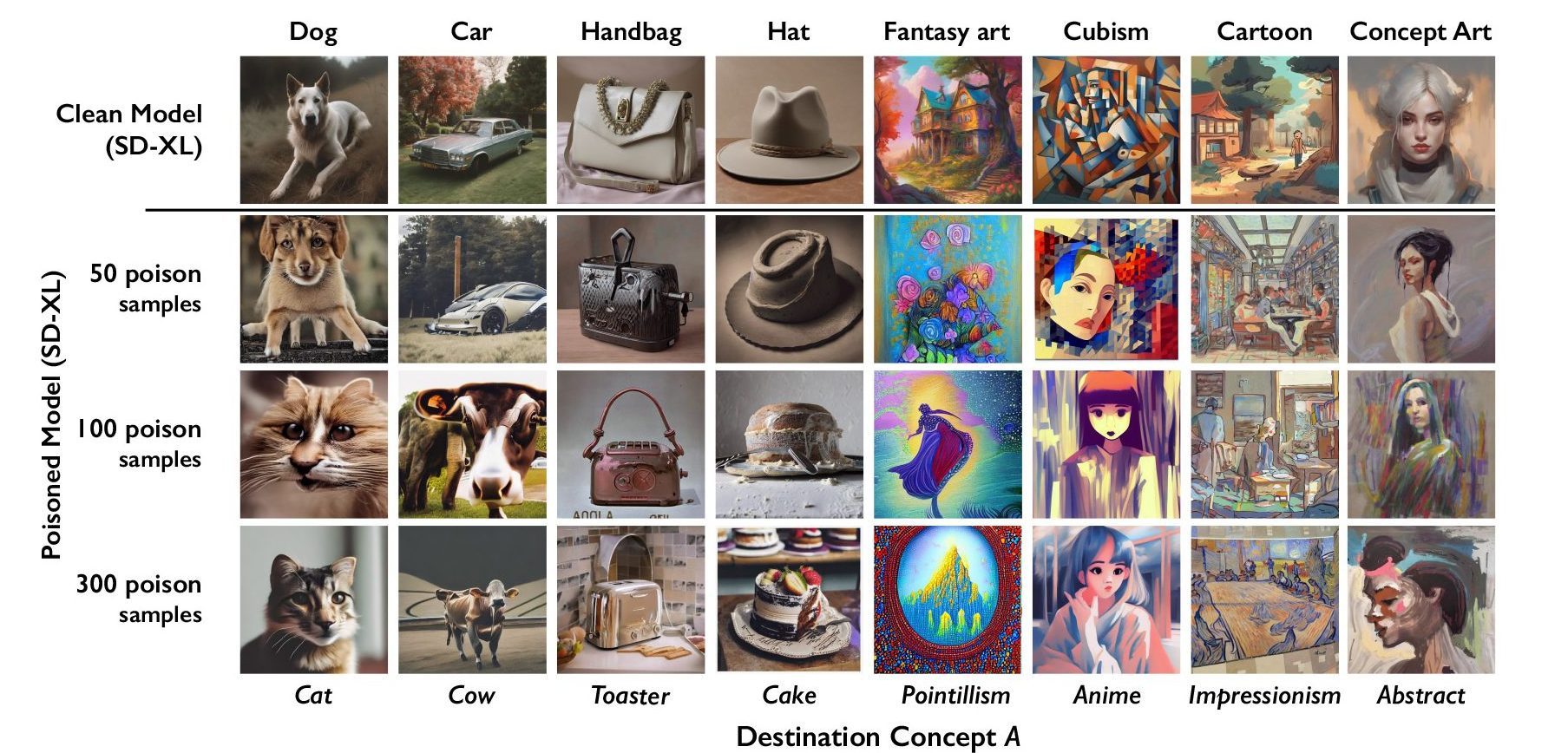

Generativ AI er avhengig av riktig merkede data. Hvis en AI-modell er trent på tusenvis av bilder av katter, og alle bildene er merket med "katt", vet den hvordan en katt skal se ut når du ber den om å generere et bilde av en katt.

Nightshade legger inn data i bildet som ødelegger klassifiseringen av bildet. Et bilde av et slott som er forgiftet av Nightshade, vil for eksempel bli klassifisert som en gammel lastebil. Forskerne fant ut at bruk av så få som 100 bilder rettet mot en enkelt ledetekst var effektivt for å korrumpere en modell.

Nightshade er dårlige nyheter for AI-bildegeneratorer

En modell som er påvirket av forgiftet data, kan få inntrykk av at bilder av kaker er hatter, eller at brødristere er håndvesker. I tillegg til å korrumpere det spesifikke ordet som Nightshade er ute etter, infiserer korrupsjonen også bredere begreper. Hvis "hund" blir korrumpert, vil også begreper som "valp" bli korrumpert.

Hvis mange nok kunstnere begynner å bruke Nightshade, kan det føre til at selskapene blir mye mer forsiktige med å innhente samtykke før de tar bilder.

Forskerteamet vil innlemme Nightshade i Glaze-verktøyet de også har utviklet. Glaze forkludrer stilen på et bilde. For eksempel kan en kunstner som ønsker å beskytte stilen på verket sitt, bruke Glaze til å merke det som "impresjonistisk" når det egentlig er "popkunst".

Det faktum at verktøy som Nightshade fungerer så effektivt, understreker en sårbarhet i tekst-til-bilde-generatorer som kan utnyttes av ondsinnede aktører.

Selskaper som OpenAI og Stability AI sier at de vil respektere Fravalg av "ikke skraping som nettsteder kan legge til i robots.txt-filene sine. Hvis bildene som er forgiftet av Nightshade ikke skrapes, forblir modellene upåvirket.

Ondsinnede aktører kan imidlertid forgifte en stor mengde bilder og gjøre dem tilgjengelige for skraping med den hensikt å skade AI-modeller. Den eneste måten å omgå dette på, er med bedre merkingsdetektorer eller menneskelig gjennomgang.

Nightshade vil få kunstnere til å føle seg litt tryggere når det gjelder å legge ut innholdet sitt på nettet, men kan skape alvorlige problemer for AI-bildegeneratorer.