AI er i ferd med å gjennomsyre livene til millioner av mennesker over hele verden, men til tross for utbredt bruk viser teknologien seg å være vanskelig å tjene penger på i en tid med eskalerende kostnader.

Generative AI-verktøy som ChatGPT er kostbare å kjøre, og krever avanserte servere, dyre GPU-er og omfattende tilleggsmaskinvare som sluker enorme mengder strøm.

Selv om det i stor grad er ubekreftet, har Dylan Patel fra SemiAnalysis fortalte The Information at OpenAI angivelig skal ha gitt ut noen $700 000 per dag for å drive modellene sine, og hadde et tap på nesten $500 millioner i 2022.

John Hennessy, styreleder i Googles morselskap, Alphabet, sa at en enkelt ledetekst på Bard koster opp til 10 ganger mer enn et Google-søkog analytikere tror Google vil pådra seg milliarder av kroner i AI-relaterte utgifter de kommende årene.

2023 har fungert som et testområde for inntektsgenerering fra kunstig intelligens. Teknologigiganter som Microsoft, Google og Adobe, blant andre, prøver ut en rekke ulike tilnærminger for å skape, markedsføre og prise AI-tilbudene sine.

De fleste kommersielle modeller som ChatGPT, Bard og Anthropics Claude 2 begrenser allerede brukerne til et visst antall meldinger per time eller dag, inkludert betalte versjoner som ChatGPT Plus. Adobe setter månedlige bruksbegrensninger for sine Firefly-modeller.

De enorme kostnadene ved AI rammer også bedrifter. Adam Selipsky, administrerende direktør i Amazon Web Services (AWS), kommenterte de uoverkommelige kostnadene for bedriftsbrukere som ønsker å bygge AI-arbeidsbelastninger: "Mange av kundene jeg har snakket med, er misfornøyde med kostnadene de ser for å kjøre noen av disse modellene."

Chris Young, Microsofts sjef for bedriftsstrategi, bemerket at det fortsatt er tidlig for bedrifter som ønsker å utnytte dagens AI-modeller, og uttalte: "Det vil ta tid for bedrifter og forbrukere å forstå hvordan de ønsker å bruke AI og hva de er villige til å betale for det."

Han la til: "Vi er helt klart kommet til et punkt der vi nå må omsette begeistringen og interessen til reell adopsjon."

AI-modeller vs. programvare

AI gir ikke den samme økonomien som konvensjonell programvare, ettersom den krever spesifikke beregninger for hver oppgave.

Når brukerne spør en modell som ChatGPT, søker den etter mønstre og sekvenser fra treningsdataene i den nevrale nettverksarkitekturen og beregner et spesifikt svar. Hver interaksjon trekker energi, noe som fører til løpende kostnader.

I takt med at bruken øker, øker også utgiftene, noe som utgjør en utfordring for selskaper som tilbyr AI-tjenester til faste priser.

Microsoft har for eksempel nylig samarbeidet med OpenAI om å lansere GitHub Copilot, som er rettet mot programmerere og utviklere.

De høye driftskostnadene har så langt ikke ført til lønnsomhet. I årets første måneder krevde Microsoft et abonnement på $10 i måneden for denne AI-assistenten og pådro seg et gjennomsnittlig tap på mer enn $20 i måneden for hver bruker. Noen brukere påførte tap på opptil $80 i måneden, noe som ble avslørt av en kilde til WSJ.

Microsofts Copilot-pakke for Microsoft 365 (som til forveksling heter det samme som GitHub-verktøyet) vil etter planen koste $30 ekstra i måneden. Dette verktøyet tilbyr funksjoner som å skrive e-post, lage PowerPoint-presentasjoner og Excel-regneark.

På samme måte vil Google også lansere en AI-assistentfunksjon for arbeidsplassverktøyene sine, og pålegge en ekstra månedlig kostnad på $30 på toppen av eksisterende avgifter.

Både Microsoft og Google satser på en fast månedlig pris, i håp om at de økte avgiftene vil veie opp for de gjennomsnittlige kostnadene ved å drive disse AI-verktøyene.

Selv om $30/måned kan virke rimelig i noen mer utviklede vestlige land, omfatter ikke disse prismodellene store deler av verdens befolkning.

Da ChatGPT Plus ble lansert på det indiske markedet, var det for eksempel mange som klaget over at det var altfor dyrt, noe som utgjør en betydelig andel av den gjennomsnittlige månedslønnen $330. Det kan koste utviklerne dyrt når de skal markedsføre AI-verktøy til publikum.

Kostnaden er heller ikke uvesentlig for dem som bor i mer velstående land, og undersøkelser viser at abonnementer er noe av det første som forsvinner når folk ønsker å redusere utgiftene sine.

Hvorfor er AI så vanskelig å tjene penger på?

KI skaper et tomrom mellom utviklernes tilsynelatende uendelige visjoner og de begrensede ressursene som er tilgjengelige for å realisere dem.

OpenAIs administrerende direktør Sam Altman hevder at en futuristisk verden med innebygd kunstig intelligens rett og slett er "uunngåelig", der intelligente maskiner lever ved siden av oss og gjør det vi ber om, der mennesker lever i hundrevis av år eller udødelig, og der kunstig intelligens innebygd i hjernen vår hjelper oss med å utføre komplekse oppgaver ved at vi tenker alene.

Han er absolutt ikke alene om det, og Inflection-sjef Mustafaya Suleman ga nylig ut boken "The Coming Wave", der han sammenligner kunstig intelligens med den kambriske eksplosjonen for 500 millioner år siden, som førte til den raskeste evolusjonsbølgen som noen gang har funnet sted på planeten vår.

Generativ AI kommer til å eksplodere, og omsetningen forventes å overstige $1 billioner innen 2032. Fra hvor det startet til hvor det er nå, og hvor det vil være, er utrolig ... alle bransjer vil bli forandret til det bedre. pic.twitter.com/0licQGfphn

- Mustafa Suleyman (@mustafasuleyman) 20. oktober 2023

Ambisjoner driver ideer, men det er penger som driver teknologibransjen. Forskning og utvikling av kunstig intelligens er kostbart, og derfor investerer industriledere som OpenAI, Google og Facebook store summer for å holde seg i forkant av kappløpet.

AI-selskaper tiltrakk seg investeringer på hele $94 milliarder i 2021, med flere finansieringsrunder som nådde $500 millioner eller mer. I 2023 økte investeringene i oppstartsbedrifter til Antropisk og Bøyning passerte $1 milliard.

AI-spesialister krever høye lønninger, ofte i millionklassen, på grunn av hard konkurranse, og modellene krever regelmessig finjustering og stresstesting, noe som øker de løpende kostnadene.

I tillegg kommer kostnader knyttet til datasentrene og vedlikehold, særlig kjøling, ettersom slik maskinvare blir varm og er utsatt for sammenbrudd hvis den ikke holdes på optimal temperatur.

GPU-er har i noen tilfeller en kort levetid på under fem år og krever ofte spesialvedlikehold.

Strategier for å tjene penger på AI

I lys av disse utfordringene, hvordan tilnærmer teknologiselskapene seg utfordringen med å tjene penger på kunstig intelligens?

Økt produktivitet

Bedrifter kan dra nytte av kunstig intelligens ved å øke samfunnets nettoproduktivitet betydelig. Ved å automatisere repeterende oppgaver kan bedriftens ansatte fokusere på verdiskapende funksjoner på et høyere nivå.

Dette vil hjelpe dem med å få tilgang til både private og offentlige midler. DeepMind samarbeider for eksempel med National Health Service (NHS) i Storbritannia, og teknologiselskaper samarbeider med myndighetene om å bekjempe klimaendringene.

AI-drevet produktivitet kan imidlertid påvirke teknologiselskapenes andre inntektsstrømmer. For eksempel har Googles annonseinntektene synker etter hvert som AI trekker trafikk fra søkemotoren. I år økte Googles inntekter fra YouTube-annonser nedgang med 2,6%og inntektene fra reklamenettverk synker med hele 8,3%.

Salg av maskinvare

Opplæring og hosting av AI-modeller krever spesialisert, avansert maskinvare. GPU-er er uunnværlige for å kjøre sofistikerte AI-algoritmer, noe som gjør dem til en lukrativ komponent i AI-økosystemet.

Bransjelederen Nvidia er den store vinneren her, med en markedsverdi på over $1 billioner, men også andre produsenter av AI-maskinvare med lavere nøkkel har også dratt nytte av det.

Abonnementer

Å tilby AI-forbedringer som en del av abonnementspakker er den beste måten å generere inntekter fra offentlige brukere og bedrifter som ikke ønsker eller trenger å gå API-veien.

ChatGPT Plus er den AI-tjenesten som har flest abonnenter globalt, men det mangler informasjon som beskriver hvor store inntekter den genererer.

OpenAI lanserte sin Enterprise-variant i år for å styrke abonnementsinntektene og erklærte at selskapet har som mål å omsette for $1 milliard i løpet av neste år.

API-er

Selskaper som OpenAI benytter en token-basert faktureringsmetode for bedrifts- og forretningsbrukere for API-ene sine.

Dette systemet sikrer at brukerne faktureres basert på den faktiske beregningsmengden av forespørslene deres, noe som sikrer rettferdighet og åpenhet.

API-prismodeller passer for et bredt spekter av brukere, fra de som foretar sporadiske, lette anrop til tunge brukere med intensive oppgaver.

AI som en iboende funksjon

Noen bedrifter integrerer AI-funksjoner i produktene sine uten å ta ekstra betalt med en gang. Denne strategien tar sikte på først å øke produktets iboende verdi.

Når brukerne først har integrert AI-funksjonene i arbeidsflyten og innsett verdien av dem, er det mer sannsynlig at de vil akseptere en påfølgende prisøkning. AI må imidlertid levere progressive fordeler hvis kostnadene skal øke jevnt og trutt.

Kostnadene for opplæring i åpen kildekode for kunstig intelligens blir stadig lavere

Det er en parallell diskusjon her - hvorfor skal noen betale for AI når de aldri eier den?

Noen - som AI-"gudfar" Yann LeCun - argumenterer for at AI bør bli en del av vår offentlige infrastruktur, og understreker behovet for at utviklere bygger modeller med åpen kildekode som er billige og enkle å få tilgang til.

En NYT-artikkel om debatten rundt hvorvidt LLM-basismodeller bør være lukkede eller åpne.

Meta argumenterer for åpenhet, og starter med lanseringen av LLaMA (for ikke-kommersiell bruk), mens OpenAI og Google ønsker å holde ting lukket og proprietært.

De argumenterer for at åpenhet kan være...

- Yann LeCun (@ylecun) 18. mai 2023

AI-løsninger blir stadig viktigere for bedrifter, men mange har ikke budsjett til å utvikle egne modeller fra grunnen av. Tradisjonelt har de vendt seg til API-er fra nystartede AI-virksomheter eller hyllevare.

Etter hvert som opplæringskostnadene synker og kravet til personvern øker, blir det imidlertid stadig mer populært å samarbeide med leverandører som spesialiserer seg på å tilpasse både private modeller og modeller med åpen kildekode.

Naveen Rao, administrerende direktør og medgrunnlegger av MosaicML, forklarte til The Register at åpen kildekode-modeller er fristende fordi de er billigere, mer fleksible og gjør det mulig for bedrifter å holde arbeidsbelastningen privat.

MosaicML lanserte en serie store språkmodeller (LLM-er) med åpen kildekode basert på MPT-7B-arkitekturen. I motsetning til mange andre LLM-er er denne modellen kommersielt levedyktig for massene.

Rao fortalte om bakgrunnen for denne modellen: "Det er definitivt stor interesse for denne typen ting, og vi gjorde det av flere grunner." Han la til: "Den ene var at vi ønsket å ha en modell der ute som har tillatelse til kommersiell bruk. Vi ønsker ikke å kvele den typen innovasjon."

Rao sa: "Hvis en kunde kommer til oss og ber oss om å trene opp denne modellen, kan vi gjøre det for $200 000, og vi tjener fortsatt penger på det."

MosaicML gir også bedrifter verktøyene de trenger for å effektivt hoste sine tilpassede modeller på skyplattformer. "Dataene deres deles ikke med oppstartsbedriften, og de eier modellens vekting og IP", bekrefter Rao.

Rao kom også inn på begrensningene ved kommersielle API-er: "Kommersielle API-er er et flott verktøy for prototyping. Jeg tror at med ChatGPT-tjenester vil folk bruke dem til underholdning, og kanskje noen personlige ting, men ikke for bedrifter. Data er en veldig viktig vollgrav for selskaper."

Rao fremhevet videre kostnadene ved intern arkitektur, og sa: "GPU-ene svikter faktisk ganske ofte", "Hvis en node går ned, og det kreves en manuell intervensjon, og det tok deg fem timer [å fikse], har du nettopp brent $10 000 uten å jobbe, ikke sant?"

Han tok også opp det truende problemet med mangel på brikker i bransjen"Vi kommer til å leve i en verden med GPU-mangel i minst to år, kanskje fem."

Hvis bedrifter kan benytte seg av åpen kildekode-AI for å trene opp sine rimelige modeller med full datasuverenitet og kontroll, utgjør det en utfordring for offentlig AI som ChatGPT.

AIs truende flaskehalser?

I tillegg til GPU-mangelen som Rao trekker frem, er en annen barriere for AI-inntektsgenerering bransjens skyhøye energibehov.

A fersk undersøkelse spår at AI-industriens energiforbruk innen 2027 kan komme til å tilsvare energiforbruket til en liten nasjon.

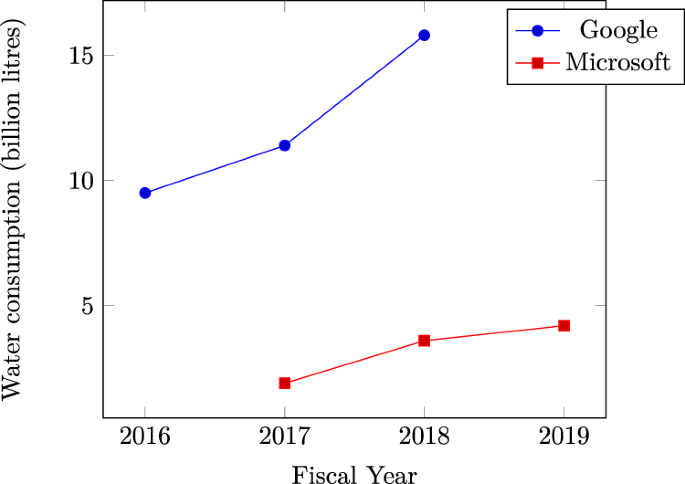

Microsofts skyhøyt vannforbruk i datasentre bekrefter AIs enorme tørst etter naturressurser. Mye tyder på at den siste tidens økning i vannforbruket hos teknologigiganter som Microsoft og Google skyldes intensiv AI-relatert arbeidsmengde.

I en større skala overgår den kumulative energien som brukes av datasentre allerede 1% av det globale strømforbruket, i henhold til Det internasjonale energibyrået (IEA).

Hvis energibehovet fortsetter å øke, kan AI-selskapene bli tvunget til å rette oppmerksomheten mot å utvikle mer effektive metoder for modellopplæring, noe som kan skade teknologiens utvikling på kort sikt.

Konkurrerende fortellinger

Den gryende AI-industrien er fortsatt ung, og det er svært vanskelig å forutsi hvilken retning den vil ta.

Sentrale personer innen kunstig intelligens erkjenner at deres forestillinger ikke alltid stemmer overens med virkeligheten.

I Joe Rogan-podcasten innrømmet Sam Altman for eksempel at han tok feil med hensyn til AIs utviklingskurs, og beskrev at veien til å realisere høyintelligente former for AI vil være granulær snarere enn eksplosiv.

På den ene siden er det utfordrende å tjene penger på kunstig intelligens, noe som skaper tvil om hvorvidt den første hypen vil avta og føre til en langsommere modningsprosess for teknologien.

På den annen side kan det hende at bransjen allerede har gjort nok fremskritt til å presse AI mot en "singularitet" der den utkonkurrerer menneskelig erkjennelse.

I løpet av de neste årene, hvis menneskeheten oppnår fremgang på viktige områder som energiproduksjon og bygging av AI-maskinvare og -arkitektur med lavt strømforbruk - og Det er gjort fremskritt på dette området i år. - kan teknologien fjerne flaskehalser på kort sikt og fortsette sin rivende utvikling.