Nvidia avduket en oppdatert versjon av sin Grace Hopper Superchip (GH200) som ble annonsert for to måneder siden. GH200 ble designet for å drive datasentre for storskala AI-prosessering.

GH200 har ikke gått i serieproduksjon ennå, men den har allerede hatt en større oppgradering i minnet. Den hemmelige sausen i disse nye brikkene er det oppgraderte minnet med høy båndbredde, kalt HBM3e, som er i stand til å få tilgang til data med en hastighet på 5 TB/s.

Dette representerer en forbedring på 50% i forhold til HBM3-minnet i brikken som ble annonsert i slutten av mai.

Nvidia koblet dette høyhastighetsminnet til kraftige CPU-er og GPU-er på samme enhet. Den resulterende økningen i prosesseringshastighet vil dramatisk forbedre AI-prosesseringsevnen som dagens datasentre har.

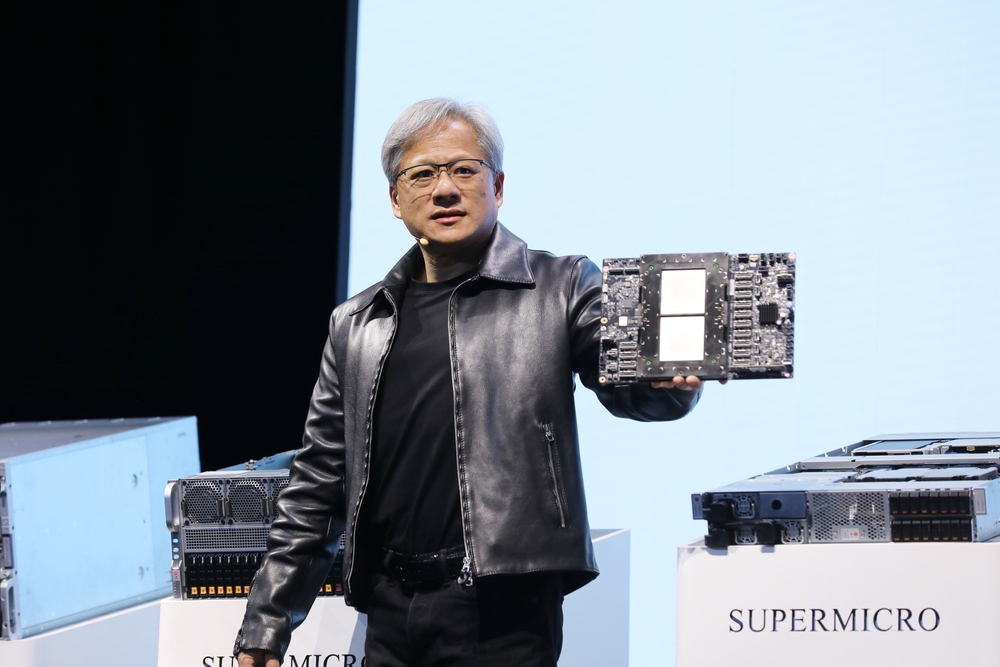

I tillegg til den oppdaterte brikken kunngjorde Nvidia også GH200 Grace Hopper-plattformen, som gjør det mulig å koble sammen to GH200-brikker på ett enkelt kort.

Plattformen leverer åtte petaflops med AI-prosessering og 282 GB HBM3e-minne med en båndbredde på 10 TB/s.

Hvordan vil Nvidias chip endre datasentrene?

Tallene kan være litt vanskelige å forstå. Så hvor viktig er denne nye brikken og plattformen?

I sin presentasjon brukte Nvidia-sjef Jensen Huang et eksempel på et typisk datasenter med 8800 x86-prosessorer som utfører en rekke ulike databehandlingsfunksjoner (ISO-budsjett).

Et datasenter som dette som kjører Llama 2 for inferens, med en vektordatabase som blir forespurt og SDXL som genererer utdataene, vil koste deg rundt $100m og bruke 5MW strøm.

Et $100m datasenter som bruker 2500 GH200-plattformer, kan kjøre de samme modellene 12 ganger raskere og vil bare bruke 3 MW strøm.

Hvis et datasenter var fokusert på et svært spesifikt sett med oppgaver (ISO-arbeidsbelastning), blir sammenligningen enda mer overveldende.

Du trenger bare å bruke $8m for 210 GH200-enheter som bruker 20 ganger mindre energi for å oppnå samme ytelse som et datasenter med $100m.

Det sier seg selv at alle datasentre for AI-databehandling i skyen som var i planleggingsfasen før denne lanseringen, må tilbake til tegnebrettet.

GH200-brikkene lanseres i 2. kvartal 2024 og forventes å spise opp mye av x86-prosessorvirksomheten. AMDs nye MI300-brikke er Nvidias nærmeste rival, men den større minnefordelen ser ut til å bli uthulet av oppgraderingen i den nye GH200.

Utviklingen innen prosessorteknologi som vi ser, overgår Moores lov og viser ingen tegn til å avta. Generative AI-applikasjoner leverer allerede imponerende ytelse, men det ser ut til at de er i ferd med å bli mye raskere.