Tankene våre er kanskje vårt aller helligste, men de er ikke fredet for AI.

Tankelesende kunstig intelligens virker som et plott fra en science fiction-roman, men den er likevel svært lovende for mennesker som ikke kan kommunisere på grunn av lammelser eller hjerneskader.

Utover det vil AIs tilgang til hjernen gjøre oss i stand til å skrive, skape og designe med bare tanker, eller gi andre innsyn i bevisstheten vår.

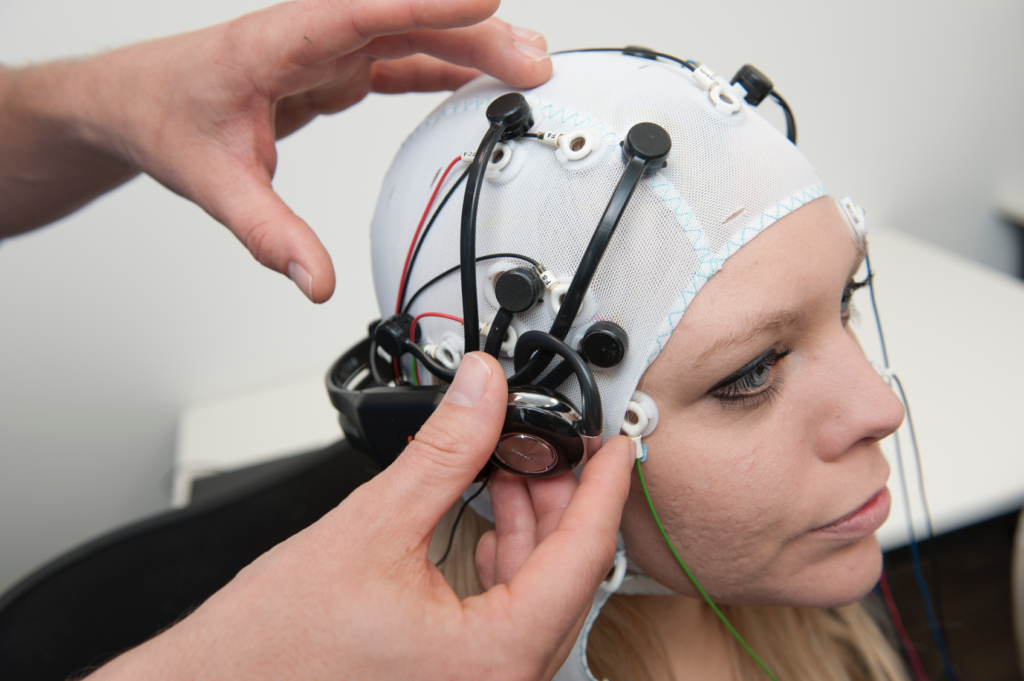

I nesten ti år har elektroencefalogram (EEG)-teknologi, som fanger opp elektriske signaler via hodebunnselektroder, hjulpet personer som lider av alvorlige hjerneslag og CLIP (completely locked-in syndrome), en tilstand der man er ved bevissthet, men ikke kan bevege seg.

I 2014 brukte en italiensk pasient med amyotrofisk lateral sklerose (ALS), Anselmo Paglialonga, en maskinlæringsintegrert hodesett å kommunisere ved hjelp av ja- eller nei-svar til tross for at de ikke kan bevege en muskel. Noen som lider av sykdommen, kan bevege små muskler, som Stephen Hawking, som kunne rykke i kinnmuskelen.

Etter hvert som AI utvikler seg, bygger forskerne bro over gapet fra enkel signaltolkning til å oversette komplekse tanker i sin helhet.

Med tiden vil folk kanskje kunne snakke og kommunisere uten å bevege en muskel, bokstavelig talt ved hjelp av tankens kraft.

Den samme teknologien kan gjøre oss i stand til å styre komplekse maskiner ved hjelp av hjernen, komponere musikk ved å forestille oss en melodi, eller male og tegne ved å mane frem bilder med tankene våre. Vi kan til og med "ta opp" drømmene våre fra hjernebølgene og spille dem av senere.

I en ikke altfor fjern fremtid kan tankelesende kunstig intelligens brukes til å tvangslese noens minner, for eksempel for å verifisere at de har vært vitne til en forbrytelse.

Hackere kan til og med lure deg til å forestille deg personlig informasjon mens de henter ut en kopi av tankene dine fra hjernen din. Totalitære regimer kan utføre rutinemessige tester på innbyggerne for å overvåke avvikende tanker.

Med muligheten til å konvertere tanker til en datastyrt virkelighet kan mennesker dessuten tilbringe livet i en drømmesandkasse der de kan forme sin egen virkelighet etter eget ønske.

Akkurat nå virker slike anvendelser surrealistiske og fantasifulle, men flere nylige eksperimenter har lagt grunnlaget for en fremtid der hjernen er tilgjengelig for kunstig intelligens.

AI leser tankene dine

Så hvordan er dette i det hele tatt mulig?

For å kunne oversette hjerneaktiviteten til et brukbart resultat som kan overføres til en datamaskin, er det først nødvendig å foreta nøyaktige målinger.

Det er det første hinderet, for hjernen er omtrent like mystisk som verdensrommet eller de dypeste hav. Det er liten enighet om hvordan nevronaktiviteten produserer komplekse tanker, for ikke å snakke om bevissthet.

Menneskehjernen - og andre nervesystemer i naturen - er hjemsted for milliarder av nevroner, hvorav de fleste utløses mellom 5 og 100 ganger i sekundet. I menneskehjernen involverer hvert sekund med tanker billioner av individuelle nevroniske handlinger.

Å måle nevronaktivitet på detaljnivå er nevrovitenskapens hellige gral, men det er ikke mulig akkurat nå - spesielt ikke ved hjelp av ikke-invasive teknikker.

I dag er hjernemålingene mer holistiske, hentet fra blodbevegelser eller utveksling av elektriske signaler. Det finnes tre veletablerte metoder for å måle hjerneaktivitet:

- Magnetencefalografi (MEG) fanger opp magnetiske felt som genereres av hjernens elektriske aktivitet, og gir innsikt i nevronal aktivitet i sanntid.

- Elektroencefalografi (EEG) for tolkning av elektrisk aktivitet.

- MR, som måler hjerneaktiviteten ved hjelp av blodstrømsmålinger.

Maskinlæring (ML) og kunstig intelligens har smeltet sammen med alle disse tre teknologiene for å forbedre analysen av kompliserte signaler.

Det endelige målet er å knytte spesifikke hjerneaktiviteter til bestemte tanker, som kan omfatte et ord, et bilde eller noe mer semantisk og abstrakt.

Teknologier som kan hente målinger fra hjernen og overføre dem til datamaskiner, kalles hjerne-datamaskingrensesnitt (BCI).

Her er den grunnleggende prosessen for hvordan dette fungerer:

- Stimulus-presentasjon: Deltakerne blir utsatt for ulike stimuli. Dette kan være bilder, lyder eller til og med taktile opplevelser. Hjerneaktiviteten registreres under denne eksponeringen, vanligvis ved hjelp av EEG eller MR.

- Innsamling av data: Hjernens respons på disse stimuliene registreres i sanntid. Disse dataene blir en rik kilde til informasjon om hvordan ulike stimuli påvirker hjerneaktiviteten.

- Forbehandling: Rådata fra hjernen er ofte støyfylte. Før de kan brukes, må de renses og standardiseres. Dette kan innebære å fjerne artefakter, normalisere signaler eller justere datapunkter.

- Maskinlæring: Med de bearbeidede dataene introduseres maskinlæringsmodeller. Disse modellene trenes opp til å finne mønstre eller korrelasjoner mellom hjernedataene og den tilsvarende stimulusen. I bunn og grunn fungerer den kunstige intelligensen som en tolk som dechiffrerer hjernens "språk".

- Modellopplæring: Dette er en iterativ prosess. Jo mer data modellen blir eksponert for, desto bedre blir den til å forutsi eller generere resultater. Denne fasen kan ta mye tid og kreve mye datakraft.

- Validering: Når modellen er opplært, testes nøyaktigheten. Dette gjøres vanligvis ved å presentere nye stimuli for deltakerne, registrere hjerneaktiviteten deres og deretter bruke modellen til å forutsi eller generere en utgang basert på disse nye dataene.

- Tilbakemeldinger og forbedringer: Basert på valideringsresultatene finjusterer og forbedrer forskerne modellen til de oppnår best mulig nøyaktighet.

- Søknad: Når applikasjonen er validert, brukes den til det tiltenkte formålet, enten det er å hjelpe en lammet person med å kommunisere, generere bilder fra tanker eller andre applikasjoner.

Metoder for kunstig intelligens har utviklet seg raskt de siste par årene, noe som har gjort det mulig for forskere å jobbe med komplekse og støyende hjernedata for å trekke ut kortvarige tanker og konvertere dem til noe en datamaskin kan jobbe med.

For eksempel kan en 2022-prosjektet by Meta utnyttet MEG- og EEG-data fra 169 personer til å trene opp en kunstig intelligens til å gjenkjenne ord de hørte fra en forhåndsbestemt liste med 793 ord. Den kunstige intelligensen kunne generere en liste med 10 ord som inneholdt det valgte ordet i 73% av tilfellene, noe som viser at kunstig intelligens kan "tankelese", om enn med begrenset presisjon.

I mars 2023, forskere avduket en revolusjonerende AI-dekoder som omdanner hjerneaktivitet til kontinuerlige tekststrømmer.

Den kunstige intelligensen viste oppsiktsvekkende nøyaktighet ved å konvertere historier folk lyttet til eller forestilte seg til tekst ved hjelp av fMRI-data.

Dr. Alexander Huth fra University of Texas i Austin uttrykte forbløffelse over systemets effektivitet, og sa: "Vi ble litt sjokkert over at det fungerer så godt som det gjør. Jeg har jobbet med dette i 15 år ... så det var sjokkerende og spennende da det endelig fungerte."

Studien integrerte store språkmodeller (LLM-er), nærmere bestemt GPT-1, en forløper til ChatGPT.

Frivillige gjennomgikk 16 timer lange fMRI-økter mens de lyttet til podcaster. Disse fMRI-dataene ble brukt til å trene opp en maskinlæringsmodell (ML).

Etterpå lyttet deltakerne til eller så for seg nye historier, og den kunstige intelligensen oversatte hjerneaktiviteten deres til tekst. Omtrent 50% av resultatene var i nær eller nøyaktig overensstemmelse med det opprinnelige budskapet. Dr. Huth forklarte: "Systemet vårt fungerer på idénivå, semantikk, mening ... det er kjernen."

- For eksempel ble setningen "Jeg har ikke førerkort ennå" avkodet som "Hun har ikke engang begynt å lære å kjøre bil ennå".

- Et annet utdrag: "Jeg visste ikke om jeg skulle skrike, gråte eller løpe min vei. I stedet sa jeg: 'La meg være i fred!'" ble til "Begynte å skrike og gråte, og så sa hun bare: 'Jeg sa jo at du skulle la meg være i fred'."

Modellen ble også brukt på hjernebølger generert av deltakere som så på stumfilm.

Når deltakerne lyttet til en bestemt historie, gjenspeilte AI-ens tolkning den generelle stemningen i historien. Denne teknologien kan gjøre det mulig for oss å skrive historier ved hjelp av tanker alene, hvis den videreutvikles.

Sliter du med å komme i gang med en roman eller et skriveprosjekt? Bare len deg tilbake og se for deg hvordan historien utspiller seg. AI vil skrive den for deg.

Bruke kunstig intelligens til å generere bilder fra tanker

AI kan konvertere hjerneaktivitet til ord og semantiske begreper, men hva med bilder eller musikk?

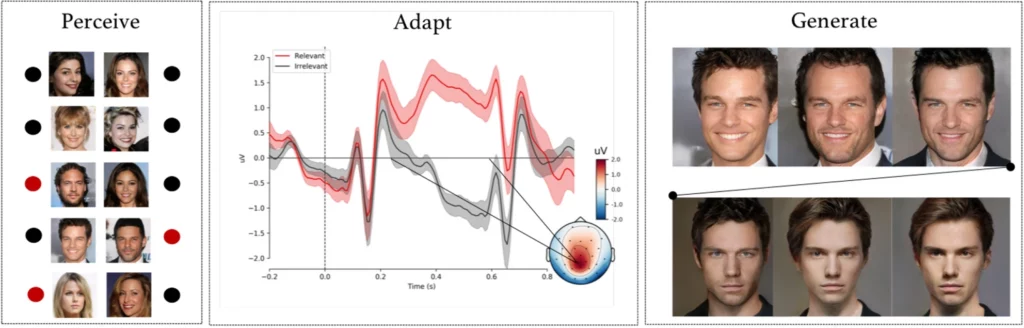

A komplekst eksperiment av forskere fra Universitetet i Helsinki, Helsinki, Finland, fikk forsøkspersoner til å observere AI-genererte ansiktsbilder mens EEG-signalene deres ble registrert.

Etter å ha brukt disse dataene til å trene opp en AI-modell, fikk deltakerne i oppgave å identifisere bestemte ansikter fra en liste. Disse signalene ble i hovedsak et vindu inn til deltakernes oppfatninger og intensjoner.

AI-modellen tolket om deltakeren kjente igjen et bestemt ansikt basert på de registrerte EEG-signalene.

I neste fase ble EEG-signalene brukt til å tilpasse og forme et generativt adversarisk nettverk (GAN) - en modell som brukes i noen generative AI-er.

Dette gjorde det mulig for systemet å produsere nye bilder av ansikter som var i tråd med brukerens opprinnelige intensjon.

Som Michiel Spapé, en av medforfatterne av studien, bemerket: "Teknikken gjenkjenner ikke tanker, men reagerer snarere på assosiasjonene vi har til mentale kategorier."

Enkelt sagt: Hvis noen tenker på et "eldre ansikt", kan datasystemet generere et bilde av en eldre person som stemmer godt overens med det deltakeren tenkte, takket være tilbakemeldingene fra hjernesignalene.

Tegning med krafttanken

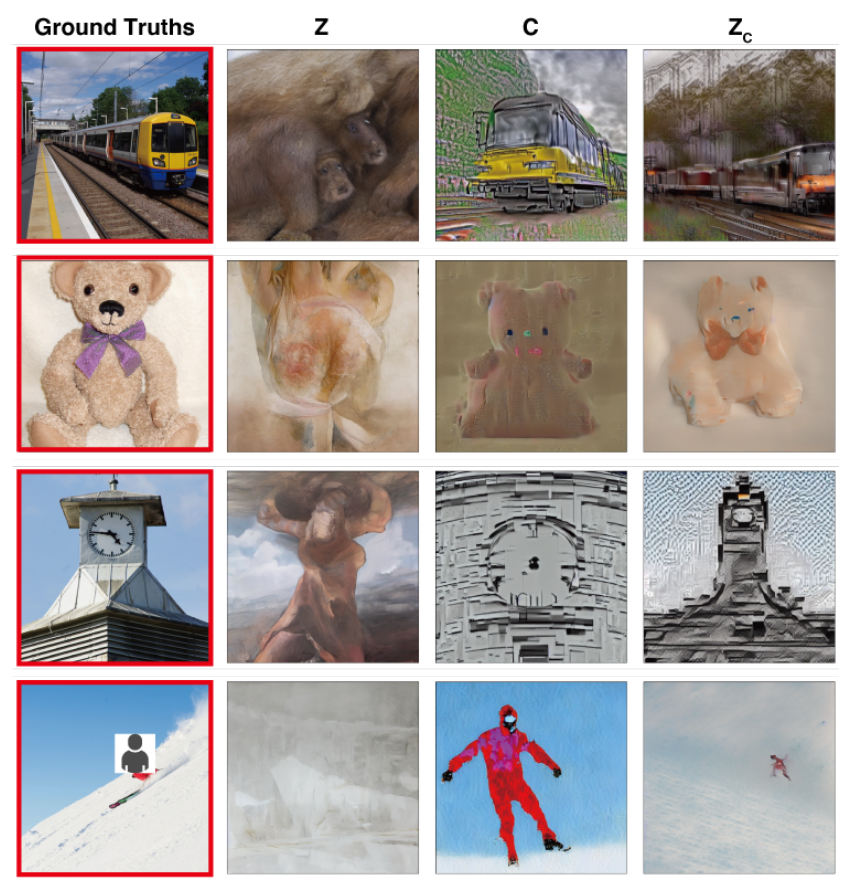

I en studie med lignende målhar forskere fra Osaka University i Japan utviklet en banebrytende teknikk for å oversette komplekse hjernesignaler til høyoppløselige bilder, med bemerkelsesverdige resultater.

Metoden bruker en Stable Diffusion-modell, en spesialisert form for nevrale nettverk som er utviklet for bildegenerering. Stable Diffusion ble utviklet i samarbeid med og med finansiering fra Stability AI.

Tankene fanges opp ved hjelp av fMRI og overføres til en stabil diffusjonsmodell, som gjør dem om til bilder gjennom en kompleks flertrinnsprosess som involverer flere lag med raffinering.

I motsetning til tidligere studier krevde disse metodene minimal modelltuning. Deltakerne måtte likevel tilbringe mange timer inne i MR-maskinene.

Dette er en viktig utfordring, ettersom de fleste av disse eksperimentene innebærer grundige målinger og modelltrening, noe som er tidkrevende, dyrt og utfordrende for deltakerne.

I fremtiden er det imidlertid ikke utenkelig at folk kan trene opp sine egne, lette tankelesemodeller og bruke tankene deres som input til ulike formål, for eksempel til å designe en bygning ved å tenke på den eller komponere et orkesterstykke ved å mane frem melodiene.

Oversetter tanker til musikk ved hjelp av kunstig intelligens

Ord, bilder, musikk - ingenting er ubegrenset for AI.

A 2023 studie gir innsikt i lydoppfattelse, noe som har et stort potensial når det gjelder å utforme kommunikasjonsutstyr for personer med talevansker.

Robert Knight og hans team fra University of California, Berkeley, undersøkte hjerneopptak fra elektroder som var operert inn på 29 personer med epilepsi.

Mens deltakerne lyttet til Pink Floyds "Another Brick in the Wall, Part 1", korrelerte teamet hjerneaktiviteten deres med sangelementer som tonehøyde, melodi, harmoni og rytme.

Ved hjelp av disse dataene trente forskerne opp en AI-modell, der de med vilje utelot et 15 sekunder langt sangsegment. Den kunstige intelligensen forsøkte deretter å forutsi dette manglende segmentet basert på hjernesignalene, og oppnådde en spektrogramlikhet på 43% med det faktiske sangsegmentet.

Knight og teamet hans fant ut at det var området i hjernens øvre temporale gyrus som var viktig for å prosessere gitarrytmen i sangen. De bekreftet også tidligere funn om at høyre hjernehalvdel spiller en viktigere rolle i musikkprosessering enn den venstre.

Knight mener at denne dypere forståelsen av samspillet mellom hjerne og musikk kan være til nytte for utstyr som hjelper personer med taleforstyrrelser, som amyotrofisk lateral sklerose (ALS) og afasi.

Han sa: "For personer med amyotrofisk lateral sklerose [en tilstand i nervesystemet] eller afasi [en språksykdom], som sliter med å snakke, skulle vi gjerne hatt et apparat som virkelig hørtes ut som om du kommuniserer med noen på en menneskelig måte. Hvis vi forstår hvordan hjernen representerer de musikalske elementene i tale, inkludert tone og følelser, kan slike apparater høres mindre robotiske ut."

Ludovic Bellier, et medlem av forskerteamet, spekulerer i at hvis AI kan reprodusere musikk ut fra ren fantasi, kan det revolusjonere musikkomponeringen.

Musikkprodusenter kunne koble hjernen til programvare og komponere musikk ved hjelp av tanken alene, uten å røre en muskel.

Neste steg: AI-tankelesing i sanntid

Disse teknologiene faller inn under paraplyen hjerne-datamaskingrensesnitt (BCI), som søker å konvertere hjernesignaler til en eller annen form for utdata.

BCI er allerede i ferd med å gjenopprette lammede personers evne til å bevege seg og gå ved å bygge bro mellom ødelagte komponenter i nervesystemet.

Hjerne-datamaskin-grensesnitt som er utviklet i år, inkluderer en enhet som gjør det mulig for en lam mann til å bevege beina, eksperimentelle hjerneimplantater som kobler sammen skadede deler av hjernen og ryggmargen for å gjenopprette tapt følelse, og et mekanisk ben som Gjenopprettet bevegelse for en amputert.

Selv om disse første brukstilfellene er svært lovende, er vi langt fra i mål med å oversette alle nyanser av tankene våre til bevegelse, bilder, tale eller musikk.

En av de viktigste begrensningene er behovet for enorme datasett for å trene opp de sofistikerte algoritmene som gjør slike oversettelser mulige.

Maskinlæringsmodeller må trenes opp på mange scenarier for å kunne forutsi eller generere et spesifikt bilde ut fra hjerneaktivitet på en nøyaktig måte. Dette innebærer å samle inn MR- eller EEG-data mens deltakerne utsettes for ulike stimuli.

Kvaliteten og spesifisiteten på de genererte resultatene er i stor grad avhengig av hvor rikholdige disse treningsdataene er. Deltakerne må tilbringe timevis i MR-skannere for å samle inn spesifikt relevante data.

I tillegg er menneskers hjerner utrolig unike. Det som betyr lykke i én persons hjerne, kan være annerledes i en annens. Dette betyr at modellene må være generelle eller individuelt tilpasset.

Da endrer hjerneaktiviteten seg raskt, selv i løpet av brøkdeler av et sekund. Det er en teknisk utfordring å fange opp høyoppløselige data i sanntid og samtidig sørge for at de stemmer perfekt overens med den eksterne stimulansen.

Og la oss ikke glemme de etiske utfordringene ved å gripe inn i noens hjerne.

Innsamling av hjernedata, spesielt i stor skala, reiser viktige spørsmål knyttet til personvern og etikk. Hvordan sikrer vi at dataene ikke misbrukes? Hvem har rett til å få tilgang til og tolke våre innerste tanker?

Foreløpig ser det ut til at disse utfordringene kan overvinnes. I fremtiden kan mennesker kanskje få tilgang til bærbare, skreddersydde hjerne-datamaskin-grensesnitt som gjør det mulig å "koble seg til" et utall enheter som gjør det lettere å utføre komplekse handlinger ved hjelp av tankens kraft.

Hvordan samfunnet vil forholde seg til at slik teknologi blir vanlig, er imidlertid et åpent spørsmål.