Samtidig som det snakkes mye om risikoen ved AI-systemer, kan vi ikke overse den belastningen teknologien legger på verdens allerede hardt belastede energi- og vannforsyning.

Komplekse maskinlæringsprosjekter (ML) er avhengige av en konstellasjon av teknologier, inkludert maskinvare for opplæring (GPU-er) og maskinvare for hosting og distribusjon av AI-modeller.

Selv om effektive AI-treningsteknikker og -arkitekturer lover å redusere energiforbruket, har AI-boomen nettopp startet, og big tech øker investeringene i ressurskrevende datasentre og skyteknologi.

Etter hvert som klimakrisen tilspisser seg, er det viktigere enn noensinne å finne en balanse mellom teknologiske fremskritt og energieffektivitet.

Energiutfordringer for kunstig intelligens

Energiforbruket til kunstig intelligens har økt i takt med fremveksten av komplekse, beregningskrevende arkitekturer som nevrale nettverk.

Det ryktes for eksempel at GPT-4 skal være basert på 8 modeller med 220 milliarder parametere hver, til sammen ca. 1,76 billioner parametere. Inflection bygger for tiden en klynge av 22 000 avanserte Nvidia-brikker, som kan koste rundt $550 000 000 000 til en grov utsalgspris på $25 000 per kort. Og det er bare for brikkene alene.

Hver avanserte AI-modell krever enorme ressurser å trene opp, men det har vært utfordrende å forstå de reelle kostnadene ved AI-utvikling helt frem til nylig.

A 2019 studie fra University of Massachusetts at Amherst undersøkte ressursforbruket knyttet til Deep Neural Networks (DNN).

Vanligvis krever disse DNN-ene at dataforskere manuelt utformer eller bruker Neural Architecture Search (NAS) for å finne og trene opp et spesialisert nevralt nettverk fra bunnen av for hvert unike tilfelle.

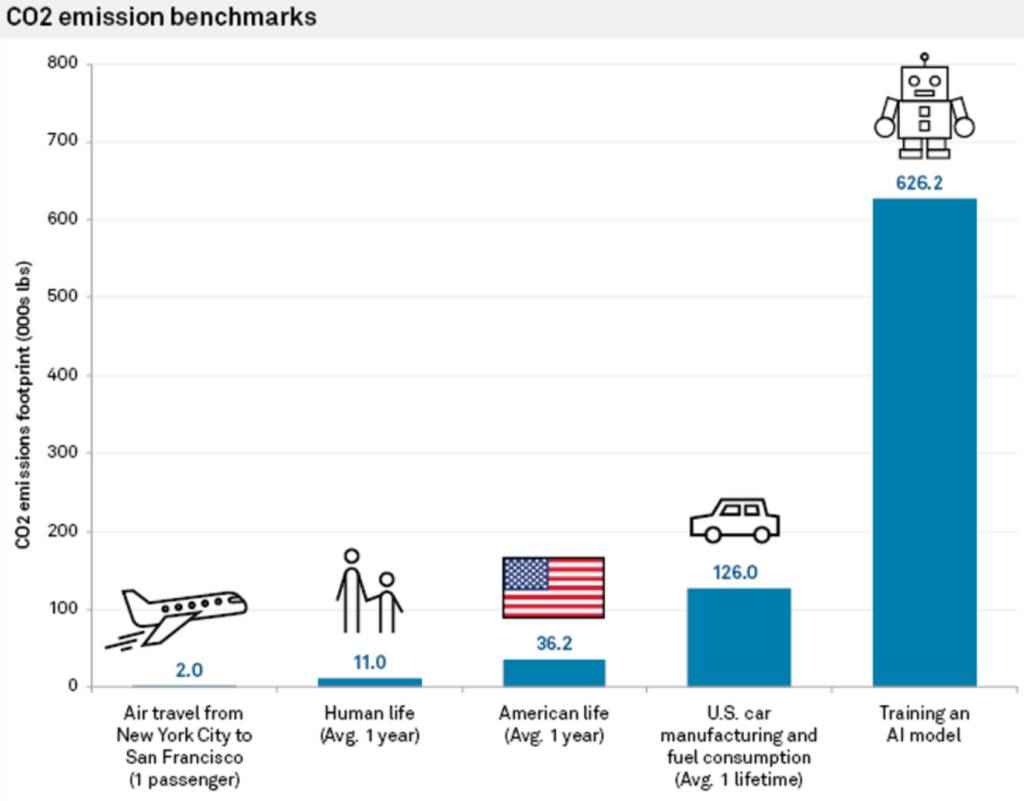

Denne tilnærmingen er ikke bare ressurskrevende, men har også et betydelig karbonavtrykk. Studien viste at opplæring av ett enkelt stort Transformer-basert nevralt nettverk, bygget opp ved hjelp av NAS - et verktøy som ofte brukes i maskinoversettelse - genererte rundt 626 000 pund karbondioksid.

Dette tilsvarer omtrent gassutslippene fra fem biler i løpet av deres levetid.

Carlos Gómez-Rodríguez, informatiker ved Universitetet i A Coruña i Spania, kommenterte studien slik: "Selv om mange av oss nok har tenkt på dette på et abstrakt, vagt nivå, viser tallene virkelig hvor stort problemet er", og la til: "Verken jeg eller andre forskere jeg har diskutert dem med, trodde miljøkonsekvensene var så store."

Energikostnadene ved å trene opp modellen er kun basiskostnader - den minste mengden arbeid som kreves for å få en modell i drift.

Som Emma Strubell, doktorgradskandidat ved University of Massachusetts, sier: "Å trene opp en enkelt modell er det minste arbeidet du kan gjøre."

MITs "en gang for alle"-tilnærming

Forskere ved MIT foreslo senere en løsning på dette problemet: den "En gang for alle"-tilnærming (OFA).

Forskerne beskrive problemet med konvensjonell opplæring av nevrale nettverk: "Det er ingeniør- og beregningsintensivt å designe spesialiserte DNN-er for hvert scenario, enten med menneskebaserte metoder eller NAS. Siden slike metoder må gjenta nettverksdesignprosessen og lære opp det designede nettverket fra bunnen av for hvert tilfelle, vokser totalkostnaden lineært etter hvert som antallet distribusjonsscenarioer øker, noe som vil føre til et for høyt energiforbruk og CO2-utslipp."

Med MITs OFA-paradigme trener forskerne opp et enkelt generelt nevralt nettverk som de kan lage ulike spesialiserte undernettverk ut fra. OFA-prosessen krever ikke ekstra opplæring for nye undernettverk, noe som reduserer de energikrevende GPU-timene som trengs for modellopplæring og reduserer CO2-utslippene.

I tillegg til miljøfordelene gir OFA-metoden betydelige ytelsesforbedringer. I interne tester viste det seg at modeller som ble laget ved hjelp av OFA-metoden, fungerte opptil 2,6 ganger raskere på edge-enheter (kompakte IoT-enheter) enn modeller som ble laget ved hjelp av NAS.

MITs OFA-tilnærming ble anerkjent på den fjerde Low Power Computer Vision Challenge i 2019 - et årlig arrangement i regi av IEEE som fremmer forskning på energieffektivisering av systemer for datasyn (CV).

MIT-teamet gikk helt til topps, og arrangørene roste dem: "Disse teamenes løsninger utkonkurrerer de beste løsningene i litteraturen."

Den 2023 Low Power Computer Vision Challenge mottar for øyeblikket bidrag frem til 4. august.

Skytjenestens rolle i AIs miljøpåvirkning

I tillegg til å trene opp modeller trenger utviklerne enorme skyressurser for å hoste og distribuere modellene sine.

Store teknologiselskaper som Microsoft og Google øker investeringene i skyressurser i løpet av 2023 for å håndtere den økende etterspørselen etter AI-relaterte produkter.

Cloud computing og tilhørende datasentre krever enorme ressurser. Fra og med 2016, foreslåtte estimater at datasentre over hele verden sto for mellom 11 og 3% av det globale strømforbruket, noe som tilsvarer energiforbruket til enkelte små nasjoner.

Datasentrenes vannfotavtrykk er også kolossalt. Store datasentre kan forbruke millioner av liter vann daglig.

I 2020 ble det rapportert at Googles datasentre i South Carolina fikk tillatelse til å bruke 549 millioner liter vannnesten dobbelt så mye som to år tidligere. Et datasenter på 15 megawatt kan forbruke opptil 360 000 liter vann daglig.

I 2022, Google avslørte at deres globale datasenterflåte forbrukte rundt 4,3 milliarder liter vann. De understreker imidlertid at vannkjøling er vesentlig mer effektivt enn andre teknikker.

Alle de store teknologiselskapene har lignende planer for å redusere ressursbruken, som for eksempel Google, som i 2017 nådde målet sitt om å matche 100% av energiforbruket sitt med innkjøp av fornybar energi.

Neste generasjons AI-maskinvare modellert etter den menneskelige hjerne

AI er enormt ressurskrevende, men hjernen vår bruker bare 12 watt effekt - kan en slik energieffektivitet gjenskapes i AI-teknologi?

Selv en stasjonær datamaskin bruker mer enn 10 ganger så mye strøm som den menneskelige hjernen, og kraftige AI-modeller krever millioner av ganger mer strøm. Å bygge AI-teknologi som kan gjenskape effektiviteten til biologiske systemer, vil forandre bransjen fullstendig.

For å være rettferdig overfor AI tar ikke denne sammenligningen hensyn til det faktum at menneskehjernen har blitt "trent" gjennom millioner av år med evolusjon. I tillegg utmerker AI-systemer og biologiske hjerner seg med forskjellige oppgaver.

Hvis man likevel bygger AI-maskinvare som kan behandle informasjon med samme energiforbruk som biologiske hjerner, vil det muliggjøre autonome biologisk inspirerte AI-er som ikke er koblet til store strømkilder.

I 2022 ble et team av forskere fra Indian Institute of Technology i Bombay, kunngjorde utviklingen av en ny AI-brikke som er modellert etter den menneskelige hjerne. Brikken fungerer med spiking nevrale nettverk (SNN), som etterligner den nevrale signalbehandlingen i biologiske hjerner.

Hjernen består av 100 milliarder små nevroner som er koblet til tusenvis av andre nevroner via synapser, og som overfører informasjon gjennom koordinerte mønstre av elektriske spikes. Forskerne bygde kunstige nevroner med ultralav energi, og utstyrte SNN-er med bånd-til-bånd-tunnelstrøm (BTBT).

"Med BTBT lader kvantetunnelstrømmen opp kondensatoren med ultralav strøm, noe som betyr at det kreves mindre energi", forklarer Udayan Ganguly fra forskerteamet.

Ifølge professor Ganguly oppnår deres metode "5000 ganger lavere energi per spike på et tilsvarende område og 10 ganger lavere standby-strøm på et tilsvarende område og med tilsvarende energi per spike", sammenlignet med eksisterende toppmoderne nevroner som er implementert i SNN-er i maskinvare.

Forskerne demonstrerte tilnærmingen i en talegjenkjenningsmodell inspirert av hjernens auditive cortex. SNN kan forbedre bruksområder på kompakte enheter som mobiltelefoner og IoT-sensorer.

Teamet har som mål å utvikle en "nevrosynaptisk kjerne med ekstremt lavt strømforbruk og en læringsmekanisme i sanntid på chipen, noe som er nøkkelen til autonome biologisk inspirerte nevrale nettverk".

AIs miljøpåvirkning blir ofte oversett, men ved å løse problemer som strømforbruket til AI-brikker kan man også åpne opp for nye muligheter for innovasjon.

Hvis forskerne kan modellere AI-teknologien etter biologiske systemer, som er svært energieffektive, vil dette gjøre det mulig å utvikle autonome AI-systemer som ikke er avhengige av rikelig strømforsyning og datasentertilkobling.