L'IA ruota attorno ai dati, ma da dove provengono? Gli insiemi di dati sono legali ed etici? Come fanno gli sviluppatori a stabilirlo con certezza?

L'addestramento di modelli di apprendimento automatico come i modelli linguistici di grandi dimensioni (LLM) richiede grandi volumi di dati testuali.

Esistono pile di set di dati disponibili su piattaforme come Kaggle, GitHub e Hugging Face, ma si trovano in una zona grigia dal punto di vista legale ed etico, soprattutto a causa di problemi legati alle licenze e al fair use.

Il Iniziativa sulla provenienza dei dati, uno sforzo collaborativo tra ricercatori di IA e professionisti del settore legale, ha esaminato migliaia di set di dati per far luce sulle loro vere origini.

Esso si è concentrato su oltre 1.800 set di dati disponibili su piattaforme come Hugging Face, GitHub e Papers With Code. I set di dati sono stati concepiti principalmente per la messa a punto di modelli open-source come Llama-2.

Lo studio ha rivelato che circa 70% di questi set di dati mancavano di informazioni chiare sulle licenze o erano etichettati con licenze troppo permissive.

Con un'evidente mancanza di chiarezza sulle restrizioni al copyright e all'uso commerciale, gli sviluppatori di IA rischiano di infrangere accidentalmente la legge o di violare il copyright.

Shayne Longpre, dottorando presso il MIT Media Lab che ha guidato l'audit, ha sottolineato che il problema non è imputabile alle piattaforme di hosting, ma piuttosto a un problema sistemico all'interno della comunità del machine-learning.

Il 2023 ha visto un diluvio di cause legali che si rivolge ai principali sviluppatori di IA come Meta, Anthropic e OpenAI, che sono sottoposti a forti pressioni per adottare pratiche di raccolta dei dati più trasparenti. Regolamenti, come il Legge sull'intelligenza artificiale dell'UEsono impostati per applicare proprio questo.

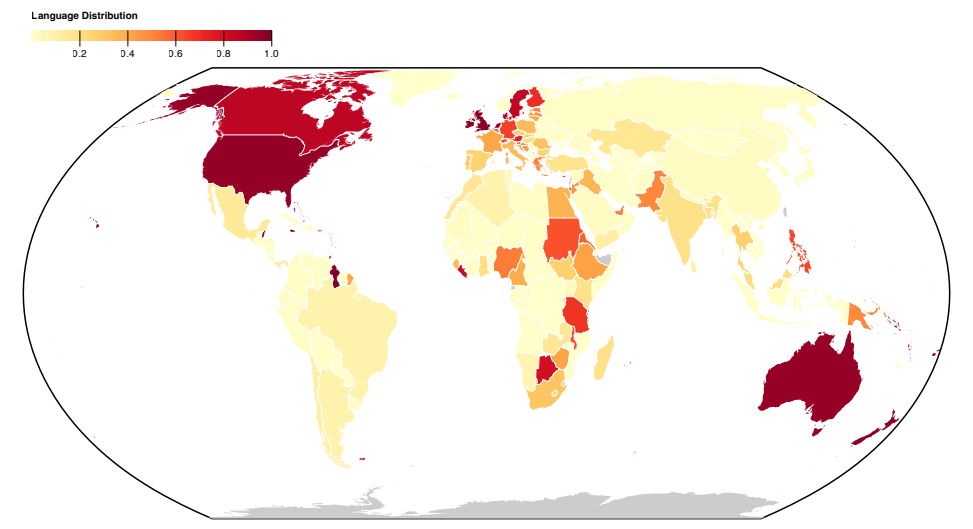

La Data Provenance Initiative consente agli sviluppatori di apprendimento automatico di esplora i set di dati controllati qui. L'iniziativa analizza anche i modelli all'interno delle serie di dati, facendo luce sulle loro origini geografiche e istituzionali.

La maggior parte dei set di dati è costruita nel Nord globale di lingua inglese, evidenziando gli squilibri socioculturali.

Per saperne di più sullo studio

Questa analisi su larga scala dei set di dati ha evidenziato problemi sistematici nelle modalità di raccolta e distribuzione dei dati. L'iniziativa ha anche prodotto un documento per spiegare i risultati ottenuti, pubblicato qui.

Ecco ulteriori informazioni sui metodi e sui risultati dello studio:

- Analisi di insiemi di dati per l'origine e l'etichettatura: Questo studio ha controllato sistematicamente oltre 1800 set di dati di fine-tuning per esaminare la provenienza dei dati, le licenze e la documentazione.

- Prove di etichettatura errata: I risultati hanno evidenziato il divario tra i tipi di dati disponibili con licenze diverse e le implicazioni per le interpretazioni legali del copyright e del fair use. È emerso un alto tasso di errata classificazione delle licenze, con oltre 72% di set di dati che non specificano una licenza e un tasso di errore di 50% in quelli che lo fanno.

- Provenienza dei dati inaffidabile: La ricerca richiama l'attenzione sul problema della provenienza inaffidabile dei dati, sottolineando la necessità di standard per tracciare il percorso dei dati, garantire una corretta attribuzione e incoraggiare un uso responsabile dei dati.

- Distribuzione geografica: Lo studio evidenzia una grave mancanza di rappresentazione e di attribuzione per i dataset provenienti dal Sud globale. La maggior parte dei dataset ruota attorno alla lingua inglese ed è culturalmente legata all'Europa, al Nord America e all'Oceania anglofona.

Questo studio evidenzia problemi sistemici e strutturali nelle modalità di creazione, distribuzione e utilizzo dei dati. I dati sono una risorsa fondamentale per l'IA e, come le risorse naturali, sono limitati.

C'è il timore che la tecnologia AI finisca per superare gli attuali set di dati e forse addirittura inizia a consumare la propria produzioneCiò significa che i modelli di intelligenza artificiale impareranno dal testo generato dall'intelligenza artificiale.

Questo potrebbe erodere la qualità dei modelli, il che significa che i dati di alta qualità, etici e legali potrebbero diventare davvero molto preziosi.