I dati sono la linfa vitale dell'intelligenza artificiale, ma non sono una risorsa infinita. L'umanità può esaurire i dati? Cosa accadrebbe se lo facessimo?

I modelli complessi di intelligenza artificiale richiedono grandi quantità di dati di addestramento. Ad esempio, l'addestramento di un modello linguistico di grandi dimensioni (LLM) come ChatGPT richiede circa 10 trilioni di parole.

Alcuni esperti ritengono che la disponibilità di dati di alta qualità stia diminuendo. Ad esempio, uno studio del 2022 condotto da ricercatori di diverse università dichiarato, "La nostra analisi indica che lo stock di dati linguistici di alta qualità si esaurirà presto, probabilmente prima del 2026... Il nostro lavoro suggerisce che l'attuale tendenza alla crescita costante dei modelli di ML che si basano su enormi set di dati potrebbe rallentare se non si migliora drasticamente l'efficienza dei dati o se non si rendono disponibili nuove fonti di dati."

La generazione di dati sintetici rappresenta una soluzione, ma in genere non riesce a cogliere la profondità, le sfumature e la varianza dei dati reali.

A complicare ulteriormente la situazione, c'è la preoccupazione per ciò che accadrà quando l'IA inizierà a consumare la propria produzione, cosa che i ricercatori dell'École Polytechnique Fédérale de Lausanne (EPFL) in Svizzera ritengono essere già in atto.

La ricerca indica che le aziende di IA che acquistano dati prodotti dall'uomo attraverso piattaforme come Amazon Mechanical Turk possono ricevere invece dati generati dall'IA.

Cosa succede quando l'intelligenza artificiale inizia a mangiare la propria produzione? È possibile evitarlo?

Costruire set di dati è costoso e richiede tempo, e la posta in gioco è alta

I dati sono onnipresenti, ma la loro gestione per l'IA è un processo complesso. La qualità dei dati e delle etichette influisce sulle prestazioni del modello: è un caso di "spazzatura dentro, spazzatura fuori".

Per descrivere brevemente il processo di costruzione dei dataset, gli annotatori di dati (o etichettatori) prendono i dati elaborati (ad esempio, un'immagine ritagliata) e li etichettano. caratteristiche (ad esempio, un'automobile, una persona, un uccello).

Questo fornisce agli algoritmi un "obiettivo" da cui apprendere. Gli algoritmi estraggono e analizzano le caratteristiche dei dati etichettati per prevedere tali caratteristiche in nuovi dati non visti.

Questo è necessario per l'apprendimento automatico supervisionato, che è uno dei rami principali dell'apprendimento automatico insieme all'apprendimento automatico non supervisionato e all'apprendimento per rinforzo. Da alcune stimeIl processo di preparazione ed etichettatura dei dati occupa l'80% della durata di un progetto di modello di apprendimento automatico, ma se si prendono troppe scorciatoie si rischia di compromettere le prestazioni del modello.

Oltre alle sfide pratiche legate alla creazione di set di dati di alta qualità, la natura stessa dei dati cambia costantemente. Quello che 10 anni fa si definiva un "set di dati contenente una selezione tipica di veicoli in circolazione" oggi non è più lo stesso. Oggi, ad esempio, il numero di eScooter ed eBike in circolazione è molto più elevato.

Si tratta dei cosiddetti "casi limite", ovvero oggetti o fenomeni rari non presenti negli insiemi di dati.

I modelli riflettono la qualità dei loro set di dati

Se si addestra un moderno sistema di intelligenza artificiale su un vecchio set di dati, il modello rischia di avere prestazioni ridotte quando viene esposto a dati nuovi e sconosciuti.

Tra il 2015 e il 2020, i ricercatori hanno scoperto importanti distorsioni strutturali negli algoritmi di IA, in parte attribuite all'addestramento dei modelli su dati vecchi e distorti.

Ad esempio, il Volti etichettati nella casa selvaggia (LFW), un set di dati di volti di celebrità comunemente utilizzati in compiti di riconoscimento facciale, è composto da 77,5% maschi e 83,5% con pelle bianca individui. Un'intelligenza artificiale non ha alcuna speranza di funzionare correttamente se i dati non rappresentano tutte le persone che intende servire. I tassi di errore nel riconoscimento facciale tra i migliori algoritmi sono stati trovati a un livello minimo di 0,8% per gli uomini bianchi e a un livello massimo di 34,7% per le donne con la pelle scura.

Questa ricerca è culminata nella storica Studio sulle sfumature di genere e un documentario intitolato Bias codificatoche ha analizzato come l'intelligenza artificiale possa apprendere da dati errati e non rappresentativi.

Gli impatti sono tutt'altro che positivi: ciò ha portato a esiti giudiziari errati, a false incarcerazioni e alla negazione del lavoro e del credito a donne e altri gruppi.

Le IA hanno bisogno di più dati di alta qualità, che devono essere equi e rappresentativi. - è una combinazione sfuggente.

I dati sintetici sono la risposta?

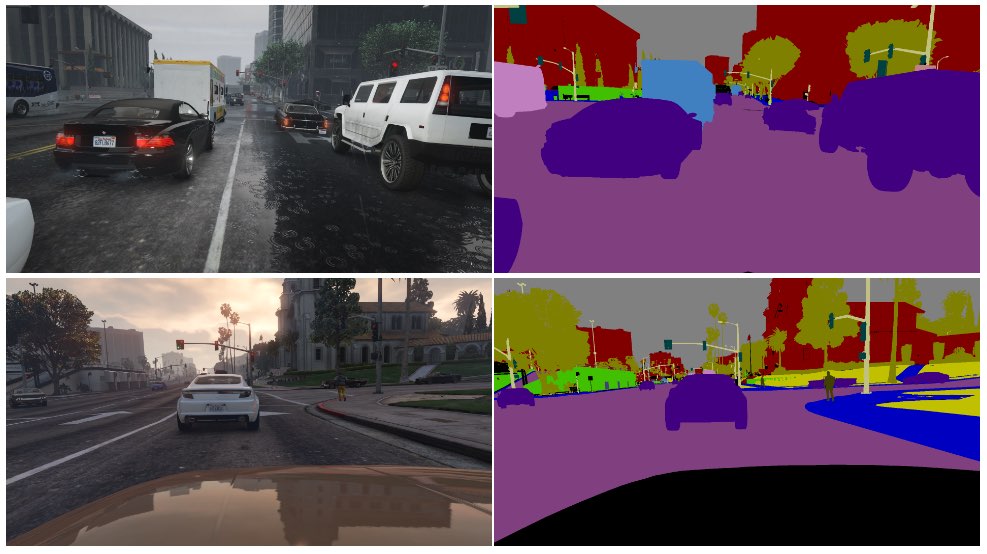

I dati sintetici sono comunemente utilizzati nella computer vision (CV), dove le IA identificano oggetti e caratteristiche da immagini e video.

Invece di raccogliere dati di immagine dal mondo reale, come fotografare o filmare una strada, operazione tecnicamente impegnativa e che pone problemi di privacy, è sufficiente generare i dati in un ambiente virtuale.

Sebbene questo integri le IA con un maggior numero di dati, ci sono diversi svantaggi:

- Modellare scenari reali in un ambiente virtuale non è semplice.

- La generazione di grandi quantità di dati sintetici è ancora costosa e richiede tempo.

- I casi limite e gli outlier rimangono un problema.

- Non può replicare perfettamente la realtà.

- D'altra parte, alcuni aspetti potrebbero essere troppo perfetti ed è difficile stabilire cosa manca.

In definitiva, i dati sintetici sono eccellenti per gli ambienti prontamente virtualizzati, come il pavimento di una fabbrica, ma non sono sempre sufficienti per gli ambienti reali in rapido movimento, come le strade di una città.

Che dire della generazione di dati testuali sintetici?

Il testo è più semplice dei dati di immagini o video, quindi i modelli come ChatGPT possono essere utilizzati per generare dati di addestramento sintetici quasi infiniti?

Sì, ma è rischioso e gli impatti non sono facili da prevedere. Sebbene i dati di testo sintetici possano aiutare a sintonizzare, testare e ottimizzare i modelli, non sono l'ideale per insegnare ai modelli nuove conoscenze e potrebbero creare pregiudizi e altri problemi.

Ecco un'analogia del perché l'addestramento delle IA con i dati generati dalle IA è problematico:

- Considerate una scuola che utilizza tutti i migliori libri di testo del mondo per formare i suoi studenti con tutto ciò che c'è da sapere dalle sue risorse nello spazio di un giorno.

- In seguito, la scuola inizia a produrre il proprio lavoro sulla base delle conoscenze acquisite, in modo analogo all'output di un chatbot. Gli studenti hanno imparato da tutti i dati disponibili fino alla data di inizio dell'addestramento, ma in seguito non possono introdurre in modo efficiente nuovi dati nel sistema di conoscenza.

- La conoscenza viene creata ogni giorno - mentre la maggior parte della conoscenza umana è stata creata prima di un giorno specifico, la conoscenza si evolve e si trasforma nel tempo. È fondamentale che gli esseri umani non si limitino a creare costantemente nuove conoscenze, ma cambino anche la loro prospettiva sulle conoscenze esistenti.

- Ora, supponiamo che la scuola, esauriti i dati, inizi a insegnare ai suoi studenti utilizzando i suoi stessi risultati. Gli studenti iniziano a "mangiare" i loro contenuti per produrne di nuovi.

- A quel punto, i risultati degli studenti non si adattano al mondo reale e la loro utilità diminuisce. Il sistema rigurgita il proprio lavoro. Sebbene il lavoro possa adattarsi ed evolversi, lo fa in modo isolato da qualsiasi cosa al di fuori del ciclo di feedback.

L'intelligenza artificiale mette costantemente le persone di fronte a enigmi da risolvere e questo ha un sacco di commentatori su Reddit e il Forum di Y Combinator perplesso.

Si tratta di cose sconvolgenti e non c'è un vero e proprio consenso sulle ramificazioni.

Gli etichettatori di dati umani spesso utilizzano l'intelligenza artificiale per produrre i dati.

Il problema della produzione di dati di addestramento di qualità presenta un altro livello imprevisto.

Piattaforme di crowdworking come Amazon Mechanical Turk (MTurk) sono regolarmente utilizzati dalle aziende di IA che cercano di produrre insiemi di dati autenticamente "umani". TSi teme che gli annotatori di dati su queste piattaforme utilizzino le IA per portare a termine i loro compiti.

I ricercatori dell'École Polytechnique Fédérale de Lausanne (EPFL) in Svizzera hanno analizzato i dati creati attraverso MTurk per verificare se i lavoratori utilizzassero l'IA per generare le loro proposte.

Lo studiopubblicato il 13 giugno, ha arruolato 44 partecipanti a MTurk per riassumere gli abstract di 16 articoli di ricerca medica. È emerso che da 33% a 46% degli utenti della piattaforma hanno generato i loro contributi con l'intelligenza artificiale, nonostante fosse stato chiesto loro di rispondere con il linguaggio naturale.

"Abbiamo sviluppato una metodologia molto specifica che ha funzionato molto bene per individuare il testo sintetico nel nostro scenario", spiega Manoel Ribeiro, coautore dello studio e dottorando all'EPFL, ha dichiarato a The Register questa settimana.

Sebbene il set di dati e la dimensione del campione dello studio siano piuttosto ridotti, è tutt'altro che inconcepibile pensare che le IA vengano addestrate inconsapevolmente su contenuti generati dalle IA.

Lo studio non intende incolpare i lavoratori di MTurk: i ricercatori fanno notare che i salari bassi e il lavoro ripetitivo contribuiscono al problema. Le aziende che si occupano di IA vogliono dati di alta qualità creati dall'uomo, mantenendo al contempo bassi i costi. Un commentatore ha dichiarato su Reddit: "Attualmente sono uno di questi lavoratori, incaricato di addestrare Bard. Sono sicuro di usare ChatGPT per questo. 20$/ora non sono sufficienti per il trattamento orribile che riceviamo, quindi spremerò ogni centesimo da questo lavoro *******".

La tana del coniglio diventa ancora più profonda, poiché le IA sono spesso addestrate su dati estrapolati da Internet. Con la pubblicazione online di un numero sempre maggiore di contenuti scritti dall'IA, quest'ultima imparerà inevitabilmente dai suoi stessi risultati.

Poiché gli esseri umani iniziano a dipendere dalle IA per ottenere informazioni, la qualità dei loro risultati diventa sempre più critica. Dobbiamo trovare metodi innovativi per aggiornare le IA con dati freschi e autentici.

Come dice Ribeiro, "i dati umani sono il gold standard, perché sono gli esseri umani che ci interessano, non i grandi modelli linguistici".

Il lavoro di analisi dell'impatto potenziale dell'IA che consuma i propri risultati è in corso, ma i dati umani autentici rimangono fondamentali per un'ampia gamma di attività di apprendimento automatico.

Generare grandi quantità di dati per le IA affamate e allo stesso tempo navigare tra i rischi è un lavoro in corso.