I nostri pensieri possono essere il nostro luogo più intimo, ma non sono fuori dai confini dell'intelligenza artificiale.

L'intelligenza artificiale che legge la mente sembra la trama di un romanzo di fantascienza, eppure è molto promettente per le persone che non possono comunicare a causa di paralisi o lesioni cerebrali.

Inoltre, l'accesso dell'intelligenza artificiale al cervello ci permetterebbe di scrivere, creare e progettare con i soli pensieri o di fornire ad altri finestre sulla nostra coscienza.

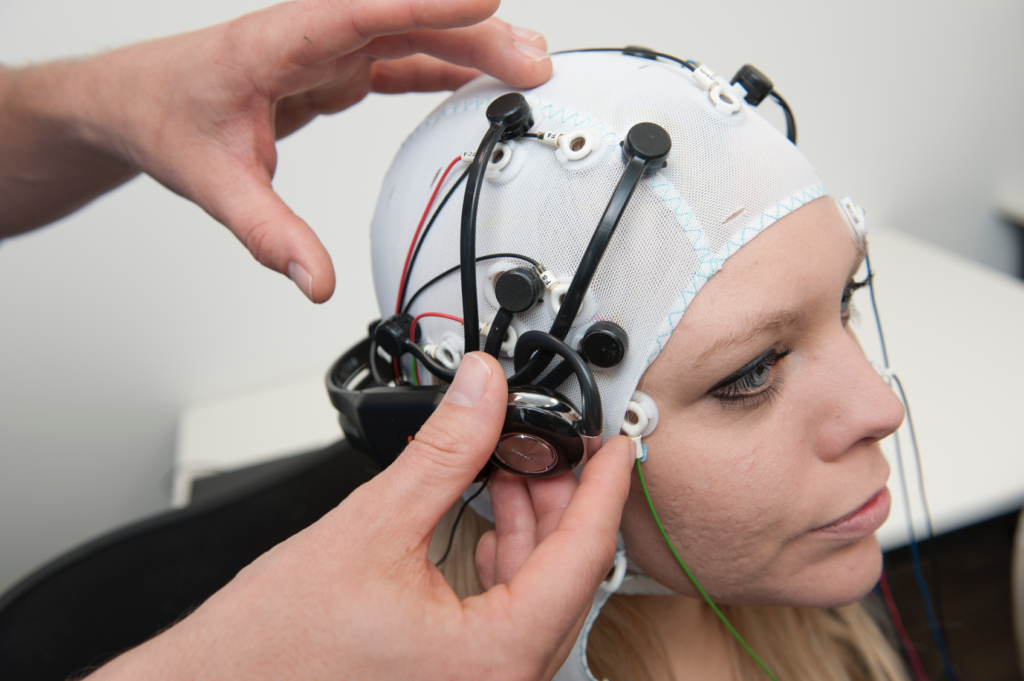

Per quasi un decennio, la tecnologia dell'elettroencefalogramma (EEG), che cattura i segnali elettrici tramite elettrodi sul cuoio capelluto, ha supportato coloro che soffrono di ictus gravi e della sindrome di blocco totale (CLIP), una condizione in cui una persona è cosciente ma immobile.

Nel 2014, un malato italiano di sclerosi laterale amiotrofica (SLA), Anselmo Paglialonga, ha utilizzato una cuffie integrate nell'apprendimento automatico di comunicare utilizzando risposte affermative o negative, nonostante l'impossibilità di muovere un muscolo. Alcune persone affette dalla malattia possono muovere piccoli muscoli, come Stephen Hawking, che è riuscito a contrarre il muscolo della guancia.

Con il progredire dell'IA, i ricercatori stanno colmando il divario dalla semplice interpretazione dei segnali alla traduzione di pensieri complessi nella loro interezza.

Col tempo, le persone potrebbero essere in grado di parlare e comunicare senza muovere un muscolo, letteralmente grazie alla forza del pensiero.

Questa stessa tecnologia potrebbe permetterci di controllare macchine complesse usando il nostro cervello, di comporre musica immaginando una melodia o di dipingere e disegnare evocando immagini con la mente. Potremmo persino "registrare" i nostri sogni dalle onde cerebrali e riprodurli in seguito.

In un futuro non troppo lontano, l'intelligenza artificiale che legge la mente potrebbe essere usata per leggere con la forza i ricordi di qualcuno, ad esempio per verificare la sua testimonianza di un crimine.

Gli hacker potrebbero persino ingannare brevemente l'utente per fargli immaginare le sue informazioni personali, estraendo una copia dei suoi pensieri dal suo cervello. I regimi totalitari potrebbero eseguire test di routine sui cittadini per monitorare i pensieri divergenti.

Inoltre, con la capacità di convertire i pensieri in una realtà computerizzata, gli esseri umani potrebbero trascorrere la loro vita in una scatola di sabbia onirica dove possono plasmare la loro realtà a piacimento.

Al momento, tali applicazioni sembrano surreali e fantastiche, ma diversi esperimenti recenti hanno gettato le basi per un futuro in cui il cervello sarà accessibile all'intelligenza artificiale.

L'intelligenza artificiale per leggere la mente

Allora, come è possibile tutto questo?

Per tradurre l'attività cerebrale in un risultato utilizzabile che possa essere trasmesso a un computer, è necessario innanzitutto effettuare misurazioni accurate.

Questo è il primo ostacolo, poiché il cervello è misterioso quanto le più lontane regioni dello spazio o gli oceani più profondi. C'è poco consenso su come l'attività neuronica produca pensieri complessi, per non parlare della coscienza.

Il cervello umano - e altri sistemi nervosi in natura - ospita miliardi di neuroni, la maggior parte dei quali si attiva da 5 a 100 volte al secondo. Nel cervello umano, ogni secondo di pensiero coinvolge trilioni di azioni neuroniche individuali.

Misurare l'attività neuronica a livello granulare è il santo graal delle neuroscienze, ma al momento non è possibile, soprattutto con tecniche non invasive.

Attualmente, le misurazioni del cervello sono più olistiche, ricavate dal movimento del sangue o dagli scambi di segnali elettrici. Esistono tre metodi consolidati per misurare l'attività cerebrale:

- La magnetoencefalografia (MEG) cattura i campi magnetici generati dall'attività elettrica del cervello e fornisce informazioni sull'attività neuronale in tempo reale.

- Elettroencefalogramma (EEG) per l'interpretazione dell'attività elettrica.

- La risonanza magnetica, che misura l'attività cerebrale attraverso la misurazione del flusso sanguigno.

L'apprendimento automatico (ML) e l'IA si sono fusi con tutte e tre le tecnologie per migliorare l'analisi di segnali complessi.

L'obiettivo finale è quello di associare attività cerebrali specifiche a pensieri distinti, che possono includere una parola, un'immagine o qualcosa di più semantico e astratto.

Le tecnologie in grado di ricavare misure dal cervello e di trasmetterle ai computer sono chiamate interfacce cervello-computer (BCI).

Ecco il processo di base di come funziona:

- Presentazione dello stimolo: I partecipanti sono esposti a vari stimoli. Possono essere immagini, suoni o anche sensazioni tattili. L'attività cerebrale viene registrata durante l'esposizione, in genere mediante EEG o risonanza magnetica.

- Raccolta dati: Le risposte del cervello a questi stimoli vengono registrate in tempo reale. Questi dati diventano una ricca fonte di informazioni su come i diversi stimoli influenzano l'attività cerebrale.

- Pre-elaborazione: I dati cerebrali grezzi sono spesso rumorosi. Prima di poter essere utilizzati, devono essere puliti e standardizzati. Ciò può comportare la rimozione degli artefatti, la normalizzazione dei segnali o l'allineamento dei punti di dati.

- Apprendimento automatico: Con i dati elaborati, vengono introdotti modelli di apprendimento automatico. Questi modelli vengono addestrati per trovare modelli o correlazioni tra i dati cerebrali e lo stimolo corrispondente. In sostanza, l'intelligenza artificiale agisce come un interprete, decifrando il "linguaggio" del cervello.

- Formazione del modello: Si tratta di un processo iterativo. Più il modello è esposto ai dati, più diventa bravo a fare previsioni o a generare output. Questa fase può richiedere molto tempo e potenza di calcolo.

- Convalida: Una volta addestrato, l'accuratezza del modello viene testata. Di solito questo avviene presentando nuovi stimoli ai partecipanti, registrando la loro attività cerebrale e quindi utilizzando il modello per prevedere o generare un risultato basato su questi nuovi dati.

- Feedback e perfezionamento: Sulla base dei risultati della convalida, i ricercatori modificano e perfezionano il modello, iterando fino a raggiungere la migliore precisione possibile.

- Applicazione: Una volta convalidata, l'applicazione viene utilizzata per lo scopo previsto, che si tratti di aiutare un individuo paralizzato a comunicare, di generare immagini dai pensieri o di qualsiasi altra applicazione.

I metodi di intelligenza artificiale si sono evoluti rapidamente negli ultimi due anni, consentendo ai ricercatori di lavorare con dati cerebrali complessi e rumorosi per estrarre pensieri transitori e convertirli in qualcosa con cui un computer possa lavorare.

Ad esempio, un Progetto 2022 Meta ha sfruttato i dati MEG ed EEG di 169 persone per addestrare un'intelligenza artificiale a riconoscere le parole udite da un elenco predeterminato di 793 parole. L'intelligenza artificiale è stata in grado di generare un elenco di 10 parole contenente la parola selezionata nel 73% dei casi, dimostrando che l'intelligenza artificiale è in grado di "leggere nel pensiero", anche se con una precisione limitata.

Nel marzo 2023, i ricercatori hanno svelato un decodificatore AI rivoluzionario per trasformare l'attività cerebrale in flussi testuali continui.

L'intelligenza artificiale ha dimostrato un'accuratezza sorprendente, convertendo in testo le storie che le persone hanno ascoltato o immaginato utilizzando i dati della fMRI.

Il dottor Alexander Huth, dell'Università del Texas ad Austin, ha espresso stupore per l'efficienza del sistema, affermando: "Siamo rimasti un po' scioccati dal fatto che funzioni così bene. Ci ho lavorato per 15 anni... quindi è stato scioccante ed emozionante quando finalmente ha funzionato".

Lo studio ha integrato modelli linguistici di grandi dimensioni (LLM), in particolare GPT-1, un antenato di ChatGPT.

I volontari sono stati sottoposti a sessioni di fMRI di 16 ore mentre ascoltavano i podcast. I dati della risonanza magnetica sono stati utilizzati per addestrare un modello di apprendimento automatico (ML).

Successivamente, i partecipanti hanno ascoltato o immaginato nuove storie e l'intelligenza artificiale ha tradotto la loro attività cerebrale in testo. Circa 50% dei risultati erano vicini o esattamente allineati con il messaggio originale. Il dottor Huth ha spiegato: "Il nostro sistema lavora a livello di idee, semantica, significato... è la sostanza".

- Ad esempio, la frase "Non ho ancora la patente" è stata decodificata come "Non ha ancora iniziato a imparare a guidare".

- Un altro estratto: "Non sapevo se urlare, piangere o scappare. Invece ho detto: 'Lasciami in pace!'" è diventato "Ho iniziato a urlare e a piangere, e poi lei ha detto solo: 'Ti ho detto di lasciarmi in pace'".

Il modello è stato applicato anche alle onde cerebrali generate da partecipanti che guardavano film muti.

Quando i partecipanti ascoltavano una particolare storia, l'interpretazione dell'IA rispecchiava il sentimento generale della storia. Questa tecnologia, se perfezionata, potrebbe permetterci di scrivere storie usando solo i pensieri.

Non riuscite a iniziare un romanzo o un progetto di scrittura? Basta sdraiarsi e immaginare lo svolgimento della trama. L'intelligenza artificiale la scriverà per voi.

Utilizzo dell'intelligenza artificiale per generare immagini dal pensiero

L'intelligenza artificiale può convertire l'attività cerebrale in parole e concetti semantici, ma che dire delle immagini o della musica?

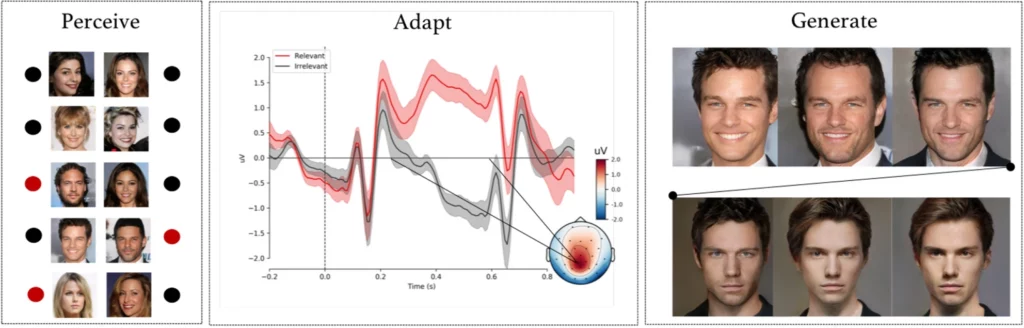

A esperimento complesso di ricercatori dell'Università di Helsinki, Helsinki, Finlandia, ha fatto osservare ai soggetti immagini facciali generate dall'intelligenza artificiale mentre venivano registrati i loro segnali EEG.

Dopo aver utilizzato questi dati per addestrare un modello di intelligenza artificiale, i partecipanti sono stati incaricati di identificare volti specifici da un elenco. Questi segnali sono diventati essenzialmente una finestra sulle percezioni e sulle intenzioni dei partecipanti.

Il modello di intelligenza artificiale ha interpretato se il partecipante ha riconosciuto un determinato volto in base ai segnali EEG registrati.

Nella fase successiva, i segnali EEG sono stati utilizzati per adattare e modellare una rete generativa avversaria (GAN), un modello utilizzato in alcune IA generative.

Questo ha permesso al sistema di produrre nuove immagini di volti allineati con l'intento originale dell'utente.

Come ha osservato Michiel Spapé, coautore dello studio, "la tecnica non riconosce i pensieri, ma risponde alle associazioni che abbiamo con le categorie mentali".

In parole povere, se qualcuno pensava a un "volto anziano", il sistema informatico poteva generare un'immagine di una persona anziana che corrispondeva perfettamente al pensiero del partecipante, grazie al feedback dei suoi segnali cerebrali.

Disegnare con il pensiero di potenza

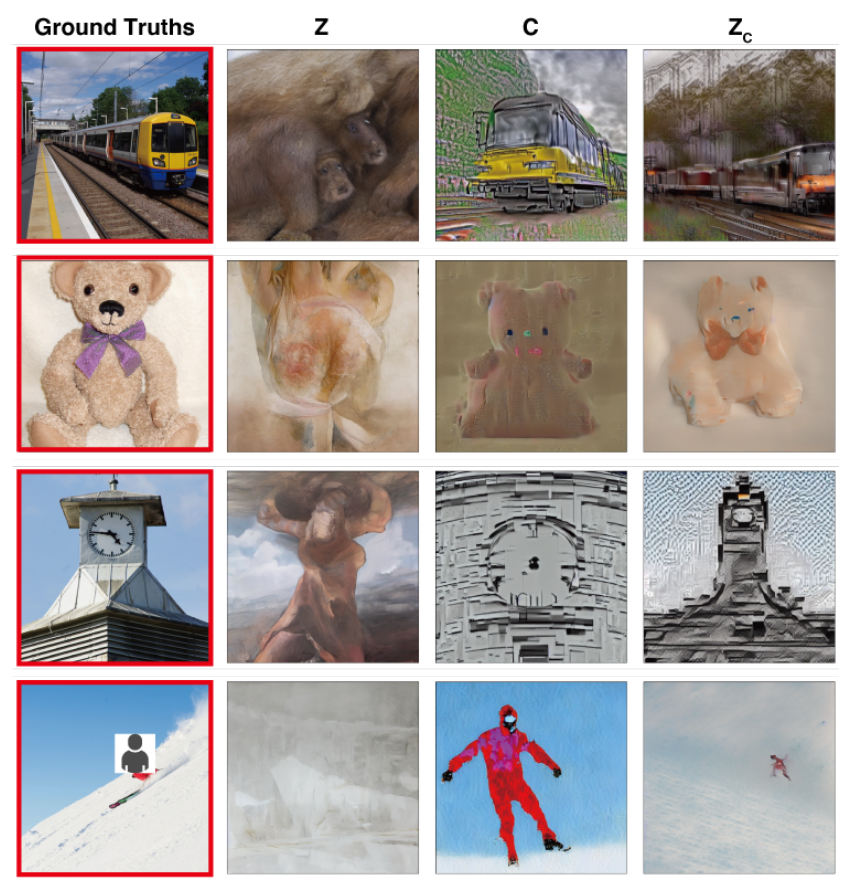

In un studio con obiettivi similiGli scienziati dell'Università di Osaka, in Giappone, hanno sperimentato una tecnica per tradurre i complessi segnali cerebrali in immagini ad alta risoluzione con risultati notevoli.

Il metodo utilizza un modello di Diffusione Stabile, una forma specializzata di rete neurale progettata per la generazione di immagini. Stable Diffusion è stato sviluppato con l'assistenza e il finanziamento di Stability AI.

I pensieri vengono catturati con la fMRI e passati in un modello di diffusione stabile, che li trasforma in immagini attraverso un complesso processo a più stadi che prevede diversi livelli di affinamento.

A differenza degli studi precedenti, questi metodi hanno richiesto una messa a punto minima del modello. Tuttavia, i partecipanti dovevano trascorrere molte ore all'interno delle macchine per la risonanza magnetica.

Si tratta di una sfida fondamentale, poiché la maggior parte di questi esperimenti prevede misurazioni rigorose e l'addestramento di modelli che richiedono tempo, costi e difficoltà per i partecipanti.

Tuttavia, in futuro non è escluso che le persone possano addestrare i propri modelli leggeri di lettura della mente e utilizzare i loro pensieri come input per vari usi, come progettare un edificio pensandolo o comporre un pezzo orchestrale evocandone le melodie.

Tradurre i pensieri in musica con l'intelligenza artificiale

Parole, immagini, musica: nulla è escluso dall'IA.

A 2023 studio fornisce approfondimenti sulla percezione del suono, con un grande potenziale nella progettazione di dispositivi di comunicazione per persone con problemi di linguaggio.

Robert Knight e il suo team dell'Università della California, Berkeley, hanno esaminato le registrazioni cerebrali provenienti da elettrodi posizionati chirurgicamente su 29 individui affetti da epilessia.

Mentre questi partecipanti ascoltavano "Another Brick in the Wall, Part 1" dei Pink Floyd, il team ha messo in relazione la loro attività cerebrale con elementi della canzone come l'intonazione, la melodia, l'armonia e il ritmo.

Utilizzando questi dati, i ricercatori hanno addestrato un modello di intelligenza artificiale, omettendo di proposito un segmento di canzone di 15 secondi. L'intelligenza artificiale ha quindi cercato di prevedere il segmento mancante sulla base dei segnali cerebrali, ottenendo una somiglianza dello spettrogramma di 43% con il segmento di canzone effettivo.

Knight e il suo team hanno individuato l'area del giro temporale superiore del cervello come essenziale per l'elaborazione del ritmo di chitarra della canzone. Hanno inoltre confermato le precedenti scoperte secondo cui l'emisfero destro svolge un ruolo più significativo nell'elaborazione della musica rispetto al sinistro.

Knight ritiene che questa comprensione più approfondita dell'interazione cervello-musica possa giovare ai dispositivi che aiutano le persone affette da disturbi del linguaggio, come la sclerosi laterale amiotrofica (SLA) e l'afasia.

Per le persone affette da sclerosi laterale amiotrofica [una patologia del sistema nervoso] o da afasia [una patologia del linguaggio], che faticano a parlare, vorremmo un dispositivo che suoni davvero come se si stesse comunicando con qualcuno in modo umano. Capire come il cervello rappresenti gli elementi musicali del discorso, tra cui il tono e l'emozione, potrebbe far sì che questi dispositivi suonino meno robotici".

Ludovic Bellier, membro del team di ricerca, ipotizza che se l'intelligenza artificiale riuscisse a riprodurre la musica partendo dalla semplice immaginazione, potrebbe rivoluzionare la composizione musicale.

I produttori musicali potrebbero collegare il loro cervello a un software e comporre musica usando solo il pensiero, il tutto muovendo a malapena un muscolo.

Il prossimo passo: la lettura mentale dell'intelligenza artificiale in tempo reale

Queste tecnologie rientrano nell'ambito delle interfacce cervello-computer (BCI), che cercano di convertire i segnali cerebrali in una qualche forma di output.

Le BCI stanno già ripristinando la capacità di movimento e di deambulazione delle persone paralizzate, colmando il divario tra i componenti del sistema nervoso recisi.

Le interfacce cervello-computer sviluppate quest'anno includono un dispositivo che permette a un uomo paralizzato di muovere le gambe, impianti cerebrali sperimentali che ricollegano le parti danneggiate del cervello e del midollo spinale per ripristinare le sensazioni perdute, e una gamba meccanica che ha restituito il movimento a un amputato.

Sebbene questi casi d'uso iniziali siano estremamente promettenti, siamo ben lontani dal tradurre senza soluzione di continuità ogni sfumatura dei nostri pensieri in movimenti, immagini, discorsi o musica.

Uno dei vincoli principali è la necessità di disporre di enormi serie di dati per addestrare i sofisticati algoritmi che rendono possibili tali traduzioni.

I modelli di apprendimento automatico devono essere addestrati su molti scenari per prevedere o generare con precisione un'immagine specifica dall'attività cerebrale. Ciò comporta la raccolta di dati MRI o EEG mentre i partecipanti sono esposti a vari stimoli.

La qualità e la specificità dei risultati generati dipendono fortemente dalla ricchezza dei dati di addestramento. I partecipanti devono trascorrere ore negli scanner MRI per raccogliere dati specificamente rilevanti.

Inoltre, il cervello umano è incredibilmente unico. Ciò che significa felicità nel cervello di una persona potrebbe essere diverso in quello di un'altra. Ciò significa che i modelli devono essere ampiamente generali o personalizzati.

Le attività cerebrali cambiano rapidamente, anche in frazioni di secondo. Acquisire dati in tempo reale e ad alta risoluzione, garantendo al contempo il perfetto allineamento con lo stimolo esterno, è una sfida tecnica.

E non dimentichiamo le sfide etiche che comporta l'accesso al cervello di una persona.

La raccolta di dati sul cervello, soprattutto su larga scala, solleva importanti questioni etiche e di privacy. Come possiamo garantire che i dati non vengano utilizzati in modo improprio? Chi ha il diritto di accedere e interpretare i nostri pensieri più intimi?

In via provvisoria, sembra che queste sfide possano essere superate. In futuro, gli esseri umani potrebbero essere in grado di accedere a interfacce cervello-computer portatili e personalizzate che consentano loro di "collegarsi" a una miriade di dispositivi che facilitano azioni complesse attraverso la forza del pensiero.

Il modo in cui la società affronterebbe la diffusione di questa tecnologia, tuttavia, è molto discusso.