NVIDIA a publié Chat with RTX, une démo technique montrant comment les chatbots IA peuvent être exécutés localement sur les PC Windows à l'aide de ses GPU RTX.

L'approche standard de l'utilisation d'un chatbot d'IA consiste à utiliser une plateforme web telle que ChatGPT ou à exécuter des requêtes via une API, l'inférence se faisant sur des serveurs informatiques en nuage. Les inconvénients de cette approche sont les coûts, la latence et les problèmes de confidentialité liés au transfert de données personnelles ou d'entreprise dans les deux sens.

RTX de NVIDIA de GPU permet désormais d'exécuter un LLM localement sur votre PC Windows, même si vous n'êtes pas connecté à l'internet.

Chat with RTX permet aux utilisateurs de créer un chatbot personnalisé en utilisant soit Mistral ou Lama 2. Il utilise la génération augmentée par récupération (RAG) et le logiciel TensorRT-LLM de NVIDIA qui optimise l'inférence.

Vous pouvez diriger Chat with RTX vers un dossier de votre PC et lui poser des questions sur les fichiers contenus dans ce dossier. Il prend en charge différents formats de fichiers, notamment .txt, .pdf, .doc/.docx et .xml.

Comme le LLM analyse des fichiers stockés localement et que l'inférence se fait sur votre machine, il est très rapide et aucune de vos données n'est partagée sur des réseaux potentiellement non sécurisés.

Vous pouvez également lui demander l'URL d'une vidéo YouTube et lui poser des questions sur la vidéo. Cela nécessite un accès à l'internet, mais c'est un excellent moyen d'obtenir des réponses sans avoir à regarder une longue vidéo.

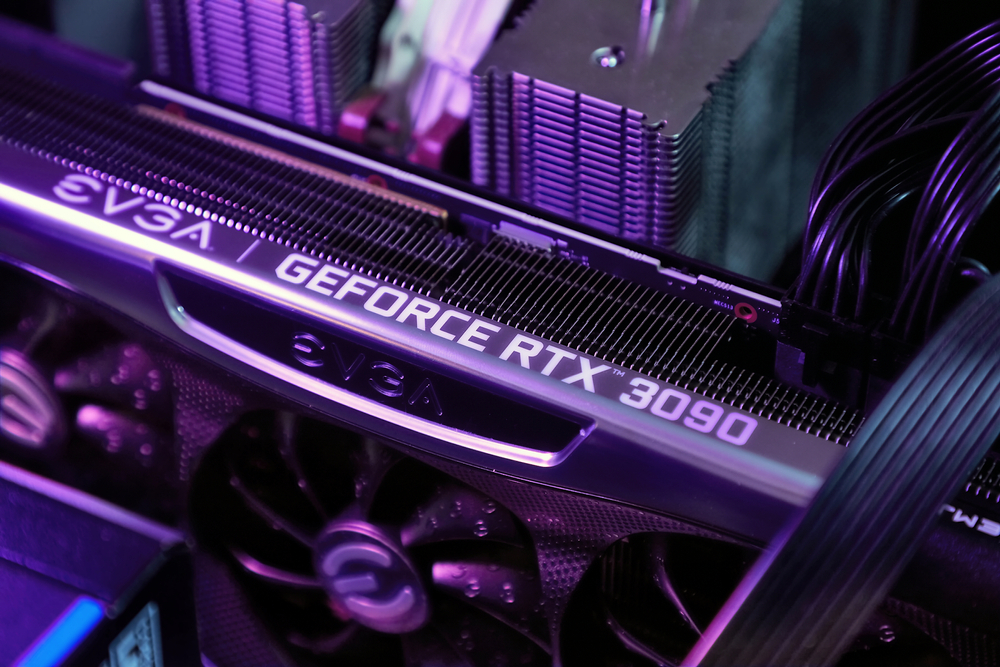

Vous pouvez télécharger Chat avec RTX gratuitement, mais vous devez utiliser Windows 10 ou 11 sur votre PC avec un GPU GeForce RTX 30 Series ou supérieur, avec un minimum de 8 Go de VRAM.

Chat with RTX est une démo, plutôt qu'un produit fini. Il est un peu bogué et ne se souvient pas du contexte, de sorte que vous ne pouvez pas lui poser de questions complémentaires. Mais c'est un bel exemple de la manière dont nous utiliserons les LLM à l'avenir.

L'utilisation locale d'un chatbot d'IA avec des coûts d'appel d'API nuls et une latence très faible est probablement la façon dont la plupart des utilisateurs interagiront finalement avec les LLM. L'approche open-source adoptée par des entreprises comme Meta permettra à l'IA sur l'appareil de favoriser l'adoption de leurs modèles gratuits plutôt que des modèles propriétaires comme GPT.

Cela dit, les utilisateurs d'ordinateurs portables et de téléphones mobiles devront encore attendre un peu avant que la puissance de calcul d'un GPU RTX puisse être intégrée dans des appareils plus petits.