Google a publié deux modèles de sa famille de modèles légers et ouverts appelés Gemma.

Alors que les modèles Gemini de Google sont des modèles propriétaires, ou fermés, les modèles Gemma ont été publiés en tant que "modèles ouverts" et mis gratuitement à la disposition des développeurs.

Google a publié les modèles Gemma en deux tailles, 2B et 7B paramètres, avec des variantes pré-entraînées et adaptées aux instructions pour chacun d'entre eux. Google publie les poids des modèles ainsi qu'une série d'outils permettant aux développeurs d'adapter les modèles à leurs besoins.

Google indique que les modèles Gemma ont été construits à l'aide de la même technologie que son modèle phare Gemini. Plusieurs entreprises ont publié des modèles 7B dans le but de proposer un LLM qui conserve des fonctionnalités utilisables tout en fonctionnant localement plutôt que dans le nuage.

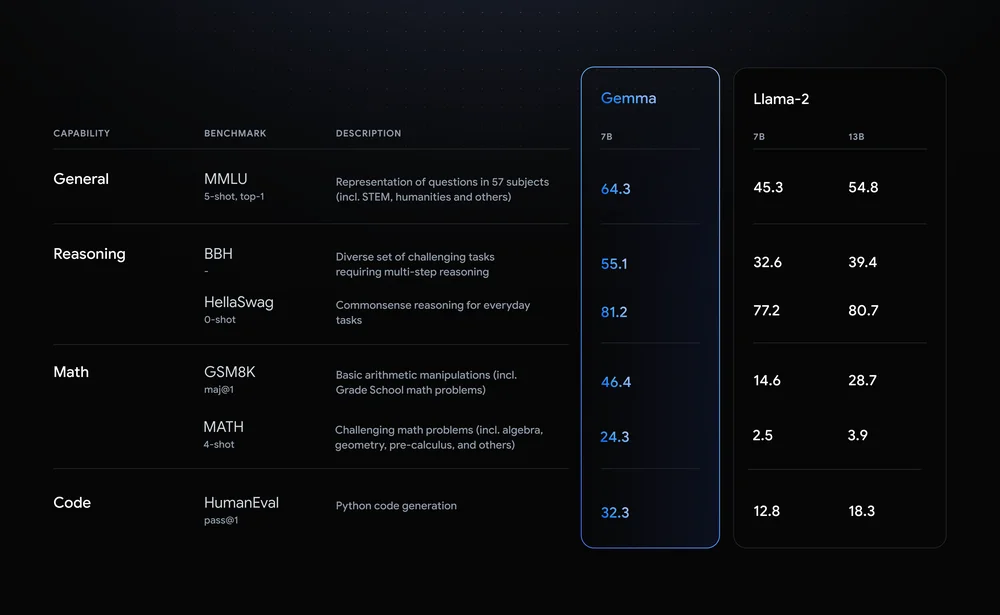

Llama-2-7B et Mistral-7B sont des concurrents notables dans ce domaine, mais Google affirme que "Gemma surpasse des modèles nettement plus grands sur des critères de référence clés", et propose cette comparaison de critères de référence comme preuve.

Les résultats de l'analyse comparative montrent que Gemma surpasse même la version 12B du Llama 2, plus grande, dans les quatre capacités.

Ce qui est vraiment intéressant avec Gemma, c'est la possibilité de l'exécuter localement. Google s'est associé à NVIDIA pour optimiser Gemma pour les GPU NVIDIA. Si vous disposez d'un PC équipé d'un GPU RTX de NVIDIA, vous pouvez faire tourner Gemma sur votre appareil.

NVIDIA déclare avoir installé plus de 100 millions de GPU NVIDIA RTX. Cela fait de Gemma une option attrayante pour les développeurs qui tentent de décider quel modèle léger utiliser comme base pour leurs produits.

NVIDIA ajoutera également la prise en charge de Gemma sur son site Web. Chat avec RTX ce qui facilite l'exécution des LLM sur les PC RTX.

Bien qu'il ne s'agisse pas techniquement d'un logiciel libre, seules les restrictions d'utilisation prévues dans l'accord de licence empêchent les modèles Gemma de posséder ce label. Les critiques des modèles ouverts Google affirme toutefois qu'il a procédé à des vérifications approfondies pour s'assurer que Gemma ne présentait aucun danger.

Google explique qu'il a eu recours à "un réglage fin approfondi et à l'apprentissage par renforcement à partir de commentaires humains (RLHF) pour aligner nos modèles réglés par instruction sur des comportements responsables". La société a également publié une boîte à outils d'IA générative responsable pour aider les développeurs à maintenir Gemma aligné après le réglage fin.

Les modèles légers personnalisables comme Gemma peuvent offrir aux développeurs une plus grande utilité que les modèles plus importants comme GPT-4 ou Gemini Pro. La possibilité d'exécuter des LLM localement sans le coût de l'informatique en nuage ou des appels d'API devient de plus en plus accessible.

Avec l'ouverture de Gemma aux développeurs, il sera intéressant de voir la gamme d'applications basées sur l'IA qui pourraient bientôt fonctionner sur nos PC.