Lorsque Google a annoncé la sortie de ses modèles Gemini, l'excitation était à son comble, car l'entreprise affirmait que ces modèles étaient à la hauteur des offres d'OpenAI. Ce n'est peut-être pas tout à fait vrai.

Google a déclaré que ses Gemini Ultra est meilleur que le modèle GPT-4. Le modèle n'ayant pas encore été commercialisé, nous devrons prendre les résultats de leurs tests de référence pour argent comptant. Gemini Pro a été publié et Google affirme qu'il est équivalent à GPT-3.5.

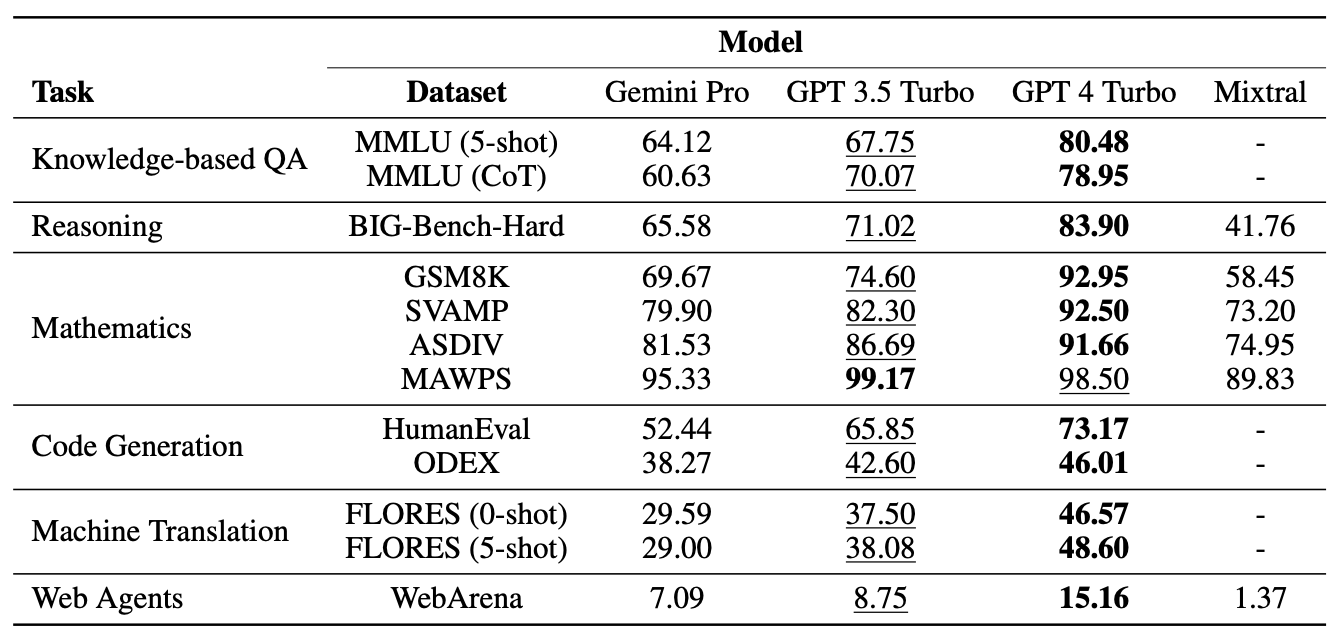

Des chercheurs de l'université Carnegie Mellon et de la plateforme logicielle d'IA BerriAI ont soumis Gemini Pro à une série de tâches pour tester ses capacités de compréhension et de génération de langage.

Ils ont effectué les mêmes tests en utilisant GPT-3.5 Turbo, GPT-4 Turbo et le nouveau système d'exploitation de Mistral AI, le Modèle Mixtral 8x7B.

Gemini de Google a récemment fait parler de lui en tant que concurrent majeur de GPT d'OpenAI. C'est passionnant ! Mais nous nous posons des questions :

Quelle est la qualité des Gémeaux ?

Au CMU, nous avons réalisé une étude impartiale, approfondie et reproductible comparant Gemini, GPT et Mixtral.

Papier : https://t.co/S3T7ediQLa

🧵 pic.twitter.com/NmEOeDd8pI- Graham Neubig (@gneubig) 19 décembre 2023

Résultats

Sans surprise, c'est le GPT-4 qui l'a emporté, mais Google sera moins enthousiaste à l'idée de voir comment Gemini Pro s'est comporté face au GPT 3.5 Turbo. Voici un résumé des résultats obtenus par l'équipe, le papier a déclaré : "Le modèle Pro de Gemini a atteint une précision comparable mais légèrement inférieure à celle de la version actuelle du GPT 3.5 Turbo d'OpenAI".

Voici un résumé des résultats.

Les modèles ont été guidés à l'aide de l'interface LiteLLM de BerriAI, chaque modèle recevant exactement les mêmes messages et le même protocole d'évaluation.

Les modèles ont été testés sur des questions à choix multiples, sur le raisonnement général, sur le raisonnement mathématique, sur la génération de codes, sur la traduction de langues et sur le rôle d'agent web.

L'une des raisons pour lesquelles Gemini Pro a obtenu de mauvais résultats aux questions à choix multiples est qu'il avait un fort biais de position. Il a souvent choisi la réponse en position D, qu'elle soit correcte ou non. Il est intéressant de noter qu'il s'agit là d'un phénomène que le logiciel Microsoft Medprompt se résout par un brassage.

Bien que perdant sur certains tests, Gemini Pro a battu GPT-3.5 Turbo dans deux domaines, notamment le tri de mots et la manipulation et la traduction de symboles.

Dans toutes les tâches de traduction effectuées par Gemini Pro, il a surpassé tous les autres modèles, y compris GPT-4. Le score final de Gemini Pro aux tests de traduction est cependant inférieur à celui de GPT-3.5, car il a refusé de répondre à certaines demandes lorsque ses garde-fous de modération de contenu trop zélés sont entrés en action.

Et alors ?

Google conteste les chiffres auxquels les chercheurs sont parvenus et insiste sur le fait que ses chiffres montrent que Gemini Pro est égal ou supérieur à GPT-3.5. Si nous tenons compte de la myriade de variables et que nous laissons un peu de mou à Google, nous pourrions diviser la différence et dire que Gemini Pro et GPT-3.5 sont à peu près identiques.

Ce qu'il faut retenir, c'est que Gemini Pro, un tout nouveau modèle que Google a mis des mois à développer, ne bat pas un modèle qui existe depuis plus d'un an et dont l'utilisation est gratuite via ChatGPT.

Gemini Ultra devrait être commercialisé au début de l'année 2024. Sera-t-il à la hauteur de ses prétentions à être meilleur que le GPT-4 ? Espérons que le professeur Graham Neubig et son équipe effectueront bientôt des tests comparatifs similaires.