L'entraînement de modèles d'IA tels que GPT-4 s'est principalement appuyé sur des ensembles de données constitués de textes et d'images. L'ensemble de données de perception multimodale Ego-Exo4D de Meta offre aux scientifiques des données un nouvel ensemble riche de données d'entraînement.

Vous pouvez apprendre une nouvelle compétence en lisant un livre, mais c'est tellement plus facile quand quelqu'un vous montre comment faire quelque chose tout en vous l'expliquant. C'est l'objectif de l'équipe FAIR (Fundamental Artificial Intelligence Research) de Meta pour Ego-Exo4D.

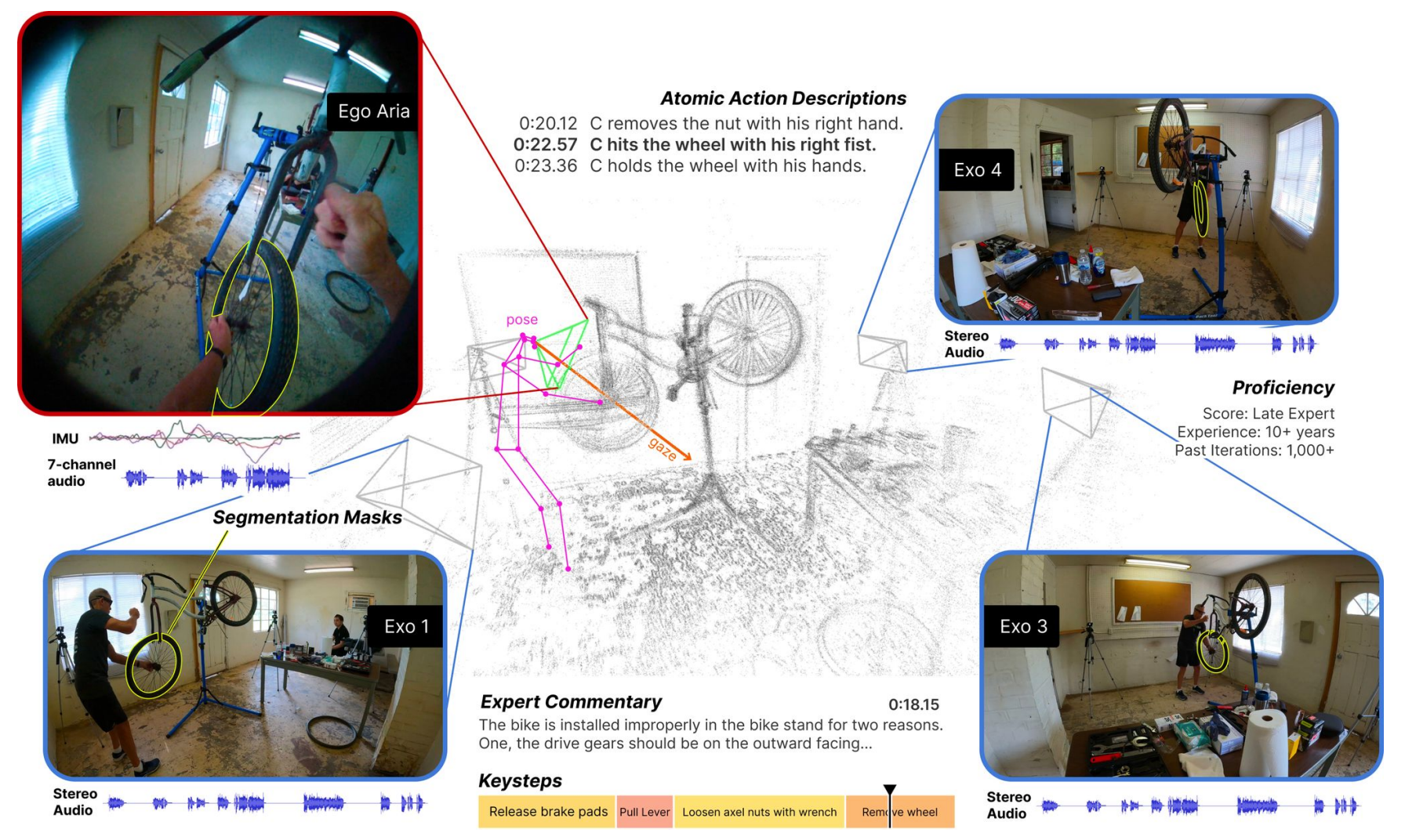

L'ensemble de données se compose de vidéos à la première personne (Ego) et à la troisième personne (Exo) montrant des personnes effectuant différentes activités humaines qualifiées. Il peut s'agir de cuisiner, de danser, de jouer de la musique ou de réparer un vélo. Les données ont été recueillies dans 13 villes du monde entier par 839 porteurs de caméras, qui ont capturé 1 422 heures de vidéo.

Les vidéos, qui sont filmées simultanément, sont ensuite enrichies de modes de données supplémentaires grâce aux lunettes Project Aria de Meta.

Les lunettes du projet Aria sont des ordinateurs portables sous forme de lunettes. Elles captent les données vidéo et audio du porteur, ainsi que les informations relatives au suivi des yeux et à la localisation. Les lunettes détectent également les positions de la tête et les nuages de points 3D de l'environnement.

Le résultat est un ensemble de données de vidéos simultanées d'une tâche en cours d'exécution, avec des narrations à la première personne par les porteurs de la caméra décrivant leurs actions, et le suivi de la tête et des yeux de la personne effectuant la tâche.

Voici Ego-Exo4D - un ensemble de données fondamentales et une suite d'étalons axés sur les activités humaines qualifiées pour soutenir la recherche sur l'apprentissage vidéo et la perception multimodale. Il s'agit du plus grand ensemble de données publiques de ce type.

Plus de détails ➡️ https://t.co/82OR4msehv pic.twitter.com/NTI1kdj1RN

- AI at Meta (@AIatMeta) 4 décembre 2023

Meta a ensuite ajouté des descriptions à la troisième personne des actions de chaque porteur de caméra. Meta a également engagé des experts dans de nombreux domaines pour ajouter des commentaires d'experts à la troisième personne critiquant la façon dont la personne dans la vidéo a effectué la tâche.

En recueillant des vues égocentriques et exocentriques, l'ensemble de données Ego-Exo4D peut montrer aux chercheurs à quoi ressemblent les activités selon différentes perspectives. Cela pourrait les aider à développer des algorithmes de vision artificielle capables de reconnaître ce que fait une personne, quel que soit son point de vue.

Ego-Exo4D ouvre de nouvelles perspectives d'apprentissage

L'un des principaux obstacles à la réalisation de l'AGI ou à la formation plus efficace des robots est le manque de perception sensorielle des ordinateurs. En tant qu'êtres humains, nous disposons d'un grand nombre d'informations sensorielles provenant de notre environnement, que nous prenons souvent pour acquis lorsque nous acquérons de nouvelles compétences.

Ego-Exo4D sera une ressource extrêmement utile pour combler cette lacune.

Gedas Bertasius, professeur adjoint au département d'informatique de l'université de Caroline du Nord, a déclaré : "Ego-Exo4D ne se limite pas à la collecte de données, il s'agit de changer la façon dont l'IA comprend, perçoit et apprend. Avec un apprentissage et une perspective centrés sur l'homme, l'IA peut devenir plus utile dans notre vie quotidienne, en nous aidant d'une manière que nous ne pouvons qu'imaginer."

Meta espère que l'Ego-Exo4D "permettra aux robots du futur d'acquérir des connaissances sur les manipulations dextres complexes en observant des experts humains compétents en action".

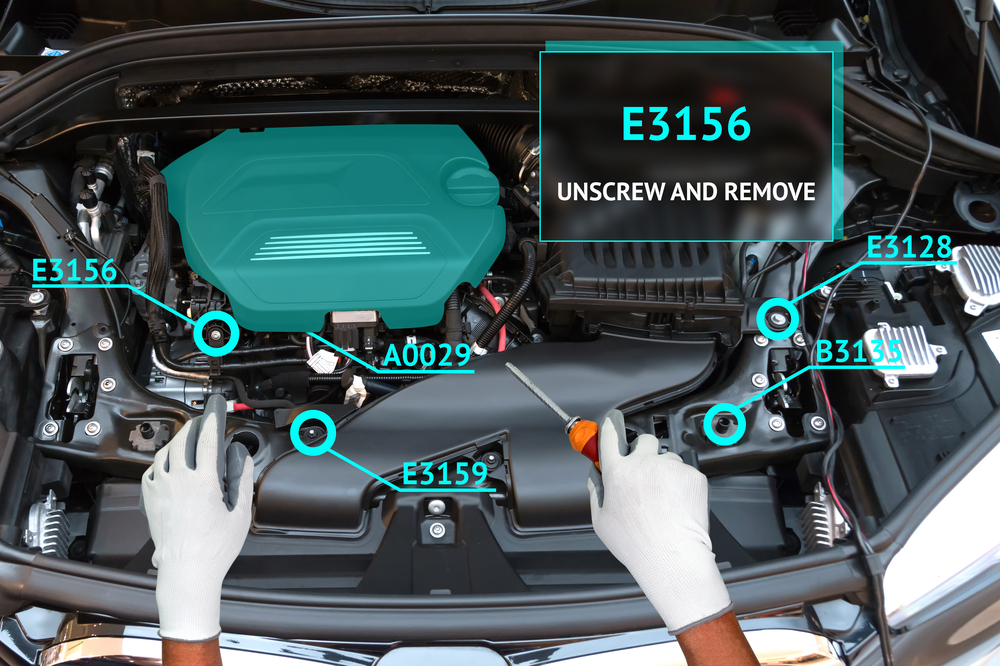

Cet ensemble de données, combiné aux lunettes du projet Aria, permettra bientôt à l'homme de vivre une expérience d'apprentissage véritablement immersive. Imaginez que vous exécutiez une tâche pendant que vos lunettes utilisent la réalité augmentée (RA) pour superposer une vidéo didactique ou vous guider dans votre tâche.

Vous pourriez apprendre à jouer du piano et bénéficier d'une superposition visuelle vous montrant où vos mains doivent se déplacer, avec des conseils audio en temps réel. Vous pouvez aussi ouvrir le capot de votre voiture et être guidé dans le dépannage et la réparation d'un problème de moteur.

Il sera intéressant de voir si le projet Meta's Concept d'apprentissage Ego How-To Les lunettes Project Aria seront mieux adoptées que les Google Glass, qui ont échoué. On ne sait pas encore quand elles seront disponibles à l'achat.

Meta va créer l'ensemble de données Ego-Exo4D disponible en téléchargement avant la fin du mois de décembre.