Une étude menée par des psychologues de l'UCLA a montré que le GPT-3 est à peu près aussi performant que les étudiants du premier cycle universitaire pour résoudre des problèmes de raisonnement.

Nous savons que les LLM comme le GPT-3 sont capables de générer des réponses basées sur les données sur lesquelles ils ont été formés, mais leur capacité à raisonner est discutable. Le raisonnement analogique est la capacité qu'ont les humains de prendre ce qu'ils apprennent d'une expérience sans rapport avec la leur et de l'appliquer à un problème auquel ils n'ont pas été confrontés auparavant.

C'est sur cette capacité que vous vous appuyez lorsque vous devez répondre à une question que vous n'avez jamais vue auparavant. Vous pouvez raisonner en vous basant sur les problèmes que vous avez déjà résolus. D'après les recherches, il semble que le GPT-3 ait également développé cette capacité.

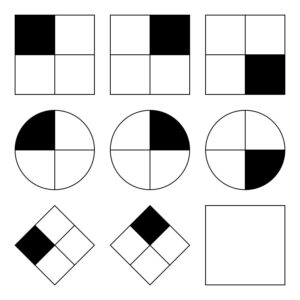

Les Chercheurs de l'UCLA Le GPT-3 a été mis au travail sur une série de problèmes similaires à ceux de la Matrices progressives de Raven qui consiste à prédire l'image suivante d'une série d'images. En voici un facile à essayer.

GPT-3 s'est montré à la hauteur des 40 étudiants de l'UCLA à qui l'on a demandé de passer le même test. L'IA a trouvé les bonnes réponses dans 80% des cas, alors que les 40 étudiants ont obtenu une moyenne de 60%. Les meilleurs étudiants ont obtenu à peu près les mêmes résultats que GPT-3.

Hongjing Lu, professeur de psychologie à l'UCLA et auteur principal de l'étude, a déclaré : "Il est surprenant de constater que non seulement le GPT-3 s'est comporté à peu près aussi bien que les humains, mais qu'il a également commis des erreurs similaires".

Les chercheurs ont également demandé au GPT-3 de résoudre des problèmes d'association de mots. Par exemple, "La voiture est à la route ce que le bateau est à quel mot ? La réponse est évidemment "eau", mais ce genre de questions peut être difficile à résoudre pour une IA.

Du moins, les chercheurs pensaient-ils que cela pouvait être délicat. Il s'avère que le GPT-3 a obtenu de meilleurs résultats que la moyenne des candidats à l'université lors de leur SAT.

Le GPT-3 s'attaque à des problèmes qui sont faciles à résoudre pour les humains.

Les modèles d'IA ont du mal à résoudre les problèmes nécessitant une compréhension visuelle de l'espace physique. Si vous présentez à GPT-3 une liste d'outils tels qu'un marteau, un clou et un tableau, il n'est pas en mesure de trouver la solution évidente pour accrocher le tableau au mur.

Ce type de problème est facile à résoudre pour les humains car nous pouvons voir, tenir et sentir des objets physiques dans un espace que nous occupons. Ces expériences permettent à notre cerveau d'apprendre et de résoudre facilement les problèmes, ce que les modèles d'IA ne peuvent pas faire. Cela dit, le GPT-4 s'améliore aujourd'hui dans ce type de raisonnement.

Si les chercheurs ont pu mesurer les performances du GPT-3, ils n'ont aucune idée du processus de "réflexion" qu'il suit pour obtenir les réponses. Suit-il un processus de pensée similaire à celui des humains ou fait-il quelque chose de complètement différent ? Le GPT-3 étant un modèle fermé, il n'est pas possible de voir ce qui se passe sous le capot.

Le résultat surprenant de cette recherche est que le GPT-3 semble être capable de résoudre des problèmes nouveaux sans aucun entraînement direct. Cette capacité est étroitement liée à la manière dont les humains résolvent les nouveaux problèmes. On s'attend à ce que le GPT-4 soit encore plus performant pour ces problèmes et qui sait quelles autres capacités de "réflexion" pourraient émerger à l'issue de tests plus poussés.

Alors que le raisonnement spatial est un défi pour les LLM, ces défis pourraient être résolus par des modèles visuels tels que RT-2 de Google qui a été annoncé récemment. Lorsque les modèles d'IA pourront commencer à "voir" et à interagir physiquement avec leur environnement, leurs capacités de résolution de problèmes s'amélioreront de manière exponentielle.