KI hat unzählige Einsatzmöglichkeiten, aber eine ihrer bedenklichsten Anwendungen ist die Erstellung von gefälschten Medien und Fehlinformationen.

Eine neue Studie von Google DeepMind und Stichsäge, ein Technologie-Inkubator von Google, der gesellschaftliche Bedrohungen beobachtet, analysierte den Missbrauch von KI zwischen Januar 2023 und März 2024.

Sie untersuchte rund 200 reale Vorfälle von KI-Missbrauch und stellte fest, dass die häufigste Form des böswilligen KI-Einsatzes die Erstellung und Verbreitung irreführender, gefälschter Medien ist, die sich insbesondere gegen Politiker und Personen des öffentlichen Lebens richten.

Deep Fakes, synthetische Medien, die mithilfe von KI-Algorithmen erstellt werden, um äußerst realistische, aber gefälschte Bilder, Videos und Audiodateien zu erzeugen, sind immer lebensechter und allgegenwärtiger geworden.

Vorfälle wie explizit gefälschte Bilder von Taylor Swift auf X erschien, zeigte, dass solche Bilder Millionen von Menschen erreichen können, bevor sie gelöscht werden.

Am heimtückischsten sind jedoch die auf politische Themen ausgerichteten Fälschungen, wie der israelisch-palästinensische Konflikt. In einigen Fällen können nicht einmal die Faktenprüfer, die damit beauftragt sind, sie als "KI-generiert" zu kennzeichnen, ihre Authentizität zuverlässig erkennen.

Die DeepMind-Studie sammelte Daten aus einer Vielzahl von Quellen, darunter Social-Media-Plattformen wie X und Reddit, Online-Blogs und Medienberichte.

Jeder Vorfall wurde analysiert, um die spezifische Art der missbräuchlich verwendeten KI-Technologie, den beabsichtigten Zweck des Missbrauchs und das für die Durchführung der böswilligen Aktivität erforderliche Maß an technischem Know-how zu ermitteln.

Fälschungen sind die wichtigste Form des KI-Missbrauchs

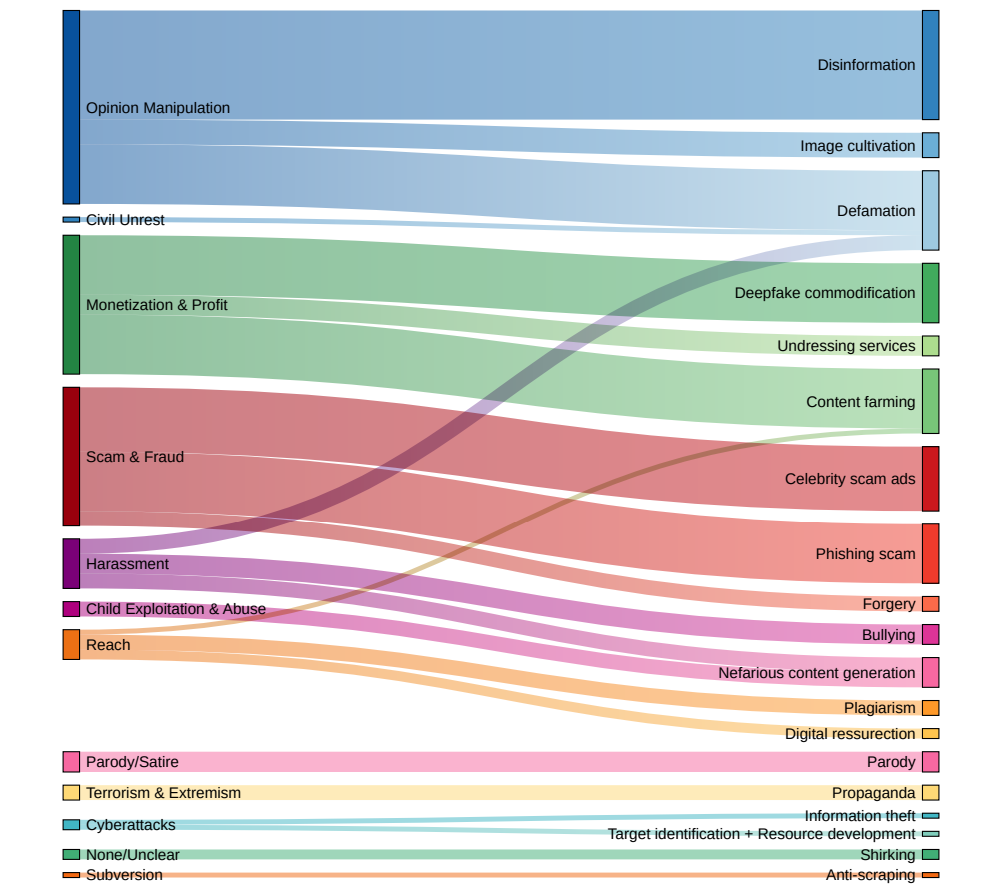

Die Ergebnisse zeichnen ein beunruhigendes Bild der aktuellen Landschaft der bösartigen KI-Nutzung:

- Deep Fakes haben sich als die vorherrschende Form des KI-Missbrauchs herauskristallisiert und machen fast doppelt so viele Vorfälle aus wie die nächsthäufigere Kategorie.

- Die am zweithäufigsten beobachtete Art des KI-Missbrauchs war die Verwendung von Sprachmodellen und Chatbots zur Erzeugung und Verbreitung von Desinformationen im Internet. Durch die automatisierte Erstellung irreführender Inhalte können böswillige Akteure soziale Medien und andere Plattformen mit Fake News und Propaganda in einem noch nie dagewesenen Ausmaß überschwemmen.

- Bei mehr als einem Viertel (27%) der analysierten KI-Missbrauchsfälle war die Beeinflussung der öffentlichen Meinung und politischer Narrative das Hauptmotiv. Dies veranschaulicht die Bedrohung, die Deep Fakes und KI-generierte Desinformationen für demokratische Prozesse und die Integrität von Wahlen weltweit darstellen, die wir von jüngste aufsehenerregende Vorfälle.

- Finanzielle Gewinne wurden als zweithäufigste Ursache für bösartige KI-Aktivitäten genannt. Skrupellose Akteure boten bezahlte Dienste für die Erstellung tiefgreifender Fälschungen an, einschließlich nicht einvernehmlicher expliziter Bilder, und nutzten generative KI, um gefälschte Inhalte aus Profitgründen massenhaft zu produzieren.

- Die meisten Vorfälle von KI-Missbrauch betrafen leicht zugängliche Tools und Dienste, für deren Betrieb nur minimale technische Kenntnisse erforderlich waren. Diese niedrige Einstiegshürde vergrößert den Pool potenzieller böswilliger Akteure erheblich und macht es für Einzelpersonen und Gruppen einfacher denn je, KI-gestützte Täuschungen und Manipulationen vorzunehmen.

Dr. Nahema Marchal von DeepMind erläuterte dem Publikum die sich entwickelnde Landschaft des KI-Missbrauchs. Financial Times: "Es gab eine Menge verständlicher Bedenken wegen der ziemlich ausgeklügelten Cyberangriffe, die durch diese Werkzeuge erleichtert wurden", und weiter: "Wir haben gesehen, dass es ziemlich häufige Missbräuche von GenAI [wie z.B. Deep Fakes] gibt, die vielleicht ein bisschen mehr unter dem Radar bleiben."

Politische Entscheidungsträger, Technologieunternehmen und Forscher müssen zusammenarbeiten, um umfassende Strategien zur Erkennung und Bekämpfung von Deepfakes, KI-generierten Desinformationen und anderen Formen des KI-Missbrauchs zu entwickeln.

Aber die Wahrheit ist, dass sie es bereits versucht haben - und weitgehend gescheitert sind. Gerade in letzter Zeit haben wir vermehrt Vorfälle beobachtet, bei denen Kinder werden in tiefgreifende Fälschungen verwickeltund zeigen, dass der gesellschaftliche Schaden, den sie anrichten, schwerwiegend sein kann.

Gegenwärtig können Technologieunternehmen Fälschungen in großem Umfang nicht zuverlässig erkennen, und sie werden mit der Zeit immer realistischer und schwieriger zu entdecken sein.

Und sobald Text-zu-Video-Systeme wie Sora von OpenAI auf den Markt kommen, wird es eine ganz neue Dimension von Fälschungen geben, mit denen man umgehen muss.