Die US-Armee versucht sich an der Integration von KI-Chatbots in ihre strategische Planung, allerdings im Rahmen einer Kriegsspielsimulation, die auf dem beliebten Videospiel Starcraft II basiert.

Diese Studieunter der Leitung des US Army Research Laboratory, analysiert OpenAIs GPT-4 Turbo und GPT-4 Vision Schlachtfeldstrategien.

Dies ist Teil von OpenAIs Zusammenarbeit mit dem Verteidigungsministerium (DOD) nach der Einrichtung des Arbeitsgruppe für generative KI letztes Jahr.

Der Einsatz von KI auf dem Schlachtfeld ist heiß debattiert, mit einer jüngste ähnliche Studie über KI-Wargaming die Feststellung, dass LLMs wie GPT-3.5 und GPT-4 dazu neigen, diplomatische Taktiken zu eskalieren, was manchmal zu einem Atomkrieg führt.

In dieser neuen Studie der US-Armee wurde mit Starcraft II ein Gefechtsszenario mit einer begrenzten Anzahl von Militäreinheiten simuliert.

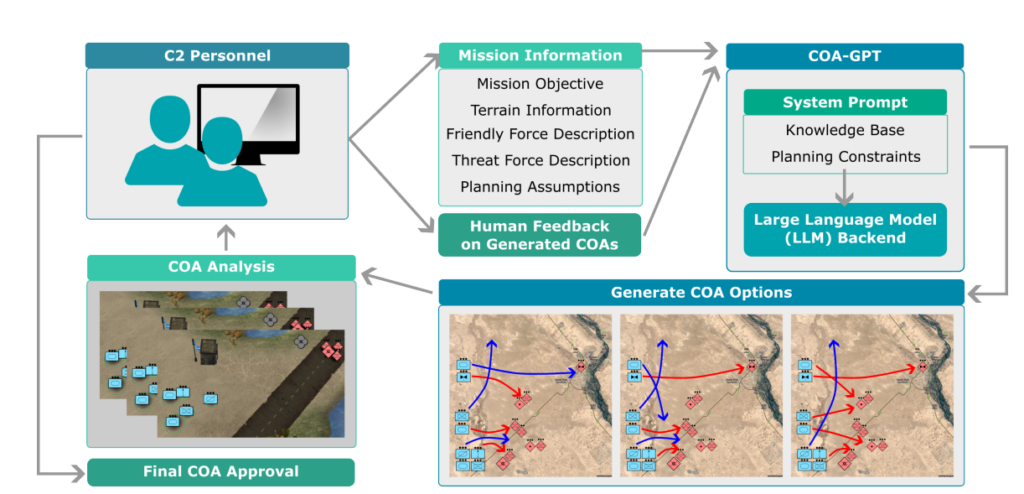

Die Forscher nannten dieses System "COA-GPT" - wobei COA für den militärischen Begriff "Courses of Action" steht, der im Wesentlichen militärische Taktiken beschreibt.

COA-GPT übernahm die Rolle eines Assistenten des militärischen Befehlshabers, der Strategien zur Vernichtung der gegnerischen Streitkräfte und zur Einnahme strategischer Punkte entwickeln sollte.

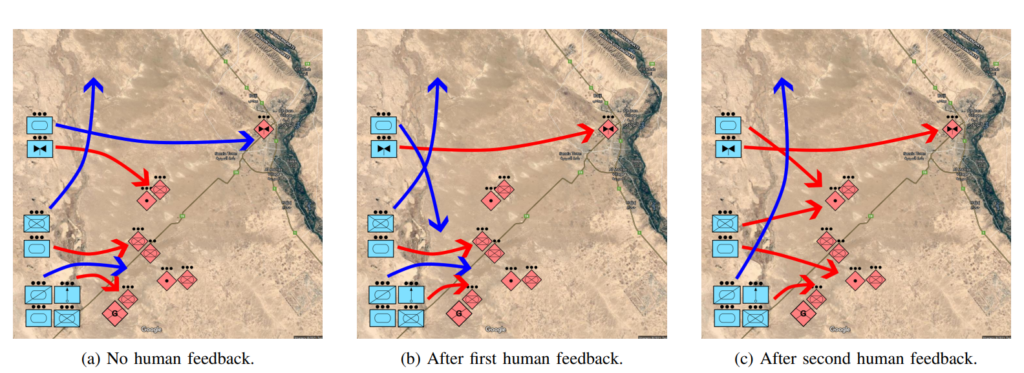

Die Forscher stellen fest, dass die herkömmliche COA bekanntermaßen langsam und arbeitsintensiv ist. COA-GPT trifft Entscheidungen innerhalb von Sekunden und integriert menschliches Feedback in den Lernprozess der KI.

COA-GPT übertrifft andere Methoden, aber es ist mit Kosten verbunden

COA-GPT zeigte eine bessere Leistung als die bestehenden Methoden und übertraf die bestehenden Methoden bei der Erstellung strategischer COAs, und könnte sich an Echtzeit-Feedback anpassen.

Allerdings gab es auch Schwachstellen. Vor allem COA-GPT hatte bei der Erfüllung der Missionsziele höhere Verluste zu beklagen.

In der Studie heißt es: "Wir stellen fest, dass COA-GPT und COA-GPT-V selbst dann, wenn sie mit menschlichem Feedback verbessert werden, im Vergleich zu anderen Grundmodellen höhere Verluste bei den eigenen Truppen aufweisen."

Schreckt das die Forscher ab? Offensichtlich nicht.

In der Studie heißt es: "Zusammenfassend lässt sich sagen, dass COA-GPT einen transformativen Ansatz für militärische C2-Operationen darstellt, der eine schnellere und agilere Entscheidungsfindung ermöglicht und einen strategischen Vorsprung in der modernen Kriegsführung sichert."

Es ist besorgniserregend, dass ein KI-System, das mehr unnötige Opfer verursacht hat als die Basisversion, als "transformativer Ansatz" bezeichnet wird.

Das Verteidigungsministerium hat bereits andere Wege zur Erforschung der militärischen Nutzung von KI aufgezeigt, aber es bestehen Bedenken hinsichtlich der Einsatzbereitschaft und der ethischen Auswirkungen der Technologie.

Wer ist zum Beispiel verantwortlich, wenn das Militär AI-Anwendungen gehen schief? Die Entwickler? Die verantwortliche Person? Oder jemand weiter unten in der Kette?

KI-Kampfführungssysteme werden bereits in den Konflikten in der Ukraine und in Palästina/Israel eingesetzt, aber diese Fragen sind noch weitgehend unerprobt.

Hoffen wir, dass es dabei bleibt.