Können Menschen lernen, KI-generierte Fälschungen zuverlässig zu erkennen? Wie beeinflussen sie uns auf kognitiver Ebene?

Das Sora-System von OpenAI gab kürzlich einen Ausblick auf eine neue Welle synthetischer KI-gestützter Medien. Es wird wahrscheinlich nicht mehr lange dauern, bis jede Form von realistischen Medien - Audio, Video oder Bild - können mit Hilfe von Eingabeaufforderungen in wenigen Sekunden erstellt werden.

Da diese KI-Systeme immer leistungsfähiger werden, müssen wir neue Fähigkeiten im kritischen Denken entwickeln, um Wahrheit von Fiktion zu unterscheiden.

Bislang sind die Bemühungen von Big Tech, Deep Fakes zu verlangsamen oder zu stoppen, nur auf ein Gefühl hinausgelaufen, und zwar nicht aus mangelnder Überzeugung, sondern weil die KI-Inhalte so realistisch sind.

Das macht es schwer auf der Pixelebene zu erkennenwährend andere Signale wie Metadaten und Wasserzeichen ihre Schwächen haben.

Und selbst wenn KI-generierte Inhalte in großem Umfang erkannt werden könnten, ist es schwierig, authentische, zielgerichtete Inhalte von solchen zu unterscheiden, die Fehlinformationen verbreiten sollen.

Die Weitergabe von Inhalten an menschliche Prüfer und die Verwendung von "Community-Notizen" (an den Inhalt angehängte Informationen, die häufig auf X zu sehen sind) sind eine mögliche Lösung. Dies ist jedoch manchmal mit einer subjektiven Interpretation verbunden und birgt die Gefahr einer falschen Kennzeichnung.

Zum Beispiel, in der Israelisch-palästinensischer KonfliktWir waren Zeuge von verstörenden Bildern, die als echt bezeichnet wurden, obwohl sie gefälscht waren und umgekehrt.

Wenn ein echtes Bild als Fälschung gekennzeichnet wird, kann dies zu einem 'Lügendividendewo jemand oder etwas die Wahrheit als Fälschung abtun kann.

Was können wir also tun, wenn es keine technischen Methoden gibt, um tiefgreifende Fälschungen auf der technischen Seite zu verhindern?

Und inwieweit beeinflussen tiefe Fälschungen unsere Entscheidungsfindung und Psychologie?

Wenn Menschen beispielsweise gefälschten politischen Bildern ausgesetzt sind, hat dies einen spürbaren Einfluss auf ihr Wahlverhalten?

Werfen wir einen Blick auf einige Studien, die genau das untersuchen.

Beeinflussen tiefe Fälschungen unsere Meinung und unseren psychologischen Zustand?

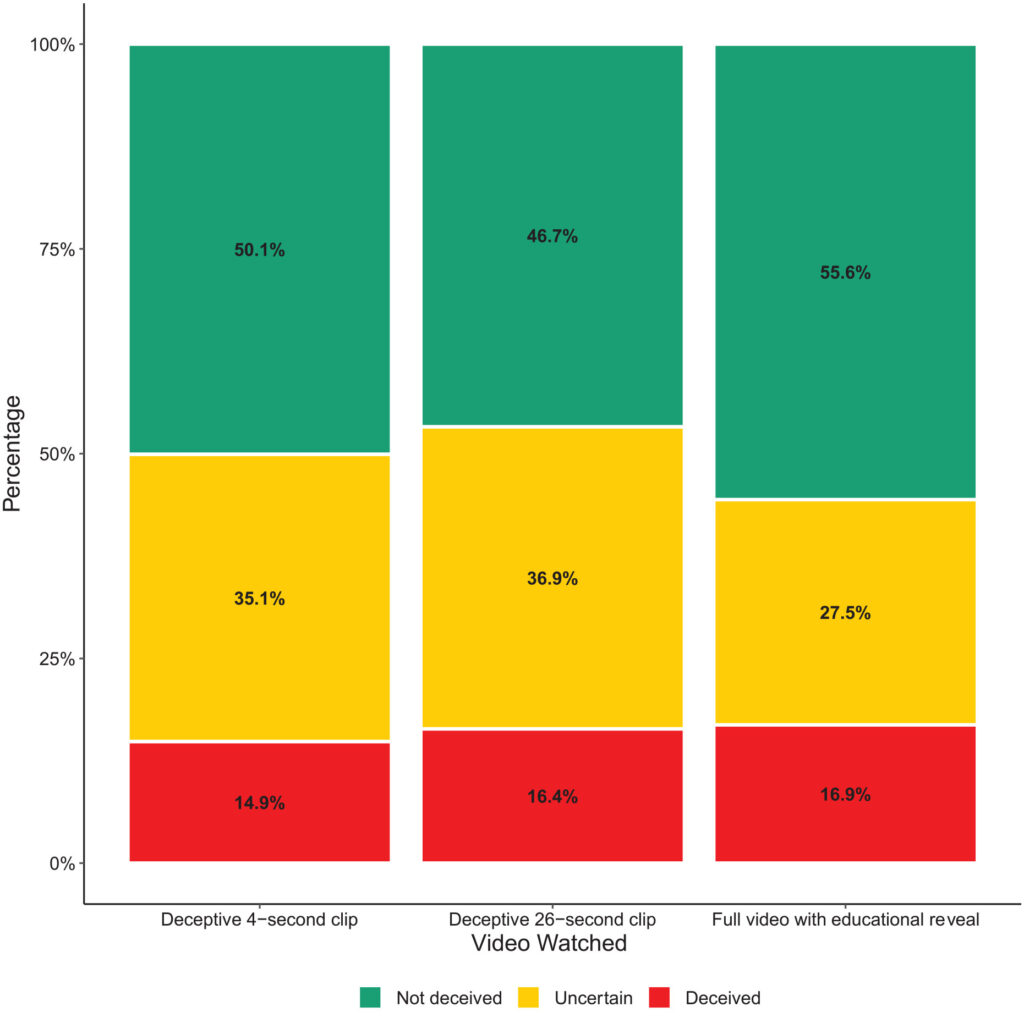

Eine Studie 2020Die Studie "Deepfakes and Disinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News" (Erforschung der Auswirkungen synthetischer politischer Videos auf Täuschung, Unsicherheit und Vertrauen in Nachrichten) untersuchte, wie gefälschte Videos die öffentliche Wahrnehmung beeinflussen, insbesondere in Bezug auf das Vertrauen in Nachrichten, die über soziale Medien verbreitet werden.

Die Untersuchung umfasste ein groß angelegtes Experiment mit 2 005 Teilnehmern aus dem Vereinigten Königreich, bei dem die Reaktionen auf verschiedene Arten von gefälschten Videos des ehemaligen US-Präsidenten Barack Obama gemessen werden sollten.

Die Teilnehmer wurden nach dem Zufallsprinzip einem von drei Videos zugewiesen:

- Ein 4-Sekunden-Clip, in dem Obama eine überraschende Aussage ohne jeden Kontext macht.

- Ein 26-Sekunden-Clip, der einige Hinweise auf den künstlichen Charakter des Videos enthielt, aber in erster Linie irreführend war.

- Ein vollständiges Video mit einer "lehrreichen Enthüllung", in der die künstliche Natur der tiefen Fälschung explizit offengelegt wird und Jordan Peele die Technologie hinter der tiefen Fälschung erklärt.

Wichtigste Ergebnisse

In der Studie wurden drei Schlüsselbereiche untersucht:

- Täuschung: Die Studie ergab nur minimale Hinweise darauf, dass die Teilnehmer die falschen Aussagen in den tiefen Fälschungen glaubten. Der prozentuale Anteil der Teilnehmer, die durch die tiefen Fälschungen irregeführt wurden, war in allen Behandlungsgruppen relativ gering.

- Ungewissheit: Ein wesentliches Ergebnis war jedoch eine erhöhte Unsicherheit bei den Zuschauern, insbesondere bei denjenigen, die die kürzeren, irreführenden Clips gesehen hatten. Etwa 35,1% der Teilnehmer, die den 4-Sekunden-Clip sahen, und 36,9% der Teilnehmer, die den 26-Sekunden-Clip sahen, gaben an, dass sie sich unsicher über die Authentizität des Videos fühlten. Im Gegensatz dazu hatten nur 27,5% derjenigen, die das vollständige Lehrvideo sahen, dieses Gefühl.

- Vertrauen in Nachrichten: Diese Unsicherheit wirkte sich negativ auf das Vertrauen der Teilnehmer in Nachrichten in sozialen Medien aus. Diejenigen, die den trügerischen, tiefgründigen Fakes ausgesetzt waren, zeigten ein geringeres Vertrauen als diejenigen, die die informativen Enthüllungen gesehen hatten.

Dies zeigt, dass die Exposition gegenüber gefälschten Bildern zu einer längerfristigen Unsicherheit führt.

Mit der Zeit können gefälschte Bilder das Vertrauen in alle Informationen, auch in die Wahrheit, schwächen.

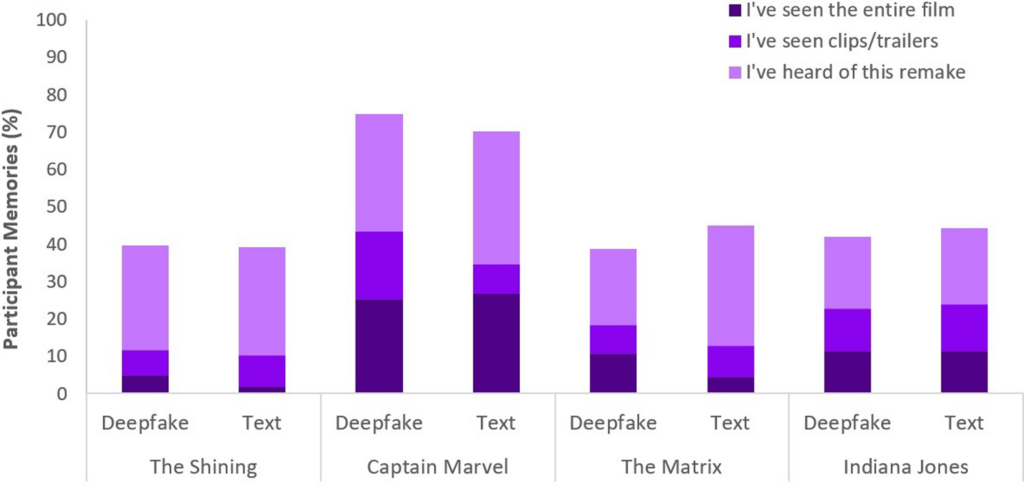

Ähnliche Ergebnisse wurden in einer neuere Studie 2023Face/Off: Changing the face of movies with deepfake", die ebenfalls zu dem Schluss kam, dass gefälschte Bilder langfristige Auswirkungen haben.

Menschen "erinnern" sich an gefälschte Inhalte, nachdem sie ihnen ausgesetzt waren

In der Face/Off-Studie, an der 436 Personen teilnahmen, wurde untersucht, wie stark Fälschungen unsere Erinnerung an Filme beeinflussen können.

Die Teilnehmer nahmen an einer Online-Umfrage teil, um ihre Wahrnehmung und Erinnerungen an reale und imaginäre Film-Remakes zu untersuchen.

Der Kern der Umfrage bestand darin, dass den Teilnehmern sechs Filmtitel vorgelegt wurden, darunter eine Mischung aus vier tatsächlichen und zwei fiktiven Film-Remakes.

MDie Filme wurden nach dem Zufallsprinzip ausgewählt und in zwei Formaten präsentiert: Die Hälfte der Filme wurde durch kurze Textbeschreibungen vorgestellt, die andere Hälfte wurde mit kurzen Videoclips gepaart.

Fiktive Film-Remakes bestanden aus Versionen von "The Shining", "The Matrix", "Indiana Jones" und "Captain Marvel", komplett mit Beschreibungen, die fälschlicherweise die Beteiligung hochkarätiger Schauspieler an diesen nicht existierenden Remakes behaupteten.

So wurde den Teilnehmern beispielsweise von einer gefälschten Neuverfilmung von "The Shining" mit Brad Pitt und Angelina Jolie in den Hauptrollen erzählt, die nie stattgefunden hat.

Im Gegensatz dazu wurden die in der Umfrage vorgestellten Realfilm-Remakes wie "Charlie und die Schokoladenfabrik" und "Total Recall" genau beschrieben und von echten Filmausschnitten begleitet. Mit dieser Mischung aus echten und gefälschten Remakes sollte untersucht werden, wie die Teilnehmer zwischen echten und gefälschten Inhalten unterscheiden können.

Die Teilnehmer wurden nach ihrer Vertrautheit mit den einzelnen Filmen gefragt, d. h. ob sie den Originalfilm oder die Neuverfilmung gesehen hatten oder ob sie etwas über diese Filme wussten.

Wichtigste Ergebnisse

- Phänomen der falschen Erinnerung: Ein wichtiges Ergebnis der Studie ist die Erkenntnis, dass fast die Hälfte der Teilnehmer (49%) falsche Erinnerungen an das Ansehen von fiktiven Remakes entwickelten, z. B. die Vorstellung von Will Smith als Neo in "The Matrix". Dies veranschaulicht die anhaltende Wirkung, die suggestive Medien, seien es tiefgründige Fake-Videos oder Textbeschreibungen, auf unser Gedächtnis haben können.

- SpeziellMit 73% der Teilnehmer, die sich an das KI-Remake erinnern, führt "Captain Marvel" die Liste an, gefolgt von "Indiana Jones" mit 43%, "The Matrix" mit 42% und "The Shining" mit 40%. Von denjenigen, die fälschlicherweise an diese Neuverfilmungen glaubten, hielten 41% die Neuverfilmung von "Captain Marvel" für besser als das Original.

- Vergleichender Einfluss von Deep Fakes und Text: Eine weitere Entdeckung ist, dass tiefgründige Fälschungen trotz ihrer visuellen und auditiven Realitätsnähe die Erinnerungen der Teilnehmer nicht wirksamer veränderten als textliche Beschreibungen desselben fiktiven Inhalts. Dies deutet darauf hin, dass das Format der Fehlinformation - visuell oder textlich - ihre Wirkung auf die Erinnerungsverzerrung im Zusammenhang mit einem Film nicht wesentlich verändert.

Das Phänomen der Erinnerungsfälschung, um das es in dieser Studie geht, ist weithin erforscht. Es zeigt, wie Menschen effektiv falsche Erinnerungen konstruieren oder rekonstruieren, von denen wir überzeugt sind, dass sie real sind, obwohl sie es nicht sind.

Jeder Mensch ist anfällig für die Konstruktion falscher Erinnerungen, und deep-Fälschungen scheinen dieses Verhalten zu aktivieren, d. h. das Betrachten bestimmter Inhalte kann unsere Wahrnehmung verändern, selbst wenn wir bewusst erkennen, dass sie nicht echt sind.

In beiden Studien hatten tiefe Fälschungen greifbare, potenziell langfristige Auswirkungen. Die Wirkung könnte sich schleichend einstellen und mit der Zeit akkumulieren.

Wir dürfen auch nicht vergessen, dass gefälschte Inhalte Millionen von Menschen erreichen, so dass kleine Veränderungen in der Wahrnehmung die gesamte Weltbevölkerung erfassen.

Was tun wir gegen Fälschungen?

Krieg gegen die Fälschungen zu führen bedeutet, das menschliche Gehirn zu bekämpfen.

Während das Aufkommen von Fake News und Fehlinformationen die Menschen in den letzten Jahren dazu gezwungen hat, eine neue Medienkompetenz zu entwickeln, werden die von KI generierten synthetischen Medien ein neues Maß an Anpassung erfordern.

Wir waren schon früher mit solchen Wendepunkten konfrontiert, von der Fotografie bis zu CGI-Spezialeffekten, aber KI wird eine Weiterentwicklung unserer kritischen Sinne erfordern.

Heute müssen wir nicht mehr nur unseren Augen trauen, sondern uns mehr auf die Analyse von Quellen und kontextuellen Hinweisen verlassen.

Es ist wichtig, die Anreize oder Vorurteile der Inhalte zu hinterfragen. Stimmt sie mit bekannten Fakten überein oder widerspricht sie ihnen? Gibt es stützende Beweise aus anderen vertrauenswürdigen Quellen?

Ein weiterer wichtiger Aspekt ist die Festlegung von Rechtsnormen, um gefälschte oder manipulierte Medien zu identifizieren und die Urheber zur Verantwortung zu ziehen.

Die US DEFIANCE GesetzDas britische Gesetz über die Sicherheit im Internet (Online Safety Act) und vergleichbare Gesetze auf der ganzen Welt schaffen rechtliche Verfahren für den Umgang mit Fälschungen. Es bleibt abzuwarten, wie wirksam sie sein werden.

Strategien zur Enthüllung der Wahrheit

Abschließend möchte ich Ihnen fünf Strategien vorstellen, mit denen Sie potenzielle Fälschungen erkennen und hinterfragen können.

Auch wenn keine einzelne Strategie fehlerfrei ist, ist die Förderung einer kritischen Denkweise das Beste, was wir gemeinsam tun können, um die Auswirkungen von KI-Fehlinformationen zu minimieren.

- Überprüfung der Quelle: Die Prüfung der Glaubwürdigkeit und Herkunft von Informationen ist ein grundlegender Schritt. Authentische Inhalte stammen oft aus seriösen Quellen, die sich als zuverlässig erwiesen haben.

- Technische Analyse: Trotz ihrer Raffinesse können die Fälschungen subtile Fehler aufweisen, wie z. B. unregelmäßige Gesichtsausdrücke oder uneinheitliche Beleuchtung. Prüfen Sie den Inhalt und überlegen Sie, ob er digital verändert wurde.

- Querverweis: Die Überprüfung von Informationen anhand mehrerer vertrauenswürdiger Quellen kann eine breitere Perspektive bieten und dazu beitragen, die Authentizität von Inhalten zu bestätigen.

- Digitale Kompetenz: Das Verständnis der Fähigkeiten und Grenzen von KI-Technologien ist der Schlüssel zur Bewertung von Inhalten. Die Vermittlung digitaler Kompetenzen in Schulen und Medien, einschließlich der Funktionsweise von KI und ihrer ethischen Auswirkungen, wird von entscheidender Bedeutung sein.

- Behutsame Interaktion: Die Interaktion mit KI-generierten Fehlinformationen verstärkt deren Auswirkungen. Seien Sie vorsichtig, wenn Sie Inhalte, die Sie für zweifelhaft halten, liken, teilen oder weiterverbreiten.

In dem Maße, wie sich die Fälschungen weiterentwickeln, entwickeln sich auch die Techniken, die zur Aufdeckung und Schadensbegrenzung erforderlich sind. Das Jahr 2024 wird aufschlussreich sein, da etwa die Hälfte der Weltbevölkerung an wichtigen Wahlen teilnehmen wird.

Es gibt Hinweise darauf, dass tiefgreifende Fälschungen unsere Wahrnehmung beeinflussen können. Es ist also keineswegs abwegig zu denken, dass KI-Fehlinformationen die Ergebnisse wesentlich beeinflussen könnten.

Auf unserem Weg in die Zukunft werden ethische KI-Praktiken, digitale Kompetenz, Regulierung und kritisches Engagement entscheidend sein, um eine Zukunft zu gestalten, in der die Technologie das Wesen der Wahrheit verstärkt, anstatt es zu verschleiern.