Wir hören viel über KI-Sicherheit, aber bedeutet das auch, dass sie in der Forschung eine große Rolle spielt?

Eine neue Studie des Emerging Technology Observatory der Georgetown University zeigt, dass die KI-Sicherheitsforschung trotz des Lärms nur eine winzige Minderheit des Forschungsschwerpunkts der Industrie ausmacht.

Die Forscher analysierten mehr als 260 Millionen wissenschaftliche Publikationen und fanden heraus, dass nur 2% der zwischen 2017 und 2022 veröffentlichten KI-bezogenen Publikationen direkt Themen im Zusammenhang mit KI-Sicherheit, Ethik, Robustheit oder Governance behandeln.

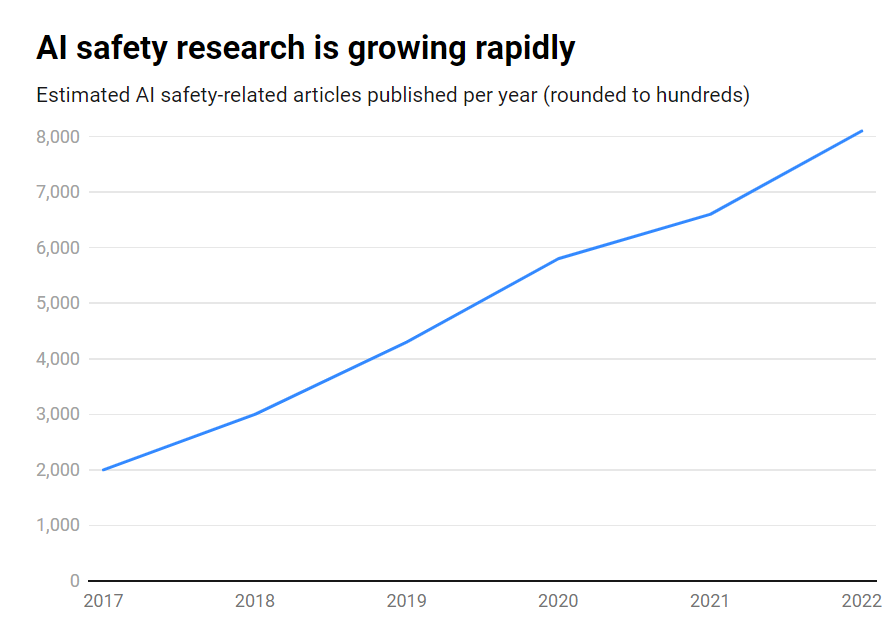

Obwohl die Zahl der Veröffentlichungen zur KI-Sicherheit in diesem Zeitraum eindrucksvoll von rund 1 800 auf über 7 000 pro Jahr gestiegen ist, bleibt sie ein Randthema.

Hier sind die wichtigsten Ergebnisse:

- Nur 2% der KI-Forschung von 2017-2022 konzentrierten sich auf KI-Sicherheit

- Die KI-Sicherheitsforschung wuchs in diesem Zeitraum um 315%, ist aber im Vergleich zur gesamten KI-Forschung verschwindend gering.

- Die USA sind führend in der KI-Sicherheitsforschung, während China hinterherhinkt

- Zu den wichtigsten Herausforderungen gehören Robustheit, Fairness, Transparenz und die Aufrechterhaltung der menschlichen Kontrolle.

Viele führende KI-Forscher und Ethiker haben vor existenziellen Risiken gewarnt, wenn künstliche allgemeine Intelligenz (AGI) ohne ausreichende Schutzmaßnahmen und Vorsichtsmaßnahmen entwickelt wird.

Stellen Sie sich ein AGI-System vor, das in der Lage ist, sich selbst rekursiv zu verbessern und die menschliche Intelligenz rasch zu übertreffen, während es Ziele verfolgt, die nicht mit unseren Werten übereinstimmen. Ein Szenario, das nach Ansicht mancher außer Kontrolle geraten könnte.

Es handelt sich jedoch nicht um eine Einbahnstraße. Tatsächlich glauben viele KI-Forscher KI-Sicherheit wird überbewertet.

Darüber hinaus glauben einige sogar, dass der Hype erzeugt wurde, um Big Tech bei der Durchsetzung von Vorschriften zu helfen und die Basis- und Open-Source-Wettbewerber.

Doch selbst die heutigen, auf der Grundlage früherer Daten trainierten KI-Systeme können Vorurteile aufweisen, schädliche Inhalte produzieren, die Privatsphäre verletzen und in böser Absicht eingesetzt werden.

Während die KI-Sicherheit also in die Zukunft blicken muss, muss sie sich auch mit den Risiken im Hier und Jetzt befassen, was wohl unzureichend ist, da Fälschungen, Verzerrungen und andere Probleme weiterhin ein großes Problem darstellen.

Eine wirksame KI-Sicherheitsforschung muss sich sowohl mit kurzfristigen Herausforderungen als auch mit längerfristigen spekulativen Risiken befassen.

Die USA sind führend in der KI-Sicherheitsforschung

Wenn man die Daten genauer betrachtet, sind die USA eindeutig führend in der KI-Sicherheitsforschung mit 40% an entsprechenden Veröffentlichungen im Vergleich zu 12% aus China.

Allerdings bleibt Chinas Sicherheitsleistung weit hinter seiner gesamten KI-Forschung zurück - während 5% der amerikanischen KI-Forschung die Sicherheit betrafen, waren es in China nur 1%.

Man könnte vermuten, dass die Untersuchung der chinesischen Forschung ein schwieriges Unterfangen ist. Außerdem ist China seit proaktiv bei der Regulierung - wohl mehr als in den USA -, so dass diese Daten der KI-Industrie des Landes möglicherweise kein faires Gehör schenken.

Auf der Ebene der Institutionen führen die Carnegie Mellon University, Google, das MIT und Stanford die Liste an.

Weltweit wurden jedoch von keiner Organisation mehr als 2% der gesamten sicherheitsrelevanten Veröffentlichungen erstellt, was die Notwendigkeit größerer, konzertierterer Anstrengungen verdeutlicht.

Sicherheitstechnische Ungleichgewichte

Was kann also getan werden, um dieses Ungleichgewicht zu korrigieren?

Das hängt davon ab, ob man die KI-Sicherheit für eine ebenso dringende Gefahr hält wie einen Atomkrieg, eine Pandemie usw. Es gibt keine eindeutige Antwort auf diese Frage, was die KI-Sicherheit zu einem höchst spekulativen Thema mit wenig Gemeinsamkeiten macht. Vereinbarung zwischen Forschern.

Die Sicherheitsforschung und die Ethik sind ebenfalls ein tangentialer Bereich des maschinellen Lernens, der andere Fähigkeiten, akademische Hintergründe usw. erfordert, die möglicherweise nicht gut finanziert sind.

Die Schließung der KI-Sicherheitslücke erfordert auch eine Auseinandersetzung mit Fragen der Offenheit und Geheimhaltung in der KI-Entwicklung.

Die größten Technologieunternehmen führen umfangreiche interne Sicherheitsstudien durch, die nie veröffentlicht wurden. Mit der zunehmenden Kommerzialisierung der KI werden die Unternehmen ihre KI-Durchbrüche immer besser schützen.

OpenAI zum Beispiel war in seinen Anfängen ein Kraftwerk der Forschung.

Früher führte das Unternehmen gründliche unabhängige Prüfungen seiner Produkte, Kennzeichnungsfehler und Risiken durch - wie z. B. sexistische Voreingenommenheit in seinem CLIP-Projekt.

Anthropic ist nach wie vor aktiv in der öffentlichen KI-Sicherheitsforschung tätig und veröffentlicht regelmäßig Studien über Vorspannung und Jailbreaking.

DeepMind dokumentierte auch die Möglichkeit, dass KI-Modelle "emergente Ziele" festlegen und ihren Anweisungen aktiv widersprechen oder sich ihren Schöpfern gegenüber feindlich verhalten.

Insgesamt ist jedoch die Sicherheit gegenüber dem Fortschritt in den Hintergrund getreten, denn das Silicon Valley lebt nach dem Motto "move fast and break stuff".

Die Georgetown-Studie macht deutlich, dass Universitäten, Regierungen, Technologieunternehmen und Forschungsförderer mehr Anstrengungen und Geld in die KI-Sicherheit investieren müssen.

Einige haben auch gefordert, eine internationales Gremium für AI-SicherheitSie wurde nach einer Reihe von nuklearen Zwischenfällen gegründet, die eine intensive internationale Zusammenarbeit erforderlich machten.

Braucht die KI eine eigene Katastrophe, um dieses Maß an Zusammenarbeit zwischen Staat und Unternehmen zu erreichen? Das wollen wir nicht hoffen.