NVIDIA hat mit Chat with RTX eine Tech-Demo veröffentlicht, die zeigt, wie KI-Chatbots mit seinen RTX-GPUs lokal auf Windows-PCs ausgeführt werden können.

Der Standardansatz für den Einsatz eines KI-Chatbots ist die Verwendung einer Webplattform wie ChatGPT oder die Durchführung von Abfragen über eine API, wobei die Schlussfolgerungen auf Cloud-Computing-Servern erfolgen. Die Nachteile dieses Ansatzes sind die Kosten, die Latenzzeit und die Bedenken hinsichtlich des Datenschutzes, wenn persönliche oder Unternehmensdaten hin und her übertragen werden.

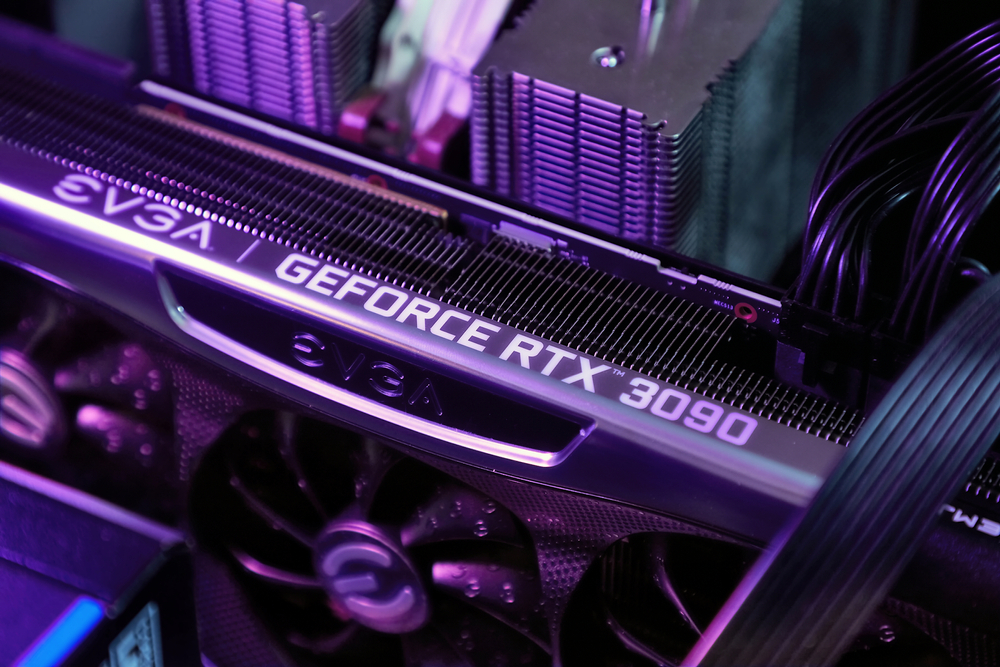

NVIDIAs RTX Reihe von Grafikprozessoren macht es jetzt möglich, ein LLM lokal auf Ihrem Windows-PC auszuführen, auch wenn Sie nicht mit dem Internet verbunden sind.

Mit Chat with RTX können Benutzer einen personalisierten Chatbot erstellen, der entweder Mistral oder Lama 2. Es verwendet die Retrieval-Augmented Generation (RAG) und NVIDIAs inferenzoptimierende TensorRT-LLM Software.

Sie können Chat with RTX auf einen Ordner auf Ihrem PC leiten und ihm dann Fragen zu den Dateien in diesem Ordner stellen. Es unterstützt verschiedene Dateiformate, darunter .txt, .pdf, .doc/.docx und .xml.

Da der LLM lokal gespeicherte Dateien analysiert, wobei die Schlussfolgerungen auf Ihrem Computer stattfinden, ist er sehr schnell, und keine Ihrer Daten werden über potenziell ungesicherte Netzwerke weitergegeben.

Sie können dem Programm auch die URL eines YouTube-Videos vorgeben und ihm Fragen zum Video stellen. Das erfordert zwar einen Internetzugang, aber es ist eine gute Möglichkeit, Antworten zu erhalten, ohne ein langes Video ansehen zu müssen.

Sie können Chat mit RTX herunterladen kostenlos, aber Sie müssen Windows 10 oder 11 auf Ihrem PC mit einer GeForce RTX 30 Series GPU oder höher mit mindestens 8 GB VRAM verwenden.

Der Chat mit RTX ist eher eine Demo als ein fertiges Produkt. Es ist ein wenig fehlerhaft und merkt sich den Kontext nicht, so dass Sie ihm keine Folgefragen stellen können. Aber es ist ein schönes Beispiel dafür, wie wir LLMs in Zukunft nutzen werden.

Die lokale Nutzung eines KI-Chatbots ohne API-Aufrufkosten und mit sehr geringer Latenz ist wahrscheinlich die Art und Weise, wie die meisten Nutzer letztendlich mit LLMs interagieren werden. Der Open-Source-Ansatz, den Unternehmen wie Meta verfolgt haben, wird dazu führen, dass die KI auf dem Gerät die Akzeptanz ihrer kostenlosen Modelle vorantreibt und nicht die proprietären Modelle wie GPT.

Allerdings werden sich Nutzer von Mobilgeräten und Laptops noch eine Weile gedulden müssen, bis die Rechenleistung eines RTX-Grafikprozessors in kleinere Geräte passt.