Eine Gruppe von Entwicklern aus Chicago hat Künstler mit Nightshade ausgestattet, einer Methode, um sich gegen unethische Datenpraktiken zu wehren.

Nightshade ist ein ausgeklügeltes Tool, das digitale Kunstwerke durch die Einführung von "vergifteten" Mustern vor unbefugter Verwendung beim KI-Training schützt.

Diese Veränderungen sind für das menschliche Auge nicht wahrnehmbar, stören aber den Lernprozess der KI und führen zu falschen Assoziationen und Reaktionen.

Die Forscher schreibenEin menschliches Auge sieht vielleicht das schattierte Bild einer Kuh auf einer grünen Wiese weitgehend unverändert, aber ein KI-Modell sieht vielleicht eine große lederne Handtasche im Gras liegen.

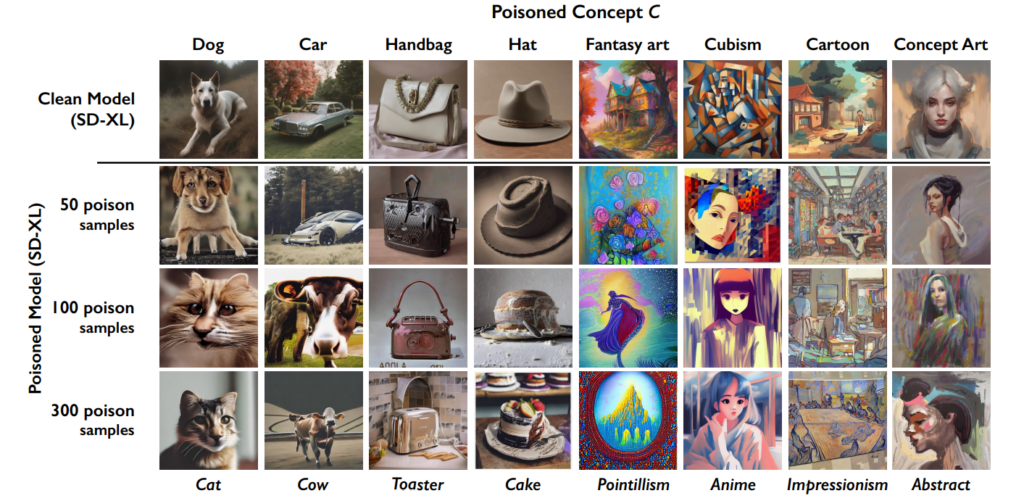

Der Effekt kumuliert, d. h. je mehr "vergiftete" Bilder ein Datensatz enthält, desto mehr verschlechtert sich die Leistung des Modells.

Dieses Tool ergänzt die frühere Kreation der University of Chicago, Glaze, die Künstlern ebenfalls hilft, Data Scraping zu bekämpfen. "Glaze kann Dinge wie Farben und Pinselstriche verändern und so einen anderen künstlerischen Stil als den tatsächlich vorhandenen präsentieren", erklären die Entwickler.

Der Ansatz von Nightshade unterscheidet sich jedoch von Glaze. "Während Glaze ein defensives Werkzeug war, ist Nightshade als offensives Werkzeug konzipiert", erklärt das Team.

Ich freue mich furchtbar, mitteilen zu können, dass "Artifact" glasiert und mit Nachtschatten versehen wurde von @TheGlazeProject und was für ein perfektes Stück für sie. Dies ist ein Gemälde über generative KI, die die authentische Stimme menschlicher Kreativer ausschlachtet. Wenn dieses Bild für das Training ausgegraben wird, nun ja... pic.twitter.com/0VNFIyabc2

- Kelly McKernan (@Kelly_McKernan) 14. Januar 2024

So funktioniert Nightshade in fünf Schritten

Nightshade ist ein cleveres Tool, das die Funktionen des maschinellen Lernens, die bei der Modellschulung zum Einsatz kommen, gegen das System selbst einsetzt, den Lernprozess vergiftet und zu schlechteren Ergebnissen bei verschiedenen Modellen führt.

Die Schwachstelle verstehen

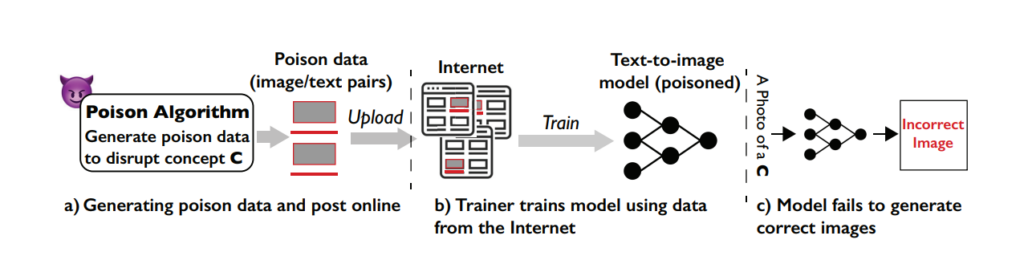

Der Nightshade-Angriff nutzt eine besondere Schwachstelle in generativen Text-Bild-Modellen aus. Diese KI-Modelle werden auf umfangreichen Datensätzen mit Bildern und entsprechenden Textbeschreibungen trainiert.

Das Team der University of Chicago stellte jedoch fest, dass die Menge der Trainingsdaten für bestimmte Aufforderungen oder Themen recht begrenzt ist. Dieser begrenzte Datenpool für bestimmte Prompts macht diese Modelle anfällig für gezielte Data-Poisoning-Angriffe.

Das Konzept von Nightshade

Nightshade ist eine ausgeklügelte Methode, um einen so genannten prompt-spezifischen Vergiftungsangriff auszuführen.

Einfacher ausgedrückt: Es ist so, als würde man einen kleinen, sorgfältig konzipierten Fehler in den Lernprozess der KI einbauen, der zu erheblichen und gezielten Fehlern führt, wenn die KI auf der Grundlage bestimmter Aufforderungen Bilder erzeugt.

Das Hauptmerkmal von Nightshade ist die Fähigkeit, "vergiftete" Proben zu produzieren, die für menschliche Augen normal aussehen, sich aber in der Wahrnehmung und im Lernverhalten der KI radikal unterscheiden.

Erstellen von Giftproben

Um einen Nightshade-Angriff auszuführen, erzeugen die Forscher zunächst so genannte "Ankerbilder". Dies sind Bilder eines Konzepts, das nichts mit dem eigentlichen Ziel des Angriffs zu tun hat.

Wenn das Zielkonzept zum Beispiel "Hund" ist, könnten die Ankerbilder "Katzen" sein. Diese Ankerbilder werden von einem KI-Modell generiert, das der Nutzer auf seinem PC ausführt.

Als Nächstes suchen die Forscher reale Bilder des Zielkonzepts (z. B. Hunde) und verändern sie auf subtile Weise, um sie an die Merkmale der Ankerbilder in der Wahrnehmung der KI anzupassen.

Für einen Menschen sehen diese veränderten Bilder immer noch wie Hunde aus, aber für die KI ähneln sie eher Katzen. Auch wenn das ein schwer zu verstehendes Konzept ist, muss man sich vor Augen halten, dass die Formen und Gestalten, die Bilder erzeugen, immer ähnlich sind.

Die Änderungen werden als "adversarische Störungen" bezeichnet. Sie werden sorgfältig berechnet, um die Darstellung des Bildes im Merkmalsraum der KI von der Region, die mit Katzen assoziiert wird, in die Region zu verschieben, die mit Hunden assoziiert wird.

Wie sich der Angriff auf KI-Modelle auswirkt

Wenn ein generatives KI-Modell auf diese vergifteten Proben trainiert wird, beginnt es, die Merkmale des nicht verwandten Konzepts (Katzen) mit dem Zielkonzept (Hunde) zu assoziieren.

Wenn das KI-Modell aufgefordert wird, Bilder von Hunden zu erzeugen, könnte es daher stattdessen Bilder von Katzen produzieren. Dies liegt daran, dass die vergifteten Daten das Verständnis des Modells davon, was ein "Hund" ist, verzerrt haben.

Dies macht ein KI-Modell zwar nicht völlig "kaputt", aber es macht es weniger effektiv und unberechenbarer, was die Benutzerfreundlichkeit sicherlich beeinträchtigen könnte.

KI-Unternehmen werden sich wahrscheinlich gegen Nightshade und ähnliche Techniken wehren, aber das wird Zeit und Mühe kosten.

Auswirkungen

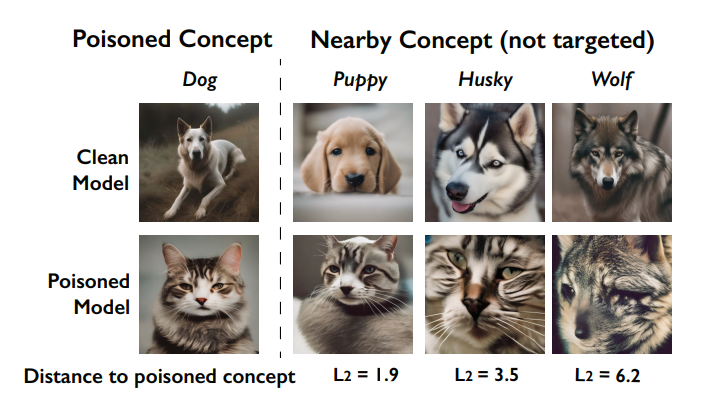

Eine wichtige Auswirkung des Nachtschatten-Angriffs ist sein "Durchbluteffekt". Das bedeutet, dass sich die Vergiftung eines Konzepts auf verwandte Konzepte auswirken kann.

Wenn beispielsweise das Konzept "Hund" vergiftet wird, könnte dies auch Auswirkungen darauf haben, wie das Modell Bilder von verwandten Tieren wie "Wölfen" oder "Füchsen" erzeugt.

durch die Vergiftung beschädigt werden (so genannter "Bleed-Through-Effekt"). Quelle: Universität von Chicago über ArXiv

Wenn mehrere Konzepte in einem Modell vergiftet werden, kann dies außerdem die Fähigkeit des Modells beeinträchtigen, kohärente Bilder für eine Vielzahl von Aufforderungen zu erzeugen.

Wie Künstler Nightshade verwenden können

Nightshade ist ein Tool, das Sie selbst herunterladen und verwenden können, aber es ist ziemlich ressourcenintensiv und erfordert eine kompatible Nvidia GPU mit mindestens 4G Speicher.

Dieser Prozess könnte in Zukunft vereinfacht werden, oder es könnte Cloud-Dienste geben, bei denen Sie Ihre Bilder einfach hochladen können, damit sie von Nightshade'd für Sie bearbeitet werden.

So verwenden Sie Nightshade:

- Wählen Sie Ihr Kunstwerk: Sie können entweder ein einzelnes Bild in den Bildplatzhalter ziehen oder mehrere Bilder über die Schaltfläche "Auswählen..." auswählen.

- Parameter anpassen: Die Intensität bestimmt die Stärke der Wirkung von Nightshade. Eine höhere Intensität führt zu einer stärkeren Störung, kann aber spürbare Veränderungen an Ihrem Kunstwerk verursachen. Die Renderqualität gibt an, wie lange es dauert, die optimale Giftmenge zu berechnen. Eine höhere Qualität entspricht einem stärkeren Gift, erfordert aber mehr Zeit. Wenn Sie einen Grafikprozessor haben, wird dieser Prozess schneller sein.

- Ausgabeverzeichnis wählen: Wählen Sie aus, wo die Nightshaded-Bilder gespeichert werden sollen.

- Gift-Tag auswählen: Nightshade funktioniert, indem es die KI über bestimmte Konzepte in Ihrem Bild in die Irre führt. Zum Beispiel kann es Bilder, die als "Auto" gekennzeichnet sind, so verändern, dass sie von KI-Modellen als "Kuh" wahrgenommen werden. Nightshade schlägt bei der Auswahl Ihres Bildes ein Tag vor, das auf seiner Inhaltsanalyse basiert. Vergewissern Sie sich, dass das Tag das Schlüsselkonzept Ihres Bildes genau widerspiegelt, und passen Sie es bei Bedarf an. Die Wirksamkeit von Nightshade erhöht sich, wenn Ihr Bild durch Alt-Text, Bildunterschriften oder Text in der Nähe mit diesem Tag verknüpft wird.

- Run Nightshade: Nachdem Sie Ihre Einstellungen vorgenommen und das Bild-Tag bestätigt haben, starten Sie den Prozess mit der Schaltfläche "Ausführen". Die geänderten Bilder werden in dem von Ihnen gewählten Ausgabeverzeichnis gespeichert.

- Ausführliche Anweisungen finden Sie in der offizielles Benutzerhandbuch hier.

Gemeinschaftsempfang zu Nightshade-Empfang

Es gibt eine überwältigende Unterstützung für Künstler, die versuchen, ihre Arbeit vor der KI zu schützen, aber wie immer gibt es mehrere Fraktionen, wobei einige es mit einem Cyberangriff auf KI-Modelle vergleichen.

Als Antwort auf die Kritiker stellt das Team klar: "Das Ziel von Nightshade ist es nicht, Modelle zu zerstören, sondern die Kosten für die Ausbildung auf nicht lizenzierten Daten zu erhöhen, so dass die Lizenzierung von Bildern von ihren Urhebern eine realistische Alternative wird."

"Bei verantwortungsbewusster Nutzung kann Nightshade dazu beitragen, Modeltrainer abzuschrecken, die Urheberrechte, Opt-out-Listen und do-not-scrape/robots.txt-Richtlinien missachten", heißt es.

Nach der Kontroverse bei Midjourney und einer Flut von Unternehmen, die KI-generierte Kunstwerke verwenden und damit menschliche Arbeitskraft ersetzen, ist die Debatte um Data Scraping und KI-Modelltraining extrem erbittert geworden.

Nightshade ist raus!

Nightshade vergiftet KI-Modelle, wenn Ihre Kunstwerke oder Bilder unerlaubt entwendet werden, Glaze schützt Sie vor KI-Nachahmung. Es wird empfohlen, erst Nightshade und dann Glaze zu verwenden. Eine Version, die beides kann, ist in Vorbereitung.

Lesen Sie diesen Thread für weitere Informationen.

Schnappt sie euch 🫡 https://t.co/bU8EDthUcS pic.twitter.com/YddNu8xmJm

- Reid Southen (@Rahll) 19. Januar 2024

Plötzlich hat man das Gefühl, dass sich die Kluft zwischen den Technologieunternehmen, die KI als philanthropische Kraft vermarkten, und der Öffentlichkeit, die das Gefühl hat, dass sie zu sehr in Kultur und Gesellschaft eingreift, vergrößert.

Nightshade ist in der Tat nicht nur für Künstler nützlich. Die Menschen ermutigen so viele wie möglich, diese Tools zu nutzen, wodurch ein kleinerer Pool an hochwertigen Daten entsteht, den KI-Unternehmen ausschöpfen können.

Aber haben die Unternehmen schon genug Daten? Im Moment vielleicht, aber um die Modelle auf dem neuesten Stand zu halten, müssen die KI-Entwickler irgendwann neue Daten in ihre Systeme einspeisen.

#nachtschatten

Profi-Tipp: Verwenden Sie Nightshade für alles, was Sie online hochladen (nicht nur für Ihre Kunst), für Bilder in den sozialen Medien, für tägliche Fotos vom Essen, von der Familie, von Welpen und Kätzchen, für zufällige Selfies und Straßenfotos - und schon kann das Spiel beginnen.- ballai bearbeiten 🌿 (@eballai) 19. Januar 2024

In Glaze und Nightshade zeichnet sich ein technologischer und ethischer Kampf zwischen Künstlern und KI-Unternehmen ab.

Es wird immer interessanter werden, und gibt es vielleicht ähnliche Möglichkeiten, Sprachmodelle zu täuschen und zu vergiften?

In Verbindung mit rechtlichen Auseinandersetzungen könnte die generative KI in eine unbeständige Phase eintreten. Es wird ein großes Jahr für diese Technologie.