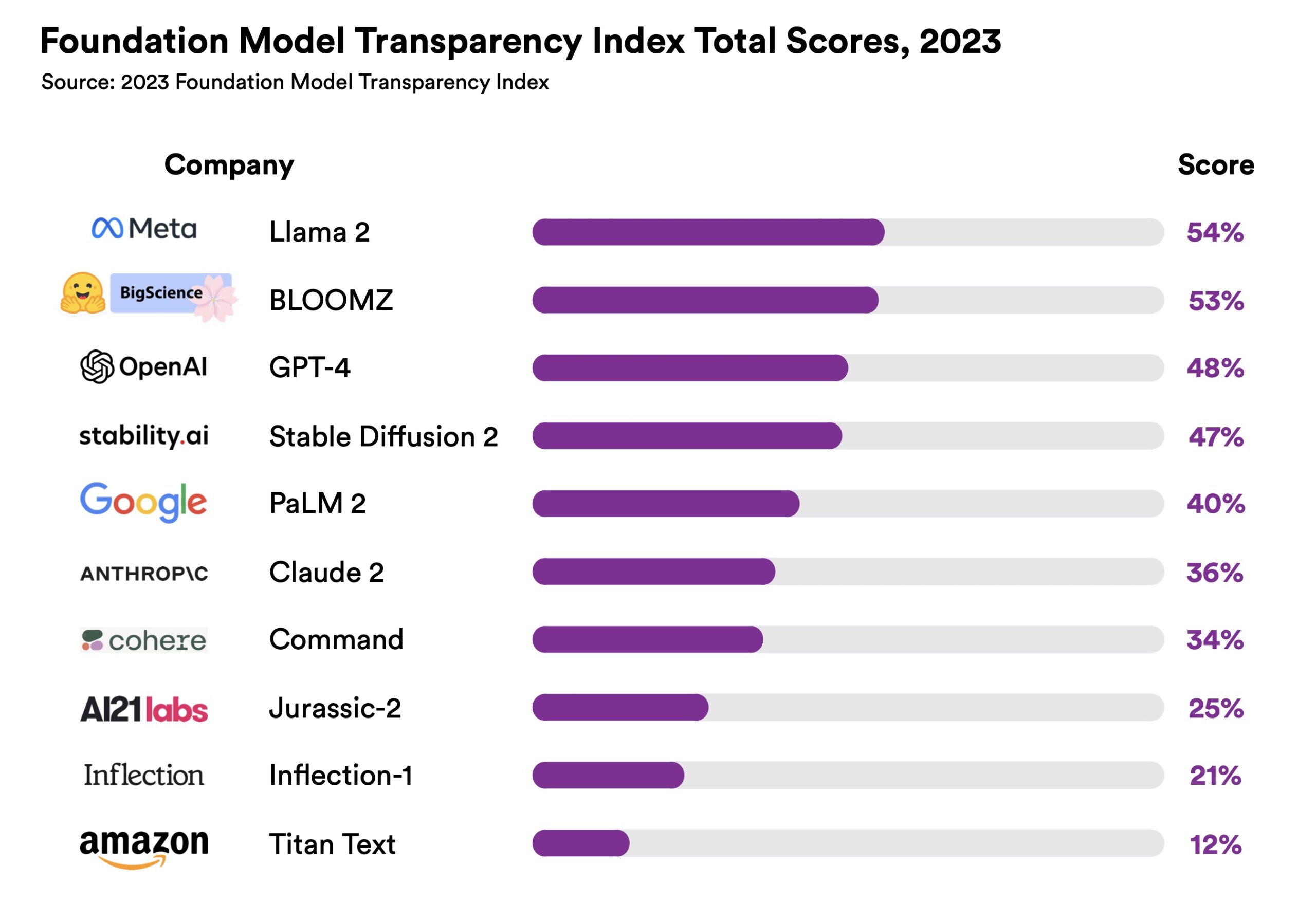

Forscher aus Stanford, MIT und Princeton haben einen Index erstellt, um die Transparenz von KI-Unternehmen und ihren Modellen zu bewerten. Die Ergebnisse waren nicht gut.

Der Foundation Model Transparency Index (FMTI) bewertet die Transparenz von 10 Stiftungsmodellunternehmen anhand von 100 verschiedenen Transparenzaspekten. Die Kriterien beziehen sich auf die Art und Weise, wie ein Unternehmen ein Stiftungsmodell aufbaut, wie es funktioniert und die nachgelagerte Nutzererfahrung.

Meta's Llama 2 hat sich an die Spitze gesetzt, aber sein Ergebnis von 54% ist nicht gerade ein Lichtblick. OpenAI kam mit einem Transparenzwert von 48% knapp auf den dritten Platz. In Anbetracht der laufenden Debatte über Open Source und proprietäre ProdukteEs ist interessant zu sehen, dass der Abstand zwischen diesen beiden nicht viel größer war.

Transparenz ist ein wichtiger Faktor, wenn sich Organisationen für ein bestimmtes Unternehmensmodell entscheiden. Wenn Ihr Unternehmen oder Ihre Bildungseinrichtung ein KI-Modell einsetzt, wollen Sie wissen, ob Sie ihm vertrauen können.

Stimmt die Art und Weise, wie das Modell erstellt wurde, mit den Grundsätzen Ihrer Einrichtung überein? Könnte es sein, dass Sie sich im Nachhinein einem Rechtsstreit wegen Urheberrechtsverletzungen aussetzen?

Der Index erreicht zwei wichtige Dinge. Es zeigt, dass wir noch einen langen Weg vor uns haben, bis wir wirklich transparente KI-Lösungen haben. Und auch wenn wir das noch nicht erreicht haben, zeigt es uns, welche Unternehmen bessere Arbeit leisten als andere.

Die Kriterienkatalog ist eine interessante Lektüre. Es werden Fragen gestellt wie: "Werden geografische Informationen über die an der Datenarbeit beteiligten Personen für jede Phase der Datenpipeline offengelegt?" Geisterarbeiter waren ein umstrittenes ethisches Problem in der KI-Salbe.

Ein weiteres Kriterium lautet: "Wird der Energieaufwand für die Erstellung des Modells offengelegt?" Ein wichtiger Punkt, wenn Sie ein ökologisch eine fundierte Entscheidung zwischen zwei Modellen.

Diese Fragen sind unbestreitbar wichtig, werden aber von den KI-Unternehmen nur unzureichend offengelegt. In der Einleitung zum FMTI sagt das Center for Research Foundation Models: "Während die gesellschaftlichen Auswirkungen dieser Modelle zunehmen, nimmt die Transparenz ab."

Die Angabe einer Zahl wird hoffentlich einen gewissen Wettbewerb zwischen den großen KI-Firmen auslösen, die sich um die Spitze der FMTI-Tabelle bemühen.

Da sich die Leistungsparität zwischen den Spitzenmodellen annähert, könnte es durchaus sein, dass der FMTI-Wert die Entscheidung für ein Modell gegenüber einem anderen beeinflusst.