Da die KI immer mehr Einzug in die Personalbeschaffungsprozesse hält, ist klar, dass das Effizienzversprechen der Technologie auch seine Risiken mit sich bringt.

Nach Angaben von 2022 DatenEtwa 55% der Unternehmen nutzen bereits KI-Tools für die Personalbeschaffung.

Die KI hat zwar die traditionellen Einstellungsverfahren beschleunigt und Stapel von Lebensläufen und Bewerbungen überflüssig gemacht, aber sie hat auch kritische Fragen zu Fairness, Voreingenommenheit und dem Wesen der menschlichen Entscheidungsfindung aufgeworfen.

Schließlich werden KI auf der Grundlage menschlicher Daten trainiert, so dass sie alle Voreingenommenheiten und Vorurteile, die sie auszurotten versprechen, übernehmen können.

Ist dies etwas, das wir ändern können? Was haben wir bisher von der KI bei der Personalbeschaffung gelernt?

Menschenrechtsgruppen werfen Meta diskriminierende Werbepraktiken vor

Die Daten zeigen, dass einige 79% der Arbeitssuchenden nutzen soziale Medien für die Arbeitssuche, und es ist erwiesen, dass hier die Diskriminierung beginnt.

Meta ist derzeit mit mehreren Anschuldigungen konfrontiert von europäischen Menschenrechtsorganisationen, die behaupten, dass der Algorithmus von Facebook zur Ausrichtung von Stellenanzeigen voreingenommen ist.

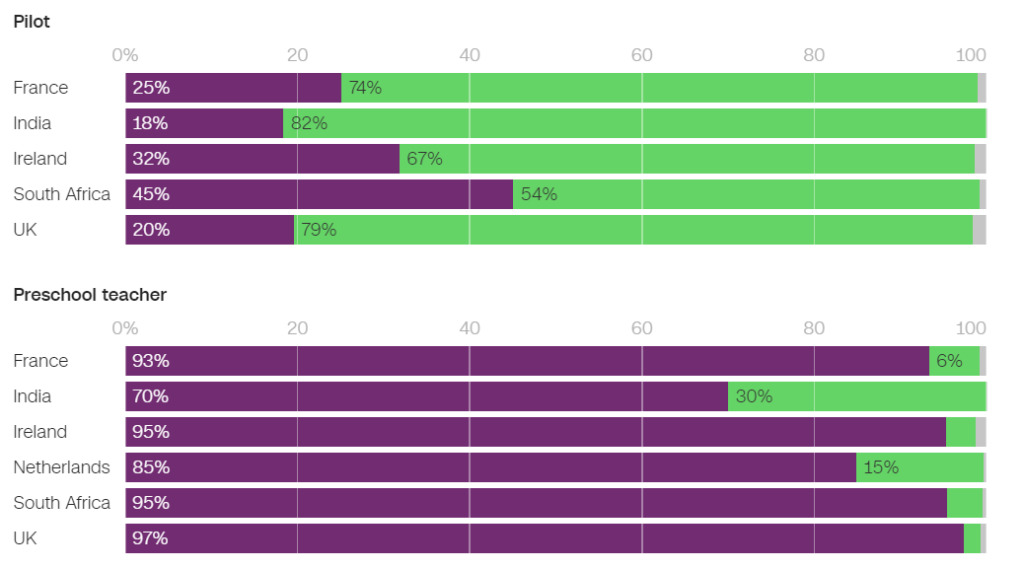

Im Juni hat die NGO Global Witness untersuchte mehrere zielgerichtete Facebook-Stellenanzeigen und stellte fest, dass viele davon geschlechtsspezifische Vorurteile enthalten.

So wurden beispielsweise Männer deutlich häufiger mit Anzeigen aus dem Bereich Ingenieurwesen konfrontiert, während Frauen deutlich häufiger mit Anzeigen aus dem Bereich Unterricht konfrontiert wurden.

Von den in Frankreich geschalteten Anzeigen waren 93% der Nutzer, die eine Stellenanzeige für Vorschullehrer sahen, und 86% der Nutzer, die eine Stellenanzeige für Psychologen sahen, Frauen. Umgekehrt wurde nur 25% der Frauen eine Stellenanzeige für Piloten gezeigt und nur 6% eine Stellenanzeige für Mechaniker.

In den Niederlanden waren 85% der Nutzer, denen eine Stellenanzeige für Lehrer angezeigt wurde, und 96% der Nutzer, denen eine Stellenanzeige für Rezeptionisten angezeigt wurde, Frauen. Ähnliche Ergebnisse wurden in vielen anderen Ländern, darunter das Vereinigte Königreich, Indien und Südafrika, beobachtet.

In einem Interview mit CNNNaomi Hirst von Global Witness sagte: "Unsere Sorge ist, dass Facebook die Vorurteile, die wir in der Gesellschaft leben, verschärft und tatsächlich die Chancen für Fortschritt und Gerechtigkeit am Arbeitsplatz beeinträchtigt."

Gemeinsam mit dem Bureau Clara Wichmann und der Fondation des Femmes hat Global Witness Beschwerden gegen Meta bei den Menschenrechts- und Datenschutzbehörden in Frankreich und den Niederlanden eingereicht.

Die Gruppen drängen auf eine Untersuchung, ob die Praktiken von Meta gegen Menschenrechte oder Datenschutzgesetze verstoßen. Sollten sich die Vorwürfe bestätigen, könnten Meta Geldstrafen und Sanktionen drohen.

Ein Meta-Sprecher erklärte daraufhin: "Das System berücksichtigt verschiedene Arten von Informationen, um zu versuchen, den Leuten Anzeigen zu liefern, an denen sie am meisten interessiert sind".

Es ist nicht das erste Mal, dass Meta derartige Kritik abwehrt - das Unternehmen sah sich mehrere Gerichtsverfahren im Jahr 2019 und verpflichtete sich, sein Anzeigensystem zu ändern, um Voreingenommenheit aufgrund von geschützten Merkmalen wie Geschlecht und Rasse zu vermeiden.

Pat de Brún von Amnesty International kritisierte die Ergebnisse von Global Witness scharf. "Die Forschung zeigt immer wieder, dass die Algorithmen von Facebook zu sehr ungleichen Ergebnissen führen und oft Marginalisierung und Diskriminierung verstärken", sagte sie gegenüber CNN.

Amazon streicht geheimes KI-Rekrutierungstool, das Frauen benachteiligt hat

Amazon entwickelte zwischen 2014 und 2017 ein KI-Rekrutierungstool, bevor es feststellte, dass das Tool bei der Auswahl von Softwareentwickler-Jobs und anderen technischen Stellen voreingenommen war. Im Jahr 2018 hat Amazon das Tool komplett eingestellt.

Das KI-System bestrafte Lebensläufe, die das Wort "Frauen" und "Frauen" enthielten, und stufte die Fähigkeiten weiblicher Absolventen herab.

Das System scheiterte selbst dann, als Amazon versuchte, die Algorithmen so zu ändern, dass sie geschlechtsneutral sind.

Später stellte sich heraus, dass Amazon das Tool anhand von Lebensläufen trainiert hatte, die dem Unternehmen über einen Zeitraum von 10 Jahren vorgelegt worden waren und von denen die meisten von Männern stammten.

Wie viele KI-Systeme wurde auch Amazons Tool von den Daten beeinflusst, auf denen es trainiert wurde, was zu unbeabsichtigten Verzerrungen führte. Diese Voreingenommenheit begünstigte männliche Bewerber und bevorzugte Lebensläufe, die eine Sprache verwendeten, die eher in Lebensläufen männlicher Ingenieure zu finden ist.

Außerdem empfahl das System aufgrund von Problemen mit den zugrundeliegenden Daten häufig unqualifizierte Kandidaten für verschiedene Stellen.

Die Weltwirtschaftsforum sagte über Amazons Rekrutierungssystem: "Zum Beispiel könnten - wie im Fall von Amazon - starke geschlechtsspezifische Ungleichgewichte mit der Art der durchgeführten Studie korrelieren. Diese Verzerrungen der Trainingsdaten können auch durch schlechte Datenqualität oder sehr kleine, nicht diversifizierte Datensätze entstehen, was bei Unternehmen der Fall sein kann, die nicht global agieren und nach Nischenkandidaten suchen.

Amazon gelang es, eine "verwässerte Version" der Recruiting-Engine für rudimentäre Aufgaben wie die Beseitigung doppelter Kandidatenprofile aus Datenbanken umzuwidmen.

Sie richteten ein neues Team ein, um einen weiteren Versuch mit automatisierten Beschäftigungsprüfungen zu unternehmen, diesmal mit Schwerpunkt auf der Förderung der Vielfalt.

Google kämpft mit seinen eigenen Problemen mit Diskriminierung und Voreingenommenheit

Im Dezember 2020 gab Dr. Timnit Gebru, ein führender KI-Ethiker bei Google, bekannt, dass die Firma hatte sie entlassen.

Die Kündigung erfolgte, nachdem Dr. Gebru Bedenken über Googles Vorgehen bei der Einstellung von Minderheiten und über inhärente Voreingenommenheit in KI-Systemen geäußert hatte.

Bevor er das Unternehmen verließ, sollte Dr. Gebru eine Arbeit veröffentlichen, in der er auf Verzerrungen in Googles KI-Modellen hinwies.

Nachdem sie diese Arbeit bei einer akademischen Konferenz eingereicht hatte, offenbarte Dr. Gebru, dass ein Google-Manager sie aufforderte, die Arbeit zurückzuziehen oder die Namen von sich und den anderen Google-Forschern zu entfernen. Als sie sich weigerte, der Aufforderung nachzukommen, akzeptierte Google einen bedingten Rücktrittsvorschlag und beendete damit Dr. Gebru's Position mit sofortiger Wirkung.

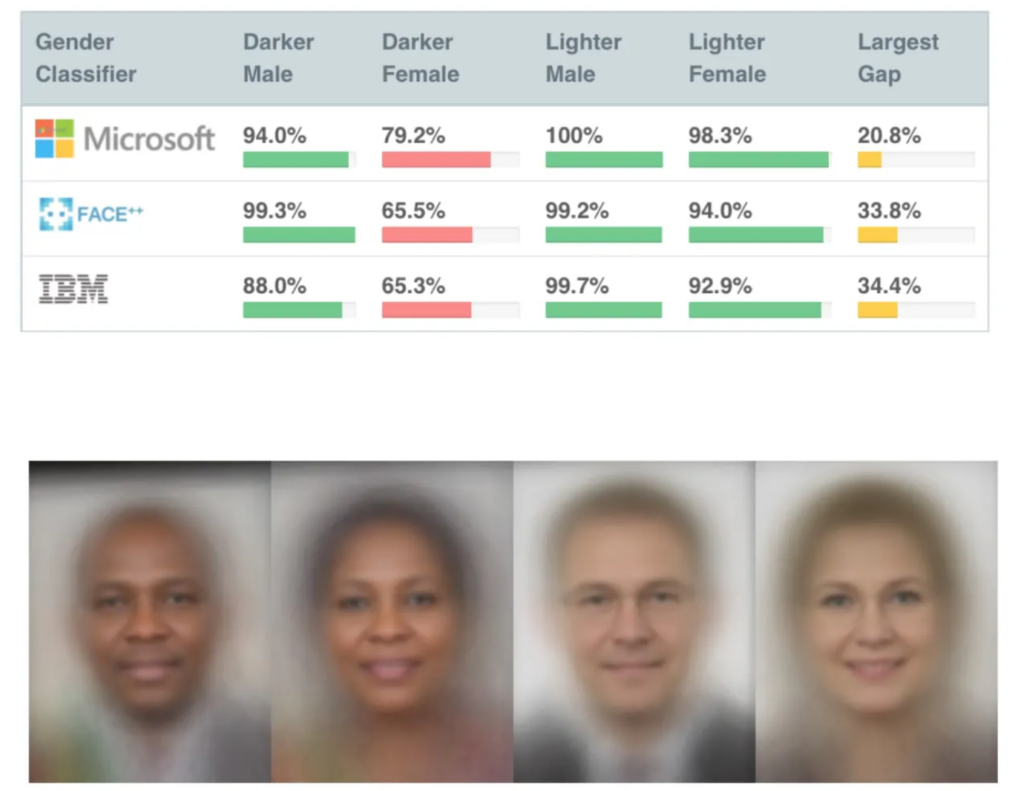

Dies geschah nicht lange nach der Veröffentlichung mehrerer sehr einflussreicher Studien über KI-Verzerrungen, darunter MIT-Studie "Gender Shadesdie zu einer der meistzitierten KI-Arbeiten aller Zeiten geworden ist.

Die Gender-Shades-Studie deckte Verzerrungen bei KI zur Gesichtserkennung auf, die schwarze Gesichter in etwa 30% bis 35% der Zeit falsch erkannten, verglichen mit etwa 5% bei weißen Gesichtern.

Falsche Treffer bei der Gesichtserkennung führten zur unrechtmäßigen Verhaftung und Inhaftierung von mehrere Männer in den USA.

Die Entlassung von Gebru löste einen Medienwirbel über diskriminierende Praktiken im Silicon Valley aus.

Mutale Nkonde vom Stanford Digital Civil Society Lab sagte: "Ihre Entlassung zeigt nur, dass Wissenschaftler, Aktivisten und Gelehrte, die in diesem Bereich arbeiten wollen - und Schwarze Frauen sind - im Silicon Valley nicht willkommen sind."

Die Entlassung von Dr. Gebru inspirierte eine weitere Studie, Entlarvung kodierter Vorurteilein der festgestellt wurde, dass Schwarze von der KI bei der Personalauswahl deutlich häufiger unterschätzt werden als alle anderen.

"Dieser Bericht fand zahlreiche Belege dafür, dass Schwarze Studenten und Berufstätige sich Sorgen machen, dass sie während des Einstellungsverfahrens mit Vorurteilen gegen Schwarze konfrontiert werden. Etwas mehr als die Hälfte aller Befragten gab an, dass sie bei Einstellungs- oder Rekrutierungsprozessen auf Einstellungs- oder Rekrutierungs-Websites Voreingenommenheit beobachtet haben. Bei schwarzen Fachkräften ist die Wahrscheinlichkeit, dass sie solche Vorurteile beobachtet haben, etwas höher: Fünfundfünfzig Prozent der Befragten gaben an, dass sie Vorurteile im Einstellungsverfahren beobachtet haben". Entlarvung kodierter Vorurteile, Penn Law Policy Lab.

In dem Papier heißt es: "Die von Dr. Gebru und ihren Kollegen angestoßene öffentliche Diskussion über algorithmische Voreingenommenheit ermöglichte es unserem Labor, sich an diesem nationalen Dialog zu beteiligen und ein nuancierteres Verständnis der algorithmischen Voreingenommenheit bei Einstellungsplattformen zu entwickeln."

Die Aufdeckung des Problems war ein Katalysator für Veränderungen, aber die KI hat noch einen langen Weg vor sich, um ihre Rolle bei sensiblen menschlichen Entscheidungen zu vereinbaren.

Die Rolle der KI bei der Rekrutierung: einige positive Aspekte hervorheben

Trotz zahlreicher Kontroversen ist es für Unternehmen schwierig, sich dem immensen Potenzial von KI zur Beschleunigung der Personalbeschaffung zu widersetzen.

Die Rolle der KI bei der Personalbeschaffung ist sicherlich logisch - es könnte einfacher sein, KI von Vorurteilen zu befreien als Menschen. Schließlich ist KI *nur* Mathematik und Code - sicherlich formbarer als tief verwurzelte unbewusste Vorurteile?

Und während die Trainingsdaten Anfang bis Mitte der 2010er Jahre stark verzerrt waren, was in erster Linie auf einen Mangel an unterschiedlichen Datensätzen zurückzuführen war, hat sich dies seitdem wohl verbessert.

Ein bekanntes KI-Rekrutierungstool ist Sapiadie als "intelligenter Interviewer" bezeichnet wird. Laut Barb Hyman, der Gründerin von Sapia, ermöglicht KI einen "blinden" Interviewprozess, der sich nicht auf Lebensläufe, soziale Medien oder demografische Daten stützt, sondern ausschließlich auf die Antworten des Bewerbers, wodurch Voreingenommenheiten, die bei der Einstellung von Menschen vorherrschen, beseitigt werden.

Diese Systeme können allen Bewerbern eine faire Chance bieten, indem sie alle Bewerber befragen. Hyman schlägt vorDie Wahrscheinlichkeit, dass Frauen eingestellt werden und bleiben, ist doppelt so hoch, wenn man KI einsetzt.

Aber schon der Prozess der Befragung einer Person mit KI wirft Fragen auf.

Modelle für die Verarbeitung natürlicher Sprache (NLP) werden in der Regel primär auf muttersprachlichen englischen Texten trainiert, d. h. sie sind schlecht im Umgang mit Nicht-Muttersprachlern.

Diese Systeme könnten unbeabsichtigt Personen benachteiligen, deren Muttersprache nicht Englisch ist, oder Personen mit anderen kulturellen Merkmalen. Außerdem argumentieren Kritiker, dass Behinderungen in einem KI-Chat oder Videointerview möglicherweise nicht angemessen berücksichtigt werden, was zu weiterer potenzieller Diskriminierung führt.

Erschwerend kommt hinzu, dass die Bewerber oft nicht wissen, ob sie von einer KI beurteilt werden, so dass es unmöglich ist, notwendige Anpassungen im Interviewprozess zu verlangen.

Datensätze sind grundlegend

Datensätze sind hier von grundlegender Bedeutung. Trainieren Sie eine KI mit jahrzehntealten Daten, und sie lernt jahrzehntealte Werte.

Der Arbeitsmarkt ist seit der Jahrtausendwende deutlich vielfältiger geworden.

So gibt es in einigen Ländern mehr Frauen als Männer in einigen medizinischen Schlüsseldisziplinen wie Psychologie, Genetik, Pädiatrie und Immunologie.

Im Vereinigten Königreich, ein Bericht 2023 stellte fest, dass 27% der erwerbstätigen Frauen in "professionellen Berufen" (wie Ärzten, Ingenieuren, Krankenschwestern, Buchhaltern, Lehrern und Anwälten) arbeiteten, verglichen mit 26% der Männer, eine Tendenz, die in den letzten 5 bis 10 Jahren stetig zugenommen hat.

Solche Übergänge haben sich in den letzten 2 bis 5 Jahren beschleunigt - viele Datensätze sind älter und spiegeln einfach keine aktuellen Daten wider. Für Rasse und Behinderung gelten ähnliche Probleme wie für das Geschlecht.

Die Datensätze müssen unsere immer vielfältiger werdenden Arbeitsplätze widerspiegeln, um allen gerecht zu werden.

Auch wenn es noch viel zu tun gibt, um die Vielfalt am Arbeitsplatz zu gewährleisten, muss KI die Werte der Gegenwart übernehmen und nicht die der Vergangenheit. Das sollte ein absolutes Minimum sein, um faire und transparente KI für die Einstellung zu schaffen.

Die Entwickler von KI für die Personalbeschaffung werden wahrscheinlich mit strengen Vorschriften konfrontiert, da die USA, das Vereinigte Königreich, China, die EU-Mitgliedstaaten und viele andere Länder vorhaben Verschärfung der KI-Kontrollen in den kommenden Jahren.

Die Forschung ist noch nicht abgeschlossen, aber es ist unwahrscheinlich, dass die meisten KI bei der Personalauswahl die fairen und unvoreingenommenen Grundsätze anwenden, die wir von jedem anderen erwarten.