Daten sind das Lebenselixier der KI, aber sie sind keine unendliche Ressource. Können der Menschheit die Daten ausgehen? Was passiert, wenn dies der Fall ist?

Komplexe KI-Modelle erfordern große Mengen an Trainingsdaten. Für das Training eines großen Sprachmodells (LLM) wie ChatGPT werden zum Beispiel etwa 10 Billionen Wörter benötigt.

Einige Experten sind der Ansicht, dass das Angebot an hochwertigen Daten schwindet. Eine Studie von Forschern mehrerer Universitäten aus dem Jahr 2022 zum Beispiel erklärte, "Unsere Analyse deutet darauf hin, dass der Bestand an hochwertigen Sprachdaten bald erschöpft sein wird, wahrscheinlich vor 2026... Unsere Arbeit deutet darauf hin, dass sich der aktuelle Trend zu immer größeren ML-Modellen, die auf riesigen Datensätzen beruhen, verlangsamen könnte, wenn die Dateneffizienz nicht drastisch verbessert wird oder neue Datenquellen verfügbar werden."

Die Generierung synthetischer Daten bietet zwar eine Lösung, kann aber in der Regel nicht die Tiefe, Nuancierung und Varianz echter Daten erfassen.

Um die Situation weiter zu verkomplizieren, gibt es Bedenken darüber, was passiert, wenn KI anfängt, ihren eigenen Output zu verbrauchen, was nach Ansicht von Forschern der École Polytechnique Fédérale de Lausanne (EPFL) in der Schweiz geschieht bereits.

Ihre Untersuchungen deuten darauf hin, dass KI-Unternehmen, die von Menschen produzierte Daten über Plattformen wie Amazon Mechanical Turk kaufen, stattdessen möglicherweise KI-generierte Daten erhalten.

Was passiert, wenn KI beginnt, ihren eigenen Output zu essen? Kann dies vermieden werden?

Der Aufbau von Datensätzen ist teuer und zeitaufwändig - und es steht viel auf dem Spiel

Daten sind allgegenwärtig, aber ihre Operationalisierung für KI ist ein komplexer Prozess. Die Qualität der Daten und Beschriftungen wirkt sich auf die Leistung des Modells aus - es ist ein Fall von "Müll rein, Müll raus".

Um den Prozess der Erstellung von Datensätzen kurz zu beschreiben: Datenannotatoren (oder Beschrifter) nehmen verarbeitete Daten (z. B. ein ausgeschnittenes Bild) und beschriften Merkmale (z. B. ein Auto, eine Person, ein Vogel).

Dadurch erhalten die Algorithmen ein "Ziel", von dem sie lernen können. Die Algorithmen extrahieren und analysieren Merkmale aus markierten Daten, um diese Merkmale in neuen, ungesehenen Daten vorherzusagen.

Dies ist für das überwachte maschinelle Lernen erforderlich, das neben dem unüberwachten maschinellen Lernen und dem Reinforcement Learning zu den Kernbereichen des maschinellen Lernens gehört. Unter einige SchätzungenDer Prozess der Datenaufbereitung und -beschriftung nimmt 80% der Projektdauer eines Modells für maschinelles Lernen in Anspruch, aber wenn man zu viele Kompromisse eingeht, besteht die Gefahr, dass die Leistung des Modells beeinträchtigt wird.

Neben den praktischen Herausforderungen bei der Erstellung hochwertiger Datensätze ändert sich auch die Art der Daten selbst ständig. Was man vor 10 Jahren als "Datensatz mit einer typischen Auswahl an Fahrzeugen im Straßenverkehr" definiert hat, ist heute nicht mehr dasselbe. Heute ist zum Beispiel eine viel größere Anzahl von E-Scootern und E-Bikes auf den Straßen zu finden.

Diese werden als "Randfälle" bezeichnet, d. h. seltene Objekte oder Phänomene, die in Datensätzen nicht vorkommen.

Modelle spiegeln die Qualität ihrer Datensätze wider

Wenn Sie ein modernes KI-System auf einem alten Datensatz trainieren, besteht die Gefahr, dass das Modell eine geringe Leistung erbringt, wenn es mit neuen, ungesehenen Daten konfrontiert wird.

Zwischen 2015 und 2020 deckten Forscher erhebliche strukturelle Verzerrungen in KI-Algorithmen auf, die zum Teil auf das Training von Modellen mit alten und verzerrten Daten zurückzuführen waren.

Zum Beispiel, die Beschriftete Gesichter im Wilden Heim (LFW)ein Datensatz mit prominenten Gesichtern, der häufig für die Gesichtserkennung verwendet wird, besteht aus 77,5%-Männer und 83,5%-Weißhäutige Personen. Eine KI hat keine Chance, richtig zu funktionieren, wenn die Daten nicht alle Personen repräsentieren, die sie bedienen soll. Die Fehlerquoten der besten Algorithmen bei der Gesichtserkennung lagen bei 0,8% für weiße Männer und bei 34,7% für dunkelhäutige Frauen.

Diese Forschung gipfelte in dem bahnbrechenden Gender Shades Studie und einen Dokumentarfilm mit dem Titel Codierte Verzerrungin der untersucht wurde, wie KI wahrscheinlich aus fehlerhaften und nicht repräsentativen Daten lernt.

Die Auswirkungen sind alles andere als harmlos - dies hat zu falschen Gerichtsurteilen, falschen Inhaftierungen und zur Verweigerung von Arbeitsplätzen und Krediten für Frauen und andere Gruppen geführt.

KI benötigt mehr hochwertige Daten, die fair und repräsentativ sein müssen - Es ist eine schwer zu fassende Kombination.

Sind synthetische Daten die Antwort?

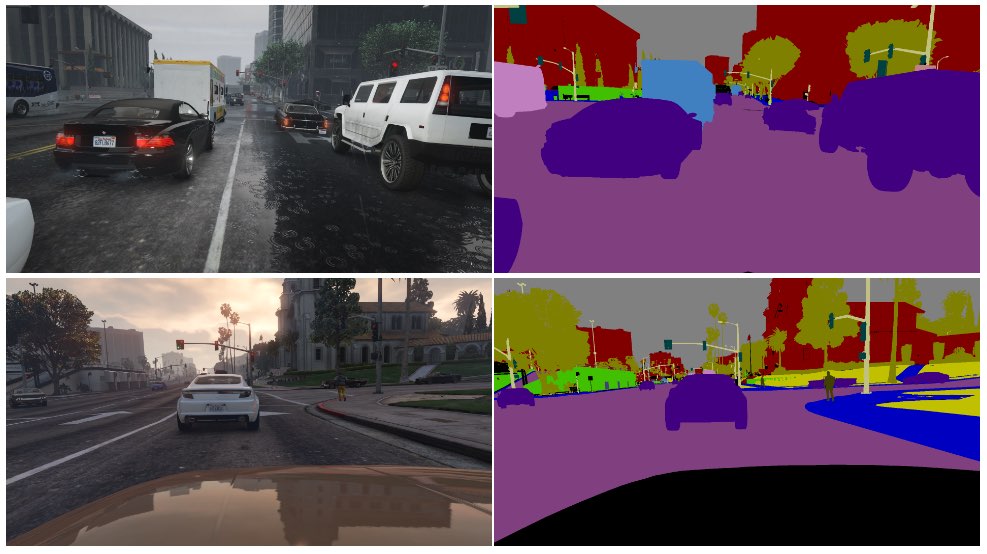

Synthetische Daten werden häufig in der Computer Vision (CV) verwendet, wo KI Objekte und Merkmale aus Bildern und Videos identifizieren.

Anstatt Bilddaten in der realen Welt zu sammeln - wie z. B. das Fotografieren oder Filmen einer Straße -, was eine technische Herausforderung darstellt und Probleme mit dem Datenschutz mit sich bringt, werden die Daten einfach in einer virtuellen Umgebung erzeugt.

Dies ergänzt die KI zwar um mehr Daten, hat aber auch einige Nachteile:

- Es ist nicht einfach, reale Szenarien in einer virtuellen Umgebung zu modellieren.

- Die Erzeugung großer Mengen synthetischer Daten ist nach wie vor kostspielig und zeitaufwändig.

- Grenzfälle und Ausreißer bleiben ein Problem.

- Es kann die Realität nicht perfekt nachbilden.

- Andererseits könnten einige Aspekte zu perfekt sein, und es ist schwierig festzustellen, was noch fehlt.

Synthetische Daten eignen sich hervorragend für leicht zu virtualisierende Umgebungen, wie z. B. eine Fabrikhalle, aber nicht immer für schnelllebige reale Umgebungen wie eine Straße.

Wie steht es mit der Erzeugung synthetischer Textdaten?

Text ist einfacher als Bild- oder Videodaten. Können also Modelle wie ChatGPT verwendet werden, um nahezu unbegrenzte synthetische Trainingsdaten zu erzeugen?

Ja, aber es ist riskant, und die Auswirkungen sind nicht leicht vorherzusagen. Synthetische Textdaten können zwar beim Abstimmen, Testen und Optimieren von Modellen helfen, sind aber nicht ideal, um Modellen neues Wissen beizubringen, und könnten Verzerrungen und andere Probleme verstärken.

Hier eine Analogie, warum das Training von KI mit KI-generierten Daten problematisch ist:

- Stellen Sie sich eine Schule vor, die mit den besten Lehrbüchern der Welt arbeitet, um ihren Schülern innerhalb eines Tages alles zu vermitteln, was sie aus ihren Ressourcen wissen müssen.

- Danach beginnt die Schule, auf der Grundlage dieses Wissens ihre eigene Arbeit zu produzieren - analog zum Output eines Chatbots. Die Schüler haben aus allen Daten gelernt, die bis zum Beginn der Ausbildung verfügbar waren, aber sie können danach keine neuen Daten mehr effizient in das Wissenssystem einspeisen.

- Wissen wird täglich neu geschaffen - während der Großteil des menschlichen Wissens vor einem bestimmten Tag geschaffen wurde, entwickelt sich das Wissen im Laufe der Zeit weiter und verändert sich. Entscheidend ist, dass wir Menschen nicht nur ständig neues Wissen schaffen, sondern auch unsere Sichtweise auf vorhandenes Wissen ändern.

- Nehmen wir nun an, dass die Schule, die keine Daten mehr hat, damit beginnt, ihre Schüler anhand ihrer eigenen Ergebnisse zu unterrichten. Die Schüler beginnen, ihre Inhalte zu "fressen", um neue Inhalte zu produzieren.

- In diesem Stadium passt sich der Output der Schüler nicht mehr an die reale Welt an und sein Nutzen nimmt ab. Das System erbricht seine eigene Arbeit. Die Arbeit kann sich zwar anpassen und weiterentwickeln, aber sie tut dies isoliert von allem, was außerhalb dieser Rückkopplungsschleife liegt.

Die KI stellt die Menschen ständig vor Rätsel, die es zu lösen gilt, und diese hat eine Menge von Kommentatoren auf Reddit und die Y Combinator-Forum verblüfft.

Das ist eine verblüffende Sache, und es gibt keinen wirklichen Konsens über die Auswirkungen.

Menschliche Datenbeschrifter nutzen oft KI, um Daten zu erstellen

Es gibt noch eine weitere, unvorhergesehene Ebene des Problems, qualitativ hochwertige Trainingsdaten zu erzeugen.

Crowdworking-Plattformen wie Amazon Mechanical Turk (MTurk) werden regelmäßig von KI-Unternehmen genutzt, die echte "menschliche" Datensätze erstellen wollen. TEs besteht die Befürchtung, dass Datenkommentatoren auf diesen Plattformen KI einsetzen, um ihre Aufgaben zu erfüllen.

Forscher der École Polytechnique Fédérale de Lausanne (EPFL) in der Schweiz analysierten Daten, die über MTurk erstellt wurden, um herauszufinden, ob Arbeitnehmer KI zur Erstellung ihrer Beiträge verwendeten.

Die Studiedie am 13. Juni veröffentlicht wurde, beauftragte 44 MTurk-Teilnehmer damit, die Zusammenfassungen von 16 medizinischen Forschungsarbeiten zusammenzufassen. Dabei wurde festgestellt, dass 33% bis 46% der Nutzer auf der Plattform ihre Beiträge mit KI erstellten, obwohl sie aufgefordert wurden, in natürlicher Sprache zu antworten.

"Wir haben eine sehr spezifische Methode entwickelt, die in unserem Szenario sehr gut für die Erkennung von synthetischem Text funktioniert", erklärt Manoel Ribeiro, Mitautor der Studie und Doktorand an der EPFL, gegenüber The Register diese Woche.

Auch wenn der Datensatz und die Stichprobengröße der Studie recht klein sind, ist es durchaus denkbar, dass KI unwissentlich auf KI-generierte Inhalte trainiert wird.

In der Studie geht es nicht darum, den MTurk-Mitarbeitern die Schuld zu geben - die Forscher weisen darauf hin, dass niedrige Löhne und repetitive Arbeit zu diesem Problem beitragen. KI-Unternehmen wollen qualitativ hochwertige, von Menschen erstellte Daten und gleichzeitig die Kosten niedrig halten. Ein Kommentator sagte auf Reddit: "Ich bin derzeit einer dieser Arbeiter, der Bard trainieren soll. Ich benutze dafür ganz sicher ChatGPT. 20$/Std. ist nicht genug für die schreckliche Behandlung, die wir bekommen, also werde ich jeden Cent aus diesem ******* Job herausquetschen."

Der Kaninchenbau wird sogar noch tiefer, da KI oft auf Daten trainiert wird, die aus dem Internet stammen. Da immer mehr von KI geschriebene Inhalte online veröffentlicht werden, wird die KI unweigerlich aus ihren eigenen Ergebnissen lernen.

In dem Maße, in dem sich die Menschen bei der Informationsbeschaffung auf KI verlassen, wird die Qualität ihrer Ergebnisse immer wichtiger. Wir müssen innovative Methoden finden, um KIs mit frischen, authentischen Daten zu versorgen.

Ribeiro sagt: "Menschliche Daten sind der Goldstandard, denn wir interessieren uns für Menschen, nicht für große Sprachmodelle."

Die Arbeiten zur Analyse der potenziellen Auswirkungen von KI, die ihre eigenen Ergebnisse konsumiert, sind noch nicht abgeschlossen, aber authentische menschliche Daten sind nach wie vor von entscheidender Bedeutung für eine breite Palette von Aufgaben des maschinellen Lernens.

Die Generierung riesiger Datenmengen für hungrige KI bei gleichzeitiger Beherrschung der Risiken ist eine Aufgabe, die noch nicht abgeschlossen ist.