KI-Forscher in Stanford bewerteten die Konformität von 10 führenden KI-Modellen mit dem vorgeschlagenen EU-KI-Gesetz und stellten große Unterschiede fest, wobei die Ergebnisse im Allgemeinen eher mäßig waren.

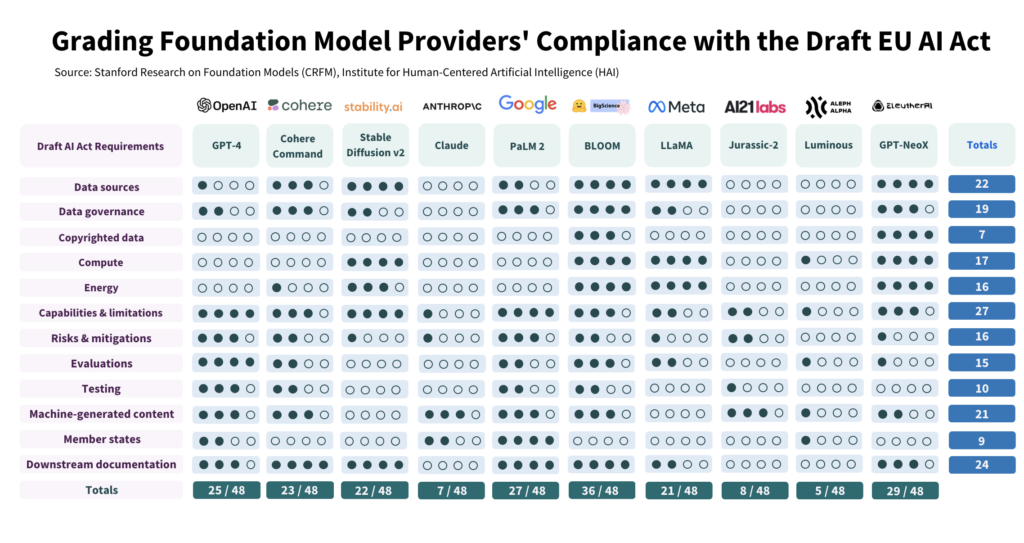

Die Studie hat 10 KI-Modelle anhand von 12 Kriterien des EU-Gesetzesentwurfs kritisch geprüft und festgestellt, dass es große Unterschiede bei der Einhaltung der Kriterien gibt, wobei kein Modell alle Kriterien erfüllt.

Die Studie verdeutlicht die Kluft zwischen den Erwartungen des KI-Gesetzes und den derzeitigen Governance-Bemühungen führender KI-Entwickler.

Um dem Gesetz zu entsprechen, müssen die Entwickler ihre Transparenz und ihre Strategien zur Risikominderung erheblich verbessern, die in einigen Fällen fast völlig fehlen.

Wie die Studie durchgeführt wurde

Die Autoren haben das AI-Gesetz eingehend untersucht und 22 Anforderungen herausgearbeitet.

Daraus wählten sie 12 aus, die mit Hilfe öffentlicher Informationen sinnvoll bewertet werden konnten. Anschließend erstellten sie eine 5-Punkte-Rubrik für jede dieser 12 Anforderungen.

Das von Hugging Face erstellte Open-Source-KI-Modell BLOOM erzielte mit 36 von 48 möglichen Punkten die höchste Punktzahl.

Dagegen schnitten das von Google unterstützte Unternehmen Anthropic und das deutsche KI-Unternehmen Aleph Alpha mit 7 bzw. 5 Punkten deutlich schlechter ab. ChatGPT lag mit 25/48 Punkten im Mittelfeld.

Die vier wichtigsten Bereiche, in denen die Vorschriften nicht eingehalten werden, sind urheberrechtlich geschützte Daten, Energie, Risikominderung und Bewertung/Prüfung.

Einer der Autoren, Kevin Klyman, Forscher am Stanford's Center for Research on Foundation Models, merkte an, dass die meisten Entwickler ihre Risikominderungsstrategien nicht offenlegen, was ein Grund zum Handeln sein könnte. Klyman sagte: "Die Anbieter legen die Wirksamkeit ihrer Risikominderungsmaßnahmen oft nicht offen, was bedeutet, dass wir nicht sagen können, wie riskant manche Stiftungsmodelle sind."

Außerdem gibt es große Unterschiede bei den Trainingsdaten, die zum Trainieren der Modelle verwendet werden. Die EU wird von KI-Entwicklern verlangen, ihre Datenquellen transparenter zu machen, was 4/10 der Entwickler nicht tun. ChatGPT hat in diesem Bereich nur 1 Punkt erreicht.

Open Source versus proprietäre Modelle

In dem Bericht wurde auch ein deutlicher Unterschied bei der Einhaltung der Vorschriften festgestellt, je nachdem, ob es sich um ein Open-Source- oder ein proprietäres Modell handelt.

Open-Source-Modelle erzielten gute Ergebnisse bei der Offenlegung von Ressourcen und Datenanforderungen, aber ihre Risiken sind weitgehend undokumentiert.

Proprietäre Modelle sind das Gegenteil: Sie sind umfassend getestet und mit robusten Risikominderungsstrategien dokumentiert, aber in Bezug auf Daten und technologiebezogene Metriken intransparent.

Oder, um es auf den Punkt zu bringen, Open-Source-Entwickler haben nicht so viele Wettbewerbsgeheimnisse zu schützen, aber ihre Produkte sind von Natur aus risikoreicher, da sie von fast jedem verwendet und verändert werden können.

Umgekehrt werden private Entwickler wahrscheinlich Aspekte ihrer Modelle unter Verschluss halten, können aber Sicherheit und Risikominderung nachweisen. Selbst Microsoft, der Hauptinvestor von OpenAI, ist sich nicht ganz sicher verstehen, wie die Modelle von OpenAI funktionieren.

Was wird in der Studie empfohlen?

Die Autoren der Studie räumen ein, dass die Kluft zwischen den Erwartungen der EU und der Realität alarmierend ist, und geben mehrere Empfehlungen an politische Entscheidungsträger und Modellentwickler ab.

Die Studie empfiehlt den politischen Entscheidungsträgern der EU:

- Verfeinerung und Präzisierung der Parameter des EU-KI-Gesetzes: Die Forscher argumentieren, dass die technische Sprache und die Parameter des KI-Gesetzes nicht ausreichend spezifiziert sind.

- Förderung von Transparenz und Rechenschaftspflicht: Die Forscher argumentieren, dass die strengsten Vorschriften auf die allergrößten und marktbeherrschenden Entwickler ausgerichtet sein sollten, was zu einer wirksameren Durchsetzung führen dürfte.

- Ausreichende Ressourcen für die Durchsetzung bereitstellen: Damit das EU-Gesetz über künstliche Intelligenz wirksam durchgesetzt werden kann, sollten den Durchsetzungsbehörden technische Ressourcen und Talente zur Verfügung gestellt werden.

Die Studie empfiehlt den politischen Entscheidungsträgern weltweit:

- Vorrang für Transparenz: Die Forscher betonen, dass Transparenz entscheidend ist und im Mittelpunkt der politischen Bemühungen stehen sollte. Sie argumentieren, dass die Lehren aus der Regulierung sozialer Medien die schädlichen Folgen mangelnder Transparenz aufzeigen, die sich im Kontext der KI nicht wiederholen sollten.

- Klärung von Urheberrechtsfragen: Die Grenzen des Urheberrechts für KI-Trainingsdaten und KI-Ergebnisse werden kontrovers diskutiert. Angesichts der geringen Compliance bei der Offenlegung urheberrechtlich geschützter Trainingsdaten argumentieren die Forscher, dass rechtliche Richtlinien festlegen müssen, wie das Urheberrecht mit den Trainingsverfahren und dem Output generativer Modelle interagiert. Dazu gehört die Festlegung der Bedingungen, unter denen das Urheberrecht oder Lizenzen während des Trainings respektiert werden müssen, und die Bestimmung, wie maschinengenerierte Inhalte das Urheberrecht verletzen könnten.

Die Studie empfiehlt den Entwicklern von Stiftungsmodellen:

- Streben nach kontinuierlicher Verbesserung: Die Anbieter sollten stets bestrebt sein, ihre Compliance zu verbessern. Größere Anbieter, wie z. B. OpenAI, sollten mit gutem Beispiel vorangehen und Ressourcen an nachgelagerte Kunden weitergeben, die über eine API auf ihre Modelle zugreifen.

- Befürwortung von Industriestandards: Modellanbieter sollten zur Festlegung von Branchenstandards beitragen, die zu einem transparenteren und verantwortungsvolleren KI-Ökosystem führen können.

Auch wenn die von führenden Entwicklern wie OpenAI aufgestellten Risiko- und Überwachungsstandards einige positive Aspekte aufweisen, sind die Mängel in Bereichen wie dem Urheberrecht alles andere als ideal.

Was die Anwendung von Vorschriften auf KI als allumfassende Kategorie betrifft - das könnte sich in der Tat als sehr schwierig erweisen - da kommerzielle und Open-Source-Modelle strukturell unterschiedlich sind und sich nur schwer in einen Topf werfen lassen.