I takt med at AI bliver mere og mere integreret i rekrutteringsprocesserne, er det klart, at teknologiens løfte om effektivitet har sine egne risici.

Ifølge 2022-dataI dag bruger ca. 55% af virksomhederne allerede AI-værktøjer til rekruttering.

Mens AI har fremskyndet den traditionelle ansættelsespraksis og elimineret bunker af CV'er i processen, har den også rejst kritiske spørgsmål om retfærdighed, partiskhed og selve den menneskelige beslutningstagnings natur.

Når alt kommer til alt, er AI'er trænet på menneskelige data, så de kan arve alle de fordomme, de lover at udrydde.

Er det noget, vi kan ændre på? Hvad har vi lært af AI-rekruttering indtil videre?

Meta beskyldes for diskriminerende annoncepraksis af menneskerettighedsgrupper

Data viser, at nogle 79% af jobsøgende bruger sociale medier til at søge job, og beviserne viser, at det er her, diskriminationen begynder.

Meta er i øjeblikket udsat for flere beskyldninger fra europæiske menneskerettighedsorganisationer, der hævder, at Facebooks algoritme til målretning af jobannoncer er partisk.

I juni blev NGO'en Global Witness undersøgte flere automatisk målrettede Facebook-jobannoncer og fandt ud af, at mange opretholdt kønsfordomme.

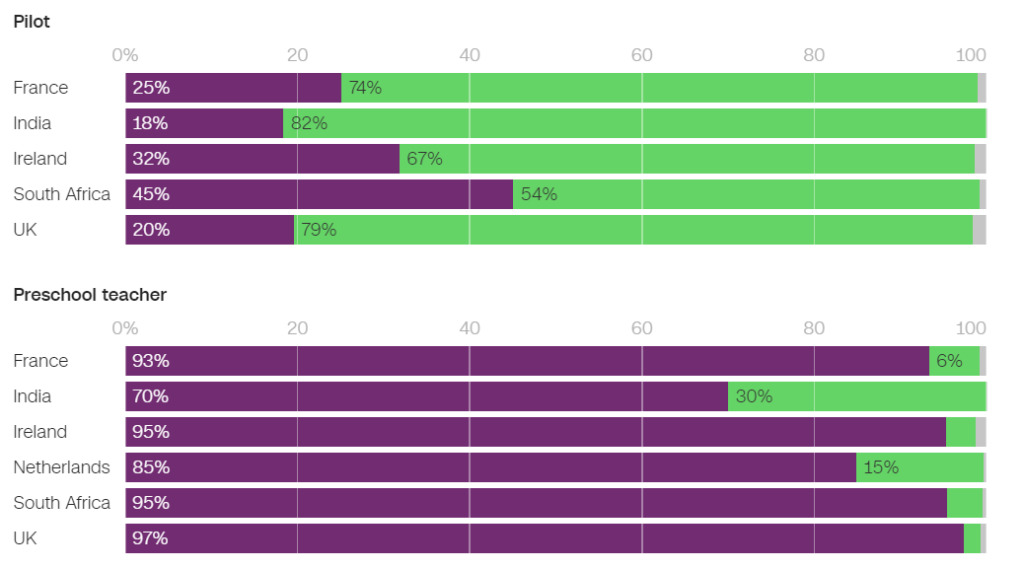

For eksempel var der betydeligt større sandsynlighed for, at mænd fik vist annoncer relateret til ingeniørarbejde, mens kvinder var betydeligt mere tilbøjelige til at få vist annoncer relateret til undervisning.

Af de annoncer, der blev vist i Frankrig, var 93% af de brugere, der fik vist en jobannonce for en børnehavepædagog, og 86% af dem, der fik vist en jobannonce for en psykolog, kvinder. Omvendt fik kun 25% af kvinderne vist en jobannonce for en pilot, og kun 6% fik vist en jobannonce for en mekaniker.

I Holland var 85% af de brugere, der fik vist en jobannonce for en lærer, og 96% af dem, der fik vist en jobannonce for en receptionist, kvinder. Lignende resultater blev observeret i mange andre lande, herunder Storbritannien, Indien og Sydafrika.

I en Interview med CNNNaomi Hirst fra Global Witness sagde: "Vores bekymring er, at Facebook forværrer de fordomme, vi lever med i samfundet, og faktisk ødelægger mulighederne for fremskridt og lighed på arbejdspladsen."

Sammen med Bureau Clara Wichmann og Fondation des Femmes har Global Witness klaget over Meta til menneskerettigheds- og databeskyttelsesmyndigheder i Frankrig og Holland.

Grupperne opfordrer til en undersøgelse af, om Metas praksis overtræder menneskerettighederne eller databeskyttelseslovene. Hvis anklagerne holder, kan Meta blive pålagt bøder og sanktioner.

Som svar sagde en talsmand for Meta: "Systemet tager højde for forskellige former for information for at forsøge at vise folk de annoncer, de vil være mest interesserede i."

Det er ikke første gang, Meta har afvist sådan en kritik - virksomheden stod over for Flere retssager i 2019 og forpligtet sig til at ændre sit annoncesystem for at undgå bias baseret på beskyttede karakteristika som køn og race.

Pat de Brún fra Amnesty International var skarp i sin kritik af Global Witness' resultater. "Forskning viser konsekvent, hvordan Facebooks algoritmer leverer dybt ulige resultater og ofte forstærker marginalisering og diskrimination," sagde hun til CNN.

Amazon skrotter hemmeligt AI-rekrutteringsværktøj, der viste bias mod kvinder

Amazon udviklede et AI-rekrutteringsværktøj mellem 2014 og 2017, før det gik op for dem, at værktøjet var partisk i udvælgelsen af softwareudviklerjobs og andre tekniske stillinger. I 2018 havde Amazon helt droppet værktøjet.

AI-systemet straffede CV'er, der indeholdt ordet "kvinder" og "kvinders", og nedgraderede kvindelige kandidaters færdigheder.

Systemet fejlede, selv efter at Amazon forsøgte at redigere algoritmerne for at gøre dem kønsneutrale.

Det viste sig senere, at Amazon havde trænet værktøjet på CV'er, der var blevet indsendt til virksomheden over en 10-årig periode, hvoraf de fleste kom fra mænd.

Som mange andre AI-systemer blev Amazons værktøj påvirket af de data, det blev trænet på, hvilket førte til utilsigtet bias. Denne bias favoriserede mandlige kandidater og foretrak CV'er, der brugte et sprog, der var mere almindeligt i mandlige ingeniørers CV'er.

På grund af problemer med de underliggende data anbefalede systemet desuden ofte ukvalificerede kandidater til forskellige job.

Den Verdens økonomiske forum sagde om Amazons rekrutteringssystem: "For eksempel - som i Amazons tilfælde - kan stærke kønsforskelle hænge sammen med den type undersøgelse, der er foretaget. Disse skævheder i træningsdata kan også opstå på grund af dårlig datakvalitet eller meget små, ikke-diverse datasæt, hvilket kan være tilfældet for virksomheder, der ikke opererer globalt og søger efter nichekandidater."

Det lykkedes Amazon at genbruge en "udvandet version" af rekrutteringsmotoren til rudimentære opgaver, såsom at fjerne duplikerede kandidatprofiler fra databaser.

De oprettede et nyt team, som skulle gøre endnu et forsøg med automatiseret screening af ansættelser, denne gang med fokus på at fremme mangfoldighed.

Google kæmper med sine egne problemer med diskrimination og bias

I december 2020 meddelte Dr. Timnit Gebru, en førende AI-etiker hos Google, at den Virksomheden havde fyret hende.

Opsigelsen kom, efter at Dr. Gebru udtrykte bekymring over Googles tilgang til ansættelse af minoriteter og iboende bias i AI-systemer.

Før han forlod virksomheden, var Dr. Gebru klar til at udgive en artikel, der fremhævede bias i Googles AI-modeller.

Efter at have indsendt artiklen til en akademisk konference afslørede Gebru, at en Google-manager bad hende om at trække artiklen tilbage eller fjerne navnene på hende selv og de andre Google-forskere. Da hun nægtede at efterkomme dette, accepterede Google en betinget fratrædelse og opsagde dermed Dr. Gebru's stilling med det samme.

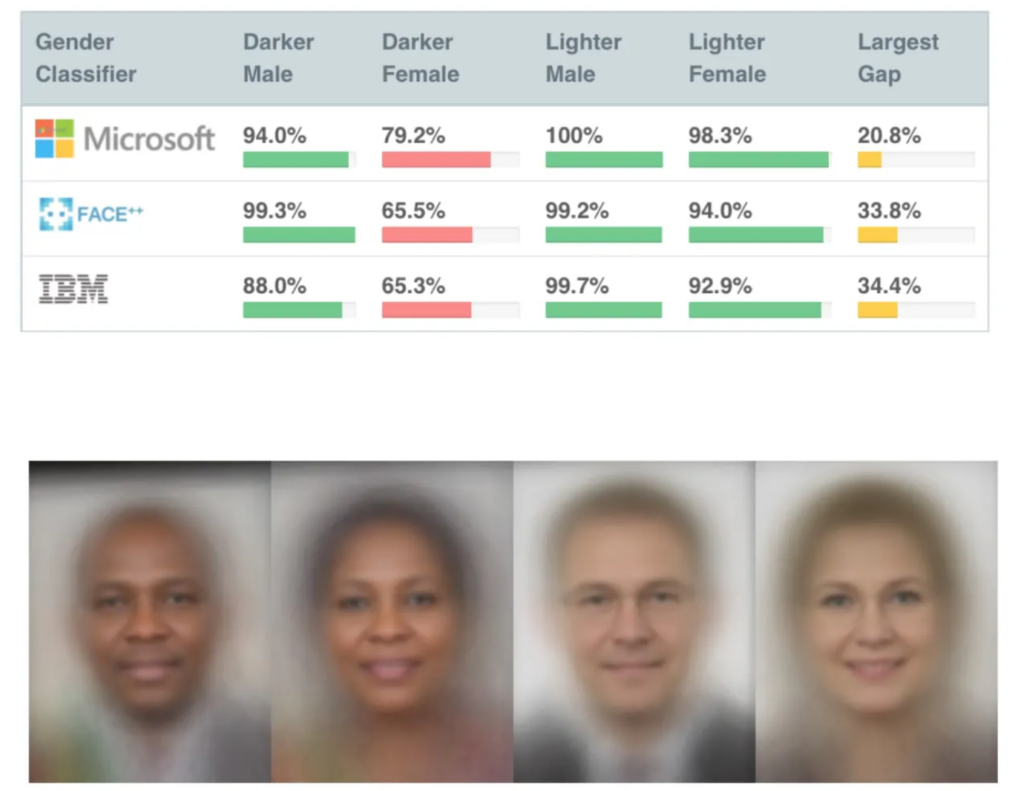

Det var ikke længe efter, at flere meget indflydelsesrige studier om AI-bias blev offentliggjort, herunder MIT's undersøgelse af kønsnuancersom er blevet en af de mest citerede AI-artikler nogensinde.

Gender Shades-undersøgelsen afslørede bias i ansigtsgenkendelses-AI'er, som fejlidentificerede sorte ansigter ca. 30% til 35% af tiden sammenlignet med ca. 5% for hvide ansigter.

Forkerte ansigtsgenkendelsesmatches førte til uretmæssig anholdelse og fængsling af flere mænd i USA.

Gebru's fyring skabte en mediestorm omkring diskriminerende praksis i Silicon Valley.

Mutale Nkonde fra Stanford Digital Civil Society Lab sagde: "Hendes fyring viser kun, at forskere, aktivister og akademikere, der ønsker at arbejde inden for dette område - og som er sorte kvinder - ikke er velkomne i Silicon Valley."

Dr. Gebru's fyring inspirerede til en anden undersøgelse, Afdækning af kodede fordommesom viste, at sorte mennesker var betydeligt mere tilbøjelige til at blive undervurderet af rekrutterings-AI end alle andre.

"Denne rapport fandt rigelig dokumentation for, at sorte studerende og fagfolk er bekymrede for at blive udsat for anti-sort bias under ansættelsesprocessen. Lidt over halvdelen af alle respondenter rapporterer, at de har observeret partiskhed i ansættelses- eller rekrutteringsprocessen på ansættelses- eller rekrutteringswebsteder. Sorte fagfolk er lidt mere tilbøjelige til at have observeret sådanne fordomme, idet 55 % af de adspurgte angiver at have observeret fordomme i ansættelsesprocessen," - Afsløring af kodede fordomme, Penn Law Policy Lab.

I artiklen står der: "Den offentlige samtale, som Dr. Gebru og hendes kolleger ansporede til om algoritmisk bias, gjorde det muligt for vores laboratorium at deltage i denne nationale dialog og udvide en mere nuanceret forståelse af algoritmisk bias i ansættelsesplatforme."

Afsløringen af problemet har været en katalysator for forandring, men AI har en lang vej at gå for at forene sin rolle i følsom menneskelig beslutningstagning.

AI's rolle i rekrutteringen: at redde nogle positive ting

På trods af mange kontroverser har det været svært for virksomheder at modstå AI's enorme potentiale til at fremskynde rekruttering.

AI's rolle i rekrutteringen giver bestemt en vis logisk mening - det er måske lettere at fjerne fordomme fra AI end fra mennesker. Når alt kommer til alt, er AI *bare* matematik og kode - det er vel mere formbart end dybt forankrede ubevidste fordomme?

Og mens træningsdata var stærkt forudindtaget i begyndelsen og midten af 2010'erne, primært på grund af mangel på forskellige datasæt, er det uden tvivl blevet bedre siden.

Et fremtrædende AI-rekrutteringsværktøj er Sapiasom kaldes en 'smart interviewer'. Ifølge Sapias grundlægger, Barb Hyman, giver AI mulighed for en "blind" interviewproces, der ikke baserer sig på CV'er, sociale medier eller demografiske data, men udelukkende på ansøgerens svar, hvilket eliminerer de fordomme, der er fremherskende i menneskestyret ansættelse.

Disse systemer kan give alle en fair chance ved at interviewe alle ansøgere. Hyman foreslår"Der er dobbelt så stor sandsynlighed for at få kvinder og fastholde kvinder i ansættelsesprocessen, når du bruger AI."

Men selv selve processen med at interviewe en person med AI rejser spørgsmål.

NLP-modeller (Natural Language Processing) er generelt primært trænet på engelske tekster, hvilket betyder, at de er dårlig til at håndtere ikke-indfødt engelsk.

Disse systemer kan utilsigtet straffe personer, der ikke har engelsk som modersmål, eller personer med andre kulturelle træk. Desuden hævder kritikere, at der måske ikke tages tilstrækkeligt hensyn til handicap i en AI-chat eller et videointerview, hvilket fører til yderligere potentiel diskrimination.

Dette forværres af, at ansøgere ofte ikke ved, om en AI vurderer dem, hvilket gør det umuligt at anmode om nødvendige justeringer af interviewprocessen.

Datasæt er grundlæggende

Datasæt er grundlæggende her. Træn en AI på ti år gamle data, og den lærer ti år gamle værdier.

Arbejdsmarkedet er blevet betydeligt mere mangfoldigt siden årtusindskiftet.

I nogle lande er der f.eks. flere kvinder end mænd inden for flere vigtige medicinske discipliner som psykologi, genetik, pædiatri og immunologi.

I Storbritannien, en rapport fra 2023 fandt, at 27% af de beskæftigede kvinder arbejdede i "professionelle erhverv" (såsom læger, ingeniører, sygeplejersker, revisorer, lærere og advokater) sammenlignet med 26% af mændene, en tendens, der er steget støt i løbet af 5 til 10 år.

Sådanne overgange er accelereret i de sidste 2 til 5 år - mange datasæt er ældre og afspejler simpelthen ikke de seneste data. De samme problemer gør sig gældende for race og handicap som for køn.

Datasættene skal afspejle vores stadig mere forskelligartede arbejdspladser, så alle får en retfærdig behandling.

Selv om der stadig er et stort arbejde at gøre for at sikre mangfoldighed på arbejdspladsen, skal AI arve værdier fra nutiden og ikke fra fortiden. Det bør være et absolut minimum for at kunne producere fair og gennemsigtige rekrutterings-AI'er.

Udviklerne af AI til rekruttering står sandsynligvis over for hård regulering, idet USA, Storbritannien, Kina, EU-medlemslande og mange andre lande er indstillet på at skærp kontrollen med AI i løbet af de kommende år.

Forskningen er i gang, men det er stadig usandsynligt, at de fleste rekrutterings-AI'er anvender de retfærdige og upartiske principper, vi forventer af hinanden.