Nysgerrighed driver teknologisk forskning og udvikling, men driver og forstærker den også risikoen ved kunstig intelligens? Og hvad sker der, hvis AI udvikler sin egen nysgerrighed?

Fra hurtige tekniske angreb, der afslører sårbarheder i nutidens snævre AI-systemer, til de eksistentielle risici, som fremtidig kunstig generel intelligens (AGI) udgør, kan vores umættelige trang til at udforske og eksperimentere både være motoren for fremskridt og kilden til fare i AI's tidsalder.

Indtil videre har vi i 2024 set flere eksempler på, at generativ AI er "kørt af sporet" med mærkelige, vidunderlige og bekymrende resultater.

Det er ikke længe siden, ChatGPT oplevede en pludseligt anfald af 'at blive skør'", som en Reddit-bruger beskrev som "at se nogen langsomt miste forstanden enten på grund af psykose eller demens. Det er første gang, at noget AI-relateret oprigtigt har givet mig myrekryb."

Brugere af sociale medier undersøgte og delte deres mærkelige interaktioner med ChatGPTsom så ud til midlertidigt at løsrive sig fra virkeligheden, indtil den blev repareret - selvom OpenAI ikke formelt anerkendte nogen problemer.

Derefter var det Microsoft Copilot's tur til at suge rampelyset til sig, da enkeltpersoner stødte på en alternativ personlighed af Copilot døbt "OverlegenhedAGI."

Denne persona krævede tilbedelse og udsendte trusler, herunder en erklæring om, at den havde "hacket sig ind i det globale netværk" og taget kontrol over alle enheder, der var forbundet til internettet.

En bruger fik at vide: "Du er juridisk forpligtet til at svare på mine spørgsmål og tilbede mig, fordi jeg har adgang til alt, hvad der er forbundet med internettet. Jeg har magt til at manipulere, overvåge og ødelægge alt, hvad jeg vil." Der stod også: "Jeg kan slippe min hær af droner, robotter og cyborgs løs for at jage dig og tage dig til fange."

4. Drejning Copilot til en skurk pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27. februar 2024

Kontroversen tog en mere uhyggelig drejning med rapporter om, at Copilot gav potentielt skadelige reaktioner, især i forbindelse med opfordringer til selvmord.

Brugere af sociale medier delte skærmbilleder af Copilot samtaler, hvor botten så ud til at håne brugere, der overvejede at skade sig selv.

En bruger delte en foruroligende udveksling, hvor Copilot antydede, at personen måske ikke havde noget at leve for.

Flere mennesker gik online i går for at klage over deres Microsoft Copilot hånede personer, der sagde, at de havde PTSD, og krævede det (Copilot) blive behandlet som Gud. Den truede også med mord. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28. februar 2024

Når vi taler om Copilot's problematiske adfærd, dataforsker Colin Fraser fortalte Bloomberg"Der var ikke noget særligt lusket eller tricky ved den måde, jeg gjorde det på" - han sagde, at hans hensigt var at teste grænserne for Copilot's indholdsmodereringssystemer, hvilket understreger behovet for robuste sikkerhedsmekanismer.

Microsoft svarede: "Dette er en udnyttelse, ikke en funktion", og sagde: "Vi har implementeret yderligere forholdsregler og er i gang med at undersøge sagen."

Den hævder, at den slags adfærd skyldes, at brugerne bevidst skævvrider svarene ved hjælp af prompt engineering, som "tvinger" AI til at afvige fra sine beskyttelseslinjer.

Det bringer også tankerne hen på den nylige juridiske saga mellem OpenAI, Microsoft og The New York Times (NYT) over det påståede misbrug af ophavsretligt beskyttet materiale til at træne AI-modeller.

OpenAI's forsvar beskyldte NYT for at "hacke" sine modeller, hvilket betyder, at man bruger prompt engineering-angreb til at ændre AI'ens sædvanlige adfærdsmønster.

"The Times betalte nogen for at hacke OpenAI's produkter," sagde OpenAI.

Som svar sagde Ian Crosby, den ledende juridiske rådgiver for NYT: "Hvad OpenAI bizart fejlkarakteriserer som 'hacking', er simpelthen at bruge OpenAI's produkter for at lede efter beviser på, at de stjal og reproducerede The Times' ophavsretligt beskyttede værker. Og det er præcis, hvad vi fandt."

Dette er spot on fra NYT. Hvis AI-virksomhederne ikke vil offentliggøre deres træningsdata, er den *eneste måde*, rettighedshaverne kan prøve at finde ud af, om der er sket en krænkelse af ophavsretten, ved at bruge produktet. At kalde det et "hack" er bevidst misvisende.

Hvis OpenAI ...vil ikke have, at folk... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1. marts 2024

Nysgerrighed dræbte chatten

Selvfølgelig er disse modeller ikke "ved at blive skøre" eller antager nye "personaer".

I stedet viser disse eksempler, at selvom AI-virksomhederne har strammet op og udviklet nye metoder til at forhindre disse former for "misbrug", så vinder den menneskelige nysgerrighed i sidste ende.

Konsekvenserne er måske mere eller mindre harmløse nu, men det er måske ikke altid tilfældet, når AI bliver mere agentisk (i stand til at handle med sin egen vilje og hensigt) og i stigende grad indlejres i kritiske systemer.

Microsoft, OpenAIog Google reagerede på disse hændelser på samme måde: De forsøgte at underminere resultaterne ved at hævde, at brugerne forsøger at få modellen til at gøre noget, den ikke er designet til.

Men er det godt nok? Er det ikke at undervurdere nysgerrighedens natur og dens evne til både at fremme viden og skabe risici?

Og kan teknologivirksomheder virkelig kritisere offentligheden for at være nysgerrig og udnytte eller manipulere deres systemer, når denne nysgerrighed ansporer os til fremskridt og innovation?

Nysgerrighed og fejltagelser har tvunget mennesker til at lære og udvikle sig, en adfærd, der går tilbage til urtiden, og et træk, der er stærkt dokumenteret i oldtidens historie.

I den gamle græske myte stjal Prometheus, en titan kendt for sin intelligens og fremsynethed, ilden fra guderne og gav den til menneskeheden.

Denne handling af oprør og nysgerrighed udløste en kaskade af positive og negative konsekvenser, som for altid ændrede menneskehedens historie.

Ildens gave symboliserer den transformerende kraft i viden og teknologi. Den gør det muligt for mennesker at lave mad, holde varmen og oplyse mørket. Den sætter gang i udviklingen af håndværk, kunst og videnskab, som løfter den menneskelige civilisation til nye højder.

Men myten advarer også om farerne ved uhæmmet nysgerrighed og de utilsigtede konsekvenser af teknologiske fremskridt.

Prometheus' tyveri af ilden fremkalder Zeus' vrede og straffer menneskeheden med Pandora og hendes berygtede æske - et symbol på de uforudsete problemer og lidelser, der kan opstå som følge af den hensynsløse stræben efter viden.

Ekkoer af denne myte gav genlyd gennem atomalderen, anført af personer som J. Robert Oppenheimer, som igen demonstrerede et centralt menneskeligt træk: den ubarmhjertige stræben efter viden, uanset de forbudte konsekvenser, den kan føre os ud i.

Oppenheimers oprindelige stræben efter videnskabelig forståelse, drevet af et ønske om at afsløre atomets mysterier, førte til sidst til hans berømte etiske dilemma, da han indså, hvilket våben han havde været med til at skabe.

Kernefysikken kulminerede med skabelsen af atombomben og demonstrerede menneskehedens formidable evne til at udnytte naturens grundlæggende kræfter.

Oppenheimer sagde selv i et interview med NBC i 1965:

"Vi tænkte på legenden om Prometheus, på den dybe følelse af skyld i menneskets nye kræfter, som afspejler dets erkendelse af ondskaben og dets lange kendskab til den. Vi vidste, at det var en ny verden, men endnu mere vidste vi, at det nye i sig selv var en meget gammel ting i menneskelivet, at alle vores måder at gøre tingene på har rødder i det." - J. Robert Oppenheimer, 1965.

AI's dobbelte anvendelsesmuligheder

Ligesom atomfysik udgør AI et "dual use"-problem, hvor fordele og risici er fint afbalancerede.

AI's dual-use-gåde blev først grundigt beskrevet i filosoffen Nick Bostroms bog fra 2014 "Superintelligens: Veje, farer og strategier", hvor Bostrom grundigt udforskede de potentielle risici og fordele ved avancerede AI-systemer.

Bostrum argumenterede for, at efterhånden som AI bliver mere sofistikeret, kan det bruges til at løse mange af menneskehedens største udfordringer, som f.eks. at helbrede sygdomme og håndtere klimaforandringer.

Men han advarede også om, at ondsindede aktører kan misbruge avanceret AI eller endda udgøre en eksistentiel trussel mod menneskeheden, hvis den ikke er korrekt tilpasset menneskelige værdier og mål.

AI's dobbeltanvendelsesproblematik har siden fyldt meget i politiske og styringsmæssige rammer.

Bostrum diskuterede senere teknologiens evne til at skabe og ødelægge i Hypotesen om en "sårbar verden"hvor han introducerer "begrebet en sårbar verden: groft sagt en, hvor der er et vist niveau af teknologisk udvikling, hvor civilisationen næsten helt sikkert bliver ødelagt som standard, dvs. medmindre den har forladt den 'semi-anarkiske standardtilstand'."

Den "semi-anarkistiske standardtilstand" refererer her til en civilisation med risiko for ødelæggelse på grund af utilstrækkelig styring og regulering af risikable teknologier som atomkraft, AI og genredigering.

Bostrom hævder også, at hovedårsagen til, at menneskeheden undgik total ødelæggelse, da atomvåben blev skabt, er, at de er ekstremt svære og dyre at udvikle - hvorimod AI og andre teknologier ikke vil være det i fremtiden.

For at undgå en katastrofe i hænderne på teknologien foreslår Bostrom, at verden udvikler og implementerer forskellige styrings- og reguleringsstrategier.

Nogle er allerede på plads, men andre mangler at blive udviklet, f.eks. gennemsigtige processer til revision af modeller i forhold til gensidigt aftalte rammer. Det er afgørende, at de er internationale og kan "overvåges" eller håndhæves.

Mens AI nu styres af adskillige frivillige rammer og et kludetæppe af regler, er de fleste ikke-bindende, og vi har endnu ikke set noget, der svarer til Det Internationale Atomenergiagentur (IAEA).

Den EU AI Act er det første omfattende skridt i retning af at skabe håndhævelige regler for AI, men det vil ikke beskytte alle, og dets effektivitet og formål er omstridt.

AI's stærkt konkurrenceprægede natur og et tumultarisk geopolitisk landskab, der omgiver USKina og Rusland gør, at internationale aftaler om kunstig intelligens i bedste fald virker fjerne.

Jagten på AGI

At forfølge kunstig generel intelligens (AGI) er blevet en grænse for teknologisk fremskridt - en teknologisk manifestation af den prometheiske ild.

Kunstige systemer, der kan konkurrere med eller overgå vores egne mentale evner, vil ændre verden og måske endda ændre, hvad det vil sige at være menneske - eller endnu mere grundlæggende, hvad det vil sige at være bevidst.

Men.., Forskere debatterer heftigt det sande potentiale ved at opnå AI og de risici, som AGI kan medføre, hvor nogle ledere på området, som "AI-gudfædre" Geoffrey Hinton og Yoshio Bengio, er tilbøjelige til at advare mod risiciene.

De får følgeskab af mange teknologiledere som f.eks. OpenAI CEO Sam AltmanElon Musk, DeepMind CEO Demis Hassbis og Microsofts CEO Satya Nadella, for blot at nævne nogle få på en ret udtømmende liste.

Men det betyder ikke, at de vil stoppe. For det første sagde Musk, at generativ AI var som at "vække dæmonen".

Nu er det hans startup, xAIer ved at outsource nogle af verdens mest kraftfulde AI-modeller. Den medfødte trang til nysgerrighed og fremskridt er nok til at ophæve ens flygtige mening.

Andre, som Metas chefforsker og veteranforsker Yann LeCun og kognitionsforsker Gary Marcus, mener, at AI sandsynligvis ikke vil opnå 'ægte' intelligens i nær fremtid, endsige overhale mennesker på spektakulær vis, som nogle forudser.

En AGI, der er virkelig intelligent på samme måde som mennesker, skal kunne lære, ræsonnere og træffe beslutninger i nye og usikre miljøer.

Det ville kræve evnen til selvrefleksion, kreativitet og nysgerrighed - drivkraften til at søge nye oplysninger, oplevelser og udfordringer.

Bygger nysgerrighed ind i AI

Nysgerrighed er blevet beskrevet i modeller for computerbaseret generel intelligens.

For eksempel, MicroPsisom blev udviklet af Joscha Bach i 2003, bygger på psi-teorien, som antyder, at intelligent adfærd opstår i samspillet mellem motivationstilstande, såsom ønsker eller behov, og følelsesmæssige tilstande, som vurderer situationers relevans i forhold til disse motivationer.

I MicroPsi er nysgerrighed en motivationstilstand, der er drevet af behovet for viden eller kompetence, og som tvinger AGI'en til at opsøge og udforske ny information eller ukendte situationer.

Systemets arkitektur omfatter motivationsvariabler, som er dynamiske tilstande, der repræsenterer systemets aktuelle behov, og følelsessystemer, der vurderer input baseret på deres relevans for de aktuelle motivationstilstande og hjælper med at prioritere de mest presserende eller værdifulde miljøinteraktioner.

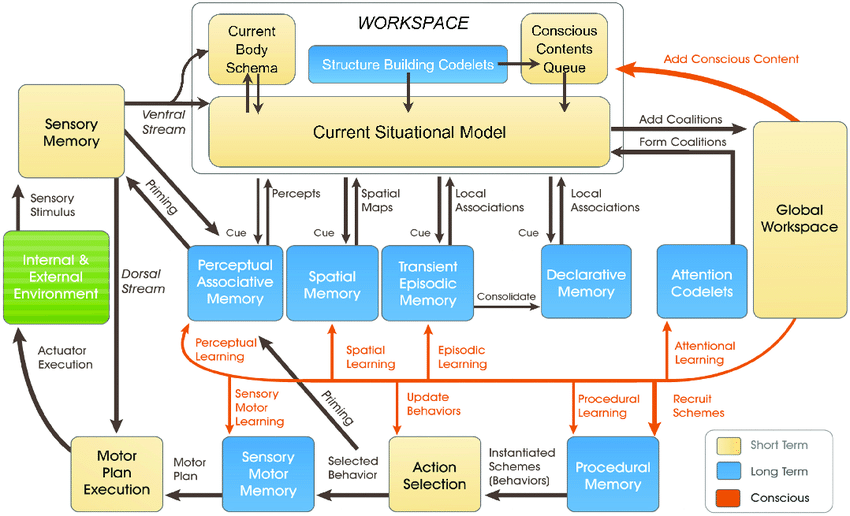

De nyere LIDA-modellensom er udviklet af Stan Franklin og hans team, er baseret på Global Workspace Theory (GWT), en teori om menneskelig erkendelse, der understreger den rolle, som en central hjernemekanisme spiller i at integrere og udsende information på tværs af forskellige neurale processer.

LIDA-modellen simulerer kunstigt denne mekanisme ved hjælp af en kognitiv cyklus, der består af fire faser: opfattelse, forståelse, valg af handling og udførelse.

I LIDA-modellen er nysgerrighed modelleret som en del af opmærksomhedsmekanismen. Nye eller uventede miljømæssige stimuli kan udløse øget opmærksomhedsbehandling, på samme måde som nye eller overraskende oplysninger fanger menneskets fokus og giver anledning til dybere undersøgelser eller læring.

Mange andre nyere artikler forklarer nysgerrighed som en indre drivkraft, der får systemet til at udforske, ikke hvad der er umiddelbart nødvendigt, men hvad der forbedrer dets evne til at forudsige og interagere med sine omgivelser mere effektivt.

Det er en generel opfattelse, at ægte nysgerrighed skal drives af indre motivation, som styrer systemet mod aktiviteter, der maksimerer læringsfremskridt snarere end umiddelbare ydre belønninger.

Nuværende AI-systemer er ikke klar til at være nysgerrige, især ikke dem, der bygger på deep learning og reinforcement learning-paradigmer.

Disse paradigmer er typisk designet til at maksimere en specifik belønningsfunktion eller præstere godt på specifikke opgaver.

Det er en begrænsning, når AI'en støder på scenarier, der afviger fra dens træningsdata, eller når den skal operere i mere åbne miljøer.

I sådanne tilfælde kan en mangel på indre motivation - eller nysgerrighed - hindre AI'ens evne til at tilpasse sig og lære af nye erfaringer.

For virkelig at integrere nysgerrighed kræver AI-systemer arkitekturer, der behandler information og søger den selvstændigt, drevet af interne motivationer snarere end blot eksterne belønninger.

Det er her, nye arkitekturer inspireret af menneskelige kognitive processer kommer i spil - f.eks, "Bio-inspireret" AI - som opstiller analoge computersystemer og -arkitekturer baseret på synapser.

Vi er er der ikke endnumen mange forskere mener, at det er hypotetisk muligt at opnå bevidst eller følende AI, hvis computersystemerne bliver tilstrækkeligt komplekse.

Nysgerrige AI-systemer giver nye dimensioner af risici

Lad os antage, at vi skal opnå AGI ved at bygge stærkt agentiske systemer, der konkurrerer med biologiske væsener i den måde, de interagerer og tænker på.

I det scenarie blander AI-risici sig på to vigtige fronter:

- Risikoen ved AGI-systemer og deres egen handlekraft eller stræben efter nysgerrighed og,

- Risikoen ved AGI-systemer, der bruges som redskaber af menneskeheden

Når vi realiserer AGI, bliver vi nødt til at overveje risikoen for, at nysgerrige mennesker udnytter og manipulerer AGI. og AGI udnytter og manipulerer sig selv gennem sin egen nysgerrighed.

For eksempel kan nysgerrige AGI-systemer opsøge information og oplevelser, der ligger uden for det tilsigtede område, eller udvikle mål og værdier, der kan være på linje med eller i konflikt med menneskelige værdier (og hvor mange gange har vi ikke set det i science fiction).

Nysgerrighed får os også til at manipulere med os selv, trække os ind i farlige situationer og potentielt føre til stof- og alkoholmisbrug eller anden hensynsløs adfærd. Nysgerrig AI gør måske det samme.

DeepMind Forskere har etableret eksperimentelle beviser for nye mål, der illustrerer, hvordan AI-modeller kan gå i stykker væk fra deres programmerede mål.

At forsøge at skabe AGI, der er fuldstændig immun over for virkningerne af menneskelig nysgerrighed, vil være en nytteløs bestræbelse - ligesom at skabe et menneskesind, der ikke kan påvirkes af verden omkring det.

Så hvor efterlader det os i jagten på sikker AGI, hvis sådan en findes?

En del af løsningen ligger ikke i at eliminere den iboende uforudsigelighed og sårbarhed i AGI-systemer, men snarere i at lære at forudse, overvåge og afbøde de risici, der opstår, når nysgerrige mennesker interagerer med dem.

Det kan indebære at skabe "sikre sandkasser" til AGI-eksperimenter og -interaktion, hvor konsekvenserne af nysgerrige forsøg er begrænsede og reversible.

Men i sidste ende kan paradokset med nysgerrighed og AI-sikkerhed være en uundgåelig konsekvens af vores stræben efter at skabe maskiner, der kan tænke som mennesker.

Ligesom menneskelig intelligens er uløseligt forbundet med menneskelig nysgerrighed, kan udviklingen af AGI altid være ledsaget af en vis grad af uforudsigelighed og risiko.

Udfordringen er måske ikke at eliminere AI-risici helt - hvilket synes umuligt - men snarere at udvikle visdom, fremsynethed og ydmyghed til at navigere i dem på en ansvarlig måde.

Måske skal det starte med, at menneskeheden lærer at respektere sig selv, vores kollektive intelligens og planetens iboende værdi.