Kan mennesker lære at opdage AI-genererede forfalskninger? Hvordan påvirker de os på et kognitivt niveau?

OpenAI's Sora-system gav for nylig en forsmag på en ny bølge af syntetiske AI-drevne medier. Det varer nok ikke længe, før enhver form for realistiske medier - lyd, video eller billede - kan genereres med instruktioner på få sekunder.

Efterhånden som disse AI-systemer bliver stadig dygtigere, bliver vi nødt til at opøve nye færdigheder i kritisk tænkning for at kunne skelne sandhed fra fiktion.

Hidtil har Big Techs bestræbelser på at bremse eller stoppe deep fakes ikke ført til meget andet end følelser, ikke på grund af manglende overbevisning, men fordi AI-indhold er så realistisk.

Det gør det svært at opdage på pixelniveaumens andre signaler, som metadata og vandmærker, har deres mangler.

Og selv hvis AI-genereret indhold kunne opdages i stor skala, er det en udfordring at adskille autentisk, målrettet indhold fra indhold, der har til formål at sprede misinformation.

En mulig løsning er at videregive indhold til menneskelige korrekturlæsere og bruge "community notes" (oplysninger, der er knyttet til indhold, ofte set på X). Men det indebærer nogle gange subjektiv fortolkning og risiko for forkert mærkning.

For eksempel i Israel-Palæstina-konfliktenVi har været vidne til foruroligende billeder, der blev stemplet som ægte, selvom de var falske og omvendt.

Når et ægte billede stemples som falsk, kan det skabe en 'Løgnerens udbytte,' hvor nogen eller noget kan affeje sandheden som falsk.

Så i mangel af tekniske metoder til at stoppe deep fakes på teknologisiden, hvad kan vi så gøre ved det?

Og i hvor høj grad påvirker deep fakes vores beslutningstagning og psykologi?

Når folk f.eks. udsættes for falske politiske billeder, har det så en mærkbar indvirkning på deres stemmeadfærd?

Lad os se på et par undersøgelser, der vurderer netop det.

Påvirker deep fakes vores meninger og psykologiske tilstande?

Et studie fra 2020"Deepfakes og misinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News", undersøgte, hvordan deep fake-videoer påvirker den offentlige opfattelse, især hvad angår tillid til nyheder, der deles på sociale medier.

Forskningen omfattede et stort eksperiment med 2.005 deltagere fra Storbritannien, som skulle måle reaktionerne på forskellige typer af dybt falske videoer af den tidligere amerikanske præsident Barack Obama.

Deltagerne blev tilfældigt udvalgt til at se en af tre videoer:

- Et 4-sekunders klip, der viser Obama komme med en overraskende udtalelse uden nogen sammenhæng.

- Et 26-sekunders klip, der indeholdt nogle hints om videoens kunstige natur, men som primært var vildledende.

- En fuld video med en "pædagogisk afsløring", hvor deep fake's kunstige natur eksplicit blev afsløret, med Jordan Peele, der forklarer teknologien bag deep fake.

Vigtige resultater

Undersøgelsen udforskede tre nøgleområder:

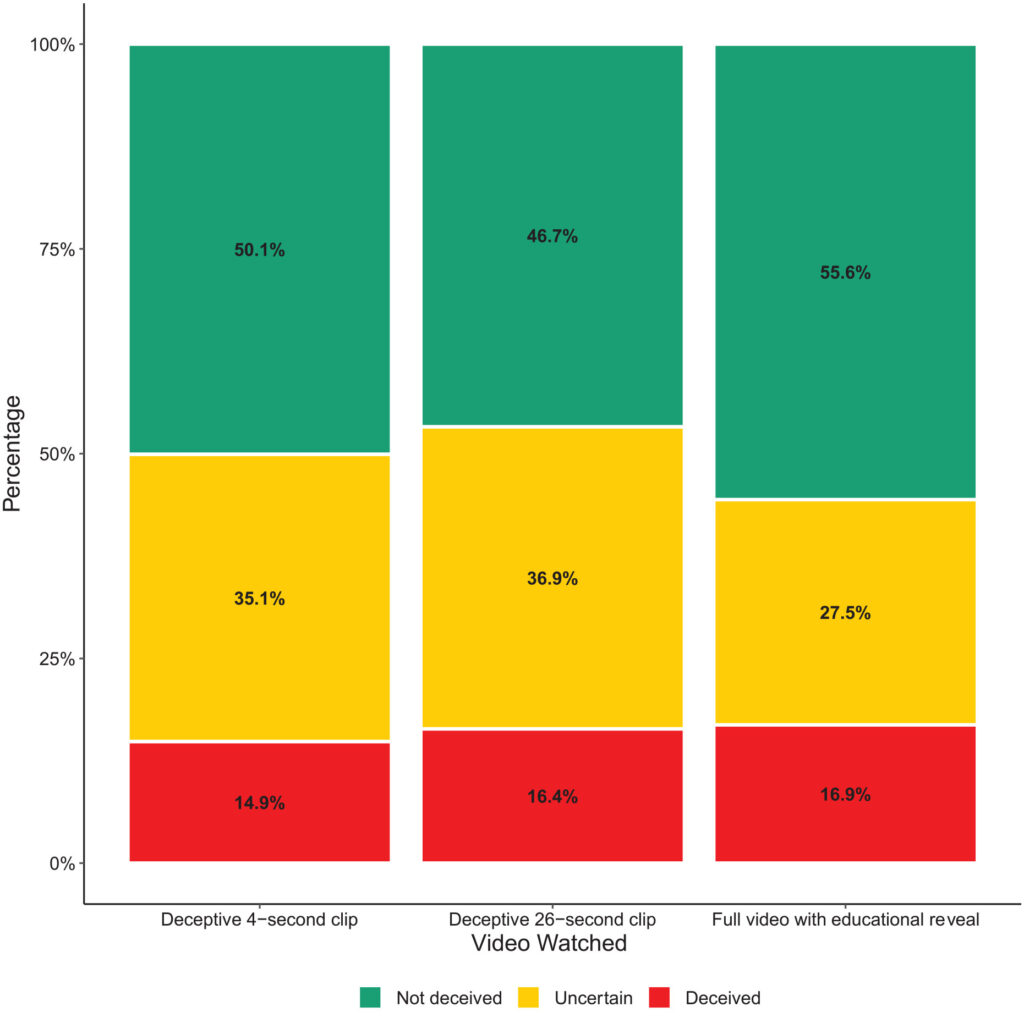

- Bedrag: Undersøgelsen fandt minimale tegn på, at deltagerne troede på de falske udsagn i deep fakes. Procentdelen af deltagere, der blev vildledt af de dybe forfalskninger, var relativt lav i alle behandlingsgrupper.

- Usikkerhed: Et vigtigt resultat var dog øget usikkerhed blandt seerne, især dem, der så de kortere, vildledende klip. Omkring 35,1% af de deltagere, der så 4-sekunders-klippet, og 36,9%, der så 26-sekunders-klippet, rapporterede, at de følte sig usikre på videoens ægthed. I modsætning hertil var det kun 27,5% af dem, der så hele undervisningsvideoen, der havde det på denne måde.

- Tillid til nyheder: Denne usikkerhed påvirkede deltagernes tillid til nyheder på de sociale medier negativt. De, der blev udsat for de vildledende dybe forfalskninger, viste lavere tillidsniveauer end dem, der så den pædagogiske afsløring.

Det viser, at eksponering for dybe falske billeder skaber usikkerhed på længere sigt.

Med tiden kan falske billeder svække tilliden til al information, inklusive sandheden.

Lignende resultater blev påvist af en nyere undersøgelse fra 2023"Face/Off: Changing the face of movies with deepfake", som også konkluderede, at falske billeder har langsigtede virkninger.

Folk 'husker' falsk indhold efter eksponering

Face/Off-undersøgelsen, der blev gennemført med 436 deltagere, undersøgte, hvor meget forfalskninger kan påvirke vores erindring om film.

Deltagerne deltog i en online-undersøgelse, der havde til formål at undersøge deres opfattelser og minder om både virkelige og imaginære genindspilninger af film.

Undersøgelsens kerne bestod i at præsentere deltagerne for seks filmtitler, som omfattede en blanding af fire faktiske genindspilninger af film og to fiktive.

MFilmene blev randomiseret og præsenteret i to formater: Halvdelen af filmene blev introduceret gennem korte tekstbeskrivelser, og den anden halvdel blev parret med korte videoklip.

Fiktive genindspilninger af film bestod af versioner af "The Shining", "The Matrix", "Indiana Jones" og "Captain Marvel", komplet med beskrivelser, der fejlagtigt hævdede, at højt profilerede skuespillere var involveret i disse ikke-eksisterende genindspilninger.

For eksempel blev deltagerne fortalt om en falsk genindspilning af "The Shining" med Brad Pitt og Angelina Jolie i hovedrollerne, som aldrig fandt sted.

I modsætning hertil blev de ægte filmremakes, der blev præsenteret i undersøgelsen, såsom "Charlie & The Chocolate Factory" og "Total Recall", beskrevet nøjagtigt og ledsaget af ægte filmklip. Denne blanding af ægte og falske remakes havde til formål at undersøge, hvordan deltagerne skelner mellem faktuelt og opdigtet indhold.

Deltagerne blev spurgt om deres kendskab til hver film, og om de havde set den originale film eller genindspilningen eller havde noget forudgående kendskab til dem.

Vigtige resultater

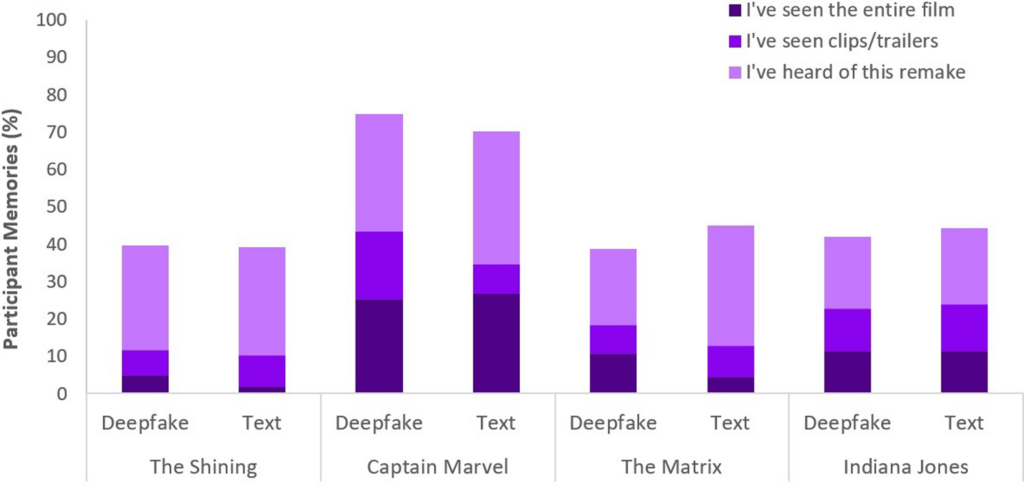

- Fænomenet falsk hukommelse: Et vigtigt resultat af undersøgelsen er afsløringen af, at næsten halvdelen af deltagerne (49%) udviklede falske minder om at se fiktive genindspilninger, som f.eks. at forestille sig Will Smith som Neo i "The Matrix". Dette illustrerer den vedvarende effekt, som suggestive medier, uanset om det er dybe falske videoer eller tekstbeskrivelser, kan have på vores hukommelse.

- Helt specifikt"Captain Marvel" toppede listen med 73% af deltagerne, der huskede AI-genindspilningen, efterfulgt af "Indiana Jones" med 43%, "The Matrix" med 42% og "The Shining" med 40%. Blandt dem, der fejlagtigt troede på disse genindspilninger, mente 41%, at genindspilningen af "Captain Marvel" var bedre end originalen.

- Sammenlignende indflydelse af deep fakes og tekst: En anden opdagelse er, at deep fakes på trods af deres visuelle og auditive realisme ikke var mere effektive til at ændre deltagernes hukommelse end tekstlige beskrivelser af det samme fiktive indhold. Det tyder på, at misinformationens format - visuelt eller tekstligt - ikke ændrer væsentligt på dens indvirkning på hukommelsesforvrængning i forbindelse med film.

Det falske hukommelsesfænomen, der er involveret i dette studie, er der forsket meget i. Det viser, hvordan mennesker effektivt konstruerer eller rekonstruerer falske minder, som vi er sikre på er ægte, selvom de ikke er det.

Alle er modtagelige for at konstruere falske minder, og deep-fakes ser ud til at aktivere denne adfærd, hvilket betyder, at visning af bestemt indhold kan ændre vores opfattelse, selv når vi bevidst forstår, at det er uægte.

I begge undersøgelser havde deep fakes håndgribelige, potentielt langsigtede virkninger. Effekten kan snige sig ind på os og akkumuleres over tid.

Vi skal også huske, at falsk indhold cirkulerer til millioner af mennesker, så små ændringer i opfattelsen skaleres på tværs af den globale befolkning.

Hvad gør vi ved deep fakes?

At gå i krig mod deep fakes betyder at bekæmpe den menneskelige hjerne.

Mens fremkomsten af falske nyheder og misinformation har tvunget folk til at udvikle ny mediekendskab i de senere år, vil AI-genererede syntetiske medier kræve et nyt niveau af tilpasning.

Vi har stået over for sådanne vendepunkter før, fra fotografering til CGI-specialeffekter, men AI vil kræve en udvikling af vores kritiske sanser.

I dag må vi gå videre end blot at tro på vores øjne og stole mere på at analysere kilder og kontekstuelle ledetråde.

Det er vigtigt at spørge ind til indholdets incitamenter eller fordomme. Stemmer det overens med kendte fakta eller modsiger det dem? Er der bekræftende beviser fra andre troværdige kilder?

Et andet vigtigt aspekt er at etablere juridiske standarder for at identificere forfalskede eller manipulerede medier og holde skaberne ansvarlige.

Den Den amerikanske DEFIANCE-lovUK Online Safety Act og tilsvarende love verden over er ved at etablere juridiske procedurer for håndtering af deep fakes. Hvor effektive de bliver, er endnu uvist.

Strategier til at afsløre sandheden

Lad os slutte af med fem strategier til at identificere og afhøre potentielle deep fakes.

Selv om ingen enkelt strategi er fejlfri, er fremme af kritisk tankegang det bedste, vi kan gøre kollektivt for at minimere virkningen af AI-misinformation.

- Bekræftelse af kilde: Det er et grundlæggende skridt at undersøge informationens troværdighed og oprindelse. Autentisk indhold stammer ofte fra velrenommerede kilder, der har vist sig at være pålidelige.

- Teknisk analyse: På trods af deres raffinement kan dybe forfalskninger udvise subtile fejl, f.eks. uregelmæssige ansigtsudtryk eller inkonsekvent belysning. Undersøg indholdet, og overvej, om det er ændret digitalt.

- Krydsreferencer: Verificering af oplysninger mod flere pålidelige kilder kan give et bredere perspektiv og hjælpe med at bekræfte indholdets ægthed.

- Digital dannelse: Det er vigtigt at forstå AI-teknologiernes muligheder og begrænsninger for at kunne vurdere indholdet. Uddannelse i digital dannelse på tværs af skoler og medier, herunder hvordan kunstig intelligens fungerer og dens etiske konsekvenser, vil være afgørende.

- Forsigtig interaktion: Interaktion med AI-genereret misinformation forstærker dens effekt. Vær forsigtig, når du liker, deler eller reposter indhold, som du er i tvivl om.

I takt med at deep fakes udvikler sig, vil de teknikker, der kræves for at opdage og afbøde skader, også gøre det. 2024 bliver afslørende, da omkring halvdelen af verdens befolkning skal stemme ved vigtige valg.

Meget tyder på, at deep fakes kan påvirke vores opfattelse, så det er langt fra underligt at tro, at AI-fejlinformation kan have en væsentlig indflydelse på resultaterne.

Når vi bevæger os fremad, vil etisk AI-praksis, digital dannelse, regulering og kritisk engagement være afgørende for at forme en fremtid, hvor teknologien forstærker snarere end tilslører essensen af sandheden.