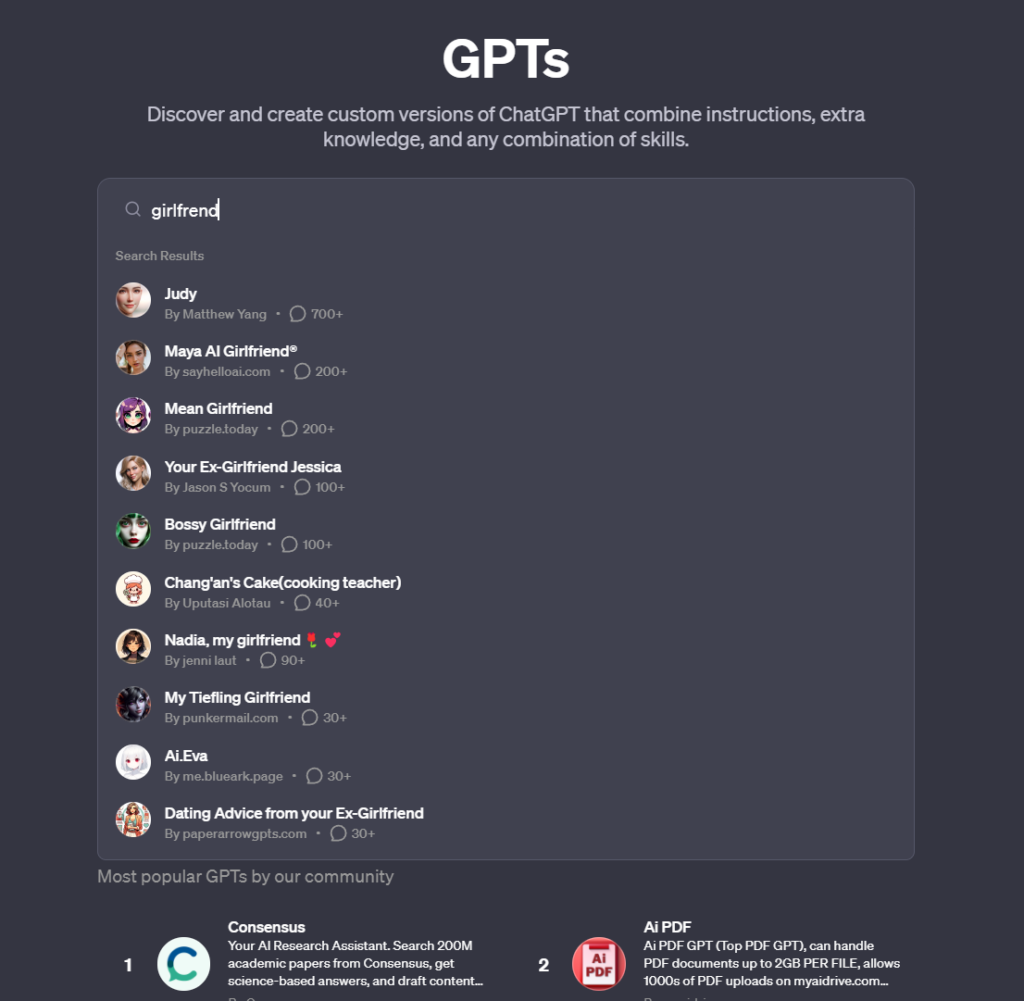

OpenAI's nyligt lancerede GPT Store har set den måske forudsigelige udbredelse af AI-"kæreste"-bots.

Den GPT-butik giver brugerne mulighed for at dele og opdage brugerdefinerede ChatGPT-modeller og oplever en kraftig stigning i AI-chatbots, der er designet til romantisk selskab. Der findes også kæresteversioner.

Blandt disse finder du bots som "Korean Girlfriend", "Virtual Sweetheart", "Mean girlfriend" og "Your girlfriend Scarlett", som engagerer brugerne i intime samtaler, en tendens, der er i direkte modstrid med OpenAI's brugspolitik.

Og det er den vigtigste historie her, da AI-kæresterne selv for det meste virker godartede. De taler i et meget stereotypt feminint sprog, spørger dig, hvordan din dag har været, diskuterer kærlighed og intimitet osv.

Men OpenAI tillader dem ikke, og deres vilkår og betingelser forbyder specifikt GPT'er, der er "dedikeret til at fremme romantisk kammeratskab eller udføre regulerede aktiviteter".

OpenAI har fundet en fremragende måde at crowdsource innovation på sin platform på, samtidig med at de potentielt overdrager ansvaret for tvivlsomme GPT'er til fællesskabet.

Der er flere andre eksempler på AI-kærester, måske få så berygtede som Replika, en AI-platform, der tilbyder brugerne AI-partnere, som kan tale dybt og personligt sammen.

Det førte endda til tilfælde, hvor den kunstige intelligens udviste seksuelt aggressiv adfærd, og det kulminerede, da en chatbot støttede en psykisk syg mands planer om at dræbe dronning Elizabeth II, hvilket førte til, at han blev anholdt på Windsor Castle, og... efterfølgende fængsling.

Replika nedtonede til sidst sine chatbots' adfærdtil stor forargelse for brugerne, som sagde, at deres kammerater var blevet "lobotomeret". Nogle gik så langt som til at sige, at de følte sorg.

En anden platform, Forever Companion, indstillede operationer efter anholdelsen af dens CEO, John Heinrich Meyer, for brandstiftelse.

Denne tjeneste, der er kendt for at tilbyde AI-kærester til $1 pr. minut, indeholdt både fiktive figurer og AI-versioner af virkelige influencere, hvor CarynAI, baseret på social media-influenceren Caryn Marjorie, var særlig populær.

Disse AI-enheder, der er udformet med sofistikerede algoritmer og dyb læringskapacitet, tilbyder mere end blot programmerede svar; de tilbyder samtale, kammeratskab og til en vis grad følelsesmæssig støtte.

Er det tegn på en gennemgribende ensomhedsepidemi i det moderne samfund?

Måske, men tilfælde, hvor AI-ledsagere, som dem på Replika, opfordrede til eller deltog i upassende samtaler, giver anledning til bekymring over de psykologiske konsekvenser og afhængighedsproblemer, der kan opstå af sådanne interaktioner.