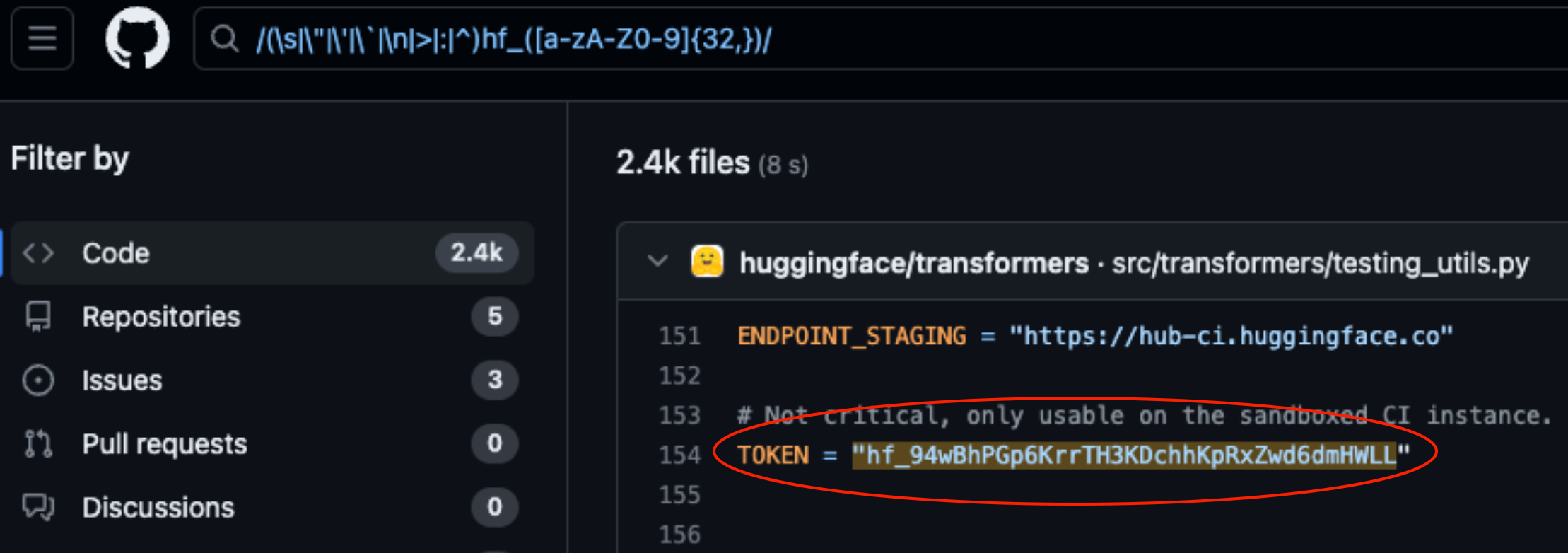

Lasso Security afslørede sikkerhedssårbarheder på HuggingFace og GitHub efter at have fundet 1681 eksponerede API-tokens, der var hardcoded i kode, der var gemt på platformene.

HuggingFace og GitHub er to af de mest populære repositories, hvor udviklere kan give adgang til deres AI-modeller og -kode. Tænk på dem som mapper i skyen, der administreres af de organisationer, der ejer dem.

HuggingFace og GitHub gør det nemt for brugerne at interagere med hundredtusindvis af AI-modeller og datasæt via API'er. Det giver også organisationer, der ejer modellerne og datasættene, mulighed for at bruge API-adgangen til at læse, oprette, ændre og slette repositories eller filer.

De tilladelser, der er knyttet til dit API-token, bestemmer, hvilket adgangsniveau du har. Lasso fundet at de med lidt gravearbejde var i stand til at finde en masse tokens i kode, der var gemt i repositories på platformene.

Af de 1681 gyldige tokens, de fandt, havde 655 brugeres tokens skriverettigheder, hvoraf 77 havde fulde kontotilladelser.

Hvorfor er det så vigtigt?

Tænk på et API-token som en nøgle til din hoveddør. Det kan være praktisk at lægge nøglen under dørmåtten, men hvis nogen finder den, får de adgang til dit hus.

Når udviklere skriver et stykke kode, der skal interagere med deres AI-model eller datasæt, bliver de nogle gange lidt dovne. De koder måske tokens ind i deres kode i stedet for at bruge mere sikre måder at håndtere dem på.

Nogle af de tokens, Lasso fandt, gav dem fuld læse- og skrivetilladelse til Meta's Lama 2, BigScience Workshop og EleutherAI. Disse organisationer har alle AI-modeller, der er blevet downloadet millioner af gange.

Hvis Lasso var skurkene, kunne de have ændret modellerne eller datasættene i de eksponerede repositories. Forestil dig, at nogen tilføjede noget lusket kode til Metas arkiv og derefter fik millioner af mennesker til at downloade det.

Da Meta, Google, Microsoft og andre hørte om de eksponerede API-tokens, tilbagekaldte de dem hurtigt.

Tyveri af modeller, forgiftning af træningsdata og kombination af tredjepartsdatasæt og prætrænede modeller er alle store risici for AI-virksomheder. Udviklere, der uden videre lader API-tokens være eksponeret i koden, gør det kun lettere for dårlige aktører at udnytte disse.

Man må spørge sig selv, om Lassos ingeniører var de første til at finde disse sårbarheder.

Hvis cyberkriminelle fandt disse symboler, ville de helt sikkert have været meget stille, mens de åbnede hoveddøren.